Der Aufbau eines generativen KI-Modells (GenAI-Modell) von Grund auf kann viele Millionen Dollar an Infrastruktur und Fachwissen sowie Monate an Bearbeitungszeit kosten. Eine praktikablere Option für die meisten Unternehmen ist Retrieval-Augmented Generation (RAG).

Retrieval-Augmented Generation (RAG) besteht darin, ein generatives KI-Modell mit Daten zu ergänzen, die zusätzliche Fakten und Kontexte liefern. So werden Ergebnisse sachlicher und für die spezifischen Bedürfnisse eines Unternehmens relevanter.

Die Grenzen von Chat GPT & Co:

Große Sprachmodelle (LLMs) wie GPT haben ein „Trainingswissen“, das irgendwann endet. Mit RAG kann man dem Modell aktuelle und verlässliche Informationen zur Verfügung stellen, die es dann in seine Antwort einbaut. Somit können die Ergebnisse auch um tagesaktuelle Infos erweitert werden. Zudem basiert die Antwort auf echten Quellen, die man im Zweifel auch zitieren oder verlinken kann. Und nicht zuletzt spart der Ansatz Rechenleistung: Man muss kein gigantisches Modell mit allem Wissen trainieren, denn es werden gezielt Information und Sprachverständnis kombiniert.

Das KI-Modell ist nur die Basis

Es gibt viele verschiedene Arten von Basismodellen, die auf unterschiedliche Medien oder Anwendungsfälle spezialisiert sind. Zu den bekannten Basismodellen gehören ChatGPT von OpenAI, Midjourney, LLama von Meta oder Claude von Anthropic. Besonders vielversprechend für den allgemeinen Gebrauch sind große Sprachmodelle (LLMs), die auf massiven Textkörpern trainiert werden. Und diese Modelle können die menschliche Sprache und das menschliche Verstehen nachahmen. Die Kombination von RAG mit einem LLM ermöglicht es Unternehmen, die Leistung von generativer „KI von der Stange“ für ihre eigenen Daten zu nutzen und so Geld und Zeit zu sparen.

RAG-Architektur für generative KI (GenAI)

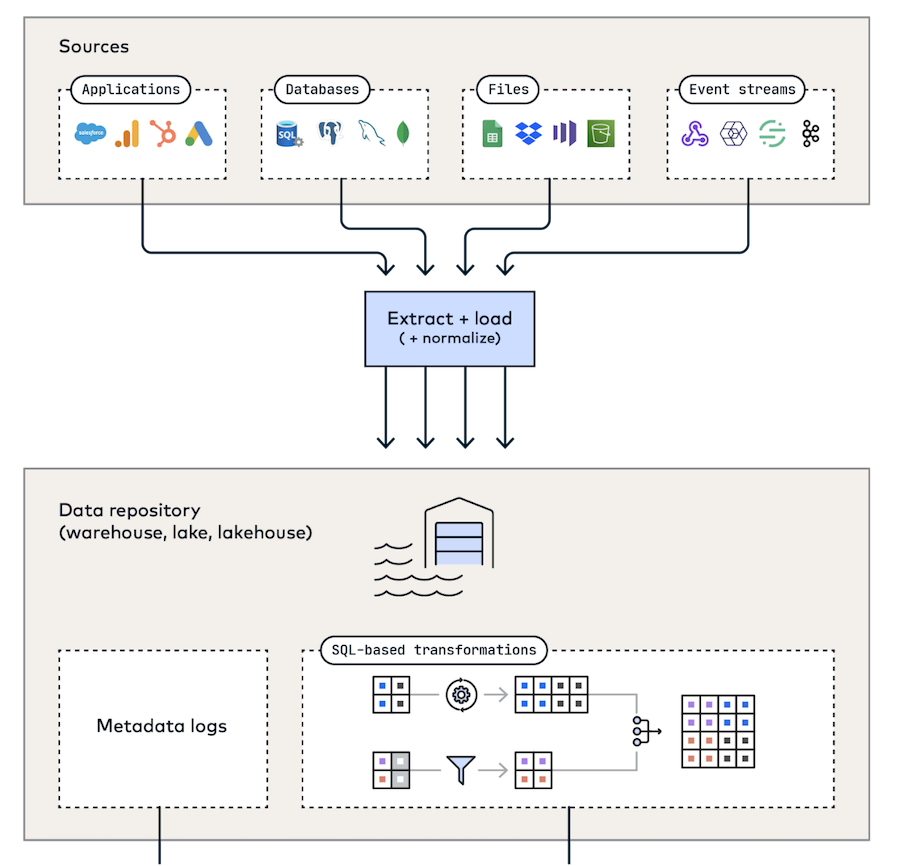

Generative KI ist auf unstrukturierte Daten in Form von allen Arten von Medien wie Text, Bilder, Audio, Video und mehr angewiesen. Die folgende Architektur (siehe Bild) zeigt, wie die Daten für RAG bereitgestellt werden. Mit Hilfe einer Lösung zur Datenintegration beginnt ein Team mit dem Extrahieren und Laden von Daten aus Quellen in ein zentrales Datenrepository. Dieses Zwischenspeichersystem bietet mehrere Vorteile: Alle Daten befinden sich an einem Ort und können verwaltet, beobachtet und modelliert werden, bevor sie in eine Vektordatenbank verschoben werden, wo sie nicht mehr umgewandelt werden können.

Diese Plattform kann das Rückgrat für andere Analysezwecke bilden, z. B. für herkömmliche Berichte, Dashboards und Business Intelligence. Am wichtigsten ist jedoch, dass sie die Modularität der Unternehmens-Architektur erhöht. Es gibt viele Gründe, warum Unternehmen Vektoreinbettungen und ihre Strategien große Textmengen in kleine, überschaubare Segmente oder Teile zu zerlegen (Chunking), immer wieder einmal ändern müssen: Mit einem Zwischenspeicher (Staging-Bereich) ist das möglich, ohne dass man alle Daten aus den Quellen neu synchronisieren muss.

Für KI-Anwendungen sind Governed Data Lakes die beste Art von Repository. Sie können am besten sowohl in sehr großem Maßstab speichern als auch unstrukturierte oder semistrukturierte Daten verarbeiten.

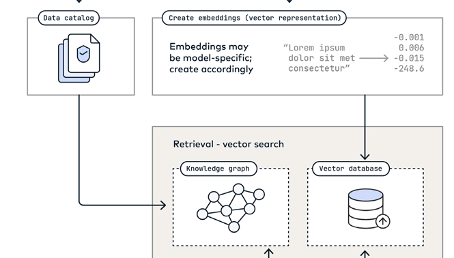

Sobald die Daten in einem Data Lake oder Data Warehouse gelandet sind, müssen sie einer zusätzlichen Verarbeitung unterzogen werden, damit sie für generative KI nutzbar sind. Ein Ansatz besteht darin, Daten zu katalogisieren und ihnen eine semantische, reale Bedeutung zuzuweisen, indem ein referenzierbarer Wissensgraph erstellt wird, der die Beziehungen zwischen Entitäten, Ereignissen und Konzepten veranschaulicht.

Der andere Ansatz besteht darin, Rohdaten – Text, Bilder, Video und andere Medien – als numerische Darstellungen, Vektoren genannt, in eine Vektordatenbank einzubetten. Vektorisierte Daten können an eine Anfrage eines Nutzers, eine sogenannte Eingabeaufforderung, angehängt werden und als zusätzlicher Kontext an ein Basismodell gesendet werden, das genauere und relevantere Antworten liefert.

Alles zusammenfügen

Nehmen wir an, man hat einen Text aus einer Anwendung, den man verwenden möchte, um einen automatisierten Helpdesk-Chatbot zu erweitern. Wenn wir uns an die soeben beschriebene RAG-Architektur halten, ist die erste Etappe dieses Arbeitsablaufs recht einfach: Man richtet einen vorgefertigten Konnektor von der Quelle zum Ziel ein. Die nächsten Schritte des Prozesses erfordern etwas technische Arbeit.

Konkret: Die Schritte zum Erfolg:

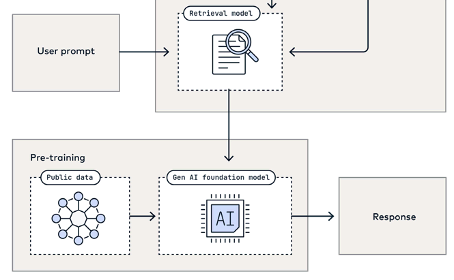

- Erstellen einer Pipeline zum Extrahieren, Transformieren und Laden der relevanten Daten aus dem Datenspeicher in die Vektordatenbank. Dies kann einmal erfolgen und die Ergebnisse werden entsprechend gespeichert. Später kann eine erneute Synchronisierung durchführen werden, wenn sich genügend Änderungen in den zugrunde liegenden Daten ergeben haben.

- Einrichten einer Benutzeroberfläche, die Eingabeaufforderungen akzeptiert und diese mit dem relevanten Kontext aus der Vektordatenbank kombiniert. Einige bemerkenswerte Beispiele für Vektordatenbanken sind ChromaDB, Pinecone und Weaviate.

- Das Retrieval-Modell sendet die erweiterten Eingabeaufforderungen an das Basismodell und generiert eine Antwort.

Mithilfe gängiger Sprachen, Bibliotheken und APIs für Basismodelle lässt sich eine einfache Anwendung wie ein Chatbot, der die einzigartigen, proprietären Daten nutzt, relativ einfach erstellen. Unternehmen sollten Ihre Teams Experten nach Ideen und Input fragen. Es gibt viele vielversprechende Möglichkeiten, die man allein durch die Kombination eigner textreichen Anwendungsdaten mit Basismodellen erkunden kann.

KI-Evolution ist extrem dynamisch: Datenintegration ist der stabile Schlüsselfaktor

Generative KI ist ein äußerst dynamischer Bereich, in dem jeden Monat neue Modelle und Architekturen auftauchen. In der Zukunft werden wir eine Fülle von benutzerdefinierten Basismodellen für bestimmte Branchen und Berufe sehen, die die Leistung von kommerziellen RAG-Implementierungen erheblich verbessern. Neue architektonische Entwicklungen könnten den Datenfluss zwischen Quellsystemen und KI-Modellen erheblich vereinfachen, einschließlich der Live-Abfrage von Produktionsdaten. Daher ist es für Unternehmen sinnvoll, sich auf die Datenintegration und die effektive Verwaltung von RAG zu konzentrieren, um KI optimal für ihre spezifischen Geschäftszwecke nutzen zu können. Denn nur durch den Einsatz automatisierter Datenpipelines und deren Aufteilung in diese zwei Stufen erhält man einen zuverlässigen, flexiblen und modularen Datenfluss.