So beeindruckend Large Language Models (LLMs) sind, als eigenständiges, vorab trainiertes Tool unterliegen sie klaren Grenzen. Um kontextbezogene und erklärbare Antworten zu erhalten, müssen die Sprachmodelle auf kuratiertes, domänenspezifisches Wissen zurückgreifen können. Retrieval-Augmented Generation (RAG) bietet dazu den momentan wohl effektivsten Ansatz.

RAG ist ein Architekturansatz, der LLMs verbessert, indem er das Sprachmodell mit einer externen Quelle mit spezifischen, für den jeweiligen Anwendungsfall wichtigen Daten verknüpft. Im Grunde funktioniert RAG damit ähnlich wie eine Erweiterung oder ein Add-on, das die GenAI relevanter, aktueller und präziser macht.

Warum braucht man RAG?

Aber warum ist dieses Hinzufügen von externen Daten für LLM-Anwendungen im Enterprise-Umfeld überhaupt notwendig? Die meisten großen Sprachmodelle wurden auf Basis einer sehr großen Menge an öffentlich zugänglichen Daten (z. B. Internet) trainiert. Damit decken sie zwar ein sehr breites Spektrum ab und haben (fast) immer eine Antwort parat. Im Rahmen von Geschäftsanwendungen kommt es jedoch zu Problemen:

- Fehlende Genauigkeit: LLM arbeiten nach dem Wahrscheinlichkeitsprinzip: Zur Beantwortung einer Anfrage werden nicht notwendigerweise allein die richtigen, sondern vor allem die rechnerisch wahrscheinlichsten Informationen herangezogen. Die Antworten können also falsch, unsinnig oder völlig erfunden sein. Solche KI-Halluzinationen sind durchaus normal für LLMs. In Geschäftsanwendungen können sie allerdings enormen Schaden verursachen.

- Fehlender Kontext: Große Sprachmodelle sind zwar gut darin, überzeugende Sprache zu generieren, sie verstehen aber die Bedeutung der verarbeiteten Sprache nicht wirklich. Im Machine Learning nenn man dieses Phänomen einen „stochastischen Papagei“: Die LLM plappert nach, ohne über ein echtes Verständnis zu verfügen. Antworten sind teilweise irrelevant, zweideutig, unvollständig oder wirken aus dem Zusammenhang gerissen. Gerade aber dieser Zusammenhang – der Kontext – ist für den spezifischen Anwendungsfall grundentscheidend.

- Fehlende Erklärbarkeit: LLMs sind nicht in der Lage, die von ihnen gelieferten Daten zu überprüfen, zu erklären oder auf ihren Ursprung zurückzuverfolgen. In manchen Fällen erfinden sie sogar eine Quelle, was das Vertrauen in die Anwendung massiv beeinträchtigt. Zudem steht die fehlende Transparenz im Widerspruch zu zahlreichen regulatorischen Compliance-Vorgaben und KI-Richtlinien.

- Fehlende Aktualität: Große Sprachmodelle sind vortrainiert und basieren auf statischen Daten. Regelmäßige Updates oder Re-Trainings sind extrem zeitaufwändig und kostspielig. Dementsprechend fehlt es den generierten Anwendungen oft an Aktualität. ChatGPT zum Beispiel befand sich lange Zeit wissenstechnisch auf dem Stand von 2021.

Bevor LLMs im Unternehmen zum Einsatz kommen, gilt es diese Probleme zu lösen und die Sprachmodelle an den jeweiligen Anwendungsfall anzupassen. RAG ermöglicht genau das.

Das sind die Vorteile von RAG

RAG kombiniert zwei Ansätze: abfragebasierte Modelle und generative Modelle. Die abfragebasierten Modelle rufen Wissen aus externen Datenquellen ab (z.B. der eigenen Unternehmensdatenbank) und integrieren die spezifischen Daten in Echtzeit in die generativen Sprachmodelle. Damit kann RAG die oben angeführten, grundlegenden Probleme effektiv angehen.

- Genauigkeit: Die ergänzenden RAG-Daten können Wissenslücken von LLM schließen und eine zuverlässige Source-of-Truth darstellen. Damit sinkt das Risiko von KI-Halluzinationen, während sich die Genauigkeit – und Korrektheit – der Antwort verbessert.

- Kontext: Kontext entsteht, wenn Informationen miteinander verknüpft und in ihrer Gesamtheit analysiert werden. Dafür sorgt RAG: Das LLM kann Prompts mit relevanten Daten ergänzen und so ausführliche Antworten geben.

- Erklärbarkeit: Mit Bezug auf die vom RAG gestellten Datenquellen können die Sprachmodelle den genauen Ursprung der Informationen benennen. Es stellt den LLMs zudem einen Bezugsrahmen bereit, um zu erklären, warum sie welche Informationen für welchen Prompt herangezogen haben.

- Aktualität: Mit RAG lassen sich LLMs auf dem neuesten Wissenstand halten, und zwar ohne ein aufwändiges Re-Training vornehmen oder das Sprachmodell verändern zu müssen. Wie über einen ständigen Zulauf von Frischwasser werden aktuelle Daten ergänzt und sorgen für aktuelle Antworten.

So funktioniert RAG

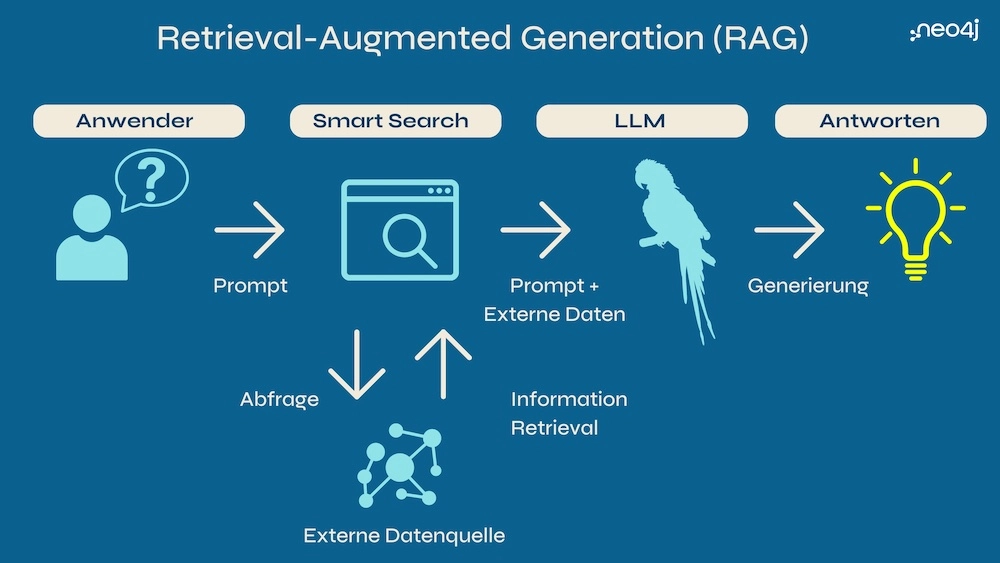

Im Kern geht es bei RAG darum, das interne Wissen von LLMs mit externen Wissensquellen zu verbinden. Um zu verstehen, wie der Ansatz funktioniert, lohnt sich ein Blick in die RAG-Architektur und den beispielhaften Antwortprozess von LLMs (Bild 1).

- Eingabe eines Prompts: Ein Anwender schreibt einen Prompt, um dem LLM-basierten GenAI-Tool eine Aufgabe oder Frage zu stellen.

- Smart Search: Basierend auf dem Prompt startet die Anwendung im LLM eine intelligente Suche (Smart Search) und gleicht ihn mit den Informationen einer externen Datenquelle ab. In der Regel kommt dabei die sogenannte Vektorähnlichkeitssuche zum Einsatz: Die Abfrage wird in einen Vektor – eine numerische Repräsentation – überführt, mit dem Daten in der Datenbank ähnlich zum Vektor gefunden werden können. . Allerdings hat die Vektorsuche auch Grenzen (mehr dazu unten im Abschnitt zu GraphRAG).

- Information Retrieval: Je höher die Ähnlichkeit zwischen Abfragevektor und den Daten, desto höher bewertet die LLM die Relevanz der Informationen für die Bearbeitung des Prompts. Die Daten werden aus der externen Datenbank extrahiert, zurück an die Suche gegeben und dort dem ursprünglichen Prompt beigegeben. Diesen Vorgang bezeichnet man als Information Retrieval (Wiederauffinden von Informationen).

- Antwortgenerierung: Zurück in der GenAI-Anwendung generiert das LLM anhand des Prompts, der eigenen Trainingsdaten sowie den externen „Zusatz“-Daten eine Antwort und gibt diese in natürlicher Sprache an den Anwender weiter.

Die Rolle von GraphRAG

Wenn es um die Implementierung von RAG geht, gilt die bereits oben erwähnte Vektorähnlichkeitssuche als Standard, um relevante Ergebnisse zu finden. Je komplexer die GenAI-Anwendungsfälle, desto deutlicher zeichnen sich in der Praxis jedoch die Grenzen der Technologie ab.

So kann die Vektorsuche zum Beispiel nur semantische Ähnlichkeiten identifizieren und Antworten auf Grundlage einer Wortassoziation generieren. Es fehlt ihr an Struktur, um die einzelnen Elemente der Vektoren zu durchforsten oder Punkte miteinander zu verbinden. Bei komplexen Zusammenhängen fehlt es dementsprechend an Kontext, um Fragen ganzheitlich zu beantworten. Ein neuer Ansatz, der die Vektorsuche für RAG in Kombination mit Knowledge Graphen einsetzt, ist GraphRAG.

Knowledge Graphen organisieren Daten aus unterschiedlichen Quellen und stellen sie als Knoten (z.B. Personen, Orte oder Ereignisse) dar, die über sogenannte Kanten (Beziehungen) verbunden sind. Das Modell der Graphen beschreibt Daten auf eine Weise, dass sie für den Menschen intuitiv verständlich bleiben. Gleichzeitig lassen sie sich auch von Maschinen verarbeiten. Knowledge Graphen ermöglichen kontextbezogene Einblicke und überwinden damit die grundlegenden Einschränkungen der Vektorsuche. Ein auf GraphRAG gestütztes LLM kann semantische Ähnlichkeiten in Texten abgleichen und gleichzeitig den Kontext strukturierter Daten verstehen. Die auf diesem Weg generierten Antworten, gehen dabei „näher“ auf die eigentliche Frage ein.

Die wichtigsten Use Cases für RAG

RAG-gestützte LLMs ermöglichen eine breite Palette von Anwendungsfällen in der Praxis. Sie sind besonders wichtig in Bereichen, die ein tiefes Verständnis von großen Datenmengen und Zusammenhängen erfordern. Hier einige Beispiel:

- Unternehmens-Chatbot: Ein RAG-Chatbot liefert Anwendern präzise, detaillierte und kontextbezogene Antworten. Dazu gehören sowohl Kunden im Online-Shop und Besucher der Webseite als auch Partner im Lieferanten-Portal oder Mitarbeitende in der Enterprise Search sowie im unternehmenseigenen IT-Support.

- Disziplinspezifischer Assistent: In Fachbereichen sorgt RAG dafür, dass GenAI-Anwendungen nicht auf oberflächlichen Informationen stehen bleiben, sondern hochspezifisches Wissen bereitstellen. In der Medizin und im Gesundheitswesen können entsprechende Anwendungen, zum Beispiel in Form eines Assistenten, Ärzten helfen, Patientendaten schneller auszuwerten und Behandlungsoptionen nachzuschlagen.

- Content-Empfehlungen: RAG liefert neue Informationen und Fakten, um bestehende Inhalte anzureichern und zu verbessern. Dabei kann es frühere Interaktionen sowie aktuelle Ereignisse, Trends und Daten als Ausgangsbasis nutzen, um Anwendern maßgeschneiderte Inhalte zu empfehlen.

- Forschung und Entwicklung: In der Wissenschaft wächst die Menge an Informationen schneller, als sie von Forschern aufgenommen werden kann. Die Extraktion relevanter Daten aus wissenschaftlichen Datenbanken, Fachpublikationen oder Studien via RAG kann helfen, komplexe Forschungsanfragen aus einem neuen Blickwinkel zu betrachten.

Die Anwendungsszenarien für RAG sind damit noch längst nicht ausgeschöpft. GenAI gehört zu einer der sich am schnellsten entwickelnden Technologien überhaupt. Unternehmen müssen sich nicht nur die Frage stellen, wie sie die KI-Anwendungen nutzen wollen. Sie brauchen auch heute schon eine Antwort auf die Frage: „Was kommt als nächstes in Sachen GenAI?“. Eine gute Strategie ist es daher, Basistechnologien rund um das Datenmanagement aufzubauen, darunter zum Beispiel Graphdatenbanken. So lassen sich dann auch kommende KI-Innovationen und Weiterentwicklungen integrieren.