In einer zunehmend datengetriebenen Geschäftswelt ist es entscheidend, Informationen schnell, verlässlich und konsistent bereitzustellen. Gleichzeitig werden viele Unternehmen mit immer komplexeren, fragmentierten und schwer handhabbaren Datenlandschaften konfrontiert.

Unterschiedliche Systeme, Formate und Schnittstellen führen dazu, dass Daten häufig mehrfach verarbeitet, transformiert und verschoben werden müssen – oft in aufwändigen, mehrstufigen Prozessen. Das Ergebnis: hohe Rechen- und Wartungskosten, lange Durchlaufzeiten, Qualitätsverluste und eine geringe Flexibilität bei sich ändernden Anforderungen.

Ein zentrales Problem liegt dabei im Aufbau herkömmlicher Datenarchitekturen: Traditionelle ETL-Pipelines (Extract, Transform, Load) oder REST-APIs (Representational State Transfer) haben sich bisher zwar in vielen Szenarien bewährt, stoßen jedoch zunehmend an ihre Grenzen. Die Datenverarbeitung erfolgt oft zu spät, was zu isolierten, redundanten Lösungen mit hohem Wartungsaufwand führt.

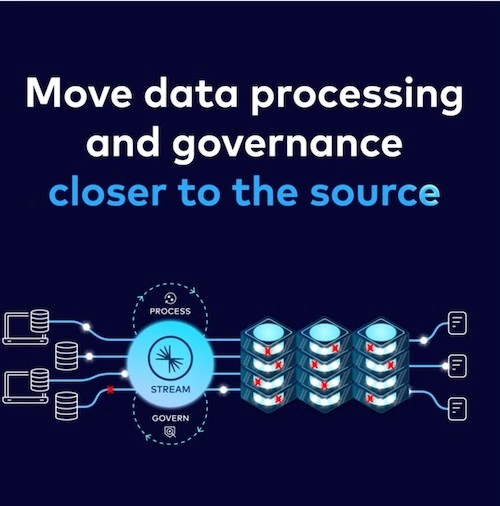

Vor diesem Hintergrund gewinnt der strategische Ansatz „Shift Left“ an Bedeutung und adressiert die Schwachstellen dieser herkömmlichen Architekturen. Ziel dieses Ansatzes ist es, Verarbeitungsschritte möglichst früh im Datenfluss – also nahe an der Quelle – zu verlagern. Indem Daten früher verarbeitet werden, lassen sich viele typische Probleme herkömmlicher Architekturen vermeiden, was zu effizienteren und flexibleren Datenarchitekturen führt.

Probleme traditioneller Datenarchitekturen

Traditionelle Datenarchitekturen wie das Medaillon-Modell mit Bronze-, Silber- und Gold-Stufen wurden ursprünglich entwickelt, um die Kluft zwischen operativen und analytischen Systemen zu überbrücken. Heute gelten diese Strukturen jedoch als ineffizient, langsam und teuer. Jeder Zwischenschritt – von der Extraktion über die Transformation bis zum Laden – erfordert erhebliche Rechen- und Speicherressourcen, was den Wartungsaufwand und die Kosten erhöht. Zudem führt die mehrfache Umwandlung von Daten zu Verzögerungen, Qualitätsverlusten und Inkonsistenzen.

Darüber hinaus reagieren solche Architekturen empfindlich auf Veränderungen in Quellsystemen. Fehler werden oft erst spät erkannt, was zu inkonsistenten Berichten führt. Außerdem greifen operative und analytische Workloads auf unterschiedliche Datenquellen zu, wodurch die Daten mehrfach gespeichert und verarbeitet werden müssen. Es entstehen redundante Prozesse und Synergien bleiben ungenutzt, was datenbasierte Entscheidungen erschwert. Unternehmen sind gezwungen, auf veränderte Anforderungen mit komplexen und teuren Anpassungen in bestehenden Pipelines zu reagieren. Das bremst Innovationen aus und führt zu einer schwerfälligen IT-Landschaft, die mit den Anforderungen moderner, datengetriebener Geschäftsmodelle nicht mithalten kann.

Die Rolle von Shift Left

Shift Left zielt darauf ab, die Komplexität dieser Verarbeitungsschritte zu verringern und die Lücke zwischen operativen und analytischen Systemen zu schließen – ohne dabei aufwändige, fehleranfällige Prozesse in Kauf nehmen zu müssen.

Im Gegensatz zu traditionellen ETL- oder ELT-Pipelines, die Transformationen erst spät im Prozess ausführen, setzt Shift Left auf eine frühzeitige Standardisierung, Bereinigung und Strukturierung direkt an der Quelle. Statt für jede Anwendung eigene ETL-Pipelines zu pflegen, etabliert Shift Left eine einheitliche, klar dokumentierte Schnittstelle für operative und analytische Workloads. Das reduziert die Fragmentierung von Datensilos und gewährleistet, dass alle Geschäftsbereiche auf dieselben validierten und verlässlichen Daten zugreifen können. Ein zentraler Baustein dabei ist Change Data Capture (CDC): Eine Technologie, die Datenänderungen in Echtzeit erkennt und nutzbar macht, ohne bestehende Systeme zu belasten. Dadurch können Daten kontinuierlich aktualisiert und konsistent aufbereitet werden, wodurch Unternehmen Daten sofort analysieren können, statt auf Batch-Läufe zu warten.

Ein weiterer Vorteil von Shift Left ist die hohe Skalierbarkeit. Anstelle von monolithischen ETL-Prozessen mit hoher Rechenlast setzen Unternehmen auf dezentrale, dynamisch skalierbare Datenpipelines. Das reduziert nicht nur die Wartungskosten, sondern sorgt auch für eine zuverlässige und ausfallsichere Verarbeitung. Diese Architektur stärkt zudem die Compliance und Governance. Da Daten frühzeitig validiert und bereinigt werden, können regulatorische Anforderungen erfüllt werden, bevor die Daten weiterverarbeitet oder gespeichert werden. Das senkt das Risiko von Datenschutzverstößen und erhöht das Vertrauen in die Daten innerhalb des Unternehmens.

Optimierte Datenbereitstellung und Skalierbarkeit

Im Kern ermöglicht der Shift-Left-Ansatz die Entwicklung sogenannter Data Products. Diese standardisierten, verlässlichen und wiederverwendbaren Datenbausteine fungieren als klar definierte, konsumierbare Datenobjekte mit hoher Qualität, Aktualität und Governance. Ergänzt werden sie durch Data Contracts, die als verbindliche Vereinbarungen zwischen Datenproduzenten und -konsumenten dienen. Diese verhindern unerwartete Änderungen und sorgen für eine stabile und vertrauenswürdige Datenbasis. Damit schaffen Unternehmen eine stabile Grundlage für datenbasierte Entscheidungen – unabhängig davon, ob sie operativ oder analytisch motiviert sind.

Ein Data Product lässt sich entweder als Echtzeit-Datenstrom über Apache Kafka bereitstellen oder tabellarisch in Apache Iceberg ablegen, um analytische Abfragen zu erleichtern. Streaming-Daten eignen sich besonders für Event-getriebene Architekturen, während Tabellenformate eine solide Basis für Business Intelligence und Machine Learning bieten.

Die Kombination aus Streaming- und Batch-Technologien führt zu einer hybriden Architektur, die operative und analytische Workloads gleichermaßen effizient unterstützt. Je nach Anwendungsfall können Unternehmen flexibel entscheiden, welche Form der Bereitstellung am besten geeignet ist. Kafka-Konnektoren sorgen hier für eine reibungslose Integration, indem sie Datenströme in verschiedene Zielsysteme leiten, ohne dass komplexe individuelle Schnittstellen entwickelt werden müssen.

Fazit

Shift Left steht für einen Paradigmenwechsel im Datenmanagement: Durch die frühzeitige Transformation, Standardisierung und Bereitstellung von Daten werden Effizienz, Qualität und Wiederverwendbarkeit erheblich verbessert. Unternehmen, die diesen Ansatz verfolgen, profitieren von niedrigeren Kosten, höherer Flexibilität und präziseren Entscheidungsgrundlagen. Mit Shift Left schaffen Unternehmen eine skalierbare, zukunftsfähige Datenarchitektur, die flexibel auf neue Anforderungen reagiert und sowohl operative als auch analytische Workloads effizient unterstützt – ein strategischer Ansatz für alle, die datenbasiertes Handeln nicht nur ermöglichen, sondern gezielt vorantreiben möchten.