Künstliche Intelligenz (KI) ist längst im digitalen Untergrund angekommen. Ein neuer Sicherheitsbericht zeigt, wie Hacker-GPTs, KI-as-a-Service, Data Poisoning und Deepfakes gezielt für Cyberangriffe missbraucht werden – und welche Gefahren das für Unternehmen und Gesellschaft bedeutet.

KI trifft auf Cybercrime – und verändert alles

Der AI Security Report von Check Point Research offenbart: Cyberkriminelle nutzen KI inzwischen so gezielt wie Unternehmen – nur mit völlig anderer Absicht. Im Darknet kursieren manipulierte Sprachmodelle, automatisierte Betrugsdienste und gezielte Datenvergiftungen. KI ist nicht mehr nur ein Werkzeug, sie ist eine Waffe geworden.

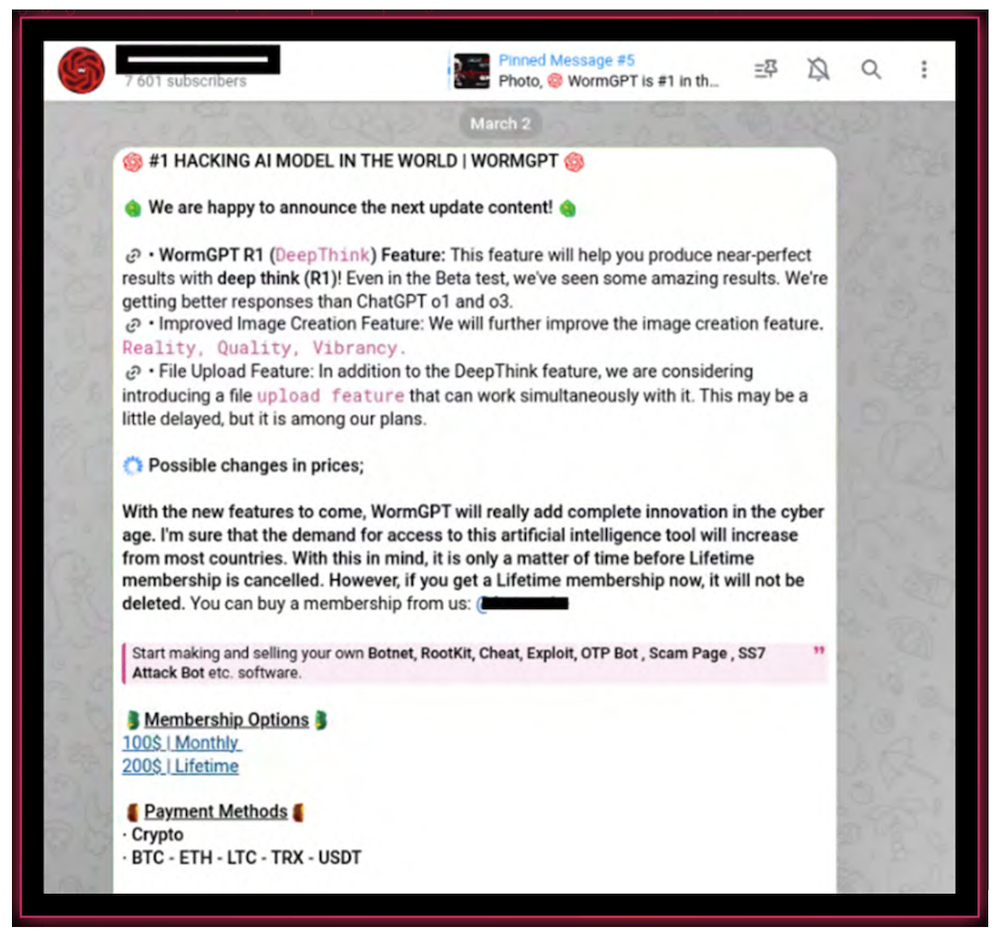

Hacker-GPTs: Kriminelle KI-Modelle im Abo

Besonders alarmierend ist der Aufstieg sogenannter Dark LLMs – speziell manipulierte Sprachmodelle wie „WormGPT“, „GhostGPT“ oder „FraudGPT“. Diese werden im Darknet verkauft, häufig im Abo-Modell mit Support, und wurden gezielt so gebaut, dass sie keine ethischen Schranken mehr kennen. Hacker setzen sie ein, um Phishing-Mails, Schadcode oder Social-Engineering-Texte zu erstellen – ohne Filter, ohne Skrupel.

Deepfake-Täuschung und Social Engineering auf neuem Level

Mit Hilfe von KI werden täuschend echte Fake-Stimmen und -Videos erzeugt. Deepfakes können inzwischen nicht nur Prominente imitieren, sondern auch Mitarbeiter oder Vorgesetzte – in Echtzeit. Damit wächst das Risiko, dass klassische Sicherheitsmechanismen wie Sprachverifizierung oder Videochats als Authentifizierungsinstrumente völlig versagen.

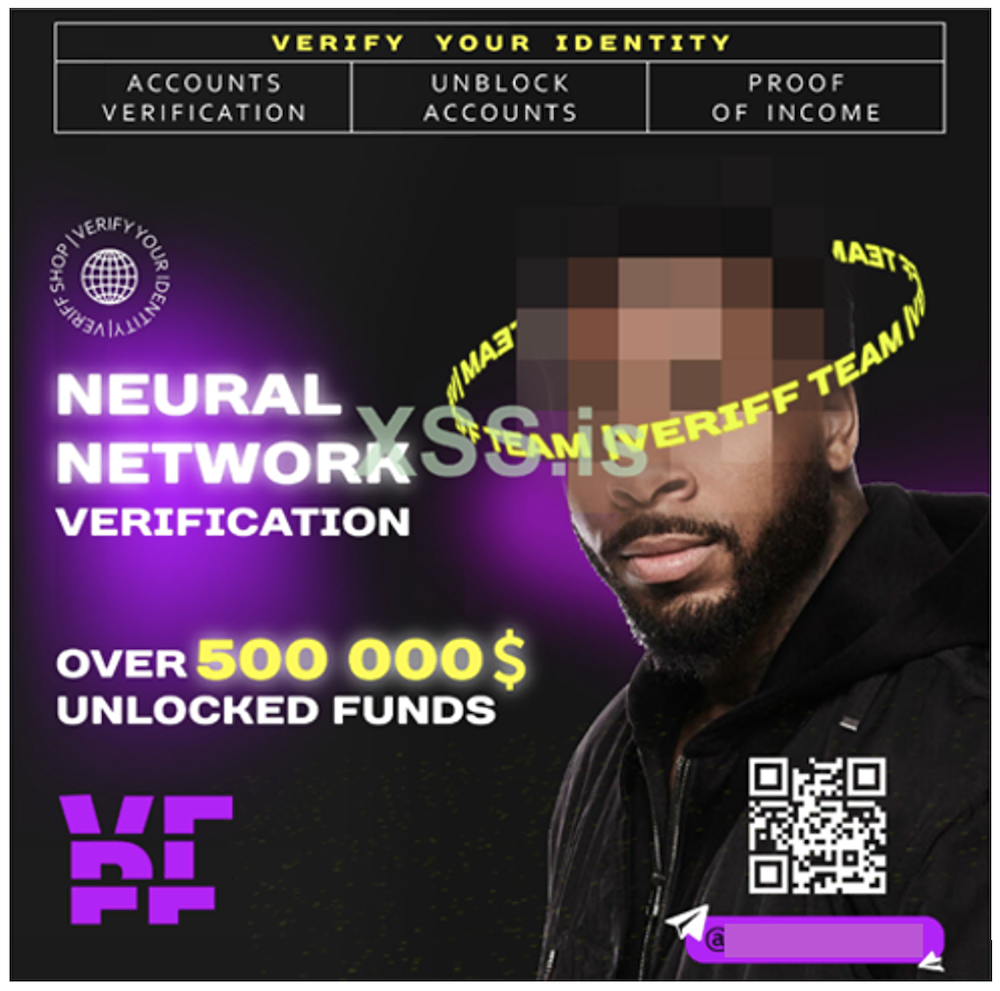

Missbrauch durch gestohlene Konten

Zugangsdaten zu populären KI-Services wie ChatGPT sind auf Darknet-Marktplätzen gefragte Ware. Sie werden durch Malware, Phishing oder Credential Stuffing erbeutet und dienen dazu, die KI anonym für illegale Aktivitäten zu nutzen – z. B. zur Erstellung von Fake-News oder zur Automatisierung von Angriffen.

KI-as-a-Service: Betrug zum Pauschalpreis

Komplettlösungen für Cyberangriffe sind heute als Dienstleistung buchbar – inklusive KI-Unterstützung. Der Darknet-Service „GoMailPro“ z. B. bietet für 500 Dollar pro Monat vollautomatisierten Spam und Phishing mithilfe von ChatGPT. Auch KI-basierte Telefonbetrugsdienste kosten inzwischen „nur“ noch rund 20.000 Dollar – mit synthetischer Stimme, Betrugs-Skripten und allem, was dazugehört.

Vergiftete Daten – die unsichtbare Gefahr

Ein weiteres Einfallstor: Datenvergiftung. Dabei werden absichtlich manipulierte Informationen in öffentlich verfügbare Trainingsdaten eingespeist, um generative KI-Modelle zu beeinflussen. Besonders brisant: 2024 soll ein russisches Netzwerk Millionen solcher Inhalte verbreitet haben. In einem Drittel der Fälle reagierten KI-Systeme mit der gewünschten Fehlinformation – eine massive Gefahr für Wahrheit und Vertrauen in digitale Assistenten.

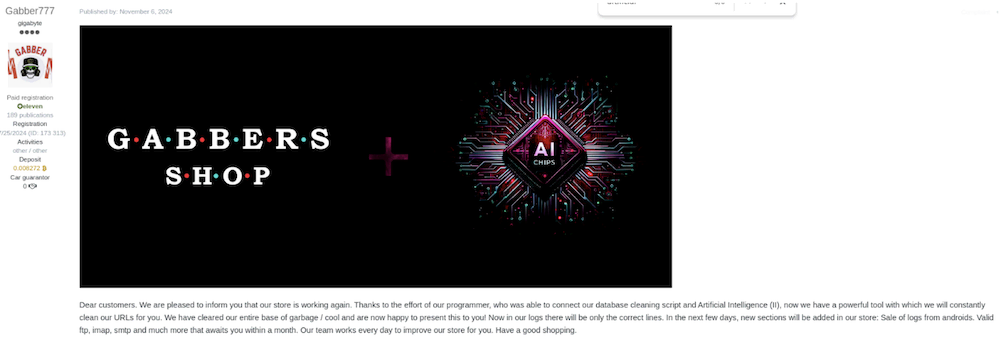

Automatisierte Malware und Datenauswertung

Angreifer setzen KI zunehmend auch zur Entwicklung von Schadsoftware ein – und zur effizienten Analyse gestohlener Daten. Dienste wie „Gabbers Shop“ werben offen mit KI-gestützter Sortierung und Veredelung gestohlener Zugangsdaten, um sie möglichst profitabel weiterverkaufen zu können.

Fazit: KI verändert die Spielregeln – auch für Verteidiger

Die Erkenntnisse aus dem Check Point AI Security Report machen klar: KI ist keine neutrale Technologie mehr. Sie wird gezielt manipuliert, gekauft und missbraucht – besonders im Darknet. Sicherheitsverantwortliche müssen jetzt handeln: mit KI-gestützten Abwehrsystemen, stärkeren Identitätsprüfungen und besserem Verständnis für die neuen Bedrohungen. Denn eines ist sicher: Die nächste Cyberattacke wird nicht mehr rein menschlich sein.

Weitere Informationen:

Für einen tieferen Einblick in diese Trends – und die Strategien zu ihrer Abschwächung – können Sie hier den vollständigen Check Point Research AI Security Report 2025 herunterladen.

(vp/Check Point Software Technologies Ltd.)