Künstliche Intelligenz (Eng.: Artificial Intelligence, kurz KI oder AI), ist überall – so schlägt Ihnen Amazon nach einem Kauf weitere Produkte vor, die Sie kaufen können. Netflix empfiehlt Filme und Serien auf Basis Ihrer bisherigen Auswahl.

Computergenerierte Bilder schlagen Wellen als Deepfakes. Auch Ihr Smartphone ist voller KI-getriebener Software, wie Gesichtserkennung in Fotos. Nicht nur die Anwendungsfälle, auch die Verantwortung von KI-Modellen steigt rasant. Denken wir nur an Medizinroboter, Chatbots für mentale Gesundheit, automatisches Fahren, militärische Drohnen und sonstige Anwendungen, welche die sensibelsten Bereiche eines jeden Menschen berühren.

Wie kommt ein KI-Algorithmus überhaupt zu einer bestimmten Entscheidung?

Abhängig von der Anwendung können sich schließlich ethische, juristische und soziale Bedenken ergeben. Wenn einer Person z. B. ein Kredit nicht gewährt wird, weil die Bonität fehlt, ist das einen sauberen Entscheidungsgrund. Wird einem ein Kredit auf Basis von Geschlecht, Alter oder Rasse nicht gewährt, ist das offensichtliche Diskriminierung. Welche der beiden Optionen tatsächlich die Grundlage für die Entscheidung war, ist allerdings nicht immer klar. Und das, obwohl ein KI-Modell seine Entscheidungsfähigkeit dank der Daten gewinnt, die wir ihm zur Verfügung stellen. Ein KI-Modell ist jedoch wie ein neugeborenes Kind, das seine Umwelt erst mit Daten und Erfahrung erlernt. Genauso müssen KI-Modelle zuerst mit Daten „trainiert“ werden.

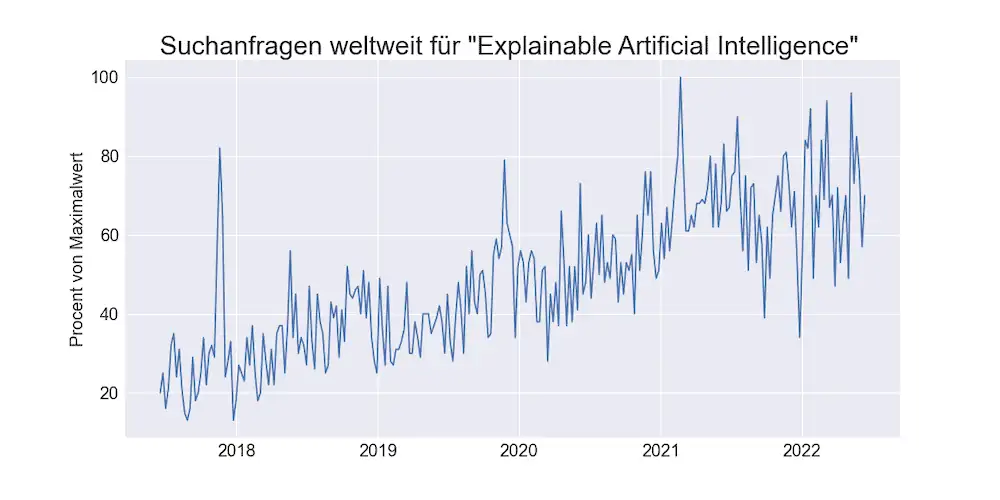

Die Thematik des Interpretierens und Verstehens von KI gewinnt entsprechend immer mehr an Interesse und Aufmerksamkeit seitens verschiedenster Richtungen unserer Gesellschaft. Die Industrie muss ihre KI-Modelle verstehen, um Risiken eingrenzen zu können, die Politik möchte für Fairness und Einhaltung der Regeln sorgen und Bürger möchten wissen, ob er oder sie von einer Maschine nicht möglicherweise unfair behandelt werden könnte. Um das benötigte Vertrauen zu gewährleisten, werden sowohl technische Komponenten, institutionelle als auch juristische Elemente gebraucht. Das führt zur so sogenannten „Explainable Artificial Intelligence“ oder auch kurz XAI, also zur nachvollziehbaren Künstlichen Intelligenz.

XAI: Herausforderungen

Die technischen Komponenten von XAI überwachen die Entscheidungsfindung auf verschiedenen Wegen, und zielen darauf, ein umfassendes Bild zu bekommen, welche Merkmale zu welchen Entscheidungen geführt haben. Der dazugehörige Aufwand ist allerdings sehr stark abhängig vom Modelltyp, so dass bestimmte Modellgruppen sich mehr oder auch weniger für einen Nachvollziehbarkeitsnachweis eignen.

Die Lösung der Probleme liegt allerdings nicht nur in „mehr Technik“. In sicherheitsrelevanten oder regulierten Bereichen ist es abzusehen, dass Zertifizierungssysteme modifiziert oder ganz neu konzipiert werden müssen. Das erfordert ein Neudenken in vielen Industriebereichen. Darüber hinaus wird auf europäische Ebene über einen neuen Rechtsrahmen für KI diskutiert– mit einem europäischen Gesetz wird noch dieses Jahr gerechnet.

Inwieweit diese Entwicklungen jedoch zu Überregulierung führen, ist eine offene Frage. Die Vorreiter der KI, USA und China, haben aus unterschiedlichen Gründen deutlich weniger Hemmungen und Bedenken und priorisieren stark wirtschaftliches Wachstum. Standardisierung und Regulierung könnten ein Wettbewerbsvorteil darstellen – die klassische deutsche Industrie hat das im 20. Jahrhundert eindrucksvoll gezeigt. Die jüngste digitale Vergangenheit der deutschen Wirtschaft ist allerdings weniger von Erfolg geprägt. Nachvollziehbarkeit in der KI ist damit gleichermaßen eine Chance, sowie ein Risiko.

Fazit: Warum XAI so wichtig ist

Die steigende Größe und Komplexität der KI führt dazu, dass immer mehr KI-Services zu sogenannten “Blackboxes” werden. Das heißt, dass nicht einmal die KI-Entwickler, 100%ig genau wissen, warum ein KI-Modell bestimmte Entscheidungen trifft. Manch einer außerhalb der IT-Branche fragt sich: wie kann man nicht wissen was man gebaut hat?

In diesem Bild erkennt man, dass die weltweite Google Suche nach XAI stetig wächst.

Es ist unumgänglich, dass wir die internen Entscheidungswege der KI-Modelle bis hin zum Endergebnis vollständig interpretieren und verstehen können: eben KI erklären. Wenn gewisse Prozesse schwerwiegende Eingriffe in die Lebensbereiche der Menschen haben können, müssen wir sicherstellen, dass diese überwacht werden. So gut wie alle Gruppen und Menschen sind daran interessiert, XAI erfolgreich umzusetzen: KI-Entwickler, KI-Endkonsumenten und die Regierung bzw. Überwachungsorgane. Unternehmen gewinnen so auch das Vertrauen der Konsumenten und Ämter gegenüber den eigenen KI-Services.

Ebenso ist XAI unabdingbar für eine Gesellschaft, welche faire Chancen für alle Bürger bieten möchte. Man stelle sich eine Gesellschaft vor, welche bestimmte Menschengruppen wegen Ihrer Nationalität, Geschlecht oder Religion benachteiligt. Diese Situation aus der Realität würde schnell ihren Platz in den statistischen Daten finden. Wir wissen, dass Daten die Grundlage für alle KI- Modelle sind. Es ist deshalb nachvollziehbar, wie es dazu kommt, dass diese unfairen Vorurteile es bis in unsere KI-Modelle schaffen. XAI hilft Menschen dabei, diese Vorurteile zu identifizieren, zu quantifizieren und zu umgehen.