Unternehmen, die Wettbewerbs- und Innovationsstärke demonstrieren wollen, schreiben sich vermehrt Künstliche Intelligenz (KI) oder Maschinelles Lernen (ML) auf die Fahnen. Wer aber hinter die Firmenversprechen und Marketing-Botschaften schaut, erkennt: Es gibt noch großen Nachholbedarf, insbesondere hinsichtlich Umsetzung und realer Geschäftsnutzen.

Hier kommen MLOps ins Spiel, eine Wortkopplung aus Machine Learning und Operations (Abläufe oder Prozesse).

Die aktuelle „Studie Machine Learning/Deep Learning 2019“ der IDC zeigt auf, dass ML und Deep Learning derzeit zu den drei wichtigsten IT-Themen gehören. Nur Cloud Computing und Sicherheit haben einen noch höheren Stellenwert. Die Ausgaben für ML-Anwendungen sollen bis 2021 demnach auf rund 57,6 Milliarden Euro steigen. Konkrete ML-Einsatzbeispiele sind die Automatisierung des Kundendienstes,vorausschauende Wartung im Produktionsumfeld oder eine Zusammenführung von Finanzdaten, um Prognosen und KPIs für die kommenden Monate herauszuarbeiten.

Das Problem: Die meisten Unternehmensentscheider sehen in ML eher ein Optimierungstool als eine Möglichkeit, neue Dienstleistungen und Produkte zu entwickeln. Deshalb wird das Machine LearningPotenzial noch längst nicht in seiner Gänze ausgeschöpft und ML-Initiativen, die messbare Ergebnisse liefern, bleiben häufig hinter den Erwartungen zurück. MLOps können hier Abhilfe schaffen, denn sie unterstützen bei Planung und Implementierung entsprechender Initiativen.

Was sind MLOps?

Doch worum geht es bei MLOps genau? Ähnlich wie die DevOps oder DataOps-Ansätze will MLOps den Automatisierungsgrad in Unternehmen erhöhen und die Produktions-, beziehungsweise Prozessqualitätverbessern, wobei geschäftliche und rechtliche Vorgaben erfüllt werden müssen. Es geht hierbei um eineverbesserte Kooperation und Kommunikation zwischen Datenanalysten, Data Scientists, undProzessverantwortlichen. MLOps betreffen den gesamten Lifecycle von ML-Projekten, darunter Modellierung, Orchestrierung und Einsatz, ebenso wie Überprüfung, Diagnose, Governance und Geschäftsmetriken.

Durch ihren Einsatz soll die hohe Zahl an gescheiterten ML-Initiativen reduziert werden. So geht die IDC beispielsweise davon aus, dass bis zu 88 Prozent aller KI- und ML-Projekte bereits in der Testphase fehlschlagen. Können Mängel hingegen frühzeitig ausgemerzt und Maschinelles Lernen mithilfe leistungsstarker und strategisch untermauerter MLOps unterstützt werden, lässt sich deutlich mehr ausdiesem Technologietrend herausholen. McKinsey erklärt in diesem Zusammenhang beispielsweise, dassdie Unternehmen, die ML wirklich effizient und strategisch in ihre Geschäftsabläufe integrieren, von Umsatzsteigerungen zwischen drei und 15 Prozent profitieren können.

ML-Planungen können den Projekterfolg behindern

Aber warum scheitern so viele ML-Vorhaben? Das hat in erster Linie damit zu tun, dass unzählige Unternehmen zwar unbedingt Maschinelles Lernen einsetzen wollen – egal ob im Customer Service oder in der Predictive Maintenance. Oft ist ihnen zu Beginn ihres Vorhabens aber nicht bewusst, wie komplex und vielschichtig ein ML-Projekt aussieht. Bereits die Erstellung eines Modells dauert sehr lange. Daher wäre es sinnvoll und hilfreich, bereits die Modellierung zu automatisieren, eine Paradedisziplin für MLOps, denn sie bieten die Möglichkeit, wichtige Einblicke zu gewinnen, um ML-Ergebnisse effizient in den Produktionsprozess einzubinden. MLOps setzen ebenfallls Expertise, eine umfassende Strategie und stete Pflege voraus.

Ein typisches Data Science-Projekt besteht in diesem Zusammenhang aus vielen verschiedenen Schritten. Zu Beginn geht es darum, ein Problem zu identifizieren und einen klaren Geschäftseinfluss auszumachen. Danach müssen Daten aus den zumeist sehr vielen unterschiedlichen Unternehmensdatenbanken extrahiert werden. Es folgt die Datenaufbereitung, die sich mit der Herausforderung beschäftigt, dass Begriffs- und Zuordnungsdefinitionen sehr klar sein müssen und im Verlauf der Zeit überprüft werden sollten. Ein weiterer Schritt eines typischen Data Science-Projekts ist die Ableitung von Datenzusammenhängen sowie das Aufdecken von Datensätzen, die mit der jeweiligen Geschäftsherausforderung zusammenhängen. Es folgen Datenmodellierung und Evaluierung. Diese Ebenen sind Voraussetzung eines jeden ML-Vorhabens.

Aufwändige Modellmonitoring und -anpassungen

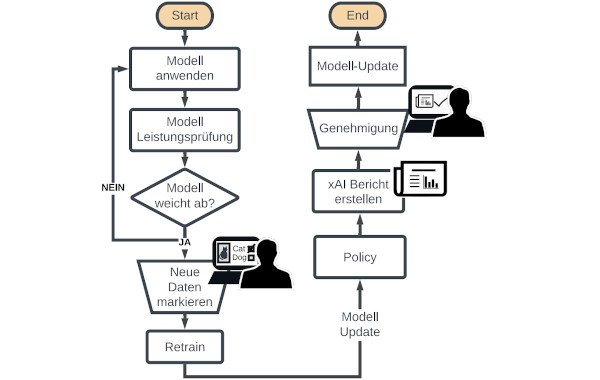

In der Regel ist bereits die Datenerhebung sehr aufwändig, noch mehr Ressourcen werden dann für die tatsächliche Anwendung benötigt. Der Einsatz der jeweiligen Modelle stellt hierbei noch keine große Herausforderung dar. Die Modellperformance sollte jedoch regelmäßig und kontinuierlich überwacht werden, um zu prüfen, ob die Ergebnisse von den konzeptionellen Erwartungen abweichen, besonders, wenn neue Daten hinzukommen. Nicht das Modell an sich ändert sich im Verlauf der Zeit, sondern das Datenkonzept, so dass das bisherige Modell obsolet wird. Veränderungen in den Daten sollten daher bereits in das Ursprungsmodell einfließen. Weitere Herangehensweisen beinhalten das Beobachten der Merkmal- und Funktionsdistribution, der Zusammenhänge zwischen den Features sowie die Zielverbreitung, also inwiefern die Zieldistribution den Trainingsdaten entspricht. Nach Beobachtung der Modellperformance folgt eine Umstrukturierung des Modells, die entweder eine Neufassung des besten Modells sein kann oder ein Retraining aller Modelle gepaart mit Hintergrundanalysen, Erläuterungen und Zuordnung von Mitarbeitern.

Flexibles und skalierbares Datenmanagement gefragt

Eine große und wichtige Frage ist in diesem Zusammenhang, wie sich ein derartig detailliertes und vielschichtiges ML-Projekt in bereits bestehende Geschäftsabläufe einbringen lässt, um diese zu optimieren. Maschinelles Lernen kann beispielsweise mehrere unterschiedliche Programmiersprachen beinhalten, die wiederum verschiedene Systeme nutzen, um die bestmögliche Performance zu erreichen. Problemlos anpass- und erweiterbare Flexibilität gegenüberverschiedenen Programmiersprachen ist daher essentiell.

Modellmonitoring-Berichte geben zudem Aufschluss über die Genauigkeit und Verlässlichkeit von genutzten ML-Modellen. Etablierte Geschäftsprozesse benötigen darüber hinaus oftmals eine gesonderte manuelle Bestätigung. Die Erneuerung des jeweiligen ML-Modells kann beispielsweise angehalten werden, bis der zuständige Mitarbeiter sein Einverständnis gegeben hat.

Um MLOps und somit Maschinelles Lernen in Unternehmen der unterschiedlichsten Branchen besser und effizienter nutzen zu können, ist Interoperabilität gefragt, genauer: die Integration von Daten und verschiedenen externen Systemen sowie die Orchestrierung der Geschäftsabläufe und Services. Gesucht ist außerdem eine Multimodell-Datenbank, die sich durch Flexibilität gegenüber verschiedenen Datentypen auszeichnet – egal ob relational, dokumenten- oder objektbasiert.

Alle Datenmodelle sollten simultan vorliegen und genutzt werden können. Die ML-optimale Datenbank ist zudem skalierbar. Hinzukommen ein grafisches Interface für die verbesserte Datenanalyse, Dashboards für verschiedene Grafiken sowie ein Zusammenspiel unterschiedlicher Funktionen je nach Bedarf und MLEinsatzszenario.

MLOps im Mittelpunkt von Data Science-Vorhaben

Ein konkretes Beispiel wie eine derartige Multimodell-Datenbank aussehen kann ist die Datenplattform InterSystems IRIS, die skalierbares Datenmanagement, flexible Interoperabilität und eine offene Analyseumgebung in einer Lösung vereint und dabei problemlos auch in bestehende IT-Infrastrukturen integrierbar ist.

Die Beantwortung zentraler MLOps-Herausforderungen sollte im Mittelpunkt jedes Data Science-Projekts stehen.

Die Beantwortung zentraler MLOps-Herausforderungen sollte im Mittelpunkt jedes Data Science-Projekts stehen. Eine Lösung wie die InterSystems IRIS Datenplattform unterstützt Entwickler und Unternehmen, MLModelle zukunftsfit für eine umfassende und effiziente Automatisierung im Sinne des digitalen Wandels zu machen, denn sie eignet sich nicht nur für unterschiedliche Programmiersprachen und Systeme, sie bietet zudem detaillierte Model Monitoring-Berichte.

Data Scientists werden bei Daten- und Modelldifferenzen sofort informiert. Sie können außerdem simultan zahlreiche xKI-Prozesse initiieren, um das Verhalten neuer Modelle zu evaluieren und zu erklären. Darüber hinaus lassen sich InterSystems IRIS-basierte Anwendungen problemlos über viele verschiedene Server skalieren. Weitere nützliche Tools sind Analysen, Grafikfunktionen und Dashboards.

Eine derart durchdachte und auf verlässlichen Daten beruhende Herangehensweise stellt künftige MLProjekte auf ein verlässliches Fundament, so dass Unternehmen deutlich mehr aus ihren Bestrebungen in Sachen Maschinelles Lernen herausholen können. So können KI und ML seinen messbaren Geschäftswert entfalten.