In einer zunehmend datengetriebenen Wirtschaft stellen öffentlich zugängliche Daten eine immense, bislang oft ungenutzte Ressource dar. Von amtlichen Statistiken über Branchenportale bis hin zu offenen Big-Data-Datenbanken – Unternehmen können aus diesen Quellen wertvolle Einblicke gewinnen und fundierte Geschäftsentscheidungen treffen.

Doch wie lassen sich relevante öffentliche Informationsquellen identifizieren, effizient aufbereiten und gewinnbringend in Geschäftsprozesse integrieren?

Die Herausforderung: Relevante Datenquellen identifizieren

Die erste Hürde besteht in der gezielten Auswahl: Nicht jede öffentlich verfügbare Datensammlung ist für das eigene Geschäftsmodell von Nutzen. KI-gestützte Tools wie Perplexity.ai helfen dabei, einen strukturierten Überblick über branchenspezifische Datenbestände zu erhalten.

Ein präzise formulierter Prompt ermöglicht eine fundierte Vorauswahl.

Beispiel-Prompt:

“Ich benötige deine Hilfe als Research Assistent und Experte im Bereich der industriellen Fertigung. Erstelle für die Branche “Industrielle Fertigung / Maschinenbau Produktion” eine Tabelle mit mindestens 20 offenen Datenquellen aus dem Bereich BigData / AI. Die Daten sollen gemeinsam mit internen Daten genutzt werden, um Geschäftsentscheidungen zu verbessern, z.B. Verbesserung der Absatzprognose, des Einkaufs hinsichtlich der Marktpreise für Rohstoffe, des Fertigungsprozesses, der Materialauswahl, Maschinenlebenszeit, etc.

Die Tabelle sollte mindestens folgende Spalten enthalten: Name der Plattform, Link, Kurzbeschreibung der enthaltenen Daten, Herausgeber der Daten, Bewertung der Qualität der Daten.

Solltest du weitere Attribute für relevant halten, ergänze die Tabelle. Solltest du Fragen haben, frage nach.”

Beispiele etablierter Datenbanken:

- data.europa.eu

- GENESIS-Online Destatis

- Fraunhofer Big Data AI Datasets

- Kaggle Datasets

- Harvard Dataverse

Kontinuierliches Datenradar aufbauen

Eine einmalige Datenabfrage reicht in der Regel nicht aus – ein kontinuierliches Monitoring ist unerlässlich, um aktuelle Marktveränderungen rechtzeitig zu erkennen. Web-Crawling-Systeme sammeln regelmäßig themenspezifische Informationen aus vordefinierten öffentlichen Datenbeständen und aktualisieren diese laufend.

Drei Strategien zur Integration öffentlicher Datensammlungen

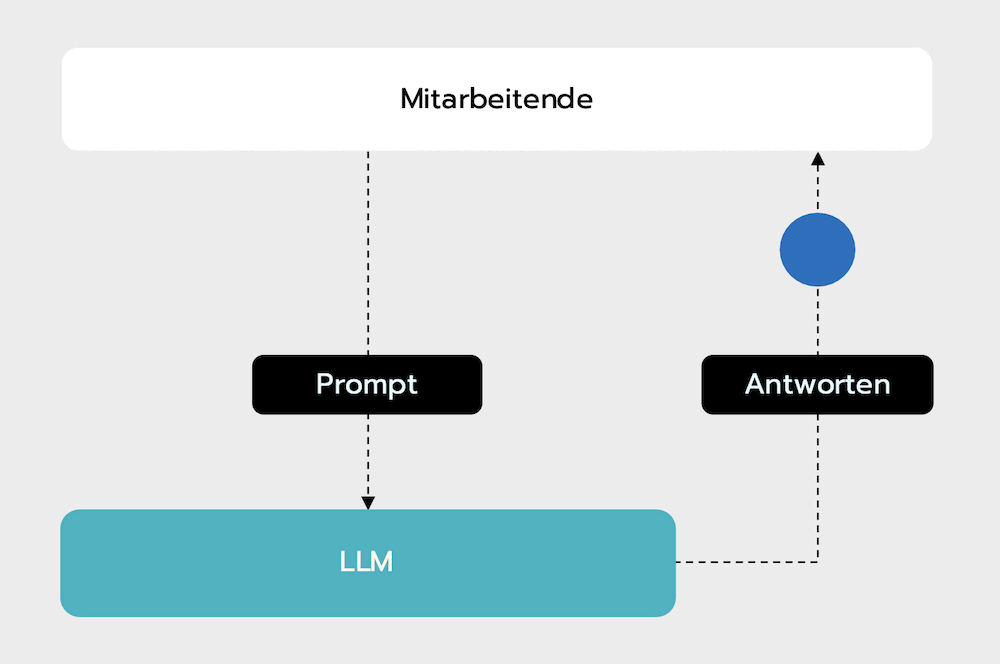

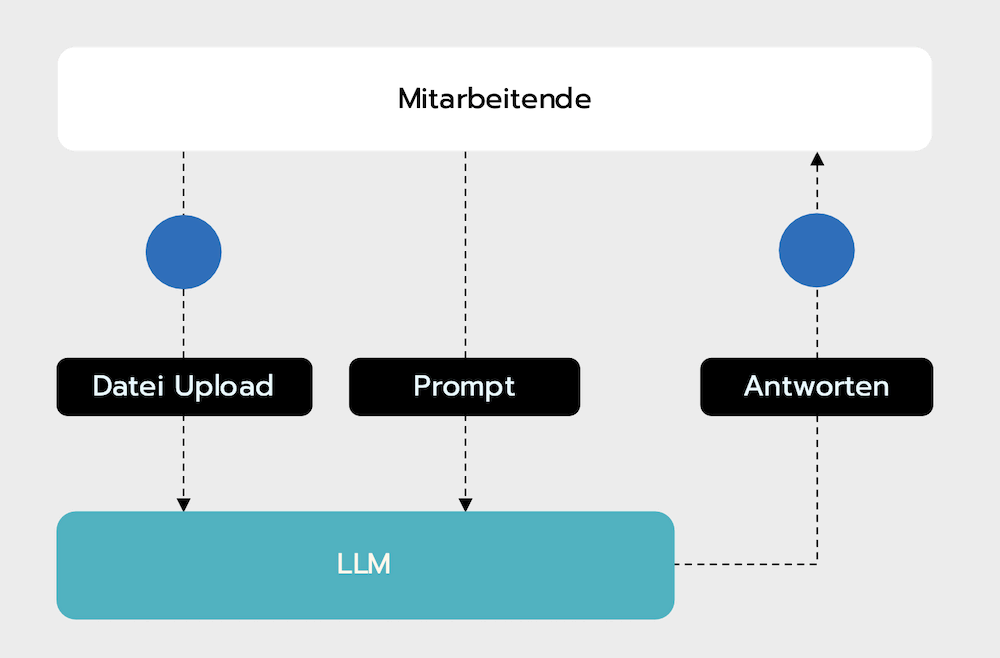

Strategie 1: Schnelle Erfolge mit Low-Code-Lösungen und generativer KI

Für schnelle Ergebnisse bieten sich Low-Code-Lösungen an, die auf großen Sprachmodellen basieren.

Praxisbeispiel: Für die Analyse von Textdokumenten – beispielsweise im Beratungskontext relevante Ausschreibungen, Marktberichte oder Projektbeschreibungen – eignet sich dieser relativ simple Ansatz besonders gut. Durch den Einsatz von Sprachmodellen können Trends und Muster automatisiert extrahiert werden. Mit gezieltem Prompt-Training können Fachanwender so innerhalb kürzester Zeit strukturierte Marktanalysen generieren.

Technologiestack & Maßnahmen:

- Anthropic Claude: Für komplexe Dokumentenanalysen

- Mitarbeiterschulungen: Für effektives Prompt-Design

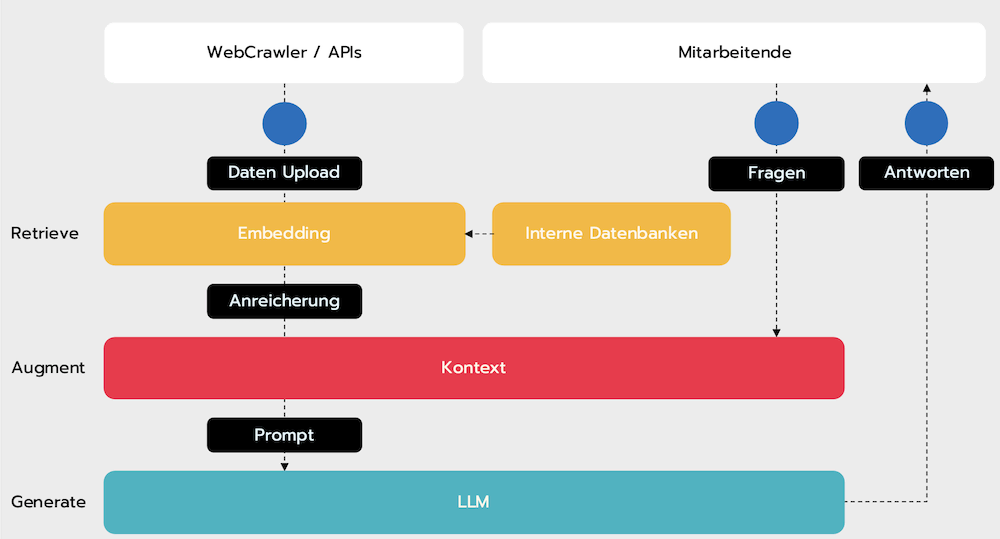

Strategie 2: Kontinuierliches Wissensmanagement mit RAG-Systemen

Retrieval-Augmented Generation (RAG) kombiniert externe Datenressourcen mit internen Beständen, um daraus aktuelles Wissen zu generieren.

Implementierungsbeispiel: Für Organisationen mit hohem Informationsbedarf – etwa im Bereich von Investitionen in erneuerbare Energien – kann ein RAG-System eine effektive Lösung zur kontinuierlichen Marktbeobachtung bieten. Solche Systeme integrieren tagesaktuelle Informationen aus einer Vielzahl öffentlicher Datenbanken und stellen diese strukturiert zur Verfügung. Über eine natürliche Sprachschnittstelle (LLM) können Nutzer komplexe Anfragen zu Solarprojekten oder Finanzierungsstrukturen stellen und erhalten präzise Antworten mit Quellenangaben.

Technologiestack:

- Playwright: Für komplexe Webseiten mit dynamischen Inhalten

- LangChain: Für LLM-basierte Anwendungen

- Sprachmodell: OpenAI API

- Vektor-Datenbank: ChromaDB für interne Informationen

- Embedding-Modell: Sentence-Transformer

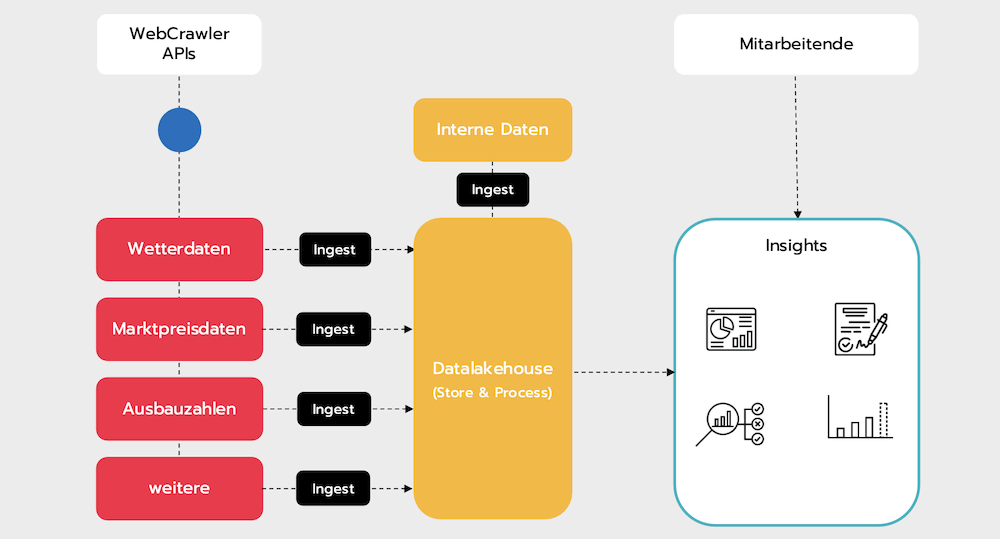

Strategie 3: Skalierbare Lösungen mit Data-Lakehouse-Architekturen

Für Unternehmen mit umfangreichen Datenbedarf bietet sich die Integration externer Informationsquellen in eine zentrale Lakehouse-Architektur an. So entstehen leistungsfähige Prognose- und Analysemodelle – etwa für Preisvorhersagen oder Handelsstrategien.

Implementierungsbeispiel:

Im Energiesektor besteht häufig die Anforderung, öffentliche Informationen wie Wetterdaten, Marktpreise oder Ausbauzahlen erneuerbarer Energien mit unternehmensinternen Betriebsdaten zu verknüpfen. Eine Data-Lakehouse-Architektur bietet hierfür eine leistungsfähige Grundlage.

Mit Tools wie Apache Airflow (einer Plattform zur Orchestrierung komplexer Datenworkflows) und Delta Lake (eine Erweiterung für zuverlässige Datenspeicherung) lassen sich stündlich automatisierte Extraktionen, Transformationen, und das Laden von Daten (ETL-Prozesse) realisieren. Auf diese Weise basieren Entscheidungen stets auf den neusten Informationen.

Technologiestack:

- Datenintegration: Apache Airflow für orchestrierte ETL-Prozesse

- Speicherschicht: Delta Lake mit S3-Storage für skalierbare Datenhaltung

- Verarbeitungsengine: Apache Spark für verteilte Analysen

- Visualisierung: Power BI Dashboards für verschiedene Benutzergruppen

Die rechtliche und ethische Dimension der Datennutzung

Rechtliche und ethische Vorgaben dürfen nicht unterschätzt werden – öffentlich zugängliche Daten unterliegen oft klaren Nutzungsbedingungen. Nur wer diese Quellen rechtskonform nutzt, kann langfristig darauf aufbauen – sowohl rechtlich als auch strategisch. So entsteht eine verlässliche Basis, die sich problemlos mit internen Informationen verknüpfen und in vielfältige Nutzungsszenarien integrieren lässt.

Best Practices:

- Lizenzprüfung: Dokumentation von Nutzungsrechten & Quellenangaben

- Web-Scraping: Einhaltung von robots.txt und Fair-Use-Richtlinien

- Datenschutz: Anonymisierung sensibler Informationen

Fazit: Öffentlichen Daten als strategischer Wettbewerbsvorteil

Unsere Projekterfahrungen zeigen: Die systematische Erschließung und Integration öffentlicher Datenressourcen ist ein entscheidender Erfolgsfaktor. Unternehmen, die strategisch in intelligentes Datenmanagement investieren, verschaffen sich Vorteile bei Marktprognosen, Standortentscheidungen und Produktentwicklungen.

Dabei geht es nicht nur um kurzfristige Effizienzgewinne – offene Informationsquellen ermöglichen skalierbare, rechtssichere und kostengünstige Lösungen, die langfristig tragfähig sind. Ihre Wiederverwendbarkeit, Transparenz und Kombinierbarkeit mit internen Ressourcen machen sie zu einer belastbaren Basis für datengetriebene Innovation. Wer diese Potenziale frühzeitig und rechtskonform nutzt, schafft nicht nur die technologischen, sondern auch die strukturellen Voraussetzungen für einen nachhaltigen Projekterfolg.

Ob schneller Einstieg mit Low-Code-KI, flexibles Wissensmanagement mit RAG oder zukunftsfähige Lakehouse-Architekturen – der Schlüssel liegt in der klaren Ausrichtung auf konkrete Geschäftsziele. Nur wer die richtigen Fragen stellt, erhält auch die richtigen Antworten. Erfolgreiche Datenprojekte verbinden technologische Kompetenz mit tiefem Fachverständnis – und schaffen so nachhaltigen Mehrwert. Technologie ist dabei immer Mittel zum Zweck, nie Selbstzweck.