Mitarbeiter in Unternehmen haben heutzutage unzählige Online-Meetings – und können der Masse an Meeting-Inhalten kaum noch folgen. Es ist daher von großer Bedeutung herauszufiltern, welche Informationen tatsächlich relevant sind. Hier kommt Künstliche Intelligenz (KI) ins Spiel. Mit Hilfe von KI können die „Highlights“ von Online-Meetings automatisch zusammengefasst werden. Mitarbeiter können sich so einen schnellen Überblick über das Besprochene verschaffen. Doch wie geht KI dabei vor?

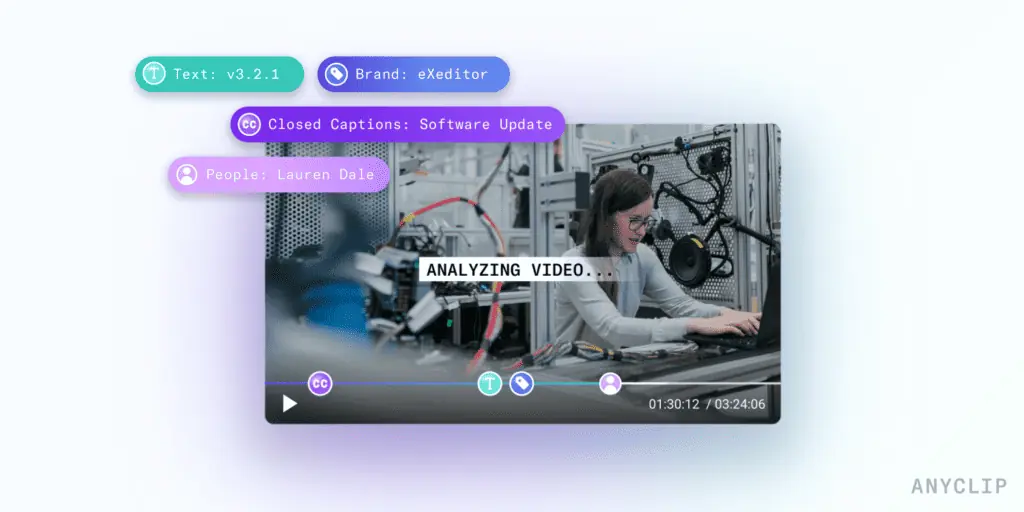

Video-Zusammenfassungen werden mittels Machine Learning-Modellen erstellt, bei denen oft mehrere verschiedene Modelle kombiniert werden. Die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) wird verwendet, um sowohl Speech-to-Text-Transkriptionen des in der Audiospur gesprochenen Textes als auch die optische Zeichenerkennung (OCR) des auf dem Bildschirm erscheinenden Textes zu analysieren. Ziel dieser Modelle ist es zu erkennen, ob der Text Teil einer Besprechung oder Präsentation ist oder aus einer anderen Quelle stammt. Wenn zum Beispiel ein Markenname in einer Präsentation auftaucht, ist das wahrscheinlich relevant für das Meeting; wenn derselbe Markenname auf dem Hemd eines Meeting-Teilnehmers steht, ist das weniger relevant.

KI muss also sowohl in der Lage sein das gesprochene Wort als auch den geschriebenen Text im Zusammenhang zu verstehen. Zudem muss sie bestimmen, welche Inhalte am relevantesten sind. Daraus ergibt sich dann ein „Supercut“ der wichtigsten Clips des Meetings. Aus einer bis zu zweistündigen Besprechung kann so zum Beispiel ein eigenständiges 6-minütiges Highlight-Video erstellt werden.

Die Erstellung von Video-Highlights stellt für KI-Forscher drei wesentliche Herausforderungen dar:

- Kontext erfassen

In der verbalen Sprache verstehen Menschen oftmals Zusammenhänge, die für Maschinen nicht offensichtlich sind. Zum Beispiel bei Pronomen: Wir sagen ein Wort und beziehen uns dann mit Pronomen darauf. In einem Online-Meeting könnte etwa jemand sagen: „Unser Budget betrug in 2022 den Betrag X“. Ein paar Sätze ergänz er: „Aber in 2023 wird es auf Y ansteigen”. Die Zuhörer haben keine Schwierigkeiten zu verstehen, dass „es“ sich auf „Budget“ aus dem ersten Satz bezieht. Einige Minuten später, wenn der Redner über seine Inhaltsstrategie spricht, werden die Zuhörer wiederum verstehen, dass „es“ jetzt „Inhaltsstrategie“ und nicht mehr “Budget” bedeutet.

KI-generierte Inhalte müssen also in der Lage sein zu erkennen, wann jemand das Thema gewechselt hat. Bei der Auswahl der Video-Highlights ist es daher essentiell, einen Satz zu wählen, in dem das Thema explizit genannt wird – sonst besteht die Gefahr, dass der Zusammenschnitt unverständlich und unter Umständen sogar irreführend ist. Die Verwendung von Syntax, Pronomen oder Folienwechseln helfen dem Algorithmus dabei, einen verständlichen Clip zur Darstellung eines Abschnitts auszuwählen.

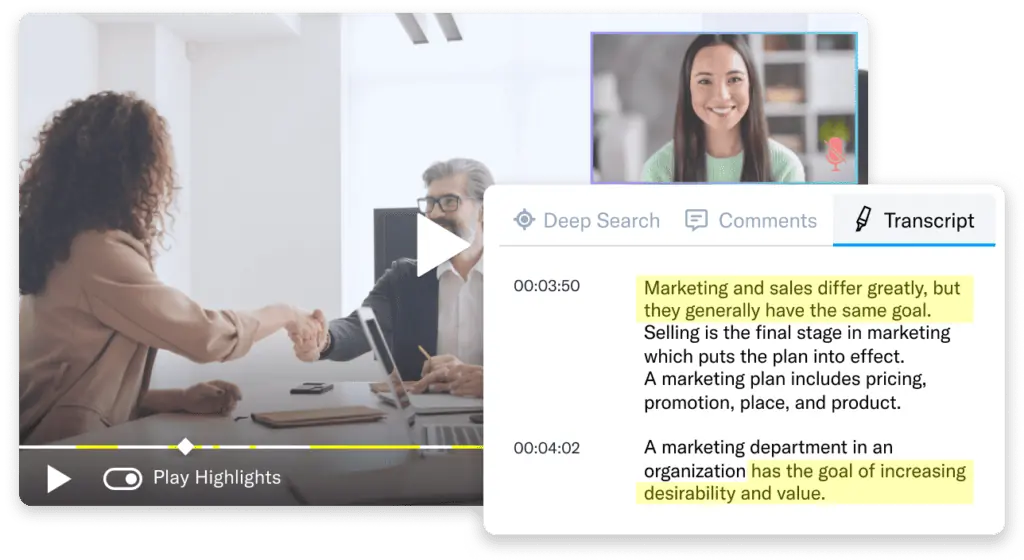

- Sprecher identifizieren

Kommen in einem Video mehrere Personen vor, ist dies eine zusätzliche Herausforderung für die KI-Entwickler: Wenn Sprecher 2 auf Sprecher 1 folgt, ist Sprecher 2 dann ein Co-Sprecher, dessen Informationen gleichwertig sind? Macht er eine wichtige oder eine irrelevante Bemerkung? Beziehen sich Sprecher 1 und 2 auf dasselbe Thema? Diese Fragen lassen sich klären, indem die Stimmen der einzelnen Sprecher identifiziert werden. Zudem muss exakt verfolgt werden, wer was wann gesagt hat. Daraus lassen sich dann zuverlässige Zusammenfassungen ableiten.

- Stimmungsanalyse

Eine der größten (und zugleich kompliziertesten) Herausforderung zur Bestimmung von Video-Highlights ist die Stimmungsanalyse, also die Ermittlung der Emotionen hinter einer Aussage. In der KI-Entwicklung lag der Fokus bisher primär auf der Unterscheidung zwischen positiven und negativen Stimmungen. Viele Forschungsarbeiten befassen sich mit Online-Kommentaren, Rezensionen und emotionalen Ausdrücken in Gesichtern. Für Unternehmensvideos ist es jedoch in der Regel überhaupt nicht relevant, ob eine Aussage positiv oder negativ ist. In diesen gilt es vielmehr darum zu ermittelt, ob eine Aussage wichtig oder unwichtig ist. Um genaue Schlussfolgerungen aus langen Inhalten wie Besprechungen oder Präsentationen zu ziehen, müssen andere Datensätze erhoben werden. Dafür werden neue Forschungsansätze und -möglichkeiten benötigt, an denen die KI-Entwicklung bereits intensiv arbeitet.

Ausblick

Die Erstellung von Video-Highlights im unternehmerischen Kontext erfordert teilweise andere Ansätze als jene, die in der Vergangenheit für die Video-KI verwendet wurden. Die KI-Forschung konzentriert sich daher aktuell verstärkt auf geschäftsorientierte maschinelle Lernmodelle.

Unternehmen, die mit der Evaluierung von Technologien für Video-Highlights beginnen, sollten die oben genannten potenziellen Fallstricke kennen. Nur dann können sie geeignete Tools auswählen, die den Bedürfnissen ihres Unternehmens am besten entsprechen. Dabei sollten sie wissen, welche Arten von Videos das Unternehmen am häufigsten aufnimmt und inwiefern die genannten Herausforderungen auf diese Videos zutreffen.

Video-Highlights haben ein immenses Potenzial, um eine Effizienzsteigerung bei Mitarbeitern zu bewirken – ohne dass eine „Meeting-Müdigkeit“ entsteht. Im Moment hält diese KI-Technologie gerade erst Einzug in Unternehmen. Es ist jedoch davon auszugehen, dass sie schon bald ein wichtiger Bestandteil des unternehmerischen Alltags sein wird.