Künstliche Intelligenz gilt als die Technologie der Zukunft. Um die Akzeptanz ihr gegenüber weiter zu steigern, müssen KI-basierte Entscheidungen jedoch nachvollziehbar sein.

Eine neue Studie im Rahmen des KI-Innovationswettbewerbs des Bundesministeriums für Wirtschaft und Energie (BMWi) befasst sich ausführlich mit der Erklärbarkeit von KI.

Eine Vielzahl von Services und Produkten in sämtlichen Lebensbereichen verdeutlichen bereits, welch enormes Potenzial in KI-Methoden steckt. Allein in Deutschland wird nach Erhebungen des eco- Verbands der deutschen Internetwirtschaft erwartet, dass mit entsprechenden Anwendungen im Jahr 2025 Umsätze in Höhe von fast 500 Milliarden Euro erzielt werden. Das entspricht ca. 13 Prozent des Bruttoinlandsprodukts. Zentraler Erfolgsfaktor ist dabei die Erklärbarkeit der Entscheidungen, die auf Basis von KI getroffen werden, denn nur wenn sich die Entscheidungen auch erklären lassen, bringen Nutzerinnen und Nutzer den Anwendungen die nötige Akzeptanz entgegen. Erklärbarkeit spielt zudem eine entscheidende Rolle im Rahmen von Zulassungs- und Zertifizierungsverfahren sowie zur Erfüllung von Transparenzpflichten.

Für welche Branchen erklärbare KI zwingend nötig ist, welche Erklärungsstrategien für welche Anwendungsfälle geeignet sind und wie die richtige Strategie gefunden werden kann, damit hat sich die Studie „Erklärbare KI – Anforderungen, Anwendungsfälle und Lösungen“ beschäftigt. Die Studie wurde im Auftrag des BMWi im Rahmen der Begleitforschung des KI-Innovationswettbewerbs durchgeführt. Mit dem Programm werden ausgewählte, KI-basierte Leuchtturmprojekte gefördert.

Notwendigkeit der Erklärbarkeit: Je KI-Modell und Branche unterschiedlich

Ein Teil der Studie befasst sich damit, welche KI-Verfahren heute und in Zukunft genutzt werden und somit potenziell erklärbar gemacht werden müssen. Eine entsprechende Umfrage ergab, dass aktuell vor allem statistische bzw. probabilistische Modelle, Entscheidungsbäume und neuronale Netze – also Modelle, die besonders gut geeignet sind, z.B. Bild- und Textdokumente zu analysieren – im Einsatz sind. In Zukunft wird insbesondere Letzteren große Bedeutung eingeräumt.

Dabei ist die Notwendigkeit der Erklärbarkeit auch abhängig von der jeweiligen Branche. Insbesondere in Anwendungsgebieten, in denen kritische Entscheidungen getroffen werden, kommt der Erklärbarkeit eine gewichtige Rolle zu. Oft ist diese sogar zwingend erforderlich, um etwa Zertifizierungen und Prüfsiegel zu erhalten oder die Erfüllung von Normen zu gewährleisten – beispielsweise in der Gesundheitsbranche, wo Fehlentscheidungen schwere Folgen nach sich ziehen können. Weitere wichtige Branchen sind die Finanzwirtschaft, Produktion, Bauwirtschaft oder die Prozessindustrie, wo Fehlentscheidungen oft mit hohen Kosten verbunden sind. Hier eingesetzte KI-Modelle, die ihre Entscheidungen nicht erklären können, werden in der Regel von Kund:innen und Anwender:innen schlicht nicht akzeptiert.

KI-Modelle sollten transparent oder erklärbar sein

In der Studie werden KI-Modelle in zwei Klassen unterteilt, um klar abgrenzen zu können, welche Ansätze einer Erklärung bedürfen: White Box- und Black Box-Modelle. Bei White Box-Modellen liegt ein hoher Grad an Transparenz vor, sodass diese in der Regel selbsterklärend sind. Dazu zählen etwa Entscheidungsbäume, die im Allgemeinen nachvollziehbar aufgebaut sind. Somit sind einzelne Entscheidungen leicht vom Menschen überprüfbar.

Bei den sogenannten Black Box-Modellen ist die Lage anders: Diese Modelle sind nicht transparent und ihre Ergebnisse können nicht einfach nachvollzogen werden. Das ist zum Beispiel bei KI-Modellen wie neuronalen Netzen der Fall. Hier kommt das Konzept der Erklärbarkeit zur Anwendung, wobei zwischen zwei Typen unterschieden wird: Entscheidungserklärungen, die dabei helfen, individuelle, datenbezogene Entscheidungen nachzuvollziehen sowie Modellerklärungen, die dabei helfen, Wirkzusammenhänge von KI-Modellen zu verstehen.

Muss ein Black Box-Modell erklärt werden, stehen Entwickler:innen eine Reihe mehr oder weniger etablierter Strategien zur Verfügung, die die Erklärbarkeit verbessern können. KI-Modelle können beispielsweise durch sogenannte Prototypen oder auch durch die Verwendung von Wissensdatenbanken erweitert werden, um die Modelle nachvollziehbarer zu gestalten. Entsprechende Wissensbasen können beispielsweise im Rahmen von KI-gestützten medizinischen Diagnoseverfahren genutzt werden, um die Symptome eines Patienten nachvollziehbar mit klar definierten Kriterien eines Krankheitsbildes aus wissenschaftlichen Publikationen abzugleichen. Eine weitere Strategie sind Stellvertretermodelle, bei denen auf Grundlage des komplexen Black Box-Modells ein simpleres White Box-Modell entwickelt wird, anhand dessen sich beispielsweise Regelmäßigkeiten ablesen lassen und somit Entscheidungen nachvollziehbarer werden. Im Bereich der Bildanalyse können Ansätze genutzt werden, mit denen auf Basis der Eingangsdaten dargestellt wird, welcher Bereich des Bildes ausschlaggebend für die Entscheidung ist.

Entscheidungshilfe für Anwender:innen und KI-Entwickler:innen

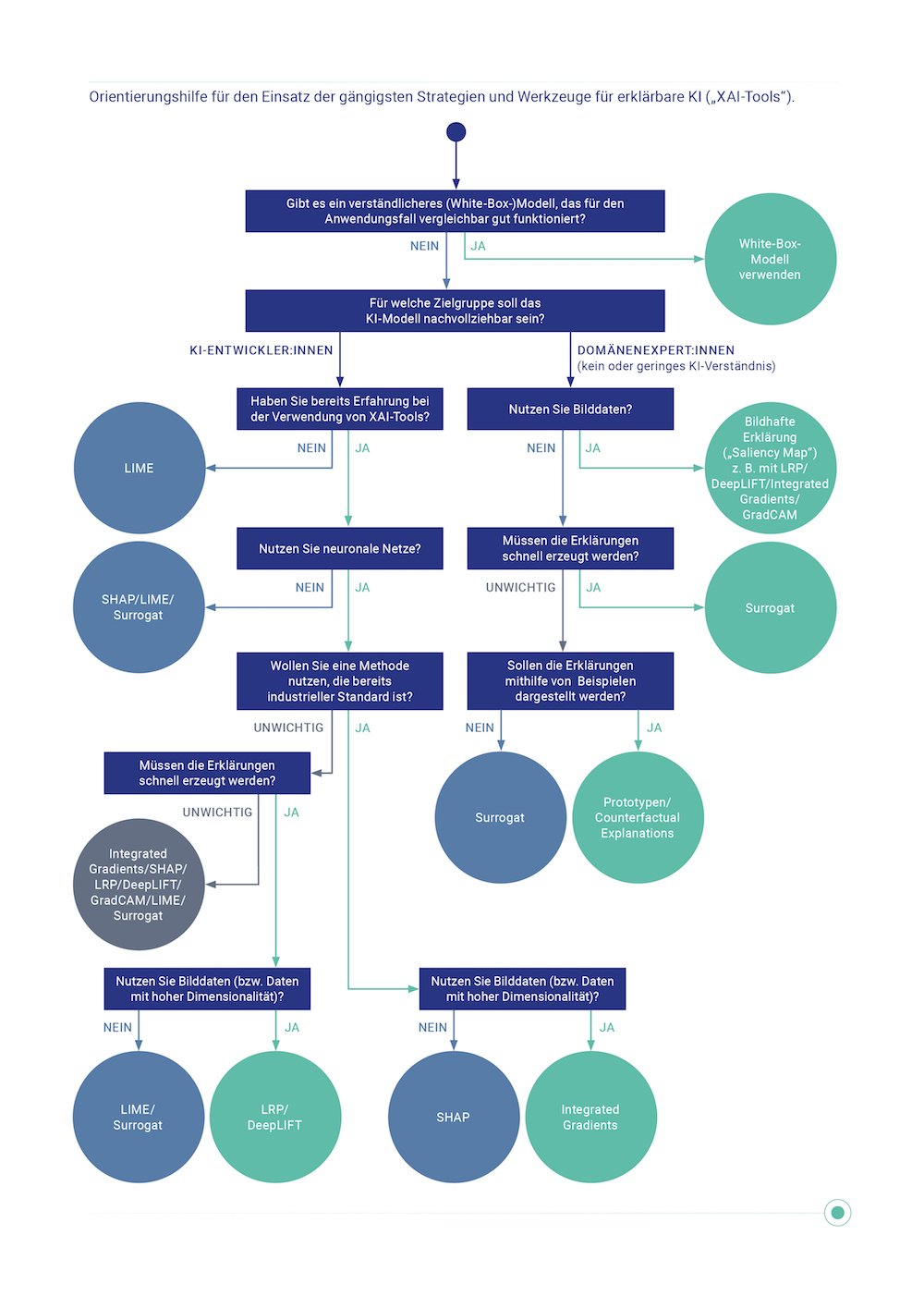

Selbstverständlich ist nicht jede Erklärungsstrategie auf jedes KI-Modell anwendbar. Die passende Strategie für die jeweilige Anwendung zu finden, fällt jedoch nicht immer leicht. Deshalb wurde im Rahmen der Studie ein Entscheidungsbaum entwickelt, der als Orientierungshilfe dienen soll. Auf Basis der Antworten auf eine Reihe von Fragestellungen werden den Nutzer:innen für sie passende Optionen aus den gängigsten Strategien und Werkzeugen für erklärbare KI empfohlen. Die Entscheidungshilfe kann in Zukunft durch neue Methoden ergänzt werden, um eine möglichst große Bandbreite möglicher Erklärungsstrategien abzubilden. So dient sie als erste Anlaufstelle für Entwickler:innen und Anwender:innen von erklärbarer KI.

Die Studie zeigt, wie wichtig die Erklärbarkeit von KI heute bereits ist und in Zukunft auch für Endkund:innen oder Entscheider:innen im Management an Bedeutung gewinnen wird. Dafür muss vor allem die Grundlagenforschung und Herausbildung von Best Practices vorangetrieben werden und die Effizienz und Anwenderfreundlichkeit von KI-Modellen stärker ins Zentrum der Forschung rücken.

Die Studie sollte hier zum Download zur Verfügung stehen.