Mit statistischen Methoden und Verfahren von Machine Learning lassen sich Problemfelder erschließen, die algorithmisch nicht ausreichend zugänglich waren. Um einen Machine Learning Workflow effizient einzusetzen, müssen die richtigen Voraussetzungen geschaffen werden.

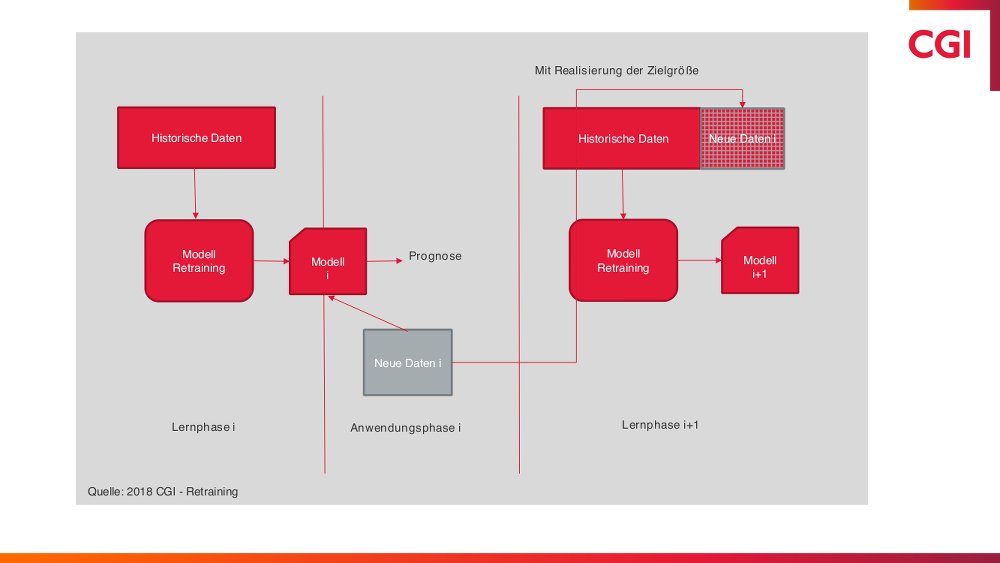

Machine Learning stammt aus der Statistik und gilt in der Zwischenzeit als eigenständige Disziplin in der Informatik. Dabei wird ein statistisches Modell (meist ein Prognosemodell) mit historischen Daten trainiert (Lernphase) und mit neuen Daten (Anwendungsphase) eine Prognose erstellt; das Ganze erfolgt maschinell, ohne menschliches Zutun. Der Machine Learning Workflow wird komplettiert, wenn die heute anfallenden und zur Prognose eingesetzten Daten in die nächste Lernphase eingespeist werden können. Damit wird das Modell sukzessive immer besser, weil es immer mit dem aktuellsten Datenstand arbeitet.

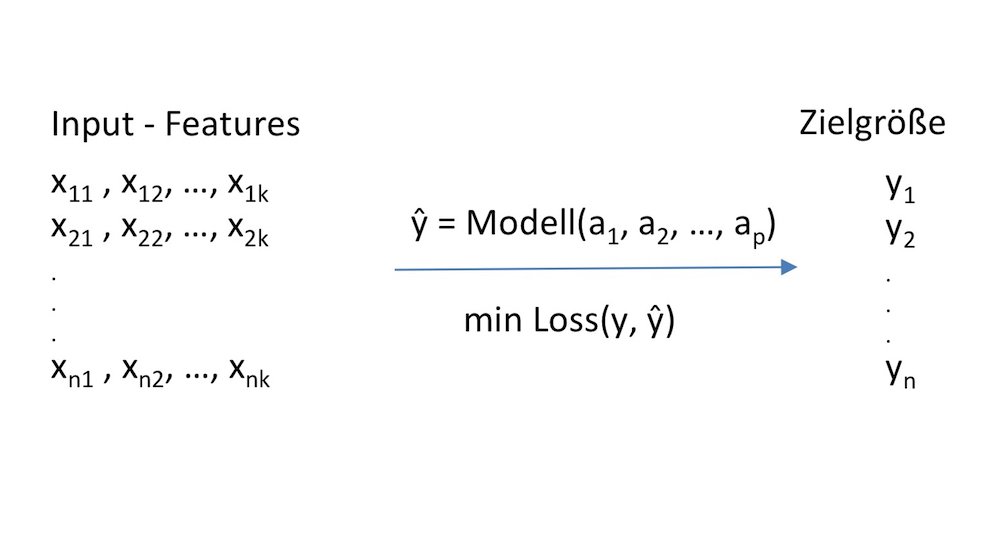

Bild 1: Ein Prognosemodell ist eine Zuordnung der Input-Daten – auch Features genannt – auf eine oder mehrere Zielgrößen. Im diesem Fall liegen k unterschiedliche Features, n unterschiedliche Beobachtungen in den historischen Daten und p unterschiedliche Modellparameter vor. In der Lernphase werden die Modellparameter a1, …, ap so festgelegt, dass eine sogenannte Loss-Funktion optimiert wird. Eine mögliche Loss-Funktion misst beispielsweise die Summe der Abstände zwischen den tatsächlichen Werten der Zielgröße aus den historischen und den prognostizierten Daten. (Quelle: CGI)

Bei einem Supervised-Learning-Ansatz ist die zu prognostizierende Größe für die vorliegenden Daten der Lernphase bekannt. In der Anwendungsphase kommen neue Daten zum Einsatz, wobei die Prognose entweder als Wahrscheinlichkeit (Klassifikation) oder als reelle Größe (Regression) ausgedrückt wird. Im Unterschied dazu prognostiziert der Unsupervised-Learning-Ansatz keine konkrete Größe, sondern identifiziert Strukturen innerhalb der Daten, die Unternehmen dann zum Beispiel für ein Clustering oder Reduktion der Dimension nutzen können.

Umfangreiches Angebot an Algorithmen und Modellvarianten

Auf dem Markt sind eine Vielzahl von Algorithmen und Modellvarianten verfügbar und es kommen auch immer wieder neue und verbesserte hinzu, deren qualifizierter Einsatz einiges an Erfahrung und Kenntnissen voraussetzt. Häufig verwendete Varianten lassen sich drei Modellklassen zuordnen: erstens Lineare Modelle und Decision Trees, zweitens Support-Vector-Machine- und Ensemble-Methoden sowie drittens Neuronale Netze.

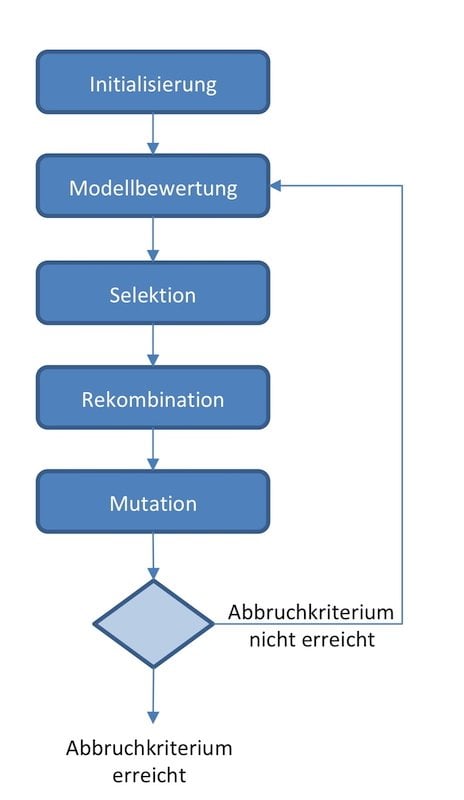

Die Auswahl der geeigneten Feature-Variablen spielt innerhalb eines Machine Learning Workflows eine wichtige Rolle. Während in der klassischen Statistik die Features im Anschluss an eine entsprechende Analyse manuell ausgewählt werden, sollte dies in einem Machine Learning Workflow weitgehend automatisch erfolgen. Dabei lassen sich unterschiedliche Strategien miteinander kombinieren:

-

Auswahl der Features basierend auf deren Werten. Hierbei werden meist Features ausgeschlossen, die (a) eine zu kleine Varianz, (b) bei nominalen Features zu viele unterschiedliche Werte (beispielsweise Namen) oder (c) zu viele fehlende Werte haben. Hierbei müssen sinnvolle, vom Anwendungsfall vorgegebene Grenzwerte festgelegt werden.

-

Auswahl der Features basierend auf statistischen Tests. Unterscheiden lassen sich univariate Tests, wie der Chi-quadrat-Unabhängigkeitstest zwischen einem Feature und der Zielgröße, und multivariate Tests, etwa ANOVA, unter Einbeziehung der Zielgröße.

-

Auswahl der Features basierend auf Modellperformance. Hier wird für unterschiedliche Feature-Kombinationen die Modellperformance berechnet und diejenige mit der besten Performance ausgewählt.

Bild 2: Innerhalb eines Machine Learning Workflows kommt der Auswahl der Features eine wesentliche Bedeutung zu. (Quelle: CGI)

Retraining eines Models

Ein Retraining bedeutet, dass die erzielten Werte der zu prognostizierenden Zielgröße mit den für die Prognose verwendeten Features aus der Anwendungsphase zusammengeführt und diese in die Daten der nächsten Lernphase eingegliedert werden. Unternehmen können so das Prognosemodell immer mit den aktuellsten Daten trainieren und weiter verbessern. Es gibt allerdings auch Use Cases, bei denen kein Retraining des Prognosemodells möglich ist. Das gilt etwa für ein Kreditrisikomodell, denn hier sind Ausfall oder Nichtausfall des Kredits erst nach Jahren bekannt.

Bild 3: Beim Retraining kann das Prognosemodell immer mit den aktuellsten Daten trainiert und sukzessive verbessert werden. (Quelle: CGI)

Auch für die Modellüberwachung werden die Realisierungen der zu prognostizierenden Zielgröße benötigt und diese müssen mit den für die Prognose verwendeten Features aus der Anwendungsphase zusammengeführt werden. Erst dann kann der prognostizierte mit dem realisierten Wert verglichen und damit das Modell bewertet und KPIs berechnet werden. Eine Modellüberwachung sollte immer Teil eines Machine Learning Workflows sein, unabhängig davon, zu welchem Zeitpunkt die realisierten Werte der Zielgröße anfallen.

In einer vereinfachten Sicht umfasst ein Machine Learning Workflow die Lernphase, die Anwendungsphase und die Modellüberwachung. Auf den ersten Blick sehen die Workflows nicht sonderlich komplex aus. Allerdings sollte die Komplexität der einzelnen Komponenten nicht unterschätzt werden. Abhängig vom Anwendungsfall können hier doch einige Personenjahre an Entwicklungsaufwand zusammenkommen. Deswegen sollte bei der Entwicklung der Machine Learning Workflows unbedingt ein methodischer Ansatz befolgt werden. Einer der am häufigsten genutzten methodischen Ansätze ist der Cross Industry Standard Process for Data Mining, kurz CRISP-DM genannt.

CRISP-DM umfasst sechs unterschiedliche Projektphasen. Die erste Projektphase beinhaltet das Verstehen der Geschäftsziele, der Geschäftsanwendung und Prozesse. Diese Phase wird auch als Business Understanding bezeichnet. In der zweiten Phase, dem Data Understanding, werden die vorhandenen Daten analysiert und die darin enthaltenen Strukturen und Probleme bewertet. In dieser Phase sollte auch entschieden werden, ob ein Machine Learning Workflow mit den vorhandenen Daten entwickelt und implementiert werden kann. Es kann durchaus auch sein, dass die Strukturen in den Daten nicht stark genug ausgeprägt sind, um damit ein Prognosemodell entwickeln zu können. Die nächsten Phasen umfassen die Datenaufbereitung, die Modellentwicklung, die Evaluierung und das Deployment der Machine Learning Workflows.

Machine Learning benötigt die passenden Daten

Machine Learning entwickelt sich immer stärker zu einer Schlüsseltechnologie für die Digitalisierung. In den zugänglichen internen und externen Datenquellen kann sehr viel Potenzial vorhanden sein. Welche Möglichkeiten tatsächlich vorhanden sind, lässt sich nur durch eine vorhergehende Datenanalyse und eine Beurteilung der Datenqualität feststellen. Vor dem Start von Machine-Learning-Projekten sollten Unternehmen deshalb zunächst die zugänglichen Daten begutachten und im Zweifelsfall die Datenbasis verbessern.

|

Modellklasse |

Beispiele und Algorithmen |

Eigenschaften |

Anforderungen |

|

|

Lineare Modelle |

|

|

|

|

|

Decision Tree |

|

|

|

|

|

Support Vector Machine |

|

|

|

|

|

Ensemble Methoden |

|

|

|

|

|

Neuronale Netze |

|

|

|

|

Tabelle: Beispiele von Modellklassen, deren Eigenschaften und notwendige Anforderungen für die Modellierung. (Quelle CGI)