Die Menge an Daten, die Unternehmen heute generieren, wächst rasant, und die vorherrschenden Hybrid-Multi-Cloud-Umgebungen werden zunehmend komplexer. Wie lässt sich die wertvolle Ressource „Daten” angesichts dieser Herausforderungen effektiv verwalten, nutzen und schützen?

Table of Contents

Dieses Thema sollte von verschiedenen Seiten beleuchtet werden: Welche Exit-Strategien gibt es bei Wechseln in Multi-Cloud-Umgebungen? Welche Rolle kann Open Source hier übernehmen? Hat Künstliche Intelligenz (KI) das Potenzial zum Gamechanger und kann sie eine transformative Rolle im Datenmanagement, in der Datennutzung und für die Datensicherheit spielen?

Zudem stellt sich die Frage: Wie können hybride Infrastrukturen, Datenschutz und -verfügbarkeit für eine verbesserte Business Intelligence optimiert werden, um in Echtzeit datenbasierte Geschäftsentscheidungen zu treffen und zum Daten-Disruptor zu werden?

Lösungsansätze dazu gab es bei einem Roundtable zu dem Akima Media eingeladen hatte. Zu den vielfältigen Aspekten gab es interessante Vorträge von Sprechern der Unternehmen Cloudera, NetApp, Strategy und Rubrik.

Vom Problem zur Lösung

Die Kernfrage, die sich die allermeisten Unternehmen stellen lautet: Wie komme ich von der Datenflut zur Datenintelligenz. Daten sind schließlich das neue Gold, so das gängige Credo.

Daten produzieren wir in Unmengen, leider zumeist in Silos. Zudem sind die meisten davon unstrukturiert und damit kaum verwertbar. Das nächste Problem ist das der Orchestrierung und Verwaltung der Daten.

Hinzu kommen die Multi-Cloud-Umgebungen, die das Ganze zusätzlich erschweren. Letztendlich stellt sich die Frage der Nutzbarkeit der vorhandenen Daten. Schön, dass es jetzt die KI gibt. Aber wie können Unternehmen sie am effektivsten nutzen und welche Risiken gibt es?

Der Wandel der klassischen Datenanalyse vollzieht sich rasant. Datenintelligenz ist die nächste Evolution in der Datenanalyse.

Das Thema der Datenintelligenz ist grundsätzlich schön segmentierbar und lässt sich von den verschiedensten Perspektiven aus beleuchten. Nachfolgend stellen wir die unterschiedlichen Perspektiven dar und fügen sie zu einem Gesamtbild zusammen.

Blickwinkel 1 – die Sicht von Cloudera als Experte für hybride Datenplattformen, Analytik und KI.

Ausgangspunkt ist die Frage, welche Herausforderungen Unternehmen heute antreiben: Wie können Unternehmen effizienter werden, Kosten einsparen und mit den vielen neuen Paradigmen umgehen?

Welche Chancen ergeben sich daraus – und welche Maßnahmen müssen Unternehmen ergreifen?

Wichtig ist zu verstehen, dass es um den Aspekt der Datennutzung als Fundament für Unternehmensstabilität geht. Wie lassen sich Daten im eigenen Unternehmen zielgerichtet und gewinnbringend einsetzen, um den größtmöglichen Nutzen für das Unternehmen zu erzielen?

Ein zentraler Aspekt ist dabei das Thema Hybrid- und MultiCloud. Viele Unternehmen haben über die letzten Jahre oder gar schon Jahrzehnte das Thema „Cloud first” verfolgt. Sämtliche Prozesse sollen primär über eine Cloud-Infrastruktur abgewickelt werden. Dies ist per se keine schlechte Strategie, denn: Cloud-Umgebungen gelten als dynamisch und zugleich skalierbar. Außerdem bieten sie in der Regel transparente Kostenmodelle, häufig inklusive Compliance-Funktionen.

Gleichzeitig sind mit der Cloud-Nutzung natürlich auch verschiedene Risiken verbunden. Aktuell drehen sich die besonders um Zölle, Gegenzölle und eventuelle Besteuerung digitaler Dienstleistungen. Haben Unternehmen dadurch ein Ausfallrisiko? Haben sie dadurch ein monetäres Risiko? Wie lassen sich diese bewerten?

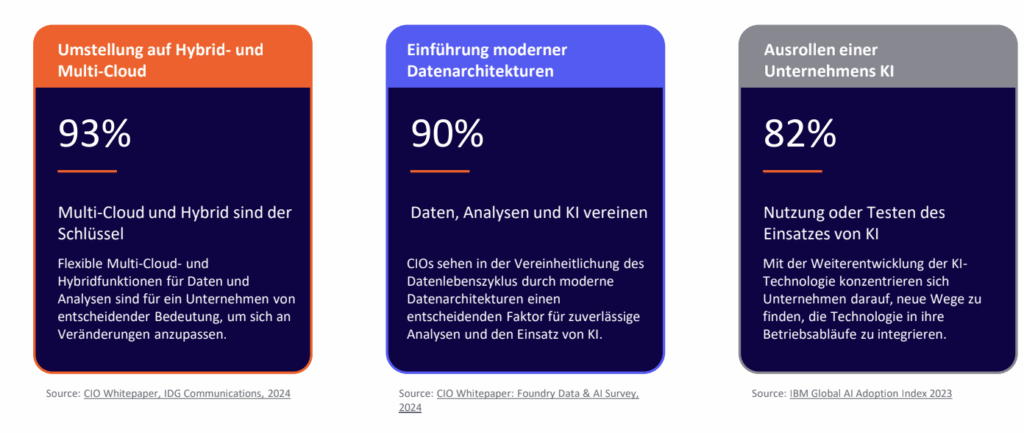

Die abgebildete Grafik zeigt, dass 93% der Unternehmen sich aktiv mit der Frage beschäftigen, wie sich eine MultiCloud-Strategie oder eine Hybrid-Cloud-Strategie umsetzten lassen. Ist ein Wechsel zwischen Cloud-Providern möglich? — und wenn ja, wie? Welche Voraussetzungen gelten für den Übergang in eine souveräne Cloud? Und wie könnte der Wechsel in eine Private Cloud-Infrastruktur funktionieren?

Cloud Preferred

Jede Medaille hat zwei Seiten. Zwar lassen sich Anwendungen und Daten grundsätzlich in die Cloud migrieren, doch stellt sich die Frage, ob dies in jedem Szenario tatsächlich sinnvoll ist. Wie viel Flexibilität bietet eine Hybrid-Cloud-Architektur? Und wie sieht es in puncto Kosteneffizienz aus?

Bei einer Infrastrukturauslastung von über 50% sollte geprüft werden, ob „Cloud first”, also ein vollständiger Betrieb über die Cloud, wirtschaftlich tatsächlich sinnvoll ist. Gegebenenfalls ist eine Kombination aus Cloud und On-Premises die bessere Option.

Jeder Anwendungsfall erfordert eine individuelle Bewertung. Die Anforderungen unterscheiden sich je nach Branche, Unternehmensgröße oder technologischem Reifegrad. Eine differenzierte Analyse erhöht die Entscheidungsqualität — auch wenn sie komplexer ausfällt.

Datenarchitektur

Ein zweiter zentraler Punkt betrifft die Einführung moderner Datenarchitekturen. Viele Unternehmen haben erkannt, dass bestehende Strukturen nicht mehr ausreichen. Insbesondere im Hinblick auf Skalierbarkeit, Effizienz und Interoperabilität müssen sie nachbessern, wodurch Data Mesh zunehmend an Bedeutung gewinnt.

Ein serviceorientierter Aufbau trägt dazu bei, Daten über Silos hinweg nutzbar zu machen. Genau mit diesem Ansatz beschäftigen sich aktuell rund 90% der Unternehmen.

Auch hier steht die Kosteneffizienz im Fokus, wie etwa die Vermeidung redundanter Daten. Die Umsetzung zeigt sich in der Praxis so: Insbesondere in der Automobil- und Fertigungsindustrie werden Daten häufig mehrfach kopiert, weil verschiedene Abteilungen dieselben Informationen benötigen, statt sie zentral bereitzustellen. Moderne Architekturen und Datenmodelle reduzieren diese Redundanzen deutlich.

Parallel dazu setzen sich derzeit 82% der Unternehmen mit der Einführung oder dem Testen von KI-Systemen auseinander.

Was nach einem zunächst hohen Prozentsatz aussieht, ist in der Realität besorgniserregend. Denn diese Zahl sollte höher liegen – idealerweise bei 100% der Unternehmen. KI ist einer der größten Effizienzgewinner, den Unternehmen haben können. Praktisch jeder nutzt heute KI bereits in irgendeiner Form. Wird diese Technologie den Mitarbeitern im Unternehmenskontext nicht zur Verfügung gestellt, greifen viele dennoch darauf zurück. Und dann stellt sich die Frage, was passiert mit den Daten, die die Mitarbeiter in dieses System unkontrolliert einfüttern. Das ist eines der Themen, die jedes Unternehmen beim Thema KI und Daten beschäftigen sollten. Denn das birgt erhebliche Risiken für die Datensicherheit. Sobald Mitarbeiter sensible Daten in nicht autorisierte Systeme einspeisen, entsteht ein potenziell kritisches Sicherheitsproblem. KI als Interface für Unternehmensdaten braucht deshalb klar definierte Richtlinien und eine kontrollierte Infrastruktur.

Ein Blick auf konkrete Beispiele – etwa bei SpaceX – zeigt, wie schnell sich Datenlandschaften verselbstständigen können: In der Vergangenheit wurden Daten dort ohne zentrale Strategie abgelegt. Mitarbeiter nutzten schnell und einfach die ihnen bekannten Plattformen, wie etwa Dropbox. Im Kontext von KI erfolgt ein solcher Kontrollverlust noch deutlich schneller. Das unkontrollierte Abwandern von Unternehmensdaten zählt zu den dringlichsten Herausforderungen der Gegenwart.

Besser machen

Wie sollte ein zukunftsfähiges System zur Datenverarbeitung und KI-Nutzung aussehen? Zunächst stellt sich die Frage, wie ein belastbares Datenfundament bereitgestellt werden kann. Ein KI-System liefert immer nur dann verlässliche Ergebnisse, wenn die zugrundeliegenden Daten hochwertig, aktuell und konsistent sind. Der erste und zugleich wichtigste Schritt besteht darin, diese Datenstruktur vollständig in bestehende Prozesse und Systeme zu integrieren.

Ein Blick auf den EU-Data Act zeigt, die regulatorischen Rahmenbedingungen unterliegen einem ständigen Wandel. Das heißt, es kann vorkommen, dass Daten plötzlich nicht mehr in einer Public Cloud gespeichert werden dürfen, sondern lokal oder in privaten Infrastrukturen verwaltet werden müssen. Aktuell fehlt es häufig an zentralen Instanzen, die diese Entwicklungen proaktiv weiterdenken und entsprechende Architekturen vorausschauend anpassen.

Qualität und Herkunft der Daten

Ein weiteres zentrales Thema: die Qualität und Herkunft der Daten innerhalb von KI-Systemen. Werden Daten aus öffentlichen Quellen herangezogen, besteht die Gefahr, dass sie aus veralteten oder duplizierten Umgebungen stammen, was sich unmittelbar negativ auf die Ergebnisqualität auswirkt.

Für den operativen Einsatz bedeutet das, dass es in bestimmten Fällen besser sein kann, auf spezielle Datensätze ganz zu verzichten, als auf veraltete oder verfälschte Informationen zuzugreifen. Das ist ein wichtiges und oft unterschätztes Thema. Entscheidend ist auch die Frage, wie ein solches Datenfundament genutzt werden sollte. Der Fokus sollte stets auf dem Mehrwert für die Mitarbeiter liegen — orientiert an konkreten Use Cases, die Effizienz und Qualität im Arbeitsalltag erhöhen.

Ein positives Praxisbeispiel eines Unternehmens aus der Fertigungsbranche: Dort wurde die Entwicklungsarbeit durch den Einsatz eines KI-Agenten im Bereich Coding optimiert und effizienter gestaltet. Rund 20% der Entwicklerkapazität konnten durch diese Maßnahme freigesetzt werden. Genau solche Use Cases zeigen, welches Potenzial datenbasierte KI-Lösungen haben — wenn sie richtig implementiert werden.

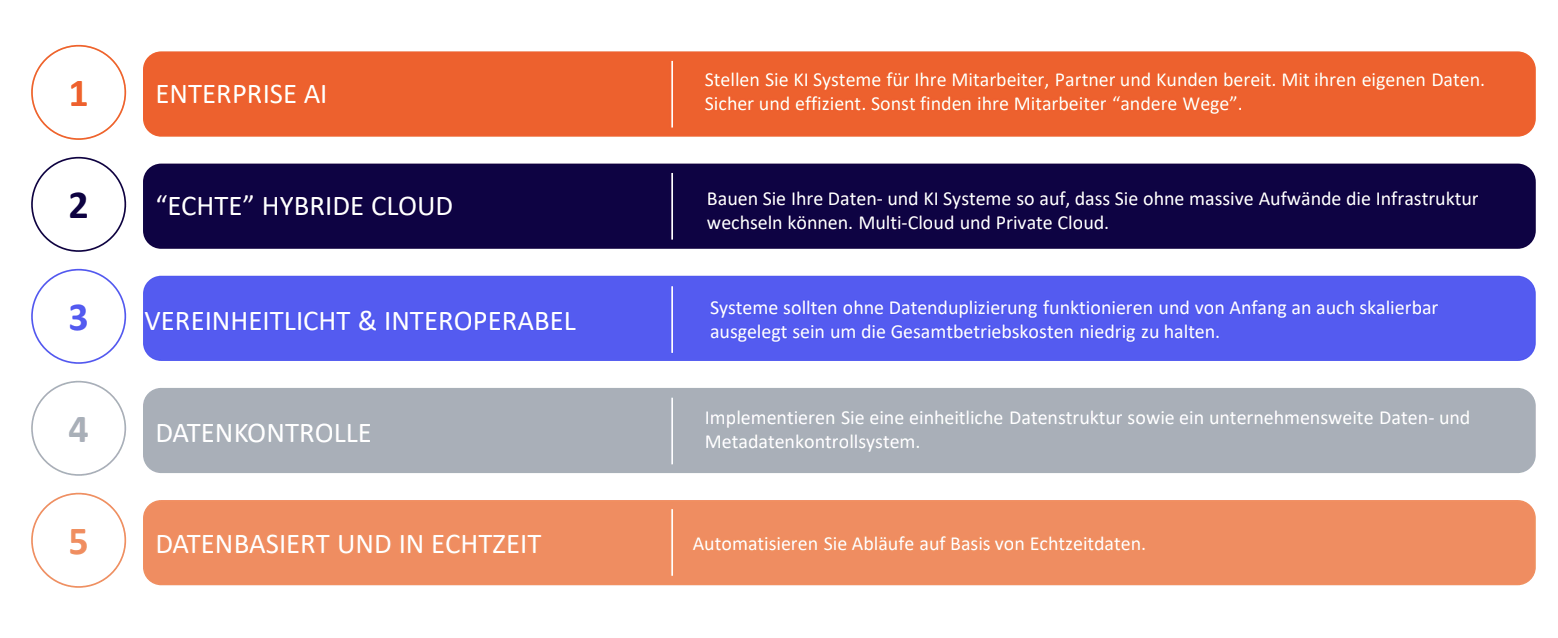

Fünf Merkmale für eine zukunftsfähige Datenstrategie

Folgende Eigenschaften sind essenziell für eine moderne und nachhaltige Datenstrategie in Unternehmen:

Das Bereitstellen einer Enterprise-KI

Unternehmen sollten sicherstellen, dass alle relevanten Daten über klar definierte APIs je nach eingesetztem KI-System und Anwendungsfelde zur Verfügung stehen. Dabei spielt es keine Rolle, ob diese für Partner, Mitarbeiter oder Kunden bereitgestellt werden. Entscheidend ist, die Datenhoheit zu behalten, Sicherheitsstandards einzuhalten und genau zu definieren, welche Daten für das System zugänglich sind.

Der Aufbau einer echten Hybrid Cloud

Daten müssen flexibel über verschiedene Infrastrukturen hinweg bereitgestellt werden können — ohne aufwändige Migrationsprojekte. Gerade in Zeiten politischer Unsicherheiten und dynamischer Marktbedingungen ist Agilität bei Infrastrukturentscheidungen von zentraler Bedeutung.

Die Nutzung von Open Source

Einheitlichkeit und Interoperabilität stehen im Zentrum jeder erfolgreichen Datenstrategie. Die Empfehlung lautet, zumindest die technologische Basis auf Open-Source-Komponenten aufzubauen. So bleibt die Kontrolle über eingesetzte Technologien gewährleistet — unabhängig von einzelnen Herstellern oder proprietären Abhängigkeiten. Wer heute keine Standards setzt, läuft Gefahr, morgen vor schwer kalkulierbaren Herausforderungen zu stehen.

Die Datenkontrolle

Eine zentrale Kontrolle der Daten ist Voraussetzung für deren unternehmensweite Nutzung. Solange Daten in abgeschotteten Silos verbleiben, bleibt ihr Potenzial ungenutzt. Ohne Zugriff und Steuerung ist auch keine Verteilung oder Skalierung der Daten möglich.

Die verschiedenen Geschäftsmodelle mit ihren unterschiedlichen Ansprüchen

Jede Branche hat andere Anforderungen an Datenverfügbarkeit — insbesondere in Echtzeitszenarien. Ein Möbelhaus etwa stellt andere Anforderungen an Reaktionsgeschwindigkeit als ein Logistikunternehmen. Auch Kundenerwartungen entwickeln sich zunehmend in Richtung Echtzeit-Services. Deshalb muss sich auch die Datenstrategie daran orientieren.

Blickwinkel 2 – die Sicht von NetApp auf das Thema als Experte für intelligente Dateninfrastruktur

Die nächste Perspektive richtet sich auf das Thema Intelligente Dateninfrastruktur. KI ist in aller Munde und längst mehr als nur ein Hype. Für die meisten Unternehmen stellt sich gar nicht mehr die Frage, ob KI eingesetzt werden soll, sondern vielmehr wann (bei welchem Arbeitsschritt oder Prozess) und wie (auf welche Weise konkret).

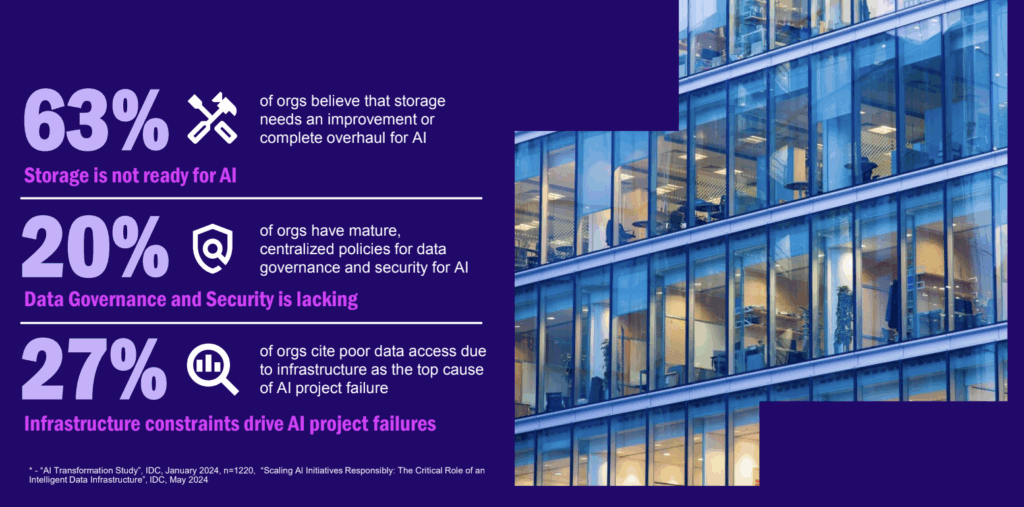

Zu beobachten ist ein klarer Trend von experimentellen Ansätzen mit KI hin zur Enterprise-KI. Dabei geht es nicht mehr nur um große Sprachmodelle oder universelle Forschungsanwendungen, sondern zunehmend um die gezielte Verknüpfung von KI mit unternehmensspezifischen Daten. Gerade hier zeigen sich aktuell die größten Herausforderungen. Sogar 63 Prozent der Unternehmen geben an, dass ihre Storage-Infrastrukturen noch nicht bereit für den produktiven KI-Einsatz sind.

Kleine Anekdote am Rande: Laut neuesten Gartner-Untersuchungen werden bis 2027 Unternehmen voraussichtlich dreimal häufiger spezialisierte, auf konkrete Aufgaben zugeschnittene KI-Modelle einsetzen als generische Sprachmodelle. Diese Entwicklung unterstreicht: Nichts ist beständiger als der Wandel.

Der große Unterschied im heutigen KI-Einsatz liegt in der enormen Beschleunigung der Datenmengen. Unternehmen sehen sich mit einer exponentiell wachsenden Datenflut konfrontiert, die klassifiziert, organisiert und verarbeitet werden muss. Diese Dynamik macht deutlich: Die bestehende Dateninfrastruktur genügt meist nicht mehr den Anforderungen moderner KI-Systeme. Ein grundlegendes Umdenken sowie die Erneuerung der technologischen Basis sind daher unumgänglich, um skalierbare, sichere und effiziente KI-Prozesse zu realisieren.

Woran scheitern KI-Projekte?

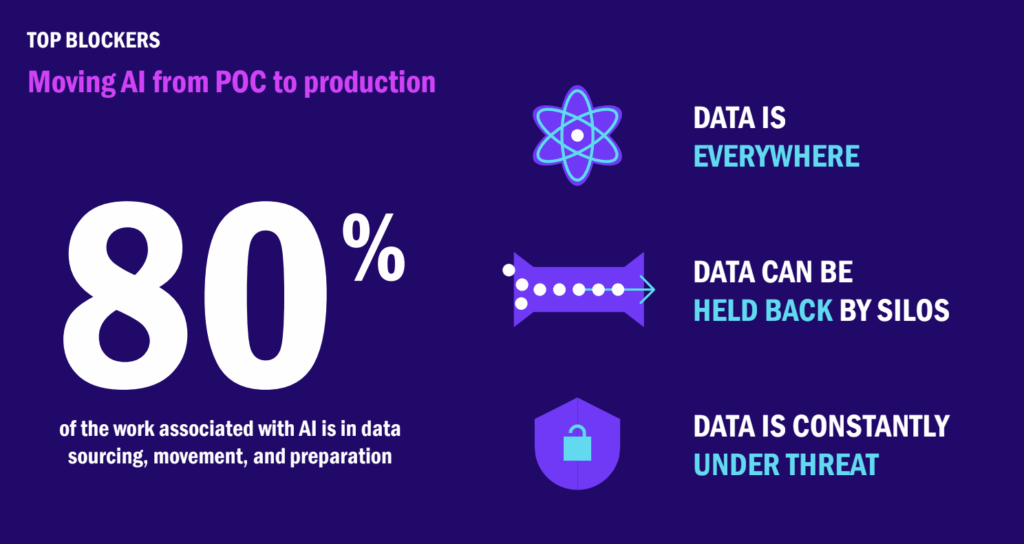

Bei der Betrachtung gescheiterter KI-Initiativen zeigt sich ein wiederkehrendes Muster: Der Zugang zu Daten sowie das übergreifende Datenmanagement gelten als die zentralen Hindernisse für den Erfolg. Diese Herausforderungen bilden häufig die Hauptursache dafür, dass KI-Projekte nicht wie geplant umgesetzt oder produktiv betrieben werden können.

Ein Blick auf die Verteilung des Aufwands innerhalb typischer KI-Projekte verdeutlicht das Problem: 80% des Zeitaufwandes an KI-Projekten entfällt auf Datenthemen. Darunter fallen Themen, wie überhaupt an Daten zu kommen, diese zu klassifizieren, zu managen und gegebenenfalls zu verschieben. Nur etwa 20% der Zeit bleibt für das eigentliche Trainieren von Modellen oder das Entwickeln von Algorithmen durch Data Scientists.

Zwei Hauptursachen lassen sich für diese Unverhältnismäßigkeit identifizieren:

Erstens: Daten sind inzwischen über eine Vielzahl von Quellen und Abteilungen verteilt. Innerhalb eines Unternehmens existieren häufig unterschiedliche Teams mit jeweils eigener Verantwortung für bestimmte Datenbestände. Der unternehmensweite Austausch gestaltet sich dadurch komplex und es entstehen sogenannte Datensilos.

Zweitens: Die Infrastruktur für KI-Projekte wird oft auf Applikationsebene aufgebaut. Nicht selten initiiert eine Fachabteilung mit eigenem Budget und Mandat ein Projekt, woraufhin eine punktuelle Infrastruktur speziell für diese Anwendung entsteht. Ein unternehmensweiter Architekturansatz bleibt dabei häufig außen vor, was langfristig zu redundanten Strukturen und begrenzter Skalierbarkeit führt.

Die Folge: Einzelprojekte stoßen an technische und organisatorische Grenzen, bevor das volle Potenzial von KI überhaupt entfaltet werden kann.

Shadow IT feiert ein Revival

Bekannt ist das unter dem Begriff „Shadow IT”, ein Déjà-vu mit Folgen. In vielen Unternehmen entstehen erneut Datensilos, die eine konsistente, unternehmensweite Nutzung und den Datenaustausch erheblich erschweren.

Eng damit verknüpft ist das Thema Datensicherheit. Insbesondere im Kontext von KI-Anwendungen stellt sich die Frage, wie der verantwortungsvolle Umgang mit großen Datenmengen gewährleistet werden kann — besonders wenn sensible oder personenbezogene Informationen betroffen sind.

Intellectual Property zählt heute zu den strategisch wichtigsten Werten eines Unternehmens und sollte unter keinen Umständen ungewollt nach außen dringen. Ein besonders kritisches Beispiel verdeutlicht das Risiko: Wird etwa ein KI-gestützter Marketing-Chatbot entwickelt, besteht bei unzureichender Zugriffskontrolle das Risiko, dass dieser ungewollt auf vertrauliche Informationen wie Gehaltsdaten zugreift.

Solche Szenarien zeigen: Ohne eine robuste Datenarchitektur und klare Governance-Richtlinien entstehen nicht nur neue technische Schulden — sondern auch massive Sicherheitslücken.

Lösungsvorschlag

Wie lässt sich der Übergang von Pilotprojekten zu produktiven KI-Anwendungen erfolgreich gestalten? Um Proof-of-Concepts (POCs) nachhaltig in den produktiven Betrieb zu überführen, ist eine integrierte, intelligente Dateninfrastruktur erforderlich.

Dabei handelt es sich nicht um ein einzelnes Produkt, das sich einmalig implementieren lässt und so das Problem löst. Vielmehr steht ein übergreifendes Konzept im Vordergrund: Eine silofreie, skalierbare Datenarchitektur, die eine konsistente Datenverfügbarkeit über alle relevanten Systeme hinweg gewährleistet. Die Umsetzung dieser Infrastruktur ist flexibel: Ob On-Premises, in der Public Cloud oder, wie in der Praxis meist der Fall, in einer hybriden Umgebung. Entscheidend ist die nahtlose Integration und die Fähigkeit, Daten über Systemgrenzen hinweg kontrolliert und sicher zu nutzen. Nur so lassen sich KI-Initiativen skalieren und zuverlässig in den laufenden Geschäftsbetrieb integrieren.

Definition: „intelligente und integrierte” Dateninfrastrukturen

Was versteht man konkret unter intelligenten und integrierten Dateninfrastrukturen? Im Kern bedeutet das, dass der Anspruch besteht, Silos zu vermeiden und eine durchgängige Nutzbarkeit von Informationen sicherzustellen. Gleichzeitig sollte die eingesetzte Infrastruktur, insbesondere der verwendete Storage, nahtlos mit anderen Systemen kombiniert sein – etwa durch eine Zertifizierung für NVIDIA-GPUs. Wird in leistungsstarke GPU-basierte Rechenleistung investiert, darf der Datenzugriff nicht zum Engpass im Gesamtprozess werden.

Darüber hinaus spielt die Integration mit MLOps-Tools eine zentrale Rolle. Machine Learning Operations (MLOps) beschreibt Technologien, die den gesamten Lebenszyklus von KI-Anwendungen. Ziel ist es, skalierbare Prozesse zu etablieren, die Data Scientists tatsächlich in ihrer täglichen Arbeit unterstützen und es ihnen ermöglichen, über vertraute Werkzeuge direkt auf die Speicherlösungen zuzugreifen – ohne zusätzliche Spezialkenntnisse.

Bei Skalierbarkeit wird oft nur an Performance und Durchsatz gedacht, umfasst aber eigentlich deutlich mehr. Effizienzsteigerung und Produktivitätsgewinn zählen ebenso dazu. Gerade im Umfeld von Data Science entstehen Potenziale, wenn Fachkräfte mit den richtigen Tools und einem reibungslosen Datenzugriff arbeiten können.

Last but not least gehören Vertrauen und Security untrennbar zur Definition einer intelligenten Infrastruktur. Data Scientists benötigen umfassende Datenzugriffe, gleichzeitig aber oft nicht die Experten in Bereichen wie Governance oder Security. Deshalb ist es essenziell, Daten zu klassifizieren, zu bewerten und über verschiedene Umgebungen hinweg verwalten zu können – egal ob lokal gespeichert oder in Cloud-Umgebungen ausgelagert.

Data Movement

Mehr als 90 % der KI-Projekte starten heute in der Cloud. Das hat ganz einfache Gründe, nämlich die initiale Kostenvorteile und die Möglichkeit, ohne großen Infrastrukturaufbau schnell zu starten. Damit verbunden ist jedoch die Herausforderung, Daten zuverlässig in die Cloud zu übertragen, dort mit nativen Services — etwa von Hyperscalern – zu kombinieren und bei Bedarf wieder zurückzuführen.

Insbesondere Sicherheitsaspekte oder langfristige Kostenüberlegungen führen häufig zu einem sogenannten Cloud-Exit oder zumindest zu einer Hybrid-Strategie. In diesen Fällen muss die Datenmigration in beide Richtungen möglich sein – reibungslos, performant und regelkonform. Zentrale Anforderungen an das sogenannte Data Movement sind deshalb, das Beibehalten von Klassifizierungen, Zugriffsrechten und weitere Governance-Vorgaben. Nur wenn diese Aspekte durchgängig berücksichtigt werden, lässt sich eine unternehmensweite, regelkonforme und effiziente Datenstrategie realisieren.

Zusammengefasst: Erfolgreiche KI-Projekte setzen eine intelligente, integrierte, skalierbare und sichere Dateninfrastruktur voraus – unabhängig davon, ob sie On-Premises, in der Cloud oder in hybriden Infrastrukturen betrieben wird.

Blickwinkel 3 – die Sicht von Strategy auf das Thema als Experte für KI- und BI-Lösungen

Die dritte Perspektive beschäftigt sich mit dem KI-Einsatz bei der Datenanalyse. Das Ziel ist, aus Rohdaten echten geschäftlichen Mehrwert zu generieren. Im Fokus stehen dabei innovative Dashboards und zukunftsweisende Analyseansätze.

These „Business Intelligence ist eigentlich eine Komödie”

In nahezu jedem Unternehmen wird mit Dashboards gearbeitet. Die Herausforderung besteht darin, die nächste Evolutionsstufe zu erreichen. Eishockey-Ikone Wayne Gretzky brachte es auf den Punkt: „Ein guter Spieler spielt, wo der Puck ist. Ein großartiger Spieler spielt, wo der Puck sein wird.” Übertragen auf die Datenwelt bedeutet das: Wer den Markt von morgen verstehen und gestalten will, benötigt antizipative Analysefähigkeiten – schneller Daten verstehen, schneller interpretieren, schneller Entscheidungen treffen.

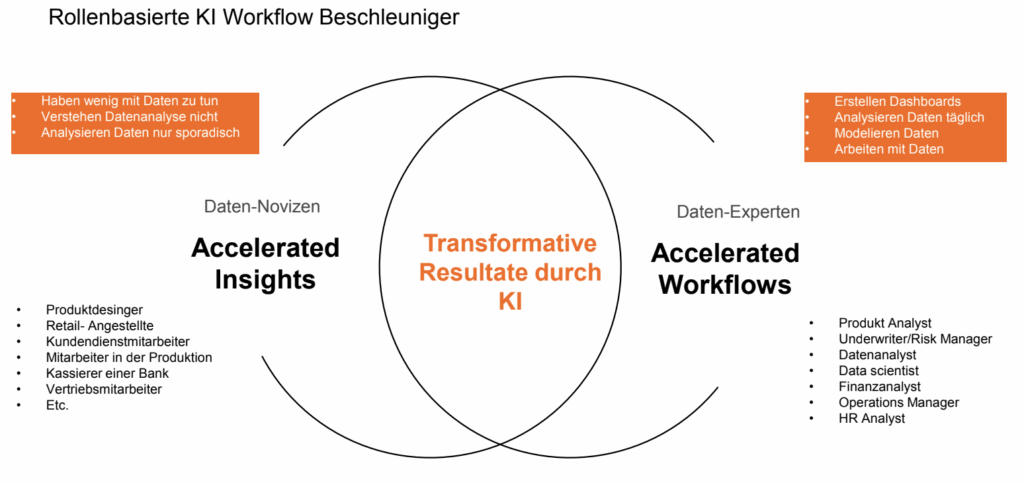

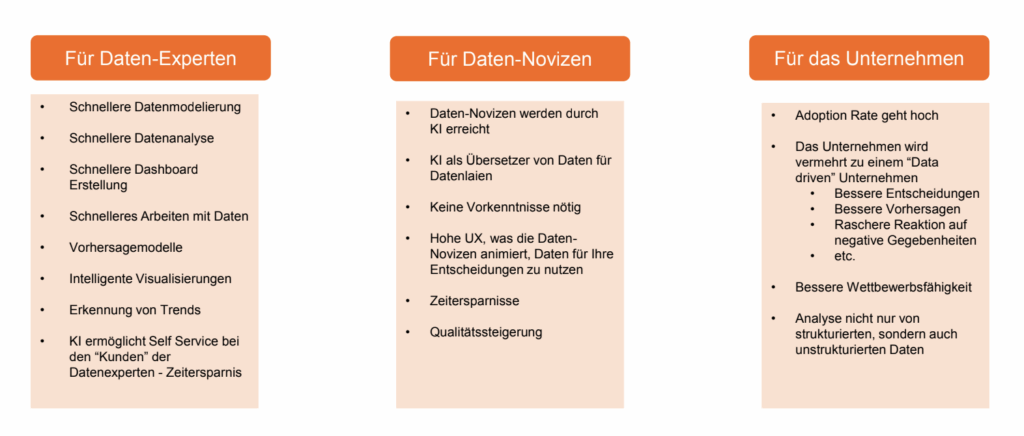

In der Praxis lassen sich zwei Nutzergruppen in der Datenanalyse unterscheiden:

- Datenexperten, die sich täglich mit großen Datenmengen befassen. Sie verstehen die Strukturen, erstellen und pflegen Datenmodelle und versorgen andere Bereiche mit aufbereiteten Informationen.

- Datennovizen, also Anwender mit wenig technischer Erfahrung, jedoch großer Motivation und Interesse daran, Daten für Entscheidungsprozesse zu nutzen.

Beide Gruppen verfolgen das gleiche Ziel datengetriebener Entscheidungsfindung. Doch ihre Anforderungen, Werkzeuge und Kompetenzen unterscheiden sich deutlich. Moderne Business-Intelligence- und KI-Plattformen müssen daher intuitiv bedienbar, kollaborativ einsetzbar und leistungsfähig zugleich sein — eine Brücke zwischen Self-Service und Professional Analytics.

KI für Datennovizen: Datenkompetenz auch ohne Vorkenntnisse

Viele Unternehmen formulieren ambitionierte Ziele und wollen datengetrieben arbeiten. Doch die Realität sieht oft anders aus. Zwar stehen große Datenmengen bereit — aber nicht jeder Mitarbeiter kann damit wirklich etwas anfangen. Genau hier liegt der Schlüssel zur Demokratisierung von Daten: Künstliche Intelligenz eröffnet Datennovizen erstmals echten Zugang zu datenbasierten Erkenntnissen — ganz ohne IT-Vorkenntnisse und ohne technische Barrieren.

Datennovizen stehen typischerweise vor einer Herausforderung in diese Richtung:

Sie sehen Zahlen, aber verstehen den Kontext nicht. Sie möchten Trends erkennen, wissen aber nicht, wie sie Dashboards lesen oder Reports selbst erstellen sollen. KI-basierte Assistenten verändern das grundlegend. Statt sich durch Tabellen zu kämpfen, können Nutzer einfache konkrete Fragen stellen, wie:

„Warum ist der Umsatz in Region Nord im März eingebrochen?”

„Welche Produkte haben die höchsten Retourenquoten im Online-Shop?”

„Wie war die Performance meines Teams im Vergleich zur Vorwoche?”

Die Antwort versteckt sich dann nicht mehr in unübersichtlichen Tabellen, sondern kommt vom KI-Assistenten zeitnah in einfacher natürlicher Sprache und auf den Punkt genau. Moderne KI-Tools gehen von der Nachfrage sogar noch einen Schritt weiter zum Vorausdenken. Das bedeutet, sie warten nicht, bis gefragt wird, sondern liefern proaktiv Empfehlungen. Zum Beispiel:

„Achtung: Die Nachfrage nach Produkt XY steigt deutlich — Lagerbestand prüfen.”

„In Filiale B sinkt die Kundenzufriedenheit – bitte prüfen Sie den Serviceprozess.”

„Diese Kundengruppe zeigt Kündigungstendenzen – starten Sie eine Rückgewinnungskampagne.”

So werden Mitarbeiter ohne Data-Science-Know-how in die Lage versetzt, vorausschauend und nicht rein reaktiv zu handeln.

User Experience: Wenn Datenarbeit zur Selbstverständlichkeit wird

Angenommen, die Antwort auf eine Kundenanfrage im Supermarkt lautet: „Wir haben aktuell leider keinen Bestand” – oder: „Ein Exemplar ist verfügbar, , bitte gehen Sie ruhig weiter einkaufen, während es nachgefüllt wird.” Dieses Maß an Serviceorientierung beschreibt im übertragenen Sinne die Erwartungshaltung an moderne Datenumgebungen – benutzerzentriert, effizient und unmittelbar zugänglich.

Insbesondere Anwender ohne tiefgehende Datenkenntnisse benötigen Systeme, die verständlich und intuitiv funktionieren. Genau an dieser Stelle greift die Stärke von Künstlicher Intelligenz: Datenarbeit muss so einfach sein wie eine natürliche Frage – und die Antwort muss ebenso klar und kontextbezogen erfolgen.

Sobald Daten barrierefrei zugänglich sind, profitiert das gesamte Unternehmen. Analyseprozesse beschleunigen sich, Entscheidungswege verkürzen sich, und die Reaktionsfähigkeit auf Veränderungen im Marktumfeld steigt deutlich. Wettbewerbsvorteile entstehen nicht mehr ausschließlich durch Technologie, sondern durch deren nutzungsfreundliche und effektive Anwendung im Alltag.

Effizient eingesetzte KI-gestützte Datenanalysen führen zu einer messbaren Verbesserung der Vorhersagegenauigkeit, Prozesssteuerung und strategischen Planung. Trotz dieser Fortschritte bleibt die Branche noch entfernt vom sogenannten Plateau der Produktivität – der Reifephase, in der intelligente Systeme flächendeckend im operativen Alltag angekommen sind.

Garbage in – Garbage out: Risiken durch Datenmängel

Neben zahlreichen Herausforderungen bergen KI-Projekte vor allem ein zentrales Risiko: mangelhafte Datenqualität. Viele Unternehmen kämpfen weiterhin mit der grundlegenden Aufbereitung und Strukturierung ihrer Daten. Wer schlechte Daten analysiert – ob mit KI oder händisch –, erhält zwangsläufig unbrauchbare Ergebnisse. Für Datenexpertinnen und -experten fällt dieses Risiko geringer aus. Zwar bleibt es bestehen, doch Fachkenntnis sorgt für die notwendige Kontrolle. Sie erkennen fehlerhafte oder auffällige Datensätze schneller, prüfen Ergebnisse und können Zusammenhänge validieren.

Ein deutlich größeres Risiko besteht für weniger versierte Anwendergruppen. Unstrukturierte Daten, also Texte, Bilder oder Audioformate, sind für sie schwer zu bewerten. Während Fachleute differenzieren und hinterfragen, akzeptieren Datennovizen häufig die ausgegebenen Ergebnisse ungeprüft – mit potenziell gravierenden Folgen: falsche Entscheidungen, entgangene Chancen und ein schleichender Vertrauensverlust in die Systeme.

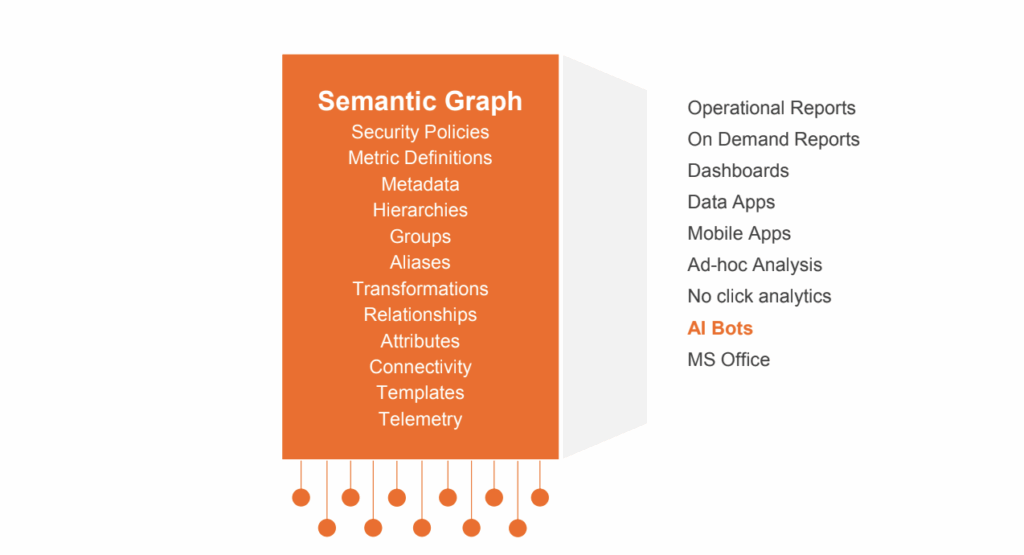

Einsatz semantischer Graphen

Auch das Thema Data Governance rückt verstärkt in den Fokus. Der Einsatz von KI im Business-Intelligence-Kontext erfordert klare Richtlinien in Bezug auf Sicherheit, Zugriffsrechte und Nachvollziehbarkeit. Eine wirksame Lösung bietet der Einsatz semantischer Graphen. Dabei werden Daten in kontextuelle Strukturen überführt, in denen Qualität, Zugänglichkeit und Governance zentral überwacht werden können. Greift die KI auf semantisch angereicherte Daten zu, steigt die Wahrscheinlichkeit qualitativ hochwertiger Ergebnisse signifikant – auch wenn der Idealzustand vielerorts noch nicht erreicht ist.

Fazit: Künstliche Intelligenz im Umfeld von Business Intelligence bietet ein enormes Potenzial – von Effizienzgewinnen über fundiertere Entscheidungen bis hin zu neuen Analysemöglichkeiten. Doch die Basis dafür bleibt eine saubere Datenlandschaft. Besonders im Hinblick auf Compliance wird das deutlich. Wer beispielsweise in einem HR-Dashboard ungefiltert auf Gehaltsdaten der Geschäftsführung zugreifen kann, überschreitet nicht nur ethische Grenzen, sondern verstößt gegen grundlegende Datenschutzprinzipien.

Ein solches Szenario erinnert an private Banker mit Zugriff auf Kontoinformationen, die sie nichts angehen – ein No-Go. Entscheidend ist deshalb, Informationsqualität, Governance und semantische Strukturen voranzutreiben. Erst dann wird KI zum echten Wettbewerbsvorteil.

Blickwinkel 4 – die Sicht von Rubrik auf das Thema unter dem Aspekt Cybersecurity

Die vierte Perspektive dreht sich um das Thema Cyber-Resilienz und wie Unternehmen die Datenqualität für GenAI-Projekte steigern können. Die Datenqualität ist der Aspekt, der sich wie ein roter Faden durch alle Blickwinkel zieht und laut aktuellem Allianz Risk Barometer stellt Cyber-Resilienz das derzeit größte Geschäftsrisiko dar. Es geht nicht mehr nur um Prävention, sondern vor allem um Reaktion: Wie lassen sich Schäden nach einem erfolgreichen Angriff kontrollieren und Systeme schnell wiederherstellen?

In der Diskussion um Künstliche Intelligenz wird deutlich, dass nahezu jedes Unternehmen derzeit entsprechende Projekte plant oder bereits umsetzt. Generative KI wird als strategisches Werkzeug betrachtet, das klare Wettbewerbsvorteile verspricht. Die Ziele dabei sind klar: Der CEO fokussiert sich auf weitere Effizienzsteigerung, während Innovations- und GenAI-Teams schnelle Erfolge anstreben. Hier dominieren agile Ansätze, kurze Entwicklungszyklen und ein beschleunigter Go-to-Market. Geschwindigkeit gilt als entscheidender Hebel im Wettbewerb.

Diese Dynamik bringt jedoch Risiken mit sich – insbesondere im Hinblick auf Cybersecurity und Datenintegrität. Nur wer Resilienz und Schutz der Dateninfrastruktur von Beginn an mitdenkt, kann generative KI verantwortungsvoll und sicher in den Produktivbetrieb überführen.

Hohe Abbruchquote bei GenAI-Projekten

Laut Gartner werden bis Ende des Jahres etwa 30% der Gen-AI-Projekte eingestellt. Der Hauptgrund auch hier wieder die mangelnde Datenqualität. Diese ergibt sich aus verschiedenen Quellen – sei es durch falsches Labeling, unzureichende Data Access Governance oder durch unzureichend definierte Zugriffsrechte. Häufig wird das Problem durch fehlende Fachkenntnis der Teams noch verschärft.

Die größten Engpässe treten auf, wenn Unternehmen sich nicht ausreichend Gedanken darüber machen, welche Daten wirklich für ihr Gen-AI-Projekt benötigt werden. Was ist das Ziel des Projekts? Warum wird es in erster Linie umgesetzt? Natürlich geht es um Effizienzsteigerung, aber in welchem Bereich und mit welchem konkreten Nutzen?

Sobald die relevanten Daten identifiziert sind, muss sichergestellt werden, dass die Zugriffsrechte gemäß der Data Access Governance ordnungsgemäß gepflegt werden. Dies verhindert, dass beispielsweise ein Azubi Zugang zu sensiblen Informationen erhält, wie etwa den Gehaltsdaten des Geschäftsführers. Ein weiterer wichtiger Schritt ist die Risikobewertung der Daten. Nur so lässt sich sicherstellen, dass sensible Inhalte aus den Antworten von KI-Systemen herausgefiltert werden.

KI-Infrastruktur

Der nächste Punkt beschäftigt sich mit der Verwaltung der Kosten der KI-Infrastruktur. Alles, was im Rahmen von KI-Projekten durchgeführt wird, benötigt Ressourcen.

Es gibt Unternehmen, die keinerlei Cloud-Services nutzen und stattdessen enorme Mengen an Grafikkarten kaufen. Das kostet eine erhebliche Summe, aber es stellt sicher, dass keine externen Cloud-Anbieter Zugriff auf die Daten erhalten. Dies betrifft insbesondere Finanzdienstleister, die aufgrund ihrer Branche ein berechtigtes Interesse an einer hohen Datensicherheit haben. Diese Vorgehensweise ist deren bevorzugter Weg, um Datensicherheit zu gewährleisten.

Jedoch ist auch dieser Ansatz teuer. Hinzu kommen die Experimente, das gesamte Prototyping und die Lösungen, die letztlich in der Praxis getestet und ständig überwacht werden müssen, um deren Plausibilität zu gewährleisten. Die entscheidende Frage dabei ist: Wie lässt sich dieser Prozess beschleunigen? Zudem stellt sich die Frage, was passiert, wenn eine GenAI-Anwendung von einem Cyberangriff betroffen ist. Ein Vorfall aus dem letzten Jahr zeigt auf, dass ein Trainingsmodell gehackt und mit fehlerhaften Daten gespeist wurde, was dazu führte, dass die GenAI später falsche Daten ausgab. Das stellt ein erhebliches Risiko dar.

Ein weiteres Beispiel: Wenn alle Daten in das GenAI-System eingespeist werden – seien es On-Premises-Daten, Cloud-Daten oder unstrukturierte Daten – wird lediglich nach dem sinnvollsten Input gesucht und dieser hochgeladen. Dies könnte jedoch dazu führen, dass alle Zukunftsrechte verloren gehen. Ohne Risikoanalyse erfolgt der Datenimport zwar schnell, jedoch ist er keineswegs sicher.

Daher muss eine gründliche Überprüfung erfolgen. Die Daten sollten aus einem zentralisierten Repository entnommen werden, welches die Sensibilität der Daten bewertet hat. Es ist entscheidend, dass die Zukunftsrechte überprüft und Risiken bewertet werden. Sensible Informationen wie Patente oder Geschäftsberichte dürfen auf keinen Fall nach oben in das System geladen werden.

Nun stellt sich die Frage: Was ist diese zentralisierte Plattform? Wo befinden sich alle Unternehmensdaten? In den meisten Fällen ist das Backup-System die zentrale Anlaufstelle. Auch wenn es simpel klingt, entspricht es oft der Realität.

Eine geniale Idee

Unternehmen verfügen über On-Premises-Daten, Cloud-Daten, SaaS-Lösungen und unstrukturierte Daten, die grundsätzlich zunächst einmal gesichert werden müssen. Wenn diese gesicherten Daten anschließend durch Sensitivity Data Suspension und Data Access Governance überprüft werden, kann ein Revealing-Modell darauf aufgesetzt und die Lösung definiert werden. Danach können die Daten in verschiedene Systeme integriert werden, wobei das System weiterhin geschlossen bleibt. Dies ist das grundlegende Konzept.

Die Idee dahinter ist genial, weil ein zentraler Standort geschaffen wird, an dem alle Daten analysiert wurden. Alles, was von diesem Punkt aus weitergegeben wird, ist vordefiniert. In diesem Szenario könnten keine Datenschutzprobleme auftreten, da die Daten gesichert und je nach Speicherform auch nach einem erfolgreichen Angriff wiederhergestellt werden können.

Datenreife von KI-Projekten

Apropos Daten: Das Beste kommt zum Schluss. Eine neue Gartner-Analyse beschäftigt sich exakt mit diesem Thema. Die Ergebnisse des Reports können in dem Artikel „So bewerten Sie die Datenreife von KI-Projekten” nachgelesen werden.

Der Weg zur Datenintelligenz

Die verschiedenen Perspektiven zeigen deutlich: Unternehmen stehen heute vor der Herausforderung, ihre exponentiell wachsenden Datenmengen in wertvolle Geschäftsintelligenz zu verwandeln. Dabei kristallisieren sich vier Schlüsselelemente heraus:

Erstens: Eine flexible Hybrid-Cloud-Strategie ist unerlässlich, um Daten intelligent zu verwalten und gleichzeitig souverän zu bleiben. Open-Source-Technologien bieten hier die notwendige Unabhängigkeit von einzelnen Anbietern.

Zweitens: Eine integrierte, silofreie Dateninfrastruktur bildet das Fundament für erfolgreiche KI-Projekte. Sie muss skalierbar, sicher und umgebungsübergreifend funktionieren.

Drittens: Der effektive Einsatz von KI in der Datenanalyse erschließt Mehrwerte für Experten wie für Datennovizen gleichermaßen – vorausgesetzt, die zugrundeliegende Qualität und -Governance sind gewährleistet.

Viertens: Cyber-Resilienz und Datensicherheit müssen von Anfang an mitgedacht werden, um KI-Projekte nachhaltig erfolgreich zu gestalten und Risiken zu minimieren.

Die Reise von der Datenflut zur Datenintelligenz erfordert einen ganzheitlichen Ansatz: Technologie allein reicht nicht aus – es braucht durchdachte Strategien, klare Governance und eine Kultur der Datenkompetenz. Unternehmen, die diese Aspekte erfolgreich integrieren, werden nicht nur effizienter arbeiten, sondern auch widerstandsfähiger gegenüber Marktveränderungen sein und sich Wettbewerbsvorteile sichern können.