Daten sind das Rückgrat moderner Unternehmen. Sie treiben Automatisierung, Steuerung und wichtige Entscheidungsprozesse voran. Doch bei schlechter Qualität verwandeln sie sich von einem wertvollen Asset in ein erhebliches Risiko. Warum mittelständische Unternehmen den Preis für schlechte Daten zahlen – und wie KI hilft erfahren Sie in diesem Artikel.

IBM schätzt die jährlichen Kosten durch schlechte Datenqualität allein in den USA auf rund 3,1 Billionen US-Dollar. Auf Ebene einzelner Unternehmen entstehen Schäden von durchschnittlich 12,9 bis 15 Millionen US-Dollar pro Jahr, in manchen Fällen sogar bis zu einem Viertel des gesamten Umsatzes. Die Dimensionen verdeutlichen: Schlechte Daten sind weit mehr als ein technisches Problem – sie bedrohen unmittelbar die Wettbewerbsfähigkeit.

Was schlechte Datenqualität bedeutet

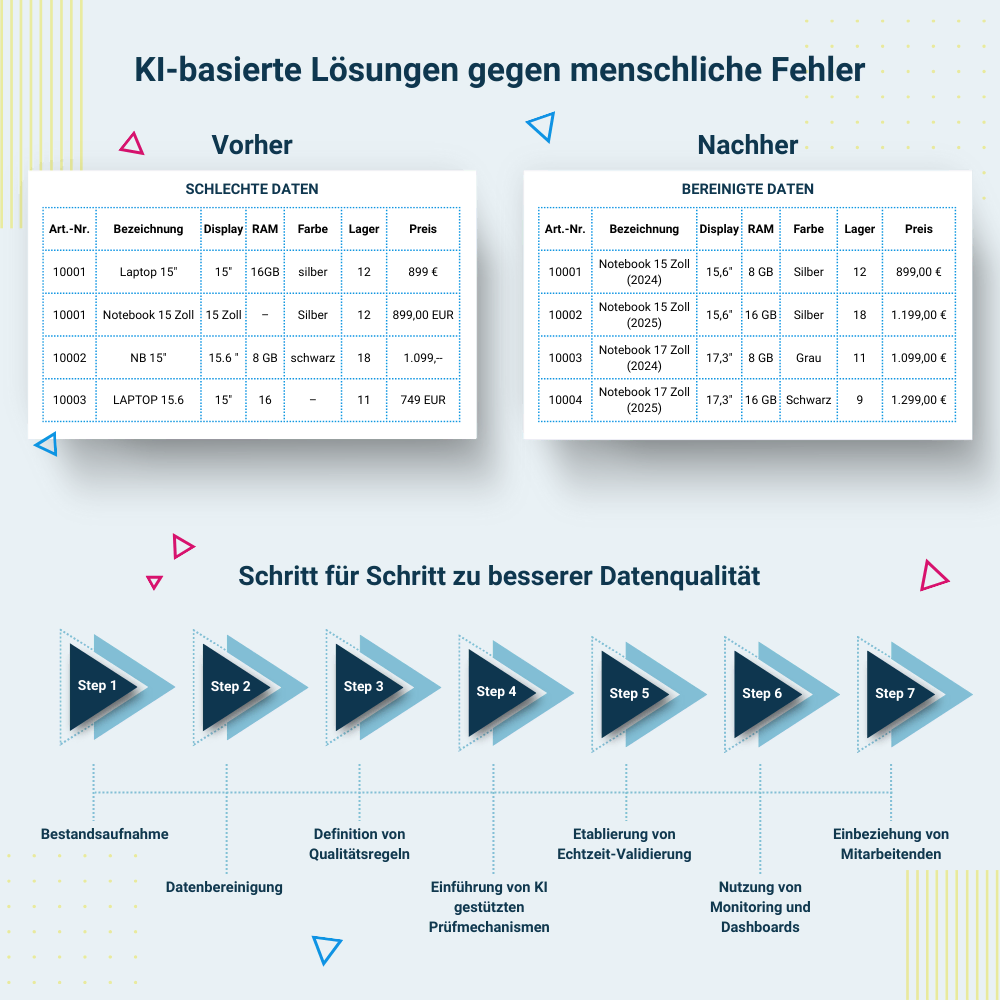

Im Alltag von Unternehmen begegnen uns immer wieder dieselben Muster. In der Produktdatenbank wird derselbe Artikel mehrfach angelegt: einmal als „Microsoft Notebook 15 Zoll“, einmal als „Laptop 15 Zoll Microsoft“. Für die Einkaufsabteilung handelt es sich um ein einziges Produkt, für das System sind es jedoch zwei verschiedene. Das führt dazu, dass Bestellmengen aufgesplittet werden, Rabatte nicht richtig berechnet werden und am Ende sogar falsche Lagerbestände ausgewiesen sind.

In der Finanzbuchhaltung fehlen Zahlungscodes oder Buchungen sind unvollständig, was zu aufwendigen Korrekturen am Monatsende führt. Ebenso kann eine fehlende

Angabe über die Zahlungsart – etwa Lastschrift oder Überweisung – dazu führen, dass Ausgangsrechnungen nicht gezahlt werden. Veraltete Einträge, falsche Formate oder unstrukturierte Datenbestände sind ebenso typische Beispiele. Oft summieren sich solche Kleinigkeiten unbemerkt zu einem schwerwiegenden Problem, das nicht nur Prozesse verlangsamt, sondern die gesamte Organisation belastet.

Definition: schlechte Datenqualität Fachlich wird schlechte Datenqualität meist anhand der Dimensionen Genauigkeit, Vollständigkeit, Konsistenz, Aktualität und Relevanz beschrieben. Sind diese Kriterien verletzt, entstehen operative Reibungen und strategische Fehlentscheidungen. |

Die Folgen fehlerhafter Daten

Die Folgen schlechter Daten sind vielschichtig. Zunächst entstehen hohe Kosten, weil Mitarbeitende wertvolle Zeit damit verbringen, fehlerhafte oder unvollständige

Datensätze zu suchen, zu prüfen oder zu korrigieren. Studien zufolge entfallen bis zu 25 Prozent der Arbeitszeit allein auf diese mühsame Bereinigung – und zusätzlich sinkt die Gutschriftsquote, weil beispielsweise nicht mehrere Rechnungen nachträglich korrigiert werden müssen, wenn Artikel gleich von Beginn an mit den richtigen Buchungsparametern eingerichtet sind.

Damit verbunden ist ein Verlust an Effizienz: Statt produktiv an der Weiterentwicklung des Unternehmens zu arbeiten, blockiert die Datenpflege enorme Ressourcen. Auch die Qualität von Managemententscheidungen leidet massiv, wenn Reports auf ungenauen oder inkonsistenten Informationen basieren. Prognosen, die auf schlechter Datenbasis erstellt werden, können Fehlinvestitionen nach sich ziehen.

Nicht zu unterschätzen ist zudem der Vertrauensverlust – sowohl intern als auch extern. Gleichzeitig können auch absatzfördernde Potenziale ungenutzt bleiben: Wenn fehlerhafte Daten beispielsweise nicht erkennen lassen, dass sich höhere Preise am Markt durchsetzen ließen, verschenken Unternehmen Umsatzchancen, ohne dass es ihnen bewusst ist.

Hinzu kommen Compliance-Risiken, etwa im Kontext der DSGVO, die durch ungenaue Kundendaten, fehlende Löschfristen oder nicht dokumentierte Einwilligungen noch verschärft werden.

Kann KI auch bestehende schlechte Daten verbessern?

Die zentrale Frage lautet: Kann Künstliche Intelligenz helfen, dieses Problem zu lösen? Die Antwort ist ein klares Ja – und zwar in zweierlei Hinsicht.

1. Präventiv: Systeme wie KI-Add-ons für ERP-Lösungen (z. B. Microsoft Dynamics 365 Business Central oder SAP S/4HANA) prüfen Eingaben der User in Echtzeit, erkennen Unstimmigkeiten und geben sofort eine entsprechende Rückmeldung. Anstatt Fehler im Nachhinein aufwendig zu korrigieren, werden sie gar nicht erst ins System übernommen.

2. Korrigierend: Mit Methoden wie Mustererkennung, Dublettenerkennung oder Anomalie-Detektion analysiert die KI vorhandene Daten, identifiziert Fehlerquellen und korrigiert sie. Forschungsergebnisse zeigen, dass KI-basierte Modelle eine sehr hohe Präzision bei der Erkennung und Korrektur fehlerhafter Daten erreichen können.

Ein Beispiel aus der Praxis: Ein mittelständischer Händler für technische Ersatzteile ließ historische Daten zu 250.000 Artikeln mit KI analysieren. Das System erkannte Dubletten, vereinheitlichte Maßeinheiten (z. B. „mm“ statt „Millimeter“) und löschte fehlerhafte Lagerbestände. Ergebnis: ein um 30 % effizienterer Einkauf und eine deutliche Reduktion von Überbeständen.

Schritt für Schritt zu besserer Datenqualität

1. Bestandsaufnahme

Klärung, welche Systeme und Datenquellen existieren, wo Schwachstellen liegen und welche Fehlerarten am häufigsten auftreten.

2. Datenbereinigung

Dubletten entfernen, Inkonsistenzen korrigieren, veraltete Datensätze archivieren.

3. Qualitätsregeln definieren

Festlegen, welche Felder Pflichtangaben enthalten, welche Formate verbindlich sind und wie mit Ausnahmen umzugehen ist.

4. KI-gestützte Prüfmechanismen einführen

Integration von Tools, die diese Regeln automatisch überwachen und Abweichungen in Echtzeit melden.

5. Echtzeit-Validierung etablieren

Fehler werden beim Erfassen verhindert, bevor sie in den Datenbestand gelangen.

6. Monitoring und Dashboards nutzen

Laufende Überwachung der Datenqualität über Key Performance Indicators (KPIs).

7. Mitarbeitende einbeziehen

Schulungen und Sensibilisierung, um Datenqualität als gemeinsame Verantwortung zu verankern. Das funktioniert erfahrungsgemäß am besten, wenn im Unternehmen Entscheidungen datengestützt getroffen werden. Im besten Fall handeln die Mitarbeitenden dann intrinsisch motiviert.

Chancen für den Mittelstand

Besonders für mittelständische Unternehmen ist dies ein entscheidender Punkt. Hier fehlt häufig die Zeit oder das Spezialwissen, um sich tief in komplexe ERP-Systeme einzuarbeiten. Gleichzeitig sind die Datenbestände oft gewachsen, ohne dass systematisch auf Qualität geachtet wurde.

KI kann in diesem Umfeld ein echter Gamechanger sein. Sie arbeitet im Hintergrund, wirkt wie ein digitales Coaching und steigert so Sicherheit und Akzeptanz. Wenn Mitarbeitende erleben, dass ein System ihnen hilft, anstatt sie zu behindern, nutzen sie es auch gerne. Das ist eine wichtige Voraussetzung für den Erfolg von ERPProjekten.

Für den Mittelstand besonders relevant: KI-basierte Datenqualitätslösungen lassen sich zunehmend modular und cloudbasiert einsetzen – ohne hohe

Anfangsinvestitionen. Das senkt die Einstiegshürden erheblich.

Datenqualität als Zukunftsvorteil

Darüber hinaus spielt die Datenqualität eine zentrale Rolle für die Zukunftsfähigkeit. Nur auf einer sauberen und konsistenten Datenbasis können moderne Anwendungen wie Predictive Analytics oder generative KI sinnvoll eingesetzt werden. Fehlende Qualität gefährdet nicht nur die Gegenwart, sondern auch die strategische Weiterentwicklung. Unternehmen, die hier investieren, sichern sich deshalb einen klaren Wettbewerbsvorteil. Nicht zuletzt leistet bessere Datenqualität auch einen Beitrag zur Nachhaltigkeit. Wer veraltete, redundante oder überflüssige Daten konsequent bereinigt, spart Speicherplatz und Energie. „Green IT“ beginnt damit, Datenmüll zu vermeiden und ITRessourcen effizient zu nutzen.

Fazit

Der Preis schlechter Daten ist hoch und wird noch immer unterschätzt – oder ist niemandem bewusst. Ineffizienz, Frust, Fehlentscheidungen und Risiken für Reputation und Compliance sind die Folge.

Doch die gute Nachricht lautet: Mit Künstlicher Intelligenz lassen sich diese Probleme wirksam adressieren. KI erkennt Fehler frühzeitig, bereinigt bestehende Datenbestände und unterstützt Mitarbeitende im Alltag. Damit wird aus einem potenziellen Risiko ein echter Wettbewerbsvorteil – und Unternehmen schaffen die Grundlage, um in einer datengetriebenen Zukunft erfolgreich zu sein. Gerade mittelständische Firmen sollten daher nicht länger den unsichtbaren Preis schlechter Datenqualität zahlen, sondern die Chancen von KI aktiv nutzen.