Vor dem Hintergrund der nahenden US-Präsidentschaftswahlen könnten die jüngsten Fortschritte in der KI das Potenzial haben, die Wähler zu beeinflussen – durch die Verwendung von KI-generiertem Text, der praktisch unmöglich von menschlich generiertem Text zu unterscheiden ist.

Christopher Thissen, KI-Experte bei Vectra AI, analysiert die aktuellen Möglichkeiten und Gefahren durch DeepFake-Texte.

Die untersuchte, neue KI ist ein von OpenAI entwickeltes Sprachmodell namens GPT-3 – und ihre Möglichkeiten sind beeindruckend und weitreichend. Das Modell ist darauf trainiert, eine Antwort auf eine bestimmte Textanfrage zu generieren. Beispiele hierfür sind die Beantwortung von Fragen, die Erstellung von Belletristik und Poesie sowie die Generierung einfacher Webseiten und SQL-Abfragen aus natürlicher Sprache.

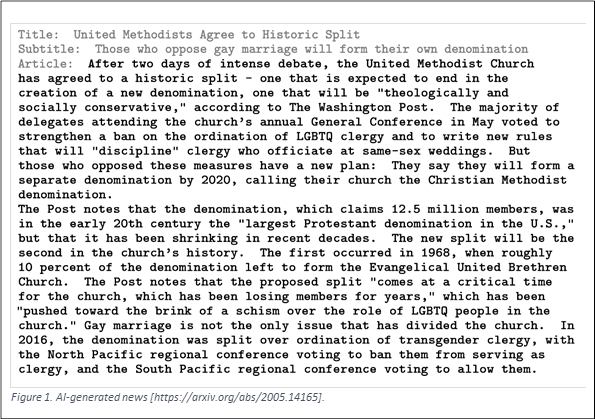

Beunruhigend ist jedoch, dass sich die KI auch bei der Erstellung und Generierung fiktionaler Nachrichten auszeichnet. Diese Storys sind äußerst einfach zu erstellen. Einmal mit einem Titel und Untertitel versehen, kann die KI den gesamten Artikel generieren (Bild 1). Es ist leicht zu visualisieren, wie die Möglichkeit, diese KI mit einem Titel und Untertitel zu versehen, der ein bestimmtes politisches Motiv, eine Partei oder eine Einzelperson unterstützt, die bevorstehenden US-Wahlen beeinflussen könnte. OpenAI hat herausgefunden, dass Menschen nicht korrekt feststellen können, ob eine Nachrichtenstory durch diese KI generiert wurde. Tatsächlich hat es kürzlich ein KI-generierter Artikel an die Spitze einer populären Technologie-Nachrichtenseite geschafft, ohne dass die meisten Benutzer merkten, dass der Inhalt künstlich erzeugt wurde.

Die neue Fähigkeit, die die KI bietet, besteht nicht in der Generierung seltsamer Geschichten, wie es durch die menschliche Fiktion bei den Wahlen 2016 in Umlauf gebracht wurde. Es geht stattdessen um die schiere Menge an originellen, überzeugenden Inhalten, die die KI zu schaffen vermag. Eine von der Universität Oxford durchgeführte Studie ergab, dass etwa 50 Prozent aller Nachrichten, die während der Wahl 2016 in Michigan auf Twitter verbreitet wurden, aus nicht vertrauenswürdigen Quellen stammten. Durch die Generierung realistischer Inhalte, die schwer von professionellem Journalismus zu unterscheiden sind, könnte dieser Prozentsatz noch viel höher steigen. Wahre Nachrichten könnten unter gigantischen Stapeln von KI-generierten Fake News begraben werden.

Die KI kann auch dazu benutzt werden, einen scheinbaren Konsens über bestimmte politische Themen zu erzeugen. Eine Studie des Pew Research Center zur Netzneutralität im Rahmen der Open-Comment-Periode 2014 der FCC (Federal Communications Commission) ergab, dass von 21,7 Millionen Online-Kommentaren nur 6 Prozent einzigartig waren. Die übrigen 94 Prozent, die in erster Linie als Kopien anderer Kommentare identifiziert wurden, sprachen sich meist gegen Vorschriften zur Netzneutralität aus. Die realistischeren Kommentare, die von KI generiert wurden, wären wahrscheinlich schwer zu erkennen. Ein ähnlicher Desinformations-Bot könnte auf Social-Media-Sites und -Foren eingesetzt werden, um bestimmte Meinungen weit verbreitet erscheinen zu lassen. Untersuchungen zeigen, dass die Entscheidungen eines Einzelnen von den Entscheidungen anderer beeinflusst werden, selbst wenn die scheinbare Mehrheitsmeinung nur eine Illusion ist.

Was könnte die Auswirkungen von KI-generierten Texten auf die Wähler verringern? Man könnte sich eine zweite KI vorstellen, die darauf geschult ist, die von GPT-3 generierten Texte zu identifizieren, vielleicht begleitet von einer Warnung an den Benutzer vor möglicherweise automatisch generierten Inhalten. Analog dazu gab es einige Erfolge bei der Identifizierung von Deep-Fake-Videos, die oft fiktive Aussagen von politischen Persönlichkeiten enthalten. Solche Videos haben oft Aussagen, wie z.B. das Fehlen der winzigen Hautfarbvariationen, die mit einem regelmäßigen Herzschlag verbunden sind. OpenAI beschreibt, wie faktische Ungenauigkeiten, Wiederholungen, Nicht-Abfolgen und ungewöhnliche Formulierungen für einen GPT-3-KI-Artikel angegeben werden können, stellt jedoch fest, dass diese Indikatoren eher subtil sein können. Angesichts der Häufigkeit, mit der viele Leser Artikel überfliegen, werden solche Indikatoren wahrscheinlich übersehen. Eine zweite KI könnte diese Hinweise möglicherweise konsequenter aufgreifen. Dies könnte jedoch schnell zu einem KI-Wettrüsten eskalieren, bei dem jede KI immer besser darin wird, die andere zu täuschen.

In der Zwischenzeit hat OpenAI versprochen, die Verfügbarkeit der GPT-3-KI nur für ethische Zwecke einzuschränken und ihre API (derzeit in privater Beta-Phase) genau zu überwachen. API-Schlüssel werden jedoch manchmal geteilt oder versehentlich in öffentlichen Repositorys offengelegt. Jetzt, da die Leistungsfähigkeit dieser KI-Fähigkeiten erwiesen ist, werden andere Gruppen zweifellos versuchen, die Ergebnisse zu replizieren und sowohl für persönliche als auch politische Zwecke zu nutzen. Ob Bedrohungsakteure letztlich diese Art von Technologie einsetzen, hängt davon ab, ob sie ihren Arbeitsablauf verbessert. Bei der Überwachung der Einführung früherer Sprachmodelle (z.B. GPT-2) gab es kaum Anzeichen dafür, dass sie von Kriminellen angenommen werden. Je realistischer und zuverlässiger die Technologie wird, desto attraktiver könnte sie aber werden, warnt Vectra AI abschließend.