Monitoring und Observability sind essenzielle Konzepte in einer dynamischen und sich ständig weiterentwickelnden IT-Landschaft. Das Monitoring konzentriert sich dabei auf die kontinuierliche Datenerfassung und -analyse, um die Performance eines Systems zu überwachen und potenzielle Probleme frühzeitig zu erkennen – ähnlich einem Frühwarnsystem, das wertvolle Infos über den Zustand der IT liefert.

Die Vielfalt und Bedrohungen moderner IT-Infrastrukturen sind mittlerweile aber so komplex geworden, dass traditionelle Monitoring-Methoden zunehmend an ihre Grenzen stoßen. Oft liefern sie nur isolierte Datenpunkte, die es erschweren, Zusammenhänge zwischen verschiedenen Systemkomponenten im Detail zu erkennen und umfassende Analysen durchzuführen.

Als Analogie können wir uns ein IT-System wie ein komplexes Labyrinth vorstellen, in dem unzählige Pfade und Hindernisse verborgen sind. Um dieses Labyrinth erfolgreich zu durchqueren und den reibungslosen Betrieb und die Sicherheit zu gewährleisten, ist nicht nur eine Überwachung von außen erforderlich, sondern auch eine gezielte Orientierung über das Geschehen innerhalb des Systems. Genau hier kommt Observability ins Spiel. Im Gegensatz zur traditionellen Überwachung, die sich auf herkömmliche Messgrößen beschränkt, konzentriert sich Observability in einem 3-Säulenmodell auch auf folgende Aspekte:

- Metriken als quantitative Datenpunkte, die das Verhalten eines Systems messen, z. B. CPU-Auslastung, Speicherverbrauch oder Anzahl der Anfragen pro Sekunde. Diese Datenpunkte sind entscheidend, um die Gesundheit und Leistungsfähigkeit eines IT-Systems zu bewerten.

- Log-Daten, die detaillierte Einblicke in die Ereignisse und Vorgänge innerhalb eines IT-Systems geben. Sie umfassen Protokolle, Fehlermeldungen, Warnungen und andere relevante Informationen, die bei der Diagnose von Problemen und der Fehlerbehebung von entscheidender Bedeutung sind.

- Schließlich Traces für Application Performance Management: Dies sind Transaktionsverfolgungsdaten, die den Weg einer Anfrage durch das IT-System zeigen. Sie helfen dabei, Engpässe und Flaschenhälse zu identifizieren und die Ursachen von Leistungsproblemen zu ermitteln.

Ein entscheidender Schritt zur Maximierung der Observability besteht nun darin, übergreifende Leistungsindikatoren (KPIs) als zentrale Messgrößen für das Säulenprinzip zu integrieren. Diese KPIs ermöglichen es, die Performance und Effizienz der IT-Systeme zu bewerten und die Auswirkungen auf die Benutzererfahrung zu verstehen. Im Rahmen unseres Modells sind insbesondere folgende KPIs von besonderer Bedeutung:

- Scalability (Skalierbarkeit) und damit die Fähigkeit eines IT-Systems, mit wachsenden Anforderungen und Lasten umzugehen, ohne dabei die Leistung zu beeinträchtigen. Dieser KPI gibt Aufschluss darüber, wie gut das System mit steigender Nutzerzahl oder Datenmenge skalieren kann.

- Response Time (Reaktionszeit), das heißt die Zeit zu erfassen, die ein IT-System benötigt, um auf eine Anfrage zu reagieren. Eine schnelle Response Time ist entscheidend, um eine reibungslose und zufriedenstellende Benutzererfahrung zu gewährleisten.

- Latency (Verzögerungszeit) erfasst schließlich die Verzögerungszeit, die bei der Übertragung von Daten zwischen verschiedenen Komponenten im IT-System auftritt. Eine geringe Latenz ist wichtig, um eine reibungslose Kommunikation zwischen den Komponenten sicherzustellen und Verzögerungen für Benutzer zu minimieren.

- Throughput (Durchsatz) beschreib die Anzahl der Anfragen, die ein IT-System pro Zeiteinheit verarbeiten kann. Ein hoher Durchsatz zeigt die Effizienz und Skalierbarkeit des Systems.

Durch die Datenerfassung und -analyse von Metriken, Log-Daten und Traces können wir diese KPIs genau messen und verstehen, wie sie sich auf die Gesamtleistung des IT-Systems auswirken. Wenn eines der KPIs sich verschlechtert oder ein Problem auftritt, ermöglicht uns die Observability, die Ursache schnell zu identifizieren und gezielte Maßnahmen zur Optimierung des Systems zu ergreifen.

Opentelemetry als immer beliebterer Standard für Observability

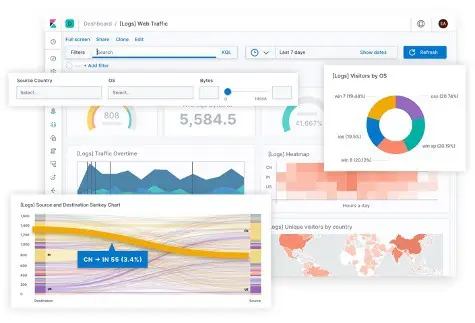

Im Streben nach einer noch umfassenderen Observability-Lösung hat sich Opentelemetry als ein vielversprechender neuer Standard herauskristallisiert. Es bietet eine innovative Möglichkeit, unser Säulenmodell nahtlos zu integrieren und gleichzeitig die Erfassung und Analyse relevanter KPIs zu erleichtern. Durch die effektive Verknüpfung von Metriken, Log-Daten und Traces entsteht damit ein ganzheitliches Bild der IT-Systemleistung, wodurch KPIs wie Scalability, Response Time, Latency und Throughput präziser gemessen und analysiert werden können. Systemadministratoren verfügen damit über vielfältige Möglichkeiten, um IT-Systeme genauer zu verstehen, Leistungsprobleme frühzeitig zu erkennen und gezielte Maßnahmen zur Verbesserung zu ergreifen.

Nahtlose Integration in jede Umgebung

OpenTelemetry bietet im Vergleich zu ähnlichen Lösungen auch einen deutlichen Vorteil durch seine Offenheit und Flexibilität. Als Open-Source-Projekt wird es von der Cloud Native Computing Foundation (CNCF) unterstützt und setzt auf eine breite Community, die aktiv an der Entwicklung und Verbesserung beteiligt ist. Ein weiterer Pluspunkt ist seine plattformübergreifende Natur, die es ermöglicht, verschiedene Programmiersprachen und Technologien zu unterstützen. Dadurch kann es nahtlos in bestehende Anwendungen integriert werden, unabhängig davon, ob diese in einer Cloud-Umgebung, lokal oder in einem Container ausgeführt werden.

Die Rolle von Künstlicher Intelligenz und Machine Learning

Ein weiterer wichtiger Aspekt der Observability ist die Einbindung von künstlicher Intelligenz (AI) und maschinellem Lernen (ML). KI und ML können dazu beitragen, Muster und Anomalien in den Observability-Daten zu erkennen, um frühzeitig auf potenzielle Probleme hinzuweisen und prädiktive Analysen durchzuführen. Dies ermöglicht es Unternehmen, proaktiv auf Leistungsprobleme zu reagieren und Ausfällen vorzubeugen.

Fazit

OpenTelemetry bietet eine wertvolle Ergänzung für jede Monitoring- und Observability-Strategie, dank seiner Kombination aus Offenheit, Flexibilität und Detailliertheit in der Analyse und Auswertung. Die Integration von KI und ML erleichtert es den IT-Teams zudem, proaktiv auf potenzielle Probleme zu reagieren und eine hochgradig performante IT-Infrastruktur zu gewährleisten. Dies führt zu einem umfassenden Verständnis des Verhaltens und der Interaktionen im System, was wiederum zu einer schnelleren Diagnose von Problemen führt.

Die Anpassungsfähigkeit von OpenTelemetry ermöglicht es darüber hinaus, spezialisierte Tools und Funktionen anzubieten, um OpenTelemetry nahtlos in bestehende Monitoring-Infrastrukturen zu integrieren, wie etwa dem Monitoringsystem NetEye von Würth Phoenix, das diese Lösung bereits vollständig unterstützt.

Weiterführende Informationen zu Observability und Opentelemetry finden Sie auch in diesem Artikel unseres Partners Elastic.