Das Ende der 10k- und 15k-Festplatte ist gekommen. So lautet zumindest die These von Fujitsu, weil Flash die viel bessere Option ist. Das hat auch Auswirkungen auf das bisher bekannte Storage-Tiering. Künftig sollen sich unterschiedliche Technologien noch mehr miteinander kombinieren, vor allem auch, weil die Workloads immer heterogener werden. Wir sprachen hierzu mit Stefan Roth, Category Manager Datacentre Central Europe bei Fujitsu.

Fujitsu sieht das Ende der 10- bzw. 15k-HDDs bereits als gekommen. Die Verkaufszahlen spiegeln das noch nicht wider. Warum sollten IT-Manager keine 15k-Platten mehr kaufen?

Roth: Das ist denkbar einfach. Beim Vergleich von Systemen mit HDDs und SSD mit gleichen Kapazitäten zeigt sich Folgendes: SSDs gibt es mit viel höheren Kapazitäten (15 TByte und jetzt auch 30 TByte). Sie bieten eine höhere I/O-Leistung und wesentlich geringere Latenzzeiten. Wenn es lediglich um Performance geht, sind zudem viel weniger SSDs erforderlich. Auch lässt sich beim Stromverbrauch und den Anforderungen an die Kühlung sowie beim Platzbedarf im Rack sparen – teilweise bis zu 90 Prozent. Bei einer Gesamtkostenbetrachtung schlagen SSD-basierte Storage-Systeme solche mit SAS-HDDs in den meisten Fällen deutlich.

Ist Flash wirklich schon günstiger?

Roth: Verglichen mit 15k-Platten – und bei größeren Kapazitäten auch bei 10k-Platten: sicherlich. Aber für Data-Lakes, Archive oder Massendaten sind Nearline-SAS-Systeme immer noch die bessere Wahl. Dabei ist auch zu berücksichtigen, dass sich unterschiedliche Technologien in einem System kombinieren lassen. Es gibt zudem bestimmte Einsatzszenarien, bei denen es sinnvoll ist, NVMe-Cache anstelle von vielen SSDs und Platten zu verwenden.

15k HDDs verkaufensich nach wie vor, trotz des schlechten Preis/GByte-Verhältnis. Preisvorteil Flash: 5% Michael Marticke, @Fujitsu_DE #StorageDays pic.twitter.com/FRldNXPBP9

— speicherguide.de (@speicherguide) February 7, 2019

Flash/HDDs: Auswirkungen auf das Storage-Tiering

Bedeutet das, dass sich auch die Storage-Tiers neu ordnen?

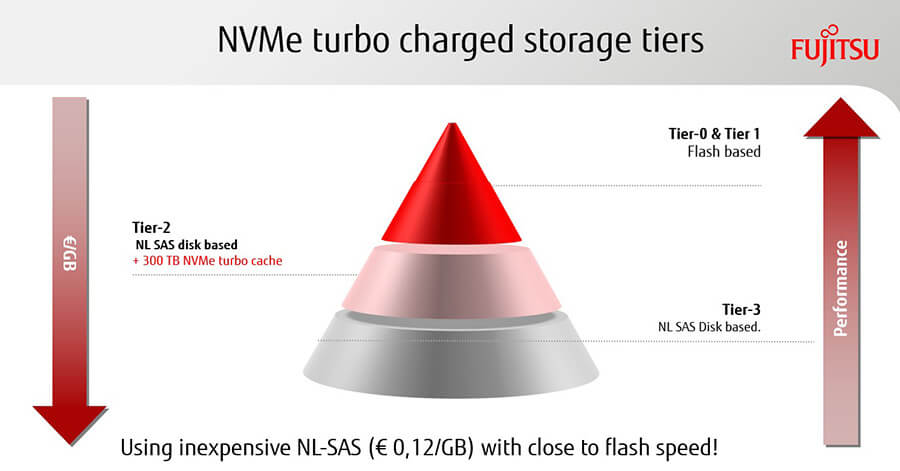

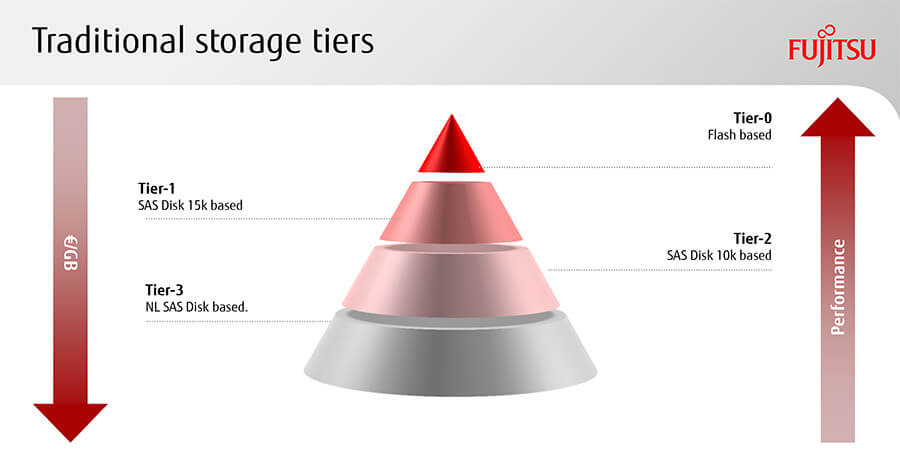

Roth: Ja, das ist die logische Konsequenz. Früher waren es meistens drei Tiers mit Nearline SAS, SAS und SSD oder – wenn vorhanden – auch Extreme-Cache.

SAS fällt jetzt raus, was die Zuordnungen erleichtert. Außerdem sorgt es meist dafür, dass auch ein automatisches Storage-Tiering nicht mehr ganz so wichtig ist wie bisher. Aber Vorsicht: Es gilt immer, den Einzelfall zu betrachten. Denn bei manchen Einsatzzwecken können Kunden nach wie vor erheblich davon profitieren.

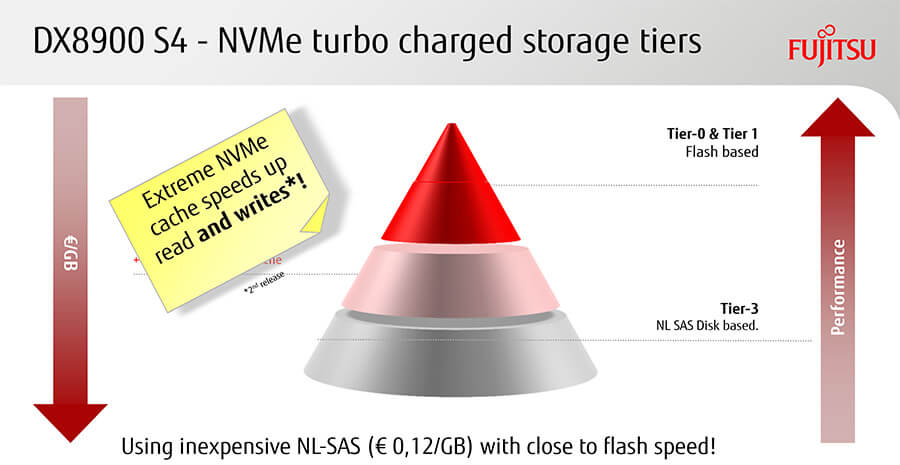

Nicht zuletzt lassen sich Nearline-SAS-Datenbereiche mit der Nutzung von NVMe-Cache anreichern, was natürlich die Performance deutlich steigert.

Ein entscheidender Faktor für eine optimale Konfiguration ist die Möglichkeit, in den Systemen sehr einfach unterschiedliche Kombinationen verschiedener Technologien nutzen zu können. Die Workloads werden immer heterogener. Daher sind Flexibilität und Skalierbarkeit das A und O.

Dies war auch entscheidend bei der Entwicklung unserer neuen ETERNUS DX8900S4-Systeme: Ausgehend von zwei Controllern können diese fast unendlich skalieren. Sie sind nicht nur die größten All-Flash- und Hybrid- Systeme am Markt, sondern mit über 10 Millionen IOPS – nachgewiesen im SPC-1-Benchmark – auch die schnellsten.

Entwicklung im Festplatten- und Flash-Markt

Wie sehen Sie die Entwicklung im Festplattenmarkt? Worauf sollten IT-Abteilungen künftig achten?

Roth: Auch bei Festplatten geht die technische Entwicklung natürlich weiter. Mit Helium-HDDs sowie Platten mit 20 TByte Kapazität sind Neuerungen im Kommen – aber so große Entwicklungssprünge wie früher sind nicht mehr zu erwarten. Nearline-SAS-Platten werden sicherlich noch einige Zeit für Massendaten, Archivierung, Video-Daten sowie Data-Lakes genutzt. IT-Abteilungen sollten generell darauf achten, dass sie in Architekturen und Systeme investieren, die eine einfache Kombination und Verwaltung verschiedener Technologien erlauben – und zwar in einem einzigen System oder innerhalb der Systemfamilie. Auch sollten Entscheider Wert darauflegen, dass die Hersteller neue Entwicklungen aufgreifen und die HDD-Technologie nicht vernachlässigen.

Fujitsu wird künftig NV-DIMMs und Intels 3D XPoint unterstützen. Was sind die Vorteile der neuen Flash-Technologie?

Roth: NV-DIMMS und Intel Optane-SSDs haben eine wesentlich geringere Latenz und sind so für zum Beispiel das Caching bestens geeignet. Sie bringen für den Anwender einen nochmaligen Schub an Performance – und das direkt neben der CPU.

Um die Kosten im Griff zu behalten, sollte bei der Planung genau geprüft werden, welche Applikationen diese Performance tatsächlich benötigen. Mit einer solchen Technologie wirklich alles abdecken zu wollen, wäre zwar sicher nett, würde aber die meisten IT-Budgets überstrapazieren.

Mit welcher generellen Entwicklung sollten IT-Abteilungen im Bereich Flash rechnen? Was kommt in den kommenden Monaten auf uns zu?

Roth: Die SSD-Kapazitäten werden größer. 30-TByte-SSDs sind bereits verfügbar, solche mit 60 TByte sind terminiert. Zudem befinden sich auch Kapazitäten von 128, 256 und sogar 512 TByte als TLC/QLC in Planung. Das ist schon enorm.

Datenwachstum ist nicht das alleinige Problem

Das Datenwachstum plagt Unternehmen jeder Größe, vor allem unstrukturierten Daten wird ein anhaltend rasantes Wachstum vorhergesagt. Wie sehen Sie hier die Entwicklung in den kommenden Jahren? Worauf sollten sich Unternehmen und IT-Abteilungen einstellen?

Roth: Das Problem ist nicht nur das reine Wachstum der Datenmengen. Auch die Zahl verschiedener Applikationen mit den unterschiedlichsten Anforderungen und Workloads wächst weiter. Hier bedarf es verschärfter und möglichst schneller Integrationsbemühungen.

Das ist zweifelsohne leichter gesagt als getan, doch mit flexiblen und skalierbaren Infrastrukturen ist es gut machbar. Dabei braucht man übrigens nicht immer gleich Software Defined-Lösungen: Wer diesen Overhead nicht wirklich benötigt, kann ihn sich sparen.

Hyperkonvergente Lösungen sind meist Silos, die ganz bewusst für bestimmte und sehr integrierte Einsatzszenarien genutzt werden, um sich genau für diesen dedizierten Einsatz einen Vorteil zu verschaffen. Das ist in etlichen Fällen extrem sinnvoll – aber eben kein Allheilmittel. Bei Storage-Lösungen gibt es so viele Integrationsmöglichkeiten. Diese gilt es, im Vorfeld zu eruieren, um das Optimum für die jeweiligen Anforderungen zu erzielen.

Auch Architekturen für Object-Speicher sind für Data-Lakes gut geeignet. Kunden nutzen für Object-Storage-Scale-Out Lösungen beispielsweise gerne die ETERNUS CD10000-Referenz-Architektur mit ihrer extrem hohen Skalierbarkeit. Scale-Out geht jedoch auch gut mit zentralen Storage-Systemen.

Umfragen zeigen, dass in Deutschland mehr als 60 Prozent der Unternehmen die Datenhoheit behalten möchten – und das am besten im eigenen Rechenzentrum. Entscheidend dafür ist jedoch eine gute Daten- und Storage-Strategie als Grundlage!

Zum Schluss eine kurze Checkliste mit den relevanten Entwicklungen, mit denen sich Unternehmen und IT-Abteilungen befassen bzw. auf die sie sich einstellen sollten:

- Intelligente Apps, Analytics/BigData

- Edge Computing

- Flash, NVMe

- Hybrid IT & Multiple Cloud

- Data Sharing und Datentransfer mit der Cloud

- Object Storage

- Archivierung

- NVMe over Fabric wird in die Rechenzentren einziehen

- Investitionen in die Absicherung der Daten werden enorm steigen