Das Passwortmanagementunternehmen LastPass entging im Zuge eines CEO-Fraud-Versuchs potenziell einem Desaster. Ein Mitarbeiter erhielt eine Deepfake-Audio über WhatsApp, die die Stimme des CEO Karim Toubba nachahmte.

Der Vorfall passierte vergangenen Woche und wurde durch die Verwendung von Deepfake-Technologie ermöglicht, die Stimmen täuschend echt imitieren kann.

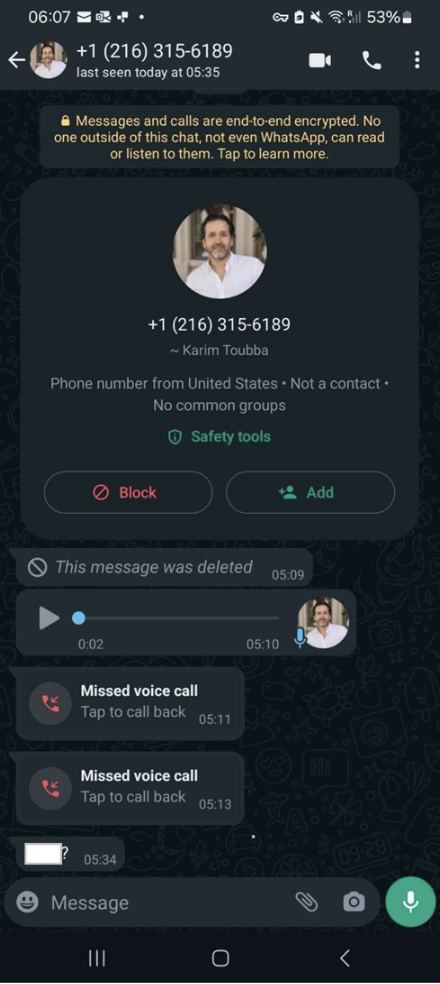

Mike Kosak, Senior Principal Intelligence Analyst bei LastPass, berichtete in einem Blogbeitrag, dass der Mitarbeiter mehrere Anrufe und Textnachrichten über WhatsApp erhielt. „Er wurde misstrauisch, ignorierte die Anfragen und meldete den Vorfall unserem Sicherheitsteam“, so Kosak. Der Mitarbeiter traute den Nachrichten vor allem deshalb nicht, weil der Kommunikationsversuch außerhalb der normalen Geschäftskommunikationskanäle stattfand und er viele der Merkmale eines Social-Engineering-Versuchs erkannte, wie die erzwungene Dringlichkeit.

Durch seine besonnene Reaktion blieb das Unternehmen unversehrt, der Angriff hatte keine Auswirkungen. Trotzdem wollte man aber den Vorfall öffentlich machen, um das Bewusstsein für die Gefahr durch Deepfakes zu schärfen.

Brandgefährliche Masche

Deepfakes sind nicht nur gefährlich, sondern nehmen auch in erschreckendem Maße zu. Die Zahl der weltweit entdeckten Deepfakes ist laut Sumsub Research von 2022 bis 2023 in allen Branchen um das 10-fache gestiegen, mit bemerkenswerten regionalen Unterschieden: 1740 % Deepfake-Anstieg in Nordamerika, 1530 % in APAC, 780 % in Europa (inkl. Großbritannien), 450 % in MEA und 410 % in Lateinamerika.

Der Anstieg beim Deepfake-Phishing ist wahrscheinlich darauf zurückzuführen, dass Deep-Learning-Modelle immer leichter zugänglich sind. Diese fortschrittlichen KI-Algorithmen erforderten früher ein hohes Maß an Erfahrung in der Datenwissenschaft oder ein großes Budget. Jetzt gibt es viele kostenlose oder kostengünstige KI-Modelle, für deren Verwendung nur geringe oder gar keine Programmierkenntnisse erforderlich sind.

Erst kürzlich wurde ein Finanzmitarbeiter eines großen Unternehmens mit Sitz in Hongkong dazu gebracht, 25 Millionen Dollar in einem ähnlichen Betrugsfall zu überweisen, Die Kriminellen hatten ein Videogespräch geführt, bei dem jede teilnehmende Person ein Deepfake war.