ChatGPT, Gemini oder Claude: Mit Cloud‑basierten generativen KI‑Tools können Unternehmen effizienter, intelligenter und kreativer agieren. Die Kehrseite: Datenschutz, Modell‑ und Datenkontrolle sowie die Integrität sensibler Informationen sind gefährdet.

Diese Risiken lassen sich jedoch durch den Betrieb leistungsstarker KI‑Systeme vor Ort und den Einsatz eines Zero‑Trust‑Netzwerks mit aktiver Traffic‑Überwachung sowie mehrschichtiger Perimeterabsicherung minimieren.

Generative Modelle wie GPT‑4, Claude und Gemini eröffnen Unternehmen neue Möglichkeiten – von automatisierter Text‑ und Code‑Generierung über Datenanalyse bis hin zu intelligentem Wissensmanagement. Doch es gibt ein Problem: Prompt‑ und Nutzungsdaten werden in der Regel über das Internet an fremdgehostete Server in Drittländern gesendet. In vielen Fällen ist dies ein Verstoß gegen interne Compliance‑Vorgaben, die DSGVO und branchenspezifische Sicherheitsstandards. In regulierten Branchen (etwa öffentlicher Sektor, Energieversorgung, Gesundheitsbranche) ist die Nutzung klassischer Cloud‑Modelle daher häufig unzulässig. Die zentrale Frage lautet: Wie können diese Tools sicher, datenschutzkonform und kontrollierbar im eigenen Unternehmen integriert werden?

Auch außerhalb von Hochsicherheitsumfeldern wächst das Bewusstsein, dass Unternehmen die Kontrolle über Datenströme, Modellverhalten und Zugriffspflichten behalten müssen. Kundendaten und Betriebsgeheimnisse dürfen nicht unkontrolliert nach außen gelangen, und nicht jeder Mitarbeitende soll Zugriff auf alle Informationen haben. Eine Lösung muss moderne KI‑Funktionalität mit lokaler Kontrolle und technischer Absicherung verbinden.

Ein praktikabler Ansatz dafür ist ein Zero‑Trust‑Framework, das generative KI‑Modelle On‑Premises hostet, diese zuverlässig absichert und gleichzeitig die kontrollierte Nutzung relevanter APIs (Application Programming Interfaces) ermöglicht.

Lokale Sprachmodelle mit vLLM

Eine Möglichkeit, generative KI lokal bereitzustellen, ist die Kombination eines leistungsfähigen Open‑Source‑Sprachmodells wie Llama 3.3 von Meta, mit dem Inferenz‑Framework vLLM (Virtual Large Language Model). vLLM stellt die Modelle besonders effizient bereit und bietet eine OpenAI‑kompatible API. Dadurch lassen sich bestehende Tools, Plugins und interne Softwarelösungen ohne größere Anpassungen lokal nutzen. Daraus ergeben sich Vorteile wie geringere Komplexität, reduzierter Implementierungsaufwand und schnelle Integration von KI‑Funktionen in vorhandene Automatisierungsabläufe.

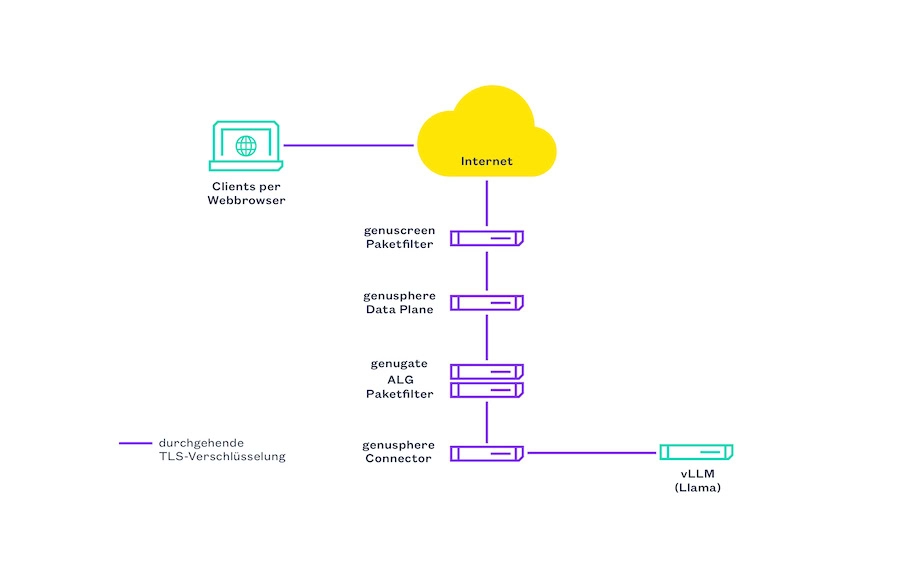

Die Kombination aus lokalem LLM‑Betrieb und mehrschichtigem Zero‑Trust‑Ansatz bildet die Basis für eine kontrollierte, datenschutzkonforme und unternehmenseigene KI‑Strategie. Die Integration von Llama 3.3 über vLLM in ein streng kontrolliertes Netzwerkszenario umfasst mehrere Sicherheitsschichten – vom äußeren Perimeter bis hin zur aktiven Überwachung des internen Datenverkehrs.

- Perimeterschutz – Die erste Schicht bildet genuscreen, die Firewall‑ und VPN‑Appliance von genua. Sie schützt das Unternehmensnetz vor externen Angriffen, analysiert und kontrolliert auch verschlüsselte Verbindungen und sorgt dafür, dass nur definierter Traffic ins interne Netz gelangt.

- Application‑Layer‑Firewall – Im internen Netzwerk arbeitet genugate als robuste Application‑Layer‑Firewall. Durch Zonen‑ und Mediendatentrennung wird der Zugriff auf die Server, die vLLM und das Sprachmodell hosten, strikt reguliert. Nur exakt definierte Kommunikation ist erlaubt; optional können Inhalte manuell freigegeben werden, z. B. bei Dateiübertragungen.

- Zero‑Trust‑Application‑Access – Für den kontrollierten Zugriff von außen (mobile Mitarbeitende, externe Partner, verteilte Units) kommt genusphere zum Einsatz. Im Unterschied zu klassischen VPNs oder Reverse‑Proxys ermöglicht die ZTAA-Lösung eine segmentierte Bereitstellung von Applikationen, komplett entkoppelt vom internen Netzwerk. Zugriffsrechte werden kontext‑, rollen‑ und gerätespezifisch vergeben.

Das bedeutet: Nur wer unter den definierten Bedingungen berechtigt ist, kann auf bestimmte Funktionen einer Anwendung zugreifen. Daraus ergeben sich klare Vorteile für die lokale KI‑Architektur:

- Selektive Bereitstellung von KI‑Diensten (API, Web‑Oberfläche, Wissensportal) nach außen.

- Authentifizierter, kontextsensitiver Zugriff (Device Trust, Identity Federation, granulare Policies).

- Anwendung bleibt intern isoliert; genusphere vermittelt nur die Anwendungsebene, nicht die darunterliegende Infrastruktur.

- Skalierbare, sichere und DSGVO‑konforme Nutzung generativer KI über Standortgrenzen hinweg ohne Kompromisse bei Netzwerk‑ oder Datensicherheit.

(Bildquelle: genua GmbH)

Fazit

Leistungsstarke generative KI‑Tools lassen sich sicher einsetzen, wenn sie in eine durchdachte Sicherheitsarchitektur eingebettet werden. Durch die Kombination aus lokalem LLM (z. B. Llama 3.3), effizienter Inferenz (vLLM) und einem mehrschichtigen Zero‑Trust‑Ansatz (genuscreen, genugate, genusphere) können Unternehmen die Vorteile moderner KI‑Anwendungen nutzen und behalten gleichzeitig die volle Kontrolle über ihre digitale Zukunft.