Die Virtualisierung der gesamten IT-Infrastruktur führt letztlich zu Cloud-Betriebsmodellen. Um dorthin zu kommen, müssen Unternehmen aber erst noch Hausaufgaben bei der Speichervirtualisierung erledigen.

Das Rechenzentrum und die Bereitstellung von Applikationsdiensten befinden sich im Wandel: Jahrelang wurden Applikationen fest einem Server zugeordnet.

Virtualisierungstechniken lösen diese Vorgehensweise zunehmend ab. Und auch dem nächsten Schritt können sich Unternehmen kaummehr verschließen: Mit Cloud Computing steht nun eine Anpassung in Richtung alternativer IT-Betriebsmodelle ins Haus. Wie sehen diese neuen Liefermodelle der IT von morgen aus, was ändert sich gegenüber den bestehenden Konzepten, und was müssen Unternehmen tun, um dorthin zu kommen?

Virtualisierung führt zur Cloud

Angelehnt an das Marktforschungsunternehmen Gartner kann man drei Stufen der Virtualisierung unterscheiden:

Phase 1: Servervirtualisierung

Der Zweck liegt vor allem in der Reduzierung der physischen Server.Die Konsolidierung der IT-Infrastruktur ist ein Mittel zur Kostensenkung und in vielen Unternehmen bereits abgeschlossen oder derzeit in der Umsetzung.

Phase 2: Agilitätserhöhung der IT

Durch flexiblere IT-Betriebsmodelle können die Unternehmen zügiger auf die Anforderungen des Marktes reagieren und ihre IT-Dienste mitsamt der Applikationen und Verwaltungsprozesse schneller in Betrieb nehmen. Erreicht wird dies durch die erweiterten technischen Funktionen der Virtualisierung wie etwa der schnellen Provisionierung einer virtuellen Maschine, der dynamischen Lastenverteilung von bestehenden Anwendungen auf weniger belastete Serversysteme, Funktionen für Fehlertoleranz sowie den besseren Möglichkeiten der Disaster Recovery.

Phase 3: Entkopplung der IT-Dienste

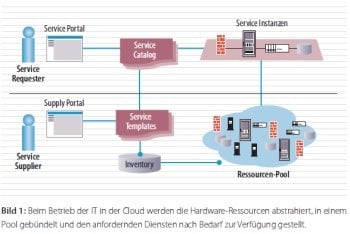

Die Dienste lösen sich vollständig von den benötigten Ressourcen, wie beispielsweise Server, Plattenspeicher, Netzwerkkomponenten oder weitere Infrastrukturbaugruppen. All diese IT-Ressourcen werden stattdessen in einem Pool zusammengefasst (siehe Bild 1), Applikationen und Dienste dann entsprechend aus diesem zugewiesen. Die Entkopplung der Dienste von den Ressourcen mündet in die Verfahren, die als Cloud Computing bezeichnet werden können. Die „interne Cloud“ baut auf den Ressourcen des eigenen Rechenzentrums auf. Bei der „externen Cloud“ erfolgt der Bezug der Ressourcen von Drittanbietern.

Die Weiterentwicklung von vSphere, Kernprodukt des Marktführers im Virtualisierungssegment VMware, sowie die Projektionen von Gartner bezüglich Cloud-Computing geben die Richtung klar vor. Diese liegt in der Schaffung einer dynamischen und abstrahierten Infrastruktur. Demnach basieren die zukünftigen IT-Betriebsmodelle auf folgenden Säulen:

-

Anforderungen der Unternehmen an IT-Dienste (Applikationen)

-

Hardware-Ressourcen

-

Verwaltungsprozesse zur Bereitstellung der Dienste

Unterstützt durch Service-Portale erfolgt dabei eine Beauftragung der Dienste direkt durch die Nutzer. Bis dahin ist allerdings noch eine Menge Arbeit zu leisten.

Speichervirtualisierung hinkt noch hinterher

Wie erwähnt schafft die vollständige Trennung der festen Zuordnung der Dienste von den Ressourcen Voraussetzungen für die Schaffung der neuen Betriebsszenarien. In der Serverlandschaft ist dies mit den Lösungen für die Servervirtualisierung bereits größtenteils geschehen. Es geht aber um mehr als Serverhardware: IT-Dienste brauchen zusätzlich zur Hardware auch Speichersysteme. Und schließlich geht es umdie Netzwerke, über die die Dienste den Benutzern zur Verfügung gestellt werden. Die Netzwerk-Virtualisierung ist dabei vergleichsweise einfach umzusetzen, während die Speichervirtualisierung deutlich komplexer und kritischer ist. Bei der Virtualisierung weiterer Ressourcen und der dazu notwendigen Managementkonzepte besteht noch Nachholbedarf. In einer Experton-Studie gaben 65 Prozent der befragten Unternehmen an, bereits Virtualisierungslösungen zur Serverreduktion einzusetzen, weitere 16 Prozent befinden sich hier noch imPlanungsstadium. Auf virtualisierte Speicher setzen dagegen nur rund 35 Prozent der Unternehmen, 16 Prozent planen den Einsatz von Speichervirtualisierung (Experton Group, Green IT Update 2009, Mai 2009).

Diese verfolgt gleich mehrere Ziele: Zumeinen die effizientere Nutzung von Speicherressourcen und zum anderen die Gewährleistung der Datenverfügbarkeit. Schließlich liefert die Speichervirtualisierung erst die Grundlage für umfassende Virtualisierungslösungen. Geschlossene Speichersysteme, die bisher als Basis für Konzepte der Speichervirtualisierung dienen, sind für eine umfassende Virtualisierung nur eingeschränkt geeignet. Mit HP LeftHand liegt dagegen eine Technologie vor, die passgenau auf die Anforderung der dynamisierten IT abgestimmt ist.

Logischer Speicherpool für vSphere

Es gibt zwei Ausprägungen dieser Technologie: Ein physikalisches SAN und eine virtuelle SAN Appliance, die den vorhandenen Plattenplatz von ESX-Servern nutzt.

Die physikalische Lösung (siehe Bild 2) basiert auf einer Cluster-Architektur. Einzelne Cluster-Knoten ergänzen sich dabei modular und flexibel zu einem gemeinsamen zu verwaltenden iSCSISAN. Jeder zusätzliche Speicherknoten liefert weitere Performance und Bandbreite bis zu 10 GBit. Die Knoten basieren auf Industrie-Standard-Storage-Komponenten mit SAS oder SATAFestplatten. Dies macht zukünftige Erweiterungen einfach.

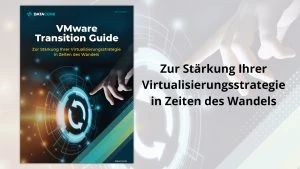

Die virtuelle SAN Appliance (siehe Bild 3) stellt den an einem ESX-Server direkt angeschlossenen Festplattenspeicher als virtualisierten Speicherpool für virtuelleMaschinen in VMware-Umgebungen bereit. Durch die integrierte Verwaltungssoftware wird der Speicherplatz aller vorhandenen Appliances, ganz im Sinne der zukünftigen IT-Betriebsmodelle, gebündelt und vSphere als ein großer Pool zur Verfügung gestellt. Die Appliances erfüllen die Forderungen einer abstrahierten IT, den gesamten verfügbaren Speicher logisch zusammenzufassen, ohne das dies physikalisch geschehen muss, wie das bei den meisten SANs heute notwendig ist.

Die weiteren Funktionen des Speichersystems sind darauf ausgelegt, den Betrieb einer vSphere-Infrastruktur zu optimieren und den Weg für die zukünftigen Betriebsmodelle zu ebnen. Die Funktion des Netzwerk-RAIDs beispielsweise federn Ausfälle des Speichersystems, wie sie bei traditionellen SANs auftreten können, ab. So wird sichergestellt, dass die Virtualisierungsplattformen wie vSphere auf einer stabilen und ausfallsicheren Speicherinfrastruktur aufbauen können. Das integrierte Thin Provisioning vereinfacht zudem die Zuweisung des Speichers zu einer virtuellen Maschine. Dies ist alleine durch den vSphere-Administrator machbar, eine zusätzliche Verwaltung in der SAN-Managementkonsole entfällt. Snapshots und die Funktion des Remote Copy liefen die Grundlagen für die Ausfallsicherheit und das Failover einer vSphere-Infrastruktur.

Wohin geht die virtuelle Reise?

Zusammenfassend lässt sich festhalten, dass künftige Virtualisierungskonzepte auf einer vollständig virtualisierten Infrastruktur basieren. Beginnend bei den Servern, setzt sie sich über die Speichersysteme und Netzwerkanbindungen fort und schließt die dazu notwendigen Verwaltungskonzepte ein. Korrespondierend dazu stehen die Servicekataloge der IT. Aus diesen wählen die Fachbereiche den benötigten Service. Unterstützt durch Automatismen und erneuerter Managementtools erfolgt dann eine dynamische Zuordnung der Benutzeranforderungen zu den Rechnerressourcen.

Ingo Kraft

Diesen Artikel finden Sie auch in der Ausgabe November/11 2009 des it management.