Im Kern geht es bei der Virtualisierung um eine effizientere Nutzung von IT-Ressourcen durch eine Konsolidierung von Applikationen auf eine geringere Zahl physikalischer Server. Ändert sich der Bedarf an Rechenzentrumsleistungen, lassen sich nicht benötigte Ressourcen vorübergehend in den Stand-by-Modus schalten. Kommt es zu unerwarteten Spitzenbelastungen sind zusätzliche Kapazitäten rasch reaktivierbar. Das Ergebnis ist ein deutlich umweltschonender Umgang mit den vorhandenen IT-Ressourcen.

Unternehmen müssen erstens klären, wie sie die Virtualisierung in die vorhandene IT integrieren und siemüssen zweitens klare Ziele setzen, wasmit der Virtualisierung erreicht werden soll. Bei einer allzu radikalen Umstellung sind die Chancen desMisslingens am größten. Wer die Virtualisierung genau plant, wird am ehesten davon profitieren. Rasch vorzeigbare Erfolge schaffen eine gute Ausgangsbasis für eine nachhaltige Effizienz.

Der Übergang zur Virtualisierung

Virtualisierung setzt sich in den Rechenzentren der Unternehmen immer stärker durch. Mit der zunehmenden Reife des Marktes werden die Potenziale, aber auch die Grenzen der Technologie deutlicher und Anwender sind besser in der Lage, die Angebote der einzelnen Hersteller einzuordnen.Hersteller sollten diese Chance nutzen und den Anwendern detailliert aufzeigen, wie sich Virtualisierung in einem konkreten Umfeld optimal einsetzen lässt.

Die Ermittlung der Zahl der Server, die in einer ersten Phase virtualisiert werden kann, ist ein wichtiger erster Schritt. Nur in Ausnahmefällen gibt es Unternehmen, die auf Anhieb die Mehrheit ihrer Workloads in eine virtuelle Umgebungmigrieren. In der Praxis hat es sich bewährt,mit den weniger kritischen Servern zu beginnen, Erfahrungen zu sammeln und dann nach und nach auch die Mission Critical Workloads zu virtualisieren. Eine wichtige Rolle spielt dabei auch die Beratung und der Support durch den Anbieter der Virtualisierungslösung.

Virtualisierung ist immer abhängig von den vorhandenen Organisationsstrukturen und der Technologielandschaft. Unternehmen sollten sich daher alle internen Prozesse, die möglicherweise von der Virtualisierung betroffen sind, genau ansehen. Wer darauf verzichtet, läuft Gefahr, dass sich die erwarteten Vorteile der Virtualisierung nicht einstellen – insbesondere die erhoffte IT-Agilität. Die größte Hürde einer erfolgreichen Implementierung ist nicht die Technologie, sondern die organisatorische Vorbereitung. Dazu gehören unter anderem die Bereitstellung (Provisioning) der virtualisierten Applikationen und Server und das Change- Management. Gibt es keine Regelungen, beansprucht jede Applikation so viele Server-Ressourcen als möglich. Es ist daher wichtig für Unternehmen, Tools einzusetzen, die zeigen, welche Ressourcen die einzelnen Applikationen tatsächlich verbrauchen. Eine höhere Transparenz ermöglicht Administratoren, Konflikte frühzeitig zu erkennen und die Performance besser zu überwachen, damit unternehmenskritische Applikationen vorrangig laufen können.

Die tatsächlichen Kosten der Virtualisierung

Kosteneinsparungen sind für Unternehmen mit die wichtigsten Gründe für die Virtualisierung. Eine Senkung der Kosten bei gleichzeitiger Steigerung der Produktivität gehört zu den grundlegenden Zielen jeder Organisation und Virtualisierung ist eine Technologie, die nachgewiesenermaßen hilft, Kosten zu reduzieren.

Das bedeutet aber nicht, dass dies ohne Investitionen gehen würde. Der Return on Investment (ROI) ergibt sich aus zusätzlichen organisatorischen Maßnahmen und deren Wirkung, etwa dem geringeren Platzbedarf im Rechenzentrum, weniger Hardware, Wartung, Administration, Personal, Administrationsaufwand und Energiebedarf. Virtualisierungstechnologie allein wird die laufenden Kosten nicht senken.

„Die Vorteile der Virtualisierung liegen auf der Hand. Die Kosten sinken, die Produktivität steigt, die Zahl physischer Server verringert sich und damit sinkt auch der Energiebedarf. Kurzum: Es gibt genügend Gründe für die Virtualisierung.“Aram Kananov, Product Markting Manager EMEA Platform und Cloud bei Red Hat

Auch ein geringerer Energiebedarf hilft Kosten sparen.Durch die Reduktion der Zahl physischer Server, können Organisationen den benötigten Platz im Rechenzentrum reduzieren. Im eigenen Rechenzentrum führt der reduzierte Bedarf an Energie und Kühlung, kombiniert mit dem geringeren Platzbedarf durchaus zu Einsparungen bis zu 50 Prozent.

Die Administration einer virtuellen Umgebung ist eine sehr anspruchsvolle Aufgabe, aber verglichen mit einer regulären Umgebung lassen sich auch hier deutliche Einsparungen erzielen. Denn in einer virtualisierten Umgebung müssen die Administratoren eine kleinere Zahl physischer Server betreuen und die vorhandenen virtuellen Systeme ermöglichen ihnen, auch remote zusätzliche Applikationen im laufenden Betrieb hinzuzufügen, ohne dass es zu Ausfällen kommt.

Die Einrichtung von Applikationen auf einem physischen Server kann sehr aufwändig und langwierig sein. In einer virtuellen Umgebung lässt sich dieser Prozess von Tagen auf Stunden oder gar Minuten reduzieren. Administratoren werden somit deutlich produktiver.

Datensicherheit in einer virtuellen Umgebung

Durch die Virtualisierung entstehen oft neue Sicherheitsanforderungen. Migrieren Unternehmen weitere Server und Applikationen in eine virtuelle Umgebung, wächst auch die Menge der Daten, die möglichen Angriffen ausgesetzt sind. In einer nicht-virtualisierten Umgebung erhält ein Hacker Zugriff auf einen physischen Server. Auf einem virtualisierten Rechner erhält er Zugriff auf jede virtualisierte Instanz, die auf dem physischen Server läuft.

Ursachen möglicher Sicherheitsrisiken bilden die eigenen Mitarbeiter oder Angriffe von außen. Da immer mehr Mitarbeiter mit ihren eigenen Geräten die IT-Ressourcen im Unternehmen nutzen wollen, müssen diese dafür sorgen, dass keine internen Daten unautorisiert über die mitgebrachten Endgeräte das Unternehmen verlassen. In der einfachsten Form gibt es technische Möglichkeiten, die verhindern, dass Daten auf den mitgebrachten Endgeräten gespeichert werden. Mitarbeiter können Daten dann lesen, aber es wird verhindert, dass sie Daten aus der virtuellen Umgebung exportieren oder kopieren können. Genau solche Szenarien sind typische Einsatzgebiete einer Virtual Desktop Infrastructure (VDI).

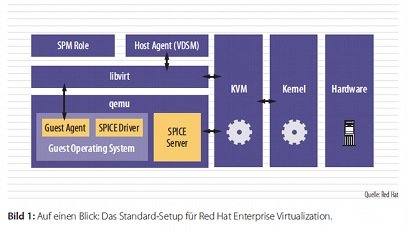

Eine Möglichkeit, hohe Datensicherheit zu gewährleisten besteht darin, sich für Produkte zu entscheiden, die über eine kernelbasierte Policy Enforcement Infrastructure verfügen. Solche Sicherheitsmaßnahmen isolieren virtuelleMaschinen voneinander und gewährleisten eine klare Trennung von physischer Hardware und dem Hypervisor. Die Linux Kernelbased Virtual Machine (KVM) mit SELinux-Technologie, verfügt über Sicherheitsfunktionen wie sie auch im Militärbereich gefordert werden.

KVM trägt entscheidend dazu bei, dass potenzielle Sicherheitslücken des Hypervisor nicht von Hackern für ihre Angriffe auf den Host oder die einzelnen virtuellen Maschinen genutzt werden können.

Risiken der Herstellerabhängigkeit

Lange Zeit haben einige Hersteller proprietäre Technologielösungen angeboten, die nur über wenig oder gar keine Interoperabilitätmit den Produkten anderer verfügten. Wo es keine offenen Standards gibt, droht die Herstellerabhängigkeit. Für Anwender bedeutet dies oft hohe Investitionskosten und eine geringe IT-Effizienz.

Die fehlenden Möglichkeiten, Applikationen von der einen in die andere virtuelle Umgebung zu verschieben und die Probleme, Daten zu übertragen, können den Geschäftsbetrieb erheblich behindern. Binden sich Unternehmen mit ihrer IT-Infrastruktur zu sehr an die Technologie eines einzelnen Herstellers, ist es schwer sich davon zu befreien. Wo Hersteller ihre Lizenzmodelle von der Zahl der von virtuellen Maschinen genutzten CPUs abhängig machen, werden Organisationen in ihrer Flexibilität stark eingeschränkt. Denn bei einer weniger starken Belastungmüssen sie dennoch hohe Lizenzkosten zahlen.

Entscheiden sie sich dagegen für eine Open-Source-Lösung, die ohne Kompromisse an den Vorgaben der Interoperabilität und Portabilität ausrichtet ist, können Unternehmen die Richtung bestimmen und sie machen sich unabhängig von einem einzelnen Anbieter. Sie sind dann in der Lage, tatsächlich alle Vorteile der Flexibilität, wie sie die Virtualisierungstechnologie eigentlich verspricht, auch auszunutzen. Neue Anforderungen aus dem Geschäftsumfeld lassen sich von nun an problemlos meistern.

Aram Kananov, Red Hat

Diesen Artikel lesen Sie auch in der it management , Ausgabe 1/2-2012.