Die meisten Daten sind ohne eine vorher durchgeführte Data Preparation für KI-gestützte Prognosen ungeeignet: ihre Qualität ist unzureichend, sie liegen nicht in numerischer Form vor, oder es fehlen Werte.

Diese Handlungsempfehlungen unterstützen bei der Datenvorbereitung und helfen, den Aufwand dafür nicht nur beträchtlich zu reduzieren, sondern auch die Qualität der Vorhersagen Ihres Predictive Analytics-Modells signifikant zu verbessern. Die 4 Schritte können auch als komplette Anleitung heruntergeladen werden.

Die Data Preparation-Phase besteht aus vier Teilschritten: Data Exploration, Feature Cleansing, Feature Engineering und Feature Selection. Für jede dieser Prozessstufen gibt es Optimierungsmöglichkeiten, mit denen Sie die Datenvorbereitung sowohl effektiver als auch effizienter gestalten können.

Data Exploration

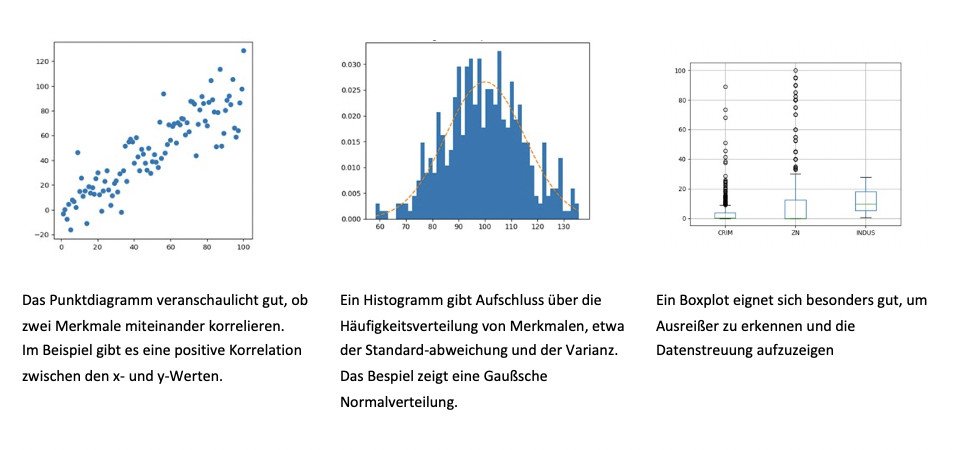

In der Explorationsphase entwickeln Sie ein grundlegendes Verständnis für die Daten. Mit statistischen Analyseverfahren beschreiben Sie die Merkmale (Features), etwa indem Sie Minima und Maxima, die Lagemaße und die Datenverteilung sowie Zusammenhangmaße ermitteln.

Weiterhin bestimmen Sie die Datenqualität und decken dabei insbesondere Qualitätsdefizite auf, die Sie in den nächsten Schritten beheben werden. Dazu gehören

- fehlende Daten: Die meisten Machine Learning-Modelle sind nicht in der Lage, die sogenannten Null-Werte zu verarbeiten, was ein Modelltraining unmöglich macht.

- Ausreißer können sich negativ auf Performance-Modelle auswirken und beispielsweise Overfitting verursachen.

- nicht-numerische Datenformate und

- seltene Merkmalsausprägungen.

Feature Cleansing

Jetzt geht es darum, die erkannten Fehler zu beheben oder weitestgehend zu neutralisieren. Für die Bereinigung fehlender Werte können Sie zwischen zwei Lösungsansätzen wählen: Sie löschen Datensätze, die fehlende Werte enthalten. Oder Sie ersetzen die fehlenden Daten durch gültige Werte („Imputing“). Die einfachste Variante dabei ist es, wenn Sie diese durch Dummies ersetzen. Sie können Ihr Modell problemlos trainieren, wenn Sie anstelle des fehlenden Werts das Merkmal „Null“ einfügen. Sie bilden den Durchschnitt aller Merkmale, die ungleich Null sind, und setzen diesen Wert ein. Bei Zeitreihen setzen Sie an die Stelle des Null-Wertes den letzten oder den ersten nachfolgenden gültigen Wert ein. Sie lassen ein Modell den fehlenden Wert ermitteln.

Den unerwünschten Einfluss von Ausreißern minimieren Sie, indem Sie die Datensätze skalieren. Wenn ein Ziel Ihres Data Science-Projekts jedoch darin besteht, Anomalien aufzudecken (Anomaly Detection), dann müssen die Ausreißerwerte unverändert im Datenbestand verbleiben.

! Tipp: Stellen Sie Ihre Werte in logarithmischer Form dar, um den verhältnismäßigen Einfluss von Ausreißern zu verringern.

Feature Engineering

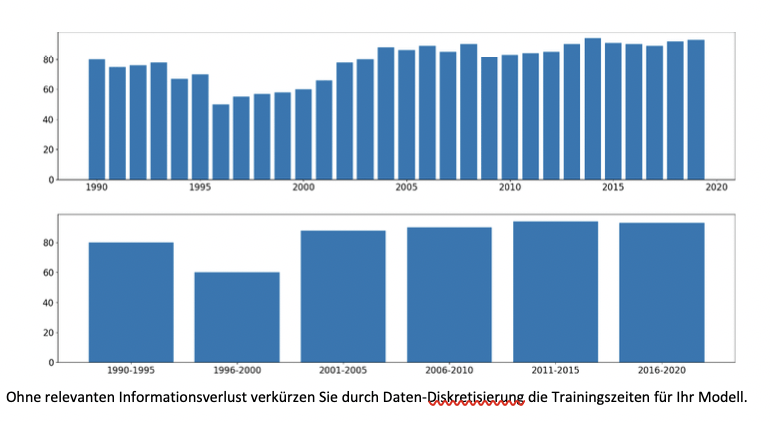

Bei sehr vielen Einzeldaten eines Merkmals ist es sinnvoll, Werte zusammenzufassen (Diskretisierung). Mit der verringerten Anzahl an Merkmalsausprägungen sinkt der Rechenaufwand und Ihr Modell benötigt weniger Zeit für die Trainingsphase.

! Tipp: Insbesondere bei kontinuierlichen Wertereihen ist es empfehlenswert, Daten zu diskretisieren.

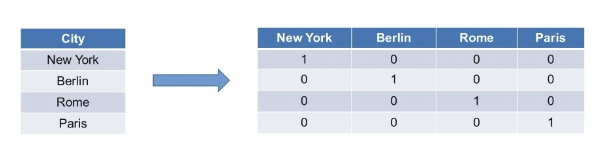

Liegen Daten auch in einer anderen Form als Zahlen vor, beispielsweise als Texte oder Bilddaten, müssen Sie diese ggfs. nun in numerische Werte überführt werden. Abhängig ist dies vom gewählten ML-Modell.

! Tipp: Nutzen Sie dafür das One-hot Encoding-Verfahren.

Für jede Merkmalsausprägung, im Beispiel sind das die verschiedenen Hauptstädte, legen Sie eine eigene Spalte an. Dort, wo die Zeile der ursprünglichen Datenreihe einen Wert in Form des Textes enthält, tragen Sie die Zahl 1 in die entsprechende Zelle ein, alle anderen Zellen enthalten eine 0.

Feature Selection

In der letzten Phase der Data Preparation bestimmen Sie die Merkmale, mit denen Sie Ihre Predictive Analytics-Modelle trainieren wollen. Eine Beschränkung ist sinnvoll, da die Modelle umso mehr Trainingszeit benötigen, je mehr Merkmale in die Berechnungen einfließen und es Modelle gibt, die überhaupt nur mit einer begrenzten Datenzahl arbeiten können. Eine Möglichkeit, die Daten sinnvoll auszuwählen, besteht darin sie zu filtern – nach ihrer Relevanz zur Zielvariablen oder nach der Anzahl der fehlenden Werte.

! Tipp: Verzichten Sie auf Daten, die mit dem Feature, das Sie in Ihrem Data-Science-Projekt modellieren wollen, in keinem Zusammenhang stehen.

Sie können ebenso eine modellbasierte Selektion vornehmen, wenngleich diese Vorgehensweise sehr rechenintensiv ist. Dabei wird das Modell mehrmals trainiert – mit verschiedenen Merkmalkombinationen. Im Anschluss lässt sich daraus ableiten, welche Kombinationen sinnvoll oder weniger sinnvoll sind.

! Tipp: Nutzen Sie Modelle, die auf Grundlage von Entscheidungsbäumen arbeiten, etwa Random Forests. Diese Modelle ermitteln datenbasiert, welche Bedeutung ein Merkmal für die Vorhersage hat, so dass Sie sich für die weitere Modellierung auf diese Features konzentrieren können.

Nun ist die Datenvorbereitung durchgeführt und es schließt sich die Modellierung an.

Der erste Schritt besteht darin, ein oder mehrere Modelle auszuwählen. Wesentliche Kriterien sind die Art der gewünschten Vorhersagen, Datenbeschaffenheit und -menge. Sobald feststeht, welches Modell am geeignetsten ist, folgt seine Trainingsphase. Ziel ist es, die bestmögliche Vorhersagegenauigkeit zu erreichen.