Enterprise-KI-Agenten werden 2026 zum Prozessstandard – doch der Weg vom fragilen Prototyp zur produktionsreifen Automatisierung erfordert die richtige Architektur.

Während 2025 als „Jahr der KI-Agenten” in die IT-Historie eingeht, zeigt die Praxis: Erfolgreiche Implementierungen basieren auf der Kombination aus deterministischer Prozessorchestrierung und dynamischer KI-Intelligenz. Im Rahmen des „Project Orchestr-AI-te” haben wir die Learnings aus über 50 Kundenprojekten aus Banking, Telekommunikation, Versicherungen und Healthcare zusammengetragen – fünf davon sind bereits live.

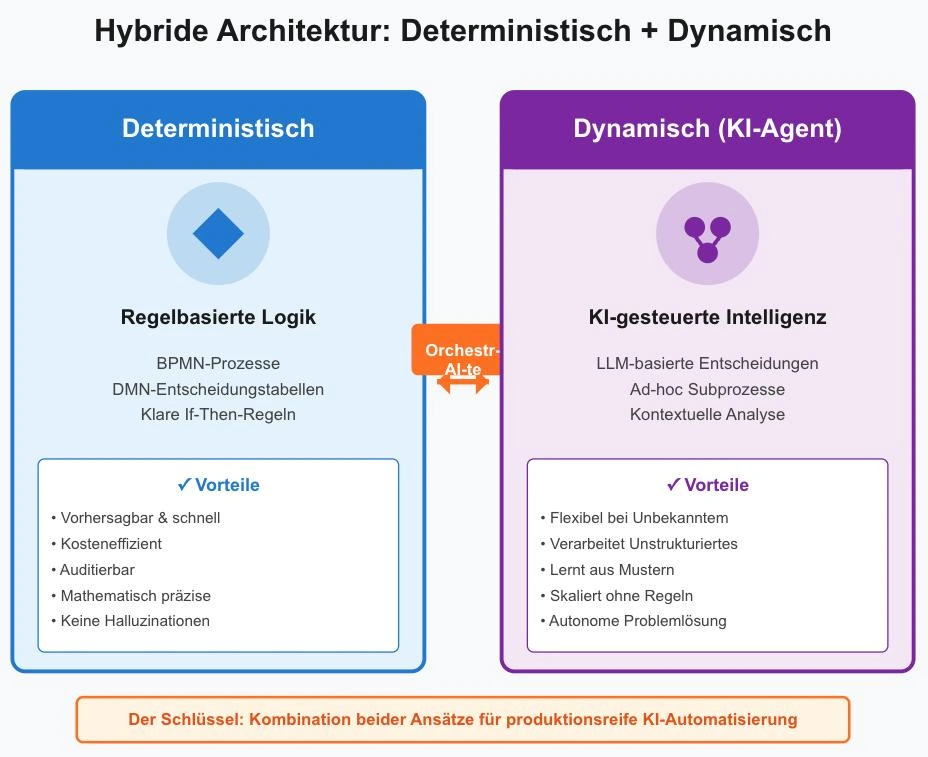

Die zentrale Erkenntnis: Agentenbasierte Orchestrierung funktioniert nur mit hybrider Architektur. BPMN-Prozesse und DMN-Entscheidungstabellen bilden das deterministische Fundament, während LLM-gesteuerte Agenten die dynamische Intelligenzschicht für unstrukturierte Probleme übernehmen.

Der perfekte Use Case für KI-Agenten (und wo sie scheitern)

Nicht jeder Prozess benötigt einen KI-Agenten. Enterprise-KI-Agenten entfalten ihren wahren Wert dort, wo es keine deterministische Lösung gibt – also dort, wo wir nicht im Voraus programmieren können, was als Nächstes passieren soll.

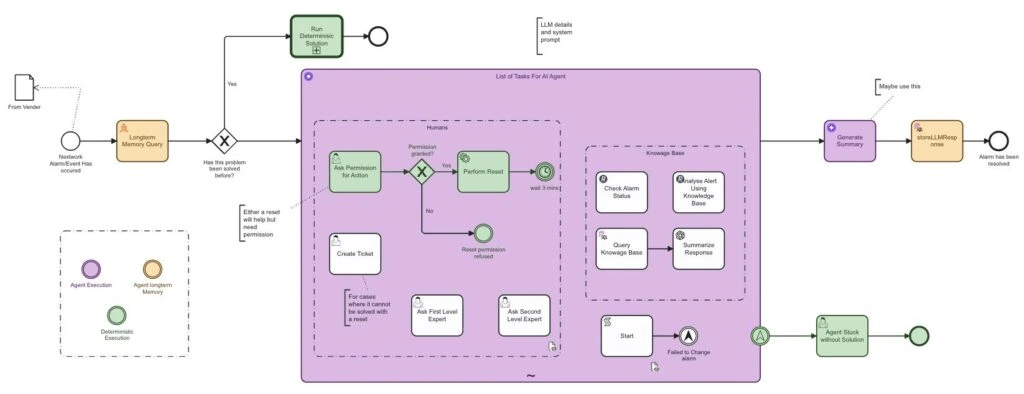

Automatisierter technischer Support in der Telekommunikation

Ein Paradebeispiel aus unserem Projekt ist der automatisierte technische Support eines Telekommunikationsanbieters. Hier prasseln hunderte verschiedene Fehlercodes pro Minute auf das System ein. Früher war dies eine Sisyphusarbeit für menschliche Teams. Heute übernimmt ein orchestrierter KI-Agent die Analyse unbekannter Fehler, schlägt Lösungen vor und lernt dabei. Das Ergebnis: Eine Reduktion des manuellen Aufwands um 80 Prozent.

Trade Reconciliation im Finanzwesen

Ein zweiter, kritischer Bereich ist die Bewertung und Anreicherung komplexer Daten, etwa im Finanzhandel („Trade Reconciliation“). Hier müssen unstrukturierte Daten gegen strikte regulatorische Fristen (T+1) geprüft werden. Unser Kunde konnte durch den Einsatz von Agenten, die Daten validieren, aber nicht eigenständig ändern dürfen, die Verzögerungen über die regulatorische Deadline hinaus um 98 Prozent senken.

Wann Sie KEINE KI-Agenten einsetzen sollten

Verwenden Sie KI niemals für Aufgaben, die deterministisch lösbar sind. Wenn es eine klare Regel gibt, nutzen Sie diese. Ein LLM (Large Language Model) ist beispielsweise notorisch schlecht in Mathematik.– KI-Halluzinationen bei Berechnungen sind ein echtes Risiko.

In einem unserer Use Cases im Finanzbereich haben wir daher strikt getrennt: Der Agent analysiert unstrukturierte Dokumente, aber die mathematische Validierung übernimmt eine klassische DMN-Entscheidungstabelle (Decision Model and Notation). Das verhindert Halluzinationen bei Berechnungen und sichert die Auditierbarkeit – ein kritischer Faktor für Compliance und DSGVO-Konformität.

Enterprise-KI-Agenten aufbauen – Drei Schritte zur Produktionsreife

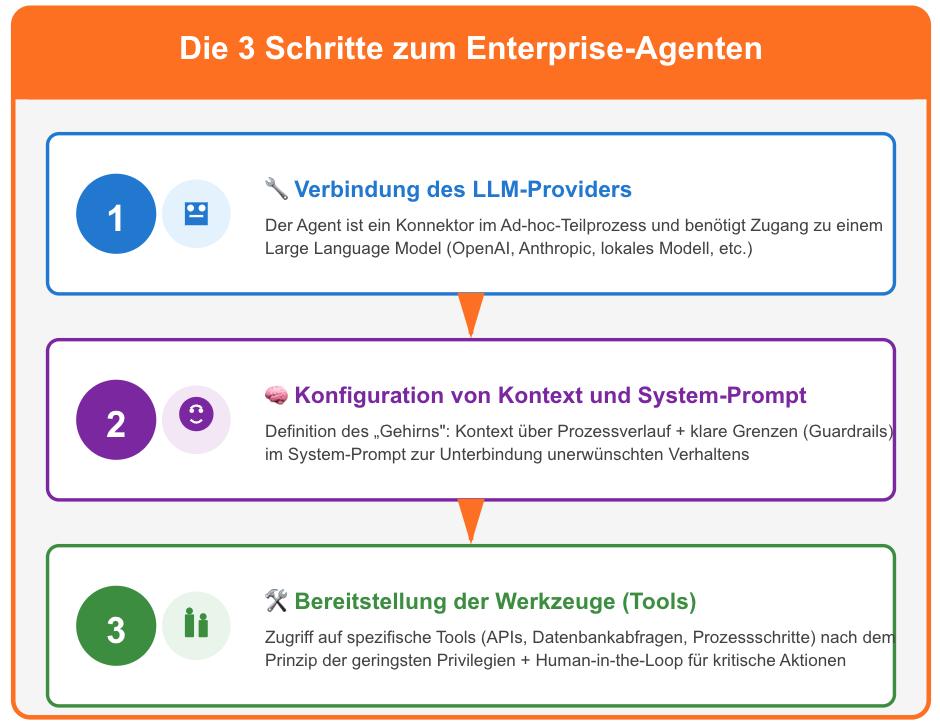

Viele CTOs fragen mich: „Ist das nicht zu komplex für meine bestehende Architektur?“ Die Antwort ist nein, wenn man dem richtigen Muster folgt. In Camunda haben wir ein Muster etabliert, das auf dem BPMN-Standard (Business Process Model and Notation) aufbaut, konkret dem „Ad-hoc Subprozess“. Die Konfiguration eines produktionsreifen Agenten folgt dabei im Wesentlichen drei unerlässlichen Schritten:

Schritt 1: Verbindung des LLM-Providers

Der Agent ist technisch gesehen ein Konnektor in einem Ad-hoc-Teilprozess. Er benötigt Zugang zu einem LLM, sei es von OpenAI, Anthropic oder einem lokalen Modell.

Schritt 2: Konfiguration von Kontext und System-Prompt

Hier definieren wir das „Gehirn” des Agenten. Wir geben ihm Kontext über den bisherigen Prozessverlauf und setzen klare Grenzen (Guardrails) direkt im System-Prompt, um unerwünschtes Verhalten zu unterbinden.

Schritt 3: Bereitstellung der Werkzeuge (Tools)

Ein Agent ohne Werkzeuge ist nur ein Chatbot. Wir geben dem Agenten Zugriff auf spezifische Tools — das können APIs, Datenbankabfragen oder sogar andere Prozessschritte sein. Wichtig ist hier das Prinzip der geringsten Privilegien: Geben Sie dem Agenten nur Zugriff auf Tools, die er wirklich benötigt, und schalten Sie kritische Aktionen (wie das Zurücksetzen eines Geräts oder eine Überweisung) hinter eine menschliche Genehmigung („Human in the Loop“). Dies gewährleistet Kontrolle und minimiert Risiken in der Prozessautomatisierung.

ROI erfassen und optimieren – Der Lernzyklus

Der vielleicht spannendste Aspekt von „Project Orchestr-AI-te“ war die Erkenntnis, wie sich der ROI (Return on Invest) über die Zeit verändert.

Phase 1: Initiale Kosten und Agilität

Zu Beginn nutzen wir den Agenten, um Fälle zu lösen, für die wir keine Lösung haben. Das ist teuer, da jeder LLM-Aufruf Kosten verursacht — aber notwendig, um überhaupt voranzukommen. In dieser Phase liegt der Fokus auf Lernfähigkeit, nicht auf Effizienz.

Phase 2: Der Übergang — Vom KI-Muster zur deterministischen Regel

Der wahre ROI entsteht jedoch durch das Lernen aus dem Agenten. Wenn der Agent ein Problem zehnmal auf die gleiche Weise gelöst hat, können wir dieses Muster erkennen und in eine deterministische Regel (z. B. in BPMN oder DMN) überführen. Dieser Übergang ist der Schlüssel zur Skalierung: Aus dynamischer KI-Intelligenz wird effiziente Regellogik.

Phase 3: Skalierbare Automatisierung und sinkende Kosten

Das senkt nicht nur die Kosten für LLM-Token drastisch, sondern erhöht auch die Geschwindigkeit und Vorhersagbarkeit. Wir nutzen die KI also nicht nur als Arbeiter, sondern als Architekt unserer zukünftigen Automatisierung. Unsere Kunden berichten von Kostensenkungen um bis zu 70 Prozent nach erfolgreicher Musteridentifikation.

Vertrauen durch Orchestrierung

Die Angst vor dem „Black Box“-Charakter der KI ist, gerade in regulierten Branchen, real und berechtigt. Unsere Projekte im Gesundheitswesen und im Banking haben gezeigt, dass wir KI-Agenten nur dann vertrauen können, wenn sie in einem „Orchestrierungs-Käfig“ operieren.

Indem wir die KI in einen BPMN-Prozess einbetten, behalten wir die volle Transparenz (Auditability). Wir wissen jederzeit, welches Tool der Agent wann und warum genutzt hat. Wir können menschliche Validierungsschritte einbauen, bevor Daten geändert werden, und wir können Datenhaltung und Entscheidungsfindung sauber trennen. Diese Governance-Architektur ist essentiell für DSGVO-Compliance und regulatorische Anforderungen.

Der Weg vom Prototyp zur Produktion führt nicht über mehr Autonomie für die KI, sondern über bessere Integration in menschliche und deterministische Workflows. Das ist die Essenz von agentenbasierter Orchestrierung: Die Kombination aus deterministischer Orchestrierung – „klassisch” über DMN und Co. – und dynamischer Orchestrierung, bei der das LLM Entscheidungen zur Ausführung trifft.

Sie möchten mehr über Orchestr-AI-te und die Learnings aus den 50 Kundenprojekten erfahren? Sehen Sie sich hier das Webinar an.