Wie sollen normale Unternehmen oder Hosting-Anbieter den Anforderungen einer vollständig IoT-vernetzten Welt gerecht werden, wo sie doch schon jetzt allein mit den durch Mobilität, soziale Medien und Big Data erzeugten Datenmengen zu kämpfen haben?

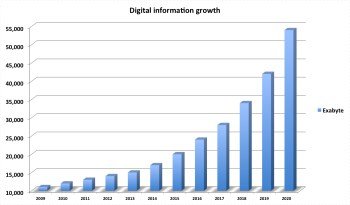

Wie jeder weiß, wächst das Datenvolumen exponentiell an. Prognosen des Analyseunternehmens IDC zufolge wird das digitale Universum, das Milliarden neuer, dauerhaft mit dem Internet verbundener IoT-Geräte umfasst, bis 2020 auf über 50.000 Exabyte, d. h., auf mehr als 5.200 Gigabytes pro Erdbewohner, anwachsen. Außerdem sagt IDC voraus, dass sich das digitale Universum ab jetzt bis 2020 alle zwei Jahre verdoppeln wird. Daraus ergeben sich natürlich wichtige Fragen: Wo werden all diese Daten untergebracht? Wie sollen sie verwaltet werden?

Die Daten werden in der Cloud abgelegt – doch wie kann die Datenflut bewältigt werden?

In den kommenden fünf Jahren erwarten CIOs ein Workload-Wachstum von bis zu 44 Prozent in der Cloud, im Vergleich zu einer Zunahme von nur 8,9 Prozent bei lokalen EDV-Workloads. Es kann also davon ausgegangen werden, dass im Laufe der Zeit immer größere Datenmengen in der Cloud gespeichert werden. Dies setzt Hosting-Unternehmen unter Druck, Systeme bereitzustellen, die einfach zu verwalten, flexibel und vor allem stark skalierbar sind.

Schon heute verwalten große Hosting-Anbieter wie die koreanische Telekom Umgebungen mit über 100 Petabytes, die in nicht allzu ferner Zukunft auf mehrere Exabytes angewachsen sein werden. Die Kunden solcher Hoster sind anspruchsvoll und verlangen unverzüglich Zugriff auf Daten. Es wird also nicht nur entscheidend sein die Daten kostengünstig speichern zu können, auch die Leistung muss stimmen. Angesichts der exponentiell wachsenden Datenmenge stellt dies schon jetzt eine Herausforderung für Hosting-Unternehmen dar. Die zusätzlichen Daten, die das IoT diesem Berg hinzufügt, wird Hosting-Anbieter dazu zwingen, ihre derzeitige Infrastruktur zu überdenken.

Die Rettung für Hoster: das Software-definierte Rechenzentrum

Der Datenberg wächst nicht erst seit heute und schon lange ist man auf der Suche nach dem Heiligen Gral der Unternehmens-IT, dem Software-definiertem Rechenzentrum (Software-Defined Data Center, SDDC). In diesem sollen alle Schichten des Rechenzentrums, Server-, Netzwerk- und Speicherebene, auf ein Softwareniveau gehoben werden, was den bisherigen Hemmschuh alter unflexibler Systeme beseitigen soll. Auf der Serverebene existieren bereits Lösungen, die den Server-Markt revolutioniert haben. VMware war hier der Vorreiter und der Ansatz Hardware zu virtualisieren ist heute fast umfassend umgesetzt. Software-Defined Networking folgt erst noch, da es komplexer ist als seine Geschwister Server und Speicher. Auch die Technologie, die unflexible und kostspielige Legacy-Storage-Lösungen überflüssig macht, ist bereits vorhanden und hat bereits jetzt Auswirkungen auf IT-Budgets, die bislang vor allem durch Speicher in die Höhe getrieben wurden.

Um die Speicherkomponente anzugehen, werden Hosting-Anbieter die Vorteile von Software-Defined Storage (SDS) nutzen müssen. SDS unterstützt bereits heute tausende Anbieter dabei wettbewerbsfähig zu bleiben. Hoster, die Trends wie das Internet der Dinge mit seinen exorbitanten Datenmengen nicht verschlafen wollen, werden sich besser früher als später diesen Modell anschließen müssen.

Dabei gilt es jedoch zu unterscheiden: Bei echten SDS-Lösungen handelt es sich um flexible, einfache und leistungsfähige Lösungen der Enterprise-Klasse ohne Anbieterabhängigkeit. SDS-Technologie wird auf Industriestandards entsprechender Hardware implementiert, statt an teure proprietäre Modelle gebunden zu sein. Anbieter von Legacy-Systemen haben bereits marketingtechnisch aufgerüstet und ihre Hardware-basierten Geräte einfach in „Software-basiert“ umgetauft.

SDS wird Hosting-Anbietern die Flexibilität geben die richtige Lösung sowohl für neue Umgebungen als auch für Legacy-Umgebungen auszuwählen. Mit einem Preis, der oftmals 50 bis 80 Prozent unter dem für proprietäre Modelle liegt, verfügen Anbieter nun über ein Tool zur Bewältigung der Datenexplosion auf elegante – und kostengünstige – Weise. Um Entwicklungen wie dem Internet der Dinge Rechnung zu tragen, sollten Hosting-Anbieter sich klar darüber werden, dass SDS-Lösungen zukünftig in ihre Infrastruktur-Roadmap gehören.

Jill Orhun, Vice President Marketing & Strategy bei Nexenta

Lesen Sie hierzu auch das Whitepaper: Paradigmenwechsel: Software Defined Storage