Ein Unternehmen kann nur schützen, was es sehen kann – Transparenz ist also ein entscheidender Erfolgsfaktor für Security. Mit der wachsenden Beliebtheit der Cloud gehen Fachabteilungen allerdings immer häufiger dazu über, sich eigenverantwortlich die benötigten Ressourcen zu beschaffen. Zunächst ist die Online-Buchung von Servern und Rechenleistung per Klick die einfachste und schnellste Lösung. Doch dieses Vorgehen bringt auch Gefahren mit sich.

Themen wie Compliance, Security, Ausfallsicherheit und viele mehr können durch die IT-Verantwortlichen nicht gewährleistet werden, wenn sie nicht wissen, woraus die eigene Infrastruktur besteht. Und selbst wenn der CIO einen umfassenden Public-Cloud-Ansatz verfolgt, der alle Abteilungen mit den notwendigen Ressourcen versorgt, wird der Einblick in die dahinterliegende Hardware durch die Anbieter komplett untersagt. Das Ergebnis: ein gefährlicher Blindflug. Wie Data Visibility auch in dynamischen Strukturen möglich wird und für Stabilität, Transparenz und einen effizienten Betrieb sorgt, zeigt Dr. Ulrich Müller, Sprecher der Geschäftsführung der operational services GmbH & Co. KG (OS).

Visibility Fabric im eigenen Rechenzentrum

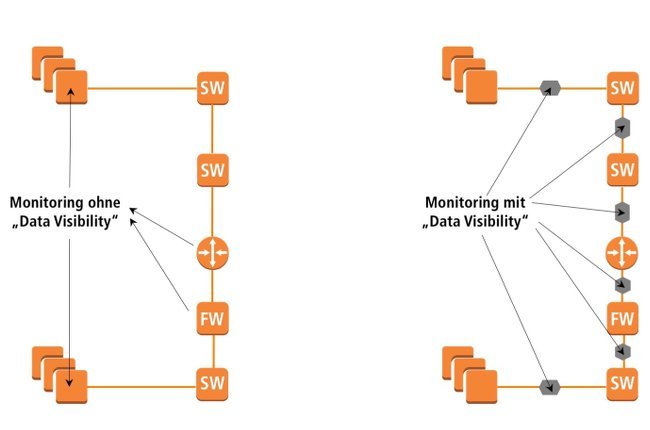

Schon in einer Infrastruktur, die vollständig im eigenen Unternehmen angesiedelt ist und über die die IT-Abteilung die absolute Entscheidungshoheit und den vollen Zugriff hat, ist die Umsetzung von Data Visibility nicht trivial. Im klassischen Monitoring werden punktuell einzelne Komponenten – beispielsweise Server oder bestimmte Netzwerkgeräte – überwacht. Dadurch haben die IT-Verantwortlichen haben keine durchgängige Kontrolle über die zu analysierenden Datenströme. Darüber hinaus ist die Zeitsynchronisation von Fehlermeldungen in der Verarbeitungskette nicht garantiert, da diese aus unterschiedlichen Informationsquellen stammen. Diese „blinden“ Punkte führen dazu, dass der Gesamtüberblick über alle Details innerhalb der Infrastruktur nicht gegeben ist und Störungsverursacher häufig gar nicht oder nur verzögert identifiziert werden können. Wesentliche Informationen fehlen und es gibt kein solides Fundament für ein übergreifendes Security-Konzept.

Im Vergleich mit der Beobachtung des Verkehrs auf einer Autobahn wird das Dilemma schnell klar: Misst man den Verkehrsfluss an jedem Autobahnkreuz, erhält man kein realistisches Bild von der tatsächlichen Situation auf der gesamten Strecke, weil die Informationen aus den Teilstücken zwischen den Messpunkten fehlen. Fließt der Verkehr an den jeweiligen Autobahnkreuzen, heißt das in der Realität noch lange nicht, dass es auch dazwischen keine Staus gibt. Erst wenn die Messungen beispielsweise an jeder Auf- und Abfahrt durchführt werden, wird das Gesamtbild klarer und eine solide Verkehrsüberwachung möglich. In der IT heißt dieser Ansatz Visibility Fabric: Statt der Netzwerkkomponenten werden die Datenströme vor und hinter jeder aktiven Komponente beobachtet und analysiert.

Auf diese Weise entsteht Data Visibility, also die ganzheitliche Sicht auf Verarbeitungsketten. Durch die effiziente Aufbereitung der so gewonnenen Daten können Störungsverursacher schnell und konkret identifiziert werden, der Betrieb wird insgesamt stabiler und die Kosten sinken, weil Ausfälle vermieden und Störungen schneller behoben werden. Der einmalige Aufwand zur Implementierung eines solchen Monitorings zahlt sich schnell aus, wenn der gesamte Betrieb zukünftig effizient und nahezu störungsfrei läuft. Bisher wird die Visibility Fabric insbesondere von großen Unternehmen eingesetzt sowie von Firmen, die in einem sehr spezialisierten Gebiet arbeiten. Beispielsweise überwachen Mobilfunkanbieter auf diese Art ihre Netze und der Bankenhandel behält jederzeit volle Transparenz über zeitsensitive Transaktionen auf dem Finanzmarkt.

Data Visibility in der Cloud

Im eigenen Rechenzentrum hat die interne IT vollen Zugriff auf alle Komponenten. Doch der Trend geht in Richtung Cloud: Unternehmen wollen von der agilen Umgebung profitieren und flexibel Ressourcen zu- und abschalten, wie sie gerade gebraucht werden. Doch immer dann, wenn die zugrundeliegende Infrastruktur nicht mehr in der alleinigen Kontrolle des jeweiligen Betriebes liegt, sondern die Verantwortung für die zugrundeliegende Infrastruktur mit dem Cloud-Betreiber geteilt ist, entstehen erhebliche Herausforderungen für Data Visibility. Das gilt für Public Clouds ebenso wie für einige Private-Cloud-Angebote. Der Zugriff auf Netzwerk, Verschlüsselung, Betriebssystem, Firewall, Plattform und Identity & Access Management ist bei der Nutzung geteilter Infrastrukturen erheblich eingeschränkt – ein Albtraum für den CIO, der die Verantwortung für Security und Compliance trägt.

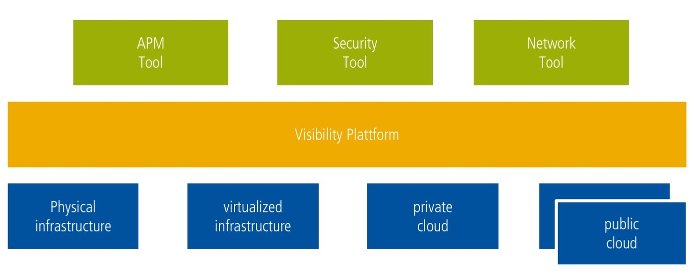

Wieder entstehen die gleichen Herausforderungen, die es schon im eigenen Rechenzentrum ohne Visibility Fabric gab: punktuelle Analyse, keine durchgängige Sicht auf die Datenströme und somit nur unvollständige Informationen sowie keine gesicherte Zeitsynchronisation. Die Lösung für diese Herausforderung ist eine professionelle Visibility Plattform. Diese entkoppelt die Infrastruktur von den Analysetools und schafft so eine einheitliche Basis für mehr Transparenz, Stabilität und Performance. Die entstehende standardisierte Betriebsumgebung erhöht die Effizienz, wobei wertvolle Tools, Prozesse sowie Wissensschätze erhalten bleiben auch wenn die IT sich weiterentwickelt und Teile der Infrastruktur in die Cloud transferiert werden.

Der ICT-Provider operational services hat dieses Konzept bereits im Rahmen eines Proof of Concept gemeinsam mit dem Technologie-Experten Gigamon praktisch umgesetzt: Die Handelsplattform einer großen deutschen Finanzorganisation wurde mit der Public Cloud verbunden, um dort mit flexiblen Ressourcen und der benötigten Agilität Handelssimulationen durchzuführen. Um die Sichtbarkeit der Datenströme nachzuweisen, wurden diese innerhalb der Cloud-Umgebung erhoben, aggregiert und zur Analyse an ein externes „Security Grid“ weitergeleitet. Das zentrale Kernelement der Visibility Plattform ist die intelligente Aggregation der Daten, um diese optimal für die weitere Verarbeitung aufzubereiten und die Kosten für den Transfer aus der Public Cloud zu minimieren. Parallel genutzte Programme für Security und Application Performance Management können so ideal mit den Informationen arbeiten, ohne miteinander in Konflikt zu geraten, da alle Daten aus einer zentralen Quelle bereitgestellt und nicht mehrfach bzw. Tool-spezifisch erhoben werden müssen.

Der Weg zu mehr Durchblick

Für die Einführung einer Visibility Plattform starten CIOs idealerweise mit einem Solution Workshop. In diesem Schritt analysiert ein erfahrenes Beraterteam die aktuelle Infrastruktur und erstellt auf dieser Basis eine Übersicht über den Status Quo. Darüber hinaus besprechen die externen Experten die zukünftige Strategie mit dem jeweiligen Unternehmen und helfen auf diese Weise dabei, einen transparenten Einblick in sämtliche Infrastrukturen zu erhalten. An dieser Stelle wird meist schnell klar, ob und in welchem Umfang Data Visibility dabei helfen kann, die gesteckten Ziele zu erreichen, sodass die Berater einen entsprechenden Lösungsvorschlag für sinnvolle Maßnahmen erstellen können. Dabei bietet es sich an, zwei bis drei verschiedene Optionen hinsichtlich technischer und finanzieller Aspekte zu beurteilen und dann den individuell passenden Weg zu wählen. Auf Basis dieser Entscheidung kann dann ein Konzept zum Roll-Out erstellt und die Installation durchgeführt werden. So gelingt der Weg zu mehr Durchblick in der Cloud – für Stabilität, Transparenz und einen effizienten Betrieb.