Sensoren, Maschinenlogs, SAP-Daten, Remote-Plattformen oder andere Quellen liefern jeden Tag enorme Datenmengen. Sie bleiben häufig ungenutzt. Die Herausforderung ist es, diese Big Data so aufzubereiten, dass man daraus Werte schaffen kann – auf der Kosten-, der Risiko- und vor allem der Wachstumsebene.

Verborgene Schätze

Die Erkenntnis, dass Datenanalysen in allen relevanten Bereichen eines Unternehmens einen Mehrwert bieten können, hat sich inzwischen bei den meisten Organisationen durchgesetzt. Es geht z.B. darum, Fehler frühzeitig zu erkennen, vor Geschäfts- und Marktrisiken zu warnen, das Geschäftsmodell um neue datengetriebene Services zu erweitern oder die Qualität in der Produktion zu verbessern. Doch wie lassen sich die verfügbaren Massendaten transformieren und in strukturierte, intelligente Informationen, so genannte Smart Data, umwandeln? In welchen Prozessen steckt verborgenes Potenzial? Welche Methodik, welcher Anwendungsfall verspricht Erfolg? Welches Know-how und welche Tools werden benötigt? Sind diese im Unternehmen vorhanden oder sollte man die Expertise von spezialisierten Anbietern nutzen?

Daten und Datenanalysen unterstützen viele wichtige Unternehmensentscheidungen. Subjektive Entscheidungsfindungen auf der Grundlage von Erfahrung und Bauchgefühl werden immer häufiger durch objektive, datenbasierte Erkenntnisse ersetzt oder zumindest ergänzt. Es ist in der Praxis jedoch alles andere als trivial, aus Daten einen erkennbaren und planbaren Nutzen zu ziehen. Es kommt dabei auf die Menge der richtigen Daten, die darauf angepasste Analyse und besonders die qualitätsgesicherte Bedeutung an, um den Wert der extrahierten Daten flexibel für individuelle Einsatzszenarien auszuschöpfen.

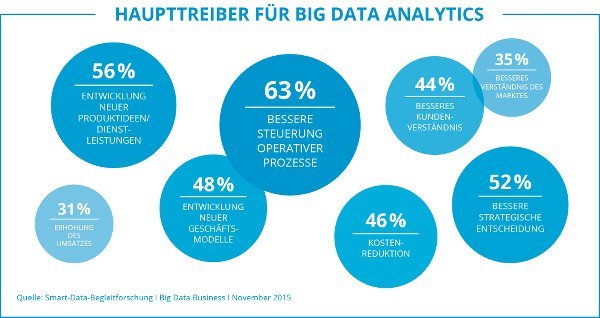

Bild: Mit 63% ist das Ziel, operative Prozesse besser steuern zu können, der wichtigste Treiber für Big Data Analytics, (Quelle: Smart-Data Begleitforschung, Big Data Business, November 2015.

Erfolgskritisch hierfür ist mathematisches Know-how, das in Kombination mit Expertenwissen über z.B. Druckmaschinen mittels komplexer Algorithmen bisher unentdeckte Informationen sichtbar macht. Hierbei ergänzen sich die datenbasierte Analyse eines Data Scientisten und das erfahrungsbasierte Know-how des Maschinenexperten, um die Bedeutung neuer Erkenntnisse qualitätsgesichert zu erarbeiten. Ob dies durch externe Unterstützung oder den Aufbau einer neuen Abteilung entsteht, hängt von 3 wesentlichen Faktoren ab: Kapazität, Zeit und Kosten. Nach dem Motto „Think big, start small, gain fast“ wird im Folgenden ein Ansatz skizziert, bei dem es mit externer Unterstützung gelingt, einen ersten Anwendungsfall rasch zu erarbeiten und umzusetzen – mit wenig Aufwand und geringen Kosten. Dies funktioniert in vier einfach zu erklärenden Schritten:

1. Use Case − was soll optimiert werden?

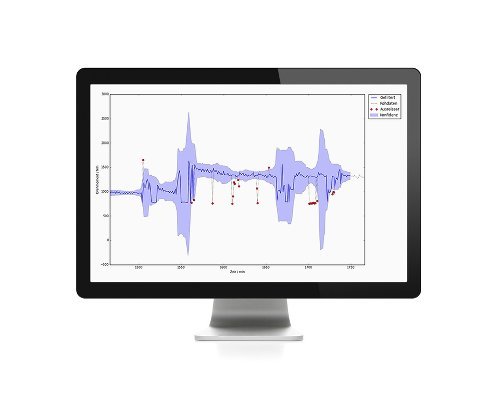

Der externe Data Scientist erarbeitet interaktiv mit dem Maschinen-Experten den ersten Use Case zur individuellen Verbesserung. Dies kann beispielsweise das Detektieren von anomalen zeitlichen Verläufen physikalischer Messgrößen sein. Oder das Auffinden von Korrelationen zwischen Ereignissen in Logdaten. In einem ersten Gespräch wird erörtert, welche Fehler oder Störungen datenbezogen gesichtet werden sollen und wo es Optimierungsbedarf gibt. Die anschließende Untersuchung und Begutachtung der Daten wird von Seiten dieses Teams beispielhaft aufgearbeitet und verfeinert. Das Ergebnis dieses wichtigen Schrittes ist die Business-Value-Definition unseres ersten Anwendungsfalls.

2. Prototyp − funktioniert es?

Nun folgt der Schritt der Datenvorbearbeitung: der Data Scientist bereitet die Daten speziell für den Anwendungsfall auf. Hierbei werden beispielsweise Offsets korrigiert und falsche Sensorwerte (Öltemperatur unter Null in einer beheizten Halle) eliminiert. Dies ist insbesondere wichtig, um ungewünschte Seiteneffekte in der anschließenden Analytics zu vermeiden. Jetzt entwickelt er den individuell angepassten Algorithmus, beispielsweise aus den Bereichen des maschinellen Lernens oder der kognitiven Intelligenz. Muster, Unregelmäßigkeiten und Ausreißer werden somit identifiziert und bislang unbekannte Kausalzusammenhänge aufgezeigt. Die Basis zur Optimierung ist jetzt geschaffen.

3. Umsetzung − ab in die Praxis!

Es folgt die Transformation auf die Big Data-Plattform. Dazu migriert der Data Engineer den prototypisch entwickelten Algorithmus, so dass dieser performant und zuverlässig auch auf große Datenmengen angewandt werden kann. Durch die abschließende Integration in die Wertschöpfungskette wird das in Schritt eins festgelegte Ziel erreicht. Neue Geschäftsmodelle entstehen sehr oft dadurch, dass Daten, die ohnehin in Massen verfügbar sind, in einen neuen Kontext gestellt und auf neuartige Weise verknüpft werden. So kann man beispielsweise durch Peer-Group- Vergleiche erkennen, wo der Wertstromprozess verbessert werden kann. Dabei ist es notwendig, die Topentscheider einzubinden, denn die Strategie muss sich nach den Firmenzielen richten – und diese werden von der obersten Ebene ausgegeben.

4. Anwendung − Gewinn einholen!

Die Wertschöpfung wird erst dann realisiert, wenn die Zielgruppe den gewählten Anwendungsfall als erfolgreich annimmt. Und genau so entstehen gewinnbringende Smart Services: Beispielsweise ist der Servicebereich durch Predictive Maintenance jetzt in der Lage, frühzeitig Fehler zu erkennen und dadurch eine proaktive Handlungsempfehlung auszusprechen. Diese führt unmittelbar zur Steigerung der Produktivität und Risikominimierung. Oder mittels Peer-Group-Vergleich konnte die Basis geschaffen werden, einen Beratungsansatz zur Performance-Steigerung anzubieten, mit dem Ziel der Effizienzsteigerung des Wertstromprozesses und Qualitätsverbesserung in der Produktion. Hierbei sind aus der Erfahrung heraus durchaus Steigerungen von 40% OEE (Overall Equipment Effectiveness) erreichbar. Um das Gesamtziel zu erreichen, erarbeitet das Team auf diese Weise sukzessive Use Case für Use Case. Und durch Know-how-Transfer entsteht – quasi als Nebeneffekt – die neue interne Abteilung für Big Data Analytics.

Lessons Learned

Neue Smart Services müssen implementiert werden und sich etablieren. Wichtig bei der Integration in die Wertschöpfungskette ist es, das Unternehmen auf den neuen Anwendungsfall vorzubereiten. Dabei kommt es sowohl darauf an, den Menschen mitzunehmen, dessen Arbeitsumfeld sich verändert, als auch, die Strukturen und Strategien in Vertrieb und Marketing anzugleichen.

Keyfacts über Big Data Analytics

- Neue Marktgesetze: „schnell gegen langsam“ ersetzt „groß gegen klein“

- Alleine oder durch externe Unterstützung hängt ab von: Kapazität, Zeit und Kosten

- Agiles Vorgehen durch Erarbeitung und Umsetzung von klar definierten Use Cases

- Auf dem Markt schnell mit wenig Aufwand erste Erfolge zeigen und testen

- Erfolg entsteht durch Technik, Mensch und Wandel innerhalb des Unternehmens

- Jetzt beginnen