Für unterschiedliche Speicheranforderungen gibt es verschiedene Strategien: Speicher als verteilte Ressource, als dediziertes Speichernetzwerk oder im Direktanschluss mit dem Server verbunden. Sicher ist keine allein heilsbringend, aber für bestimmte Umgebungen und/oder im Mix eine Option, den IT-Herausforderungen zu begegnen.

Unternehmensspeichers gehen allerdings heute weit über alltägliche Anforderungen hinaus und bestimmen damit die Speicherstrategie und Architektur der Firma. Das zuständige Personal muss sich um immer mehr vorher nicht gekannte Bedrohungen kümmern, die von »einfachen« Bedrohungen über das Netzwerk bis hin zu terroristischen Akten, Ransomware oder Industriespionage gehen. Backup- und Recovery-Pläne sind heute so essenziell, dass jegliche Speicherlösung die Grundlage hierfür bietet und niemand mehr viele Worte darüber verliert.

Unternehmen sehen sich darüber hinaus seit Jahren einer Welle von Regularien im juristischen und Compliance-Bereich ausgesetzt, welche das Speichern, die Verwaltung und die Archivierung von Daten lenken wollen, die Europäische Datenschutz-Grundverordnung (DSGVO) ist nur eine davon. Vor allem die Finanz-, Versicherungs- und Gesundheitsbereiche gehen mit sensitiven Informationen um und haben damit eine erweiterte Verantwortung, Daten integer und geschützt zu speichern.

SAN, NAS, DAS: Fünf Fragen zur Entscheidungsfindung

Obwohl die Notwendigkeit für größere Speicherlösungen nicht mehr diskutiert werden muss, ist nicht immer sofort klar, welche Art von Systemen bzw. Architekturen in einer bestimmten Umgebung anzuwenden sind. Der Entscheider steht vor einer Vielzahl von Angeboten. Die bewährtesten Speicherarchitekturen sind Storage Area Networks (SAN), Network Attached Storage (NAS) oder Direct Attached Storage (DAS). Der Anwender kann aber eben einer für seine Umgebung passende Kombination aus diesen nutzen. Für eine Entscheidung müssen vorab einige Kriterien geklärt und deren kurz- und langfristige Entwicklung im Unternehmen betrachtet werden:

1. Kapazität und Skalierbarkeit

Der Administrator muss das Volumen definieren, welches die momentan vorhandenen Daten insgesamt auf ihren bestehenden Speicherorten belegen. Hierzu gehört auch die Betrachtung, um welchen Faktor dieses Volumen in den letzten Jahren zugenommen hat und um welchen es in den kommenden Jahren zunehmen wird. Erst diese Kapazität ist ausschlaggebend für die Planung der anzuwendenden Strategie und des Systems. Dabei sollten IT-Manager auch Schwankungen mit in Betracht ziehen: Bei Entwicklungsarbeiten entstehen beispielsweise über einen kurzen Zeitraum mehr Daten als sonst. Ist das Projekt abgeschlossen, werden eventuell nicht mehr alle Daten benötigt. Deswegen muss eine Skalierung sowohl nach oben als auch nach unten machbar sein.

2. Leistung

Darüber hinaus muss der IT-Manager wissen, welche Menge an Daten das System schreibend und lesend bewältigen können muss. Auch hier sollte nicht nur der momentane Zustand, sondern auch die Datenmenge zum Schluss der Nutzung und die dann vorhandene Anzahl abfragender Systeme eine Rolle spielen. Die Leistungsanforderungen sind ein entscheidender Faktor für die Entscheidung, welche Speicherarchitektur zum Einsatz kommen soll.

3. Verfügbarkeit

Eine Kernfrage ist die Verfügbarkeit der Daten. Dabei muss bestimmt werden, welche Daten stets im Zugriff stehen müssen und welche eventuell weniger wichtig sind. Daraus ergibt sich, ob eine Hochverfügbarkeits-Lösung, hoch zuverlässige Systeme, fehlertolerante oder Desaster-tolerante Geräte zum Einsatz kommen müssen. Hier geht es grundsätzlich um die tolerierte Länge eines Ausfalles. Während 99,9 Prozent noch fast neun Stunden bedeuten, ist dieser bei 99,999 Prozent nur noch gut fünf Minuten und bei 99,9999 Prozent gar nur noch 30 Sekunden lang.

4. Datenschutz und Replikation

Auch über die benötigten Schutzmaßnahmen, beispielsweise RAID und andere, sollte sich der EDV-Verantwortliche im Klaren sein. Dabei spielen die Vorgaben für Wiederherstellungszeiten, Reaktionszeiten für den Kundendienst des Herstellers und interne SLAs eine Rolle. Hier muss die Entscheidung getroffen werden, ob Failover-fähige Architekturen und Systeme notwendig sind.

Recovery-Point-Objectives (RPO) und Recovery-Time-Objectives (RTO) sind hier wichtige Kernpunkte. Diese Kriterien bestimmen, wie lange ein Ausfall dauern darf und welches Maximum an Datenverlust verkraftbar ist. Für den Datenschutz müssen Tools auf der jeweiligen Architektur verfügbar sein, die Automatismen, Sicherheitsscans und Schutzmechanismen zur Verfügung stellen.

5. Finanzen

Nicht zuletzt ist das Budget für die Anschaffung und die Wartung des neuen Speichersystems über die geplante Nutzungsdauer zu betrachten und mit in die Planung einzubeziehen. Während eine einzige Art von Speicherlösung für kleine und mittlere Unternehmen in den meisten Fällen ausreichend ist, entscheiden sich große Unternehmen meist für die Nutzung mehrerer Typen zur Lösung der Anforderungen unterschiedlicher Abteilungen plus kleinere Systeme in entfernten Niederlassungen.

Aber welche Art von Speicherumgebung, SAN, NAS oder DAS erfüllt nun welche Anforderungen und ist damit die passende für entsprechende Bereiche?

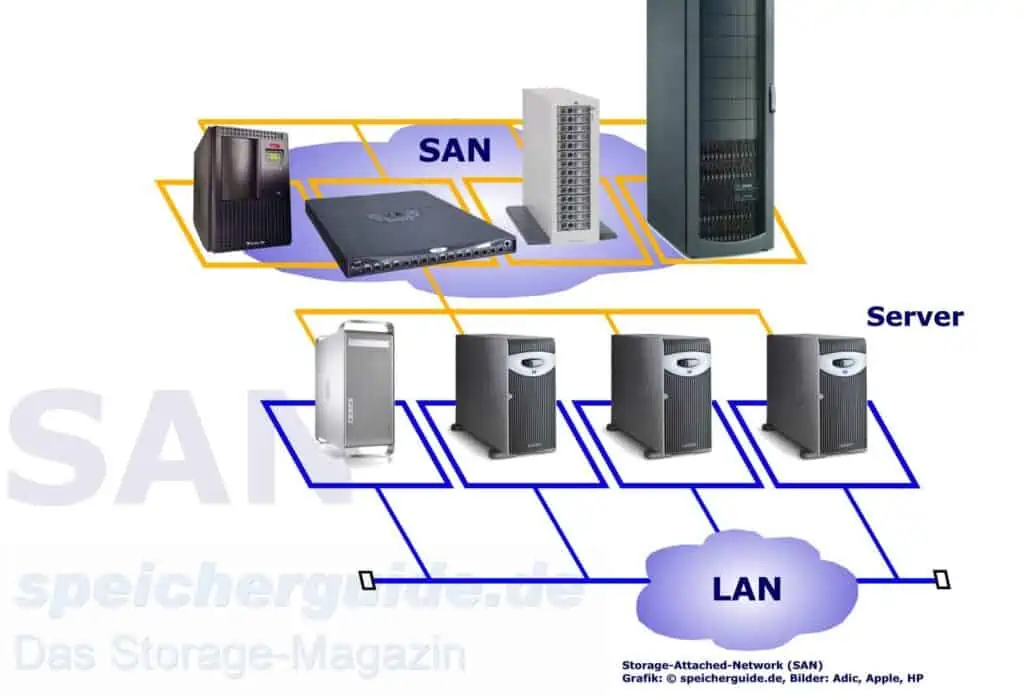

Dediziertes Netzwerk: Storage-Area-Networks

Ein Storage-Area-Network oder kurz SAN ist ein separates Netzwerk, welches ausschließlich für den Transport von zu speichernden oder aus Speichern gelesenen Daten vorgesehen ist. Diese heute technisch sehr fortgeschrittenen Netzwerke mit ihrer hohen Komplexität in Technik und Verwaltungsaufwand sowie den dadurch entstehenden Kosten werden SANs vor allem in geschäftskritischen Umgebungen größerer Unternehmen eingesetzt. Das im SAN eingesetzte Protokoll Fibre-Channel (FC) verbindet Platten-, Flash- und Bandspeicher mit den hier implementierten Rechnern. Die gängigste Implementierung von Fibre-Channel ist 32 Gbit, obwohl auch 64-Gbit-HBAs verfügbar sind und Hersteller Switch-Geschwindigkeiten von bis zu 128 Gbit anbieten.

Bei den Glasfaservarianten liegen die Übertragungsgeschwindigkeiten bei 100 bis 400 MByte/s. Die Verbindungen im SAN werden größtenteils dual und gekreuzt, also über zwei unabhängige Wege vom Speicher zum Rechner ausgeführt, so dass alle beteiligten Komponenten ausfallen können, ohne den Zugriff auf die gespeicherten Informationen zu beeinträchtigen. Im Gegensatz zu den limitierten Distanzen vor allem bei SCSI und SAS können FC-Verbindungen über mehrere hundert Kilometer mit hoher Bandbreite Daten übertragen.

SANs wurden vor allem eingeführt, um große Datenblöcke schnell und zuverlässig zu transportieren, getrennt vom Netzwerk nach außen. Dies ist vor allem wichtig, um bandbreitenhungrige Anwendungen wie Datenbanken, Data Warehousing oder Transaktionsumgebungen zu bedienen. Durch ihre verteilte Architektur bieten SANs wesentlich höhere Verfügbarkeit und Leistung als andere Ansätze. Workloads können dynamisch über alle verfügbaren Pfade geführt werden, so dass die Server mehr Daten transportieren und gleichzeitig die Reaktionszeiten verringern können. Eine große Anzahl von Nutzern kann gleichzeitig viele Daten bearbeiten, ohne das Local-Area-Network (LAN) und nicht beteiligte Server zu belasten.

In SANs lassen sich Leistung und Last sehr gut vorhersagen, kontrollieren und verwalten. Dadurch entsteht eine Verfügbarkeit von mindestens 99,99 Prozent (weniger als eine Stunde Ausfall pro Jahr) und entsprechende Zuverlässigkeit. Dies ist vor allem für Unternehmen wichtig, die gegenüber ihren Kunden oder Nutzern allgegenwärtig sein wollen oder gar müssen, zum Beispiel für Internet-Auftritte, e-Commerce oder andere entsprechende Anwendungen. Für SANs lassen sich wesentlich einfacher zuverlässige Service-Level-Agreements (SLAs) definieren und einhalten. SANs sind einfach und annähernd unbegrenzt skalierbar und auch damit gut für große und schnell wachsende Unternehmen geeignet. Im Gegensatz vor allem zu direkt angeschlossenen Speichern lassen sich Kapazitäten im SAN zusammenfassen und gemeinsam verwalten. Dies verbessert die Ausnutzung des vorhandenen Speicherplatzes deutlich.

Heute wird vor allem von Herstellerseite die Diskussion geführt, ob SAN oder NAS die ideale Lösung bei der Anschaffung neuer Systeme sei. Die Wahrheit liegt wie immer dazwischen. In letzter Zeit werden SANs fast überall parallel zu NAS-Systemen aufgebaut bzw. erweitert. Viele Hersteller gehen sogar den Weg, beide Zugriffsarten in »konvergente« Arrays zu integrieren und parallel zu betreiben.

Hier darf nicht vergessen werden, dass viele Cloud-Services diese Funktionalitäten bieten. Wer die Investitionen für die eigene Hardware scheut oder schlicht vermeiden möchte, kann entsprechende Cloud-Dienste nutzen. Bei all den beschriebenen Vorteilen von SANs verlangsamt sich deren Einführung oder Erweiterung zusehends. Vor allem die Kosten für eine völlig separate Infrastruktur und die immer noch hohe Komplexität bei der Verwaltung schrecken viele Anwender ab. Auch die vergleichsweise schnellere technische Entwicklung der Ethernet-Standards lassen Interessenten eher auf diese Seite schwenken. Daher wurde neben dem seit Jahren lahmenden iSCSI-Protokoll der neue FCoE-Standard (Fibre Channel over Ethernet) eingeführt. Mit seiner Hilfe lassen sich schon heute 10-Gbit/s-Ethernet-Verbindungen nutzen, in naher Zukunft sogar noch wesentlich breitere Verbindungen. Allerdings empfehlen die Hersteller auch für FCoE eigene dedizierte Verbindungen, so dass entweder größere Switches oder neue Infrastrukturen benötigt werden. Diese allerdings sind wesentlich einfacher aufzubauen als FC-Netze und können vor allem vom selben Personal betrieben werden wie das des LAN-Betriebes.

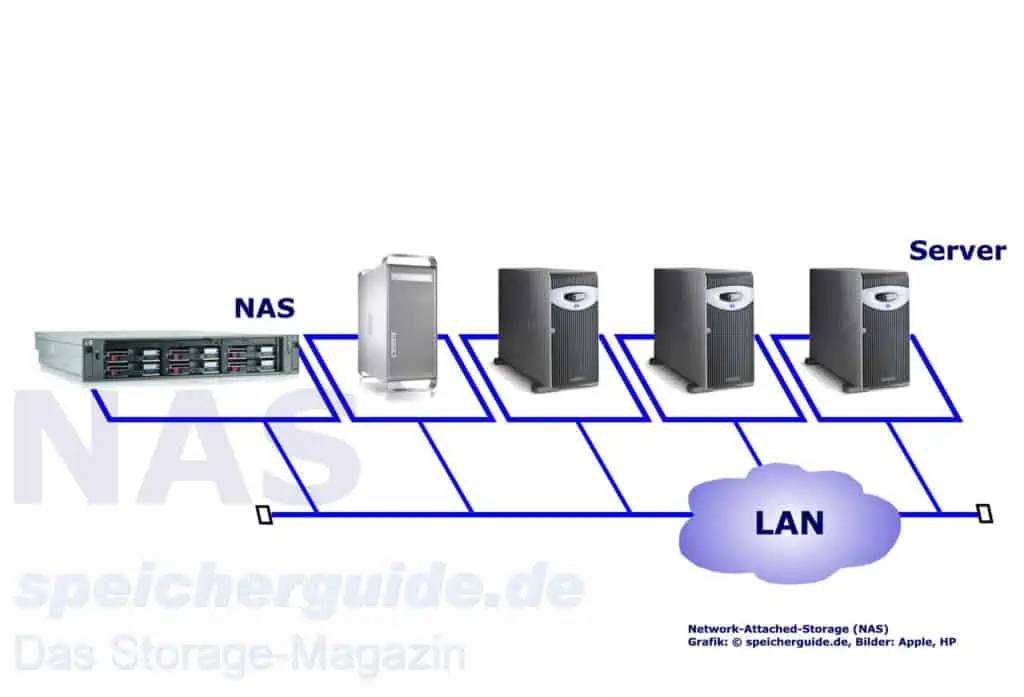

Ressource für viele: Network-Attached-Storage

NAS wurde vor allem für Umgebungen entwickelt, in denen die Zahl der zu verwaltenden Server und Dateisysteme den Administratoren über den Kopf zu wachsen schien. NAS-Systeme stellen den in ihnen verbauten Plattenspeicher über spezielle Software – wie diese Server – ins Netz, sind allerdings für keine andere Anwendung vorgesehen. Damit werden vor allem die Standardsysteme entlastet, die nur noch ihre Anwendungen betreiben und keine zusätzlichen Dateidienste mehr bedienen müssen. Darüber hinaus bieten NAS-Arrays eine wesentlich größere Flexibilität bei der Anzahl und Nutzung der verbauten Laufwerke. Obwohl NAS-Systeme eist reine plattenbasierte Geräte sind, gibt es derzeit auch Systeme, die Flash-Speicher für schnellere Prozesse und intelligente Datenplatzierung nutzen.

NAS bietet eine gute Lösung für alle Nutzer, die sich nach einer einfachen und preiswerten Lösung für viele Anwender auf Dateiebene umsehen. Im Vergleich zu Standardservern bieten diese Systeme eine bessere Leistung und damit verbesserte Produktivität. Vor Jahren als Einstiegs- und Midrange-Lösungen eingeführt, hat sich NAS vor allem bei SMB-Kunden eine breite Basis erarbeitet. Aber die bereits genannten Vorteile bereiten dieser Architektur auch in den großen Unternehmen den Weg.

Kleinere Unternehmen bekommen mit NAS eine Plug-and-Play-Lösung, die sich einfach und schnell installieren und auch ohne eigenes IT-Personal betreiben lässt. Durch immer größere Laufwerke zu immer geringeren Preisen wird der Einstieg zudem immer leichter. Für größere Unternehmen ist es eine gute Lösung, um Daten verteilt zu nutzen.

Fast alle Hersteller von Enterprise-Systemen haben ihre eigenen NAS-Systeme entwickelt, die mit immer umfassenderen Funktionen in die großen Unternehmen drängen. In vielen Ausschreibungen werden SANs parallel zu NAS-Systemen oder gar konvergente Lösungen gefordert. Hochverfügbarkeits-Eigenschaften wie RAID sowie im Betrieb austauschbare Komponenten oder Laufwerke sind auch in Systemen der Einstiegsklasse längst selbstverständlich. Die Mittelklasse kommt mit immer mehr Eigenschaften aus dem Unternehmensbereich daher, so beispielsweise mit Replikation oder Spiegelung.

Auch zur Konsolidierung direkt angeschlossener Speicher ist NAS in mittleren und großen Installationen geeignet. Wie bereits erwähnt, kann hierdurch neben der zentralen Verwaltung vor allem die Nutzung des Speichers verbessert werden. NAS ist aus der Perspektive von ROI und anderen kaufmännischen Faktoren eine sehr attraktive Lösung. Im Gegensatz zur Aufstellung immer neuer physikalischer Server oder der umständlichen Erweiterung der vorhandenen Kapazitäten und den hiermit verbundenen Kosten für Anschaffung und Verwaltung ist diese Architektur wesentlich preiswerter. NAS-Systeme bieten heute Speicher weit jenseits der PByte-Grenze auf sehr engem Raum, wodurch der Platz im Rechenzentrum und die Energie wesentlich besser genutzt wird. Daher sind NAS-Arrays vor allem in Umgebungen mit großem Datenzuwachs wesentlich beliebter als direkt angeschlossene Kapazitäten.

Ein weiterer Faktor für NAS ist die Möglichkeit, Daten in heterogenen Umgebungen über Betriebssystemgrenzen hinaus nutzbar zu machen. Während auf direkt oder über SAN angeschlossenen Rechnern gelagerte Informationen nur für den einen Rechner im Zugriff liegen, lassen sich über NAS-Arrays beliebig viele Zugriffe auf ein Dateisystem realisieren. Ob Macintosh, Unix, Linux oder Windows, alle Systeme werden gleichbehandelt und arbeiten in derselben Sicherheitsumgebung. Für spezielle Anforderungen gehen manche Hersteller seit kurzem dazu über, den Zugriff auf Dateisysteme über NAS und über iSCSI parallel zu ermöglichen. Viele Cloud-Dienstleister bieten Storage- und Backup-Services an, die eine NAS-Architektur darstellen. Dies ist eine Option für Anwender, NAS-Infrastrukturen zu nutzen, ohne die Hardware anschaffen oder das Management führen zu müssen. Cloud-NAS-Offerten sind eine simple Option zu lokalen Shared-Storage-Implementierungen. Sie sind oftmals günstiger, schneller bereitgestellt und einfacher in der Verwaltung – erst recht, wenn das Management beim Anbieter liegt – und somit eine valide Alternative zu On-Premises-NAS-Systemen.

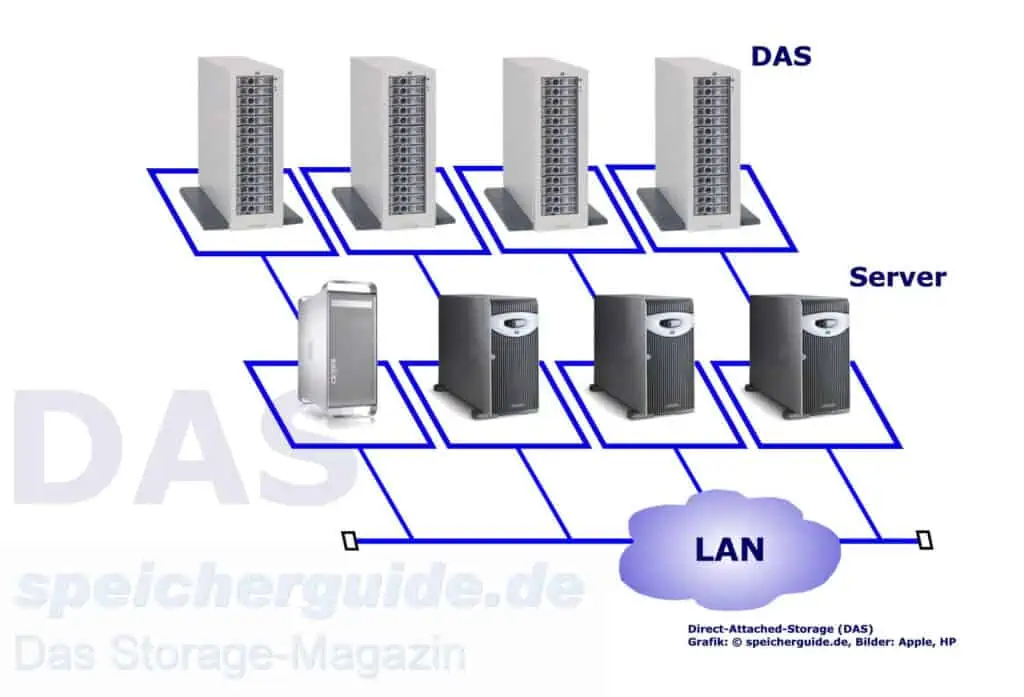

Direktspeicher: Direct-Attached-Storage

DAS ist die älteste Art, größere Speichervolumen anzuschließen. Hier arbeiten eine oder mehrere Medien direkt am Bus eines Rechners bzw. Servers, entweder einzeln genutzt oder aber abgesichert in RAID-Gruppen. Somit erhält ein einzelner Server die gesamte Leistung eines Speichergeräts. Im Gegensatz zu NAS und SAN, wo separate Systeme die Speicheraufgaben erfüllen, wird der DAS-Server meist noch durch die Abarbeitung anderer Programme belastet. Auch die für den Zugriff auf die gespeicherten Daten verfügbare Bandbreite wird durch zum Beispiel E-Mail- oder Datenbankanwendungen geschmälert.

Obwohl der Anteil von Netzwerkspeichern in den letzten Jahren im Vergleich zu DAS-Systemen zugenommen hat, greifen viele IT-Abteilungen immer noch auf diese Art der Lösung zurück. Sie ist einfach einzuführen und kann mit Mitteln der jeweiligen Betriebssystemumgebung verwaltet werden. Dabei stehen die Daten im DAS-Server nur dann zur Verfügung, wenn dieser einwandfrei arbeitet. Fällt dieser aus, ist auch der Zugriff gestört.

DAS ist vor allem für Umgebungen geeignet, in denen nur ein oder wenige Server installiert sind. Beispielsweise Abteilungen oder kleine Unternehmen, die keine Daten über größere Entfernungen oder intern verteilen müssen. Während kleinere Firmen DAS vor allem zur Speicherung von Dateien oder für E-Mail-Dienste nutzen, führt es in größeren Unternehmen meist eine Koexistenz mit NAS- und/oder SAN-Installationen. Ist der Aufwand für die Verwaltung eines einzigen oder weniger DAS-Server durch Nutzung des Netzwerkes und des auf dem Rechner vorhandenen Betriebssystems noch gering, kann dieser schnell mit der Anzahl der verwendeten Systeme anwachsen.

Aus der wirtschaftlichen Perspektive sind die Anschaffung und der Betrieb eines einzelnen DAS-Servers billiger. Für IT-Leiter mit immer kleiner werdenden Budgets ist dies somit eine valide Option, um dem Netzwerk schnell und preiswert Speicher hinzuzufügen und die mit NAS und vor allem SAN einhergehende Komplexität zu vermeiden. DAS kann ebenso als Zwischenlösung für Installationen dienen, die in der Zukunft auf NAS oder SAN migrieren wollen. Aber vor allem Unternehmen mit raschem Datenwachstum sollten hier Vorsicht walten lassen, da DAS aufgrund seiner Architektur eine eingeschränkte Skalierbarkeit aufweist. Aus Sicht der Kosteneffizienz und Verwaltbarkeit sind Netzwerk-Speichermodelle hier die weit bessere Wahl. DAS-Systeme sind allerdings in ihrer Skalierbarkeit beschränkt: Wird ein großer Server (viele Compute- und Kapazitäts-Ressourcen) an ein DAS angeschlossen, gilt es sicherzustellen, dass das DAS-System die maximale Auslastung des Systems bedienen kann. In der Regel ist dies kein Problem, muss aber bei der Planung für DAS-Systeme unbedingt beachtet werden.

Die Anforderung bestimmt die Speicherstrategie

Welches ist die beste Lösung für das Unternehmen – SAN, NAS oder DAS? Alle drei haben ihre Vor- und Nachteile, aber jedes hat seine Berechtigung für bestimmte Umgebungen und Anforderungen. Um die passende Architektur oder eine Mischung aus mehreren zu finden, müssen die oben angeführten Fragen geklärt sein. Daher ist eine genaue und detaillierte Bewertung des momentanen und zukünftigen Datenbestandes vonnöten. Was ist vorhanden, und wo will die Datenverarbeitung hin? Wie alle anderen Branchen auch, ist der Speicherbereich ständigen Änderungen unterworfen. Größere Bandbreiten, längere Distanzen, schnellere Medien und vor allem immer neue Softwarefunktionen prägen die Weiterentwicklung.

Die beste Anschaffung ist – wie immer – diejenige, die zu möglichst geringen Kosten einen möglichst langen Investitionsschutz bietet. Digitale Informationen nehmen ständig zu, einen Rückweg gibt es kaum. Die Speicherumgebung sollte daher nicht nur momentane, sondern auch die Anforderungen der nächsten drei oder fünf Jahre erfüllen. Bestenfalls entsprechen die Systeme offenen Standards bzw. Industriestandards, so dass in ein paar Jahren leicht und barrierefrei auf andere Lösungen gewechselt werden kann. In einigen wenigen Fällen ist es möglich, Komponenten des jeweiligen Systems zu erneuern (und damit auszutauschen), was das System langlebiger macht.

Und nicht zu vergessen: Objektspeicher. Neben SAN und NAS hat sich Object-Storage als Alternative für die Bereitstellung und Sicherung von unstrukturierten Daten etabliert, vor allem bei großen Datenmengen.