Die Märkte für verteilte Dateisysteme und Objektspeicher wachsen zusammen. Aus diesem Grund veröffentlicht Gartner neuerdings einen Magic Quadranten für die Technologiesegmente. Die Grenzen zwischen den beiden Disziplinen verschwimmen. Im Mittelpunkt stehen sowohl Datei- als auch Objektzugriff für unstrukturierte Datensätze in öffentlichen oder privaten Clouds. Sie gehören längst zur modernen Speicher-Infrastruktur.

IT-Führungskräfte entscheiden sich scheinbar häufig zwischen Public-Cloud und On-Premises-Infrastruktur, je nach Workload. Die Organisationskultur und die Sensibilität für Sicherheits- und Governance-Vorgaben sind in der Regel die wichtigsten Faktoren, die Unternehmen bei der Entscheidung berücksichtigen, ob sie Anwendungen und Daten in die Public-Cloud verschieben oder lokal belassen.

Wenn sich Unternehmen dafür entscheiden, Anwendungen und Daten lokal oder in einer Public-Cloud aufzubewahren, entscheiden sie sich zunehmend zwischen Objekt- und Dateisystem-Speicher, um die großen Mengen unstrukturierter Daten unterzubringen. Die Analysten von Gartner behaupten in ihrem aktuellen Report »Magic Quadrant for Distributed File Systems and Object Storage« vom Oktober 2021, dass diese Workloads nicht zwingenderweise getrennt werden müssen. Auch wird gesagt, dass Unternehmen bei der Wahl von Solid-State-Arrays, hyperkonvergenten Infrastrukturen, verteilten Dateisystemen und Objektspeichern offener geworden sind gegenüber Start-ups und weniger etablierten Herstellern.

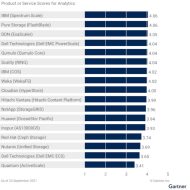

Im Überblick vorab: Der aktuelle Report führt als »Leader« Dell, IBM, Pure Storage, Qumolo und Scality. Netapp, Nutanix, Quantum, Red Hat und WEKA dürfen sich »Visionäre« nennen. Cloudian, Hitachi und Huawei rangieren im Quadrat der »Herausforderer«, DDN und Inspur besetzen jenes der »Nischen-Player«. Viele Anbieter fallen jedoch durch das Gartner-Raster, das bestimmte Voraussetzungen an Unternehmensgröße, Mitarbeiterzahl und geografischer Ausrichtung stellt.

Viele große, etablierte Anbieter positionieren verteilte Dateisysteme für aufkommende KI-Workloads neu. Gleichzeitig sieht der Markt, aufstrebende Anbieter wie MinIO, VAST oder WekaIO, die speziell Verbesserungen der Leistung, Skalierbarkeit und Bereitstellungsflexibilität angehen. Gartner konstatiert ebenso, dass hyperkonvergente Lösungen wie die von Nutanix und Cohesity sich weiterentwickeln und traditionelle NAS-Lösungen (Network-Attached Storage) ersetzen. Auch Anbieter wie DataCore mit seinen Software-defined-Storage-Plattform für Block- File- und Objekt-Dienste spielen in diesem Marktsegment.

Kurz gesagt: Die Wahlmöglichkeiten bei der Bereitstellung einer Storage-Infrastruktur nehmen zu. Und sie gehen in die Richtung hybrider Architekturen, die auf Effizienz getrimmt sind. Die Anbieter für verteilte Dateisysteme und Objektspeicher bieten gemischte Bereitstellungsoptionen an, um den Kunden Wahlmöglichkeiten bei der Bereitstellung der Infrastruktur zu geben. Zu den gängigen Optionen gehören schlüsselfertige High-Density-Appliances oder reine Software-Optionen, die entweder auf Bare-Metal-Hardware nach Industriestandard als virtuelle Maschinen oder auf Docker-Containern bereitgestellt werden können. Anbieter in diesem Markt bieten ihre Produkte zunehmend als SDS (Software-defined Storage) an, die für die Ausführung auf x86-Hardware nach Industriestandard vorzertifiziert sind.

Hybrid scheint gesetzt

Hybrid-Modelle scheinen bei Fragen der Speicher-Infrastruktur derzeit dominant. Die Public-Cloud bietet, trotz aller Unwägbarkeiten bezüglich Gesamtkosten, Daten-Sicherheit und Zugriff-Garantien die Agilität, Effizienz und progressive Funktionen, die offenbar viele Unternehmen suchen, trotz aller Vorbehalte. Die Redaktion speicherguide.de war im Jahr 2022 im Silicon Valley (USA) und im Silicon Wadi (Israel) unterwegs, und führt hierzulande viele Gespräche. Die Frage ist dort eigentlich nicht, ob, sondern wann und wie die Cloud, auch die öffentliche, in einer Storage-Infrastruktur integriert werden wird, zwischen lokalen und öffentlichen Cloud-Standorten.

Verteilte Datei-Systeme, und oftmals damit verbunden Objektspeicher-Modelle, sind die technische Grundlage für derart fluides Agieren von Unternehmen in lokalen und internationalen Märkten. Globale 24/7-Datenverfügbarkeitnist ohne Cloud, trotz aller Bedenken bezüglich der Daten-Sicherheit und -Integrität kaum mehr vorstellbar. So argumentiert jedenfalls Gartner.

Gartner-Voraussagen zu Distributed-File-Systems

IT-Führungskräfte suchen deshalb in erster Linie nach kostengünstigen, skalierbaren und flexiblen Speicherplattformen für wachsende Mengen unstrukturierter Daten. Bis 2026 werden große Unternehmen ihre Kapazität für unstrukturierte Daten, die als Datei- oder Objektspeicher vor Ort, am Rand (Edge) oder in der öffentlichen Cloud gespeichert sind, im Vergleich zu 2021 verdreifachen, behaupten die Analysten.

Bis 2025 werden 40 Prozent der Infrastruktur- und Betriebsleiter mindestens eine hybride Cloud-Speicherfunktion implementieren. 2021 waren es 15 Prozent. Im selben Jahr sollen 60 Prozent der globalen Speicherkapazität für unstrukturierte Daten als Software-definierter Speicher bereitgestellt werden, gegenüber weniger als 25 Prozent im Jahr 2021.

Speicherinfrastrukturprodukte, die auf verteilten Dateisystemen und Objektspeichern basieren, nehmen sowohl im Umfang als auch in der Kapazität der Bereitstellungen als Plattform der Wahl schneller denn je zu, um das Wachstum unstrukturierter Daten in globalen Rechenzentren zu bewältigen. Unstrukturierte Daten sollen Jahr für Jahr um mehr als 30 Prozent zunehmen. Gartner meint, IT-Führungskräfte suchen primär nach erweiterbaren On-Premises-Speicherprodukten, die eine wachsende Zahl von digitalen Geschäftsanwendungsfällen mit geringeren Anschaffungs-, Betriebs- und Verwaltungskosten adressieren können. Und finden verteilte Datei-Systeme, die auch die Cloud orchestrieren. Multi-PByte an Speicher bereitstellen, Hybrid-Cloud-Workflows mit Public-Cloud-IaaS steuern, um die Gesamtbetriebskosten (TCO) zu senken und die Datenmobilität zu verbessern, skalierbare Speicherumgebungen sind im Fokus.

Gartner zu Technologie und Anbietern

Objektspeicher, der sich auf Systeme und Software bezieht, die Daten in Strukturen enthalten und Objekte genannt werden, und Daten über RESTful-HTTP-APIs bereitstellen, wie beispielsweise Amazon S3 (Simple Storage Service), ist dabei zum De-facto-Standard für den Zugriff auf Objektspeicher geworden.

Die Anbieter für Distributed-File-Systems im Überblick (in alphabetischer Reihenfolge)

Cloudian

Cloudians flexible Software-basierte und Hardware-unabhängige Lösungen, Marken-Appliances und Cloud-basierte Bereitstellungsoptionen Die Strategie von Cloudian, sich auf Backup-Möglichkeiten für die Bereitstellung von S3-kompatiblem Speicher mit Object-Lock-Technologie zum Schutz vor Ransomware zu konzentrieren, bleibt für viele Kunden eine attraktive Option. In den letzten 12 Monaten hat Cloudian mehrere Verbesserungen wie die Unterstützung für Kubernetes, VMware Tanzu und All-Flash-Objektspeicher hinzugefügt und seine File-Gateway-Lösung HyperFile auf eine Scale-out-Architektur verbessert.

DDN

DDN ist ein Nischenplayer in diesem Magic Quadrant. DDN EXAScaler ist ein verteiltes Dateisystem, das lokal und in der Cloud ausgeführt wird. Es wird hauptsächlich für umfangreiche Datei-Workloads mit hohem Durchsatz und in einigen Fällen als S3-Ziel für Archivierungsanwendungsfälle bereitgestellt. Exascaler basiert auf dem parallelen Open-Source-Dateisystem Lustre. Allerdings bietet DDN keinen entwicklerfreundlichen Objektspeicher für Objekt-native Workloads, der einfach herunterzuladen, bereitzustellen und zu verwalten ist. Kunden sind in der Regel große Unternehmen.

In den letzten 12 Monaten hat DDN Verbesserungen an den Protokolldiensten von Exascaler geliefert und die Cloud-native Bereitstellung in den drei großen öffentlichen Clouds optimiert. Darüber hinaus erhielt DDN mit SAS Grid Manager, einem Grid-Computing-Manager, die Zertifizierung für Bereitstellungen in der Public Cloud. DDN Exascaler eignet sich am besten für High Performance Computing (HPC) und Analyse-Anwendungsfälle, einschließlich der Integration in GPU-Umgebungen zur Unterstützung von NVIDIA DGX SuperPOD.

Dell Technologies

Dell Technologies ist in diesem Magic Quadrant führend. Dell EMC PowerScale ist ein verteiltes Dateisystem, das lokal ausgeführt wird und als nativer Dienst in Google Cloud verfügbar ist. Dell EMC ECS ist eine Objektspeicherplattform, die lokal und in der Cloud ausgeführt wird. Kunden reichen von kleinen bis zu sehr großen Unternehmen in allen Branchen.

Für Powerscale wurde in den letzten 12 Monaten Unterstützung für NVIDIA GPUDirect, parallele Upgrades, Inline-Komprimierung und Daten-Deduplizierung hinzugefügt. ECS erhielt Unterstützung für größere SSDs und HDDs, S3-Zugriff, einen externen Schlüsselmanager und Objekt-Tagging. Beide Produkte decken den Großteil der Anwendungsfälle für unstrukturierte Daten ab und bieten eine zentralisierte Verwaltung mit Dell EMC CloudIQ und Dell EMC DataIQ.

Powerscale eignet sich für eine Vielzahl von Anwendungsfällen und Bereitstellungsoptionen, beispielsweise einen nativen GCP-Dateidienst und eine Option zur Nutzung als Storage-as-a-Service. Allerdings fehlt dem Hersteller ein SDS-Angebot, das auf Nicht-Dell-Bare-Metal-x86-Servern ausgeführt werden kann.

Hitachi Vantara

Der Herausforderer Hitachi Vantara bietet mit der Hitachi Content Platform (HCP) ein Objektspeicherprodukt, das als Software oder Appliance angeboten und lokal sowie in öffentlichen und hybriden Cloud-Umgebungen genutzt werden kann. HCP kann Leistung und Kapazität unabhängig voneinander skalieren, um eine Vielzahl von Workloads zu unterstützen. Kunden sind in der Regel mittelständische bis große Unternehmen.

HCP unterstützt die gängigen öffentlichen Clouds (Amazon Web Services AWS, Microsoft Azure und Google Cloud Platform GCP). Zuletzt hat Hitachi die OEM-Integration mit WekaFS, EverFlex für XaaS und eine HCP Anywhere-Funktion zum Synchronisieren und Freigeben von Dateien bekannt gegeben. HCP, sagen die Marktforscher, eigne sich am besten für Analysen, Cloud-Speicher, Backup und Archivierung sowie Hybrid Cloud.

Huawei

Huawei ist ein Herausforderer im Magic Quadrant und bietet mit OceanStor Pacific ein verteiltes Dateisystem, Block- und Objektspeicherprodukt an. Während OceanStor 9000 weiterhin für Datei-Workloads unterstützt wird, ist Oceanstor Pacific jetzt das Flaggschiffprodukt von Huawei für alle Anforderungen an unstrukturierte Daten. Kunden sind in der Regel Telekommunikations-, Regierungs- und Finanzinstitute.

Im vergangenen Jahr wurden neue Kapazitäts- und Leistungsknoten mit hoher Dichte hinzugefügt. Die Systeme verfügen jetzt über asynchrone Replikation, einen verteilten parallelen Client, Mandantenfähigkeit und Verschlüsselung sowie Komprimierung, Active Directory- und LDAP-Authentifizierung. Oceanstor Pacific eignet sich am besten für große private Clouds, Inhaltsverteilung, Cloud-native Anwendungen und Archivierung.

IBM

IBM befindet sich mit Spectrum Scale im Segment der Marktführer. Spectrum Scale ist ein paralleles Dateisystemprodukt, das lokal und in ausgewählten öffentlichen Clouds ausgeführt wird. Cloud Object Storage (COS) heißt das Objektspeicherangebot von Big Blue, das lokal oder in der IBM Cloud ausgeführt werden kann. Kunden reichen von mittelständischen bis hin zu sehr großen Unternehmen. Spectrum Scale fokussiert dabei kommerzielle HPC- und Analyseanwendungsfälle. COS eignet sich am besten für Archive und private Cloud-Speicher.

IBM hat zuletzt die Unterstützung für hybriden Cloud-Speicher, containerisierte Anwendungen, Dateiprüfung und QoS mit Spectrum Scale verbessert. Bei COS wurde File-Access und eine Virtual-Edge-Caching-Lösung hinzugefügt.

Mit der Übernahme von Red Hat durch IBM erweitert seine Reichweite auf Unternehmen mit Cloud-nativen Workloads, einschließlich erweiterter Unterstützung für containerisierte Anwendungen und OpenShift in IBM Spectrum Scale.

Inspur

Die AS13000G5-Serie des Nischen-Players Inspur bietet eine einheitliche Softwarelösung für Datei- und Objektspeicherung. Inspur bietet drei Modelle für Anwendungen im Petabyte-Bereich für Hochleistungs-, High-Definition-Video, hohe Zuverlässigkeit und Cloud-basierte Bereitstellungen. Kunden sind in der Regel Telekommunikations-, Regierungs-, Internet-, Mobilfunk- und Bildungseinrichtungen. In den letzten zwölf Monaten hat Inspur zwei neue Arrays hinzugefügt, Tagging, natives HDFS, Zwei-Wege-Authentifizierung von HTTPS, S3 Select, Kapazitätsüberwachung und prädiktive Analysen. Inspur-Storage eignet sich am besten für Backup und Archivierung, kommerzielle HPC, Hybrid Cloud und Analysen. Allerdings könnten, noch stärker als bei Huawei, geopolitische Auswirkungen der US-Sanktionen außerhalb der Region Asien/Pazifik die Entwicklung von Inspur behindern.

Netapp

Netapp rangiert als Visionär im Magic Quadrant. NetApp StorageGRID ist eine Objektspeicherlösung, die als reine Software und als Hardware-Appliance erhältlich ist, die lokal und in der Public Cloud ausgeführt werden können. Netapp unterstützt das Tiering von Daten von lokalem Storagegrid-Knoten zu öffentlichen Cloud-Services, einschließlich AWS und Azure. Kunden sind in der Regel große Unternehmen, Medien und Unterhaltung, Behörden und Dienstleister. NetApp eignet sich für Cloud Storage-, Archivierungs-, Backup- und Hybrid Cloud-Infrastrukturen.

Nutanix

Nutanix Files und Nutanix Objects des Visionärs sind in die hyper-konvergente Nutanix-Plattform integriert, um eine einheitliche Architektur und Verwaltung zu ermöglichen. Dateien und Objekte können knotenübergreifend bereitgestellt werden kann. Dabei wird die Plattform als hyperkonvergente Infrastruktur (HCI) für kleinere Bereitstellungen oder auf einem dedizierten Nur-Storage-Cluster für größere Bereitstellungen genutzt. Nutanix arbeitet mit Server-OEMs und Channel-Partner.

Nutanix hat eine Ransomware-Erkennung, verbesserte Notfallwiederherstellung, erweiterte Dateianalyse- und Synchronisierungsfunktionen hinzugefügt. Bei Objects wurden Leistung und Replikation verbessert und dem S3-Speicher Tiering hinzugefügt. Ebenso beherrscht die Plattform sowie Smart Lock, Legal Hold sowie Unterstützung für Versionierung und Mandantenfähigkeit. Nutanix eignet sich am besten für Hybrid-Cloud- und Cloud-native Anwendungsspeicher.

Die Datenanalysetools von Nutanix sollen differenzierende Funktionen wie die Überwachung und Meldung von abnormalem Benutzerverhalten, Leistungsanomalien und Audit-Trails sowie einen integrierten Ransomware-Schutz mit der Fähigkeit, Angriffe zu erkennen und zu blockieren. Allerdings unterstützen Nutanix-Dateien und -Objekte keine Deduplizierung und ihre öffentliche Cloud-Präsenz ist auf Nutanix-Cluster auf AWS Bare Metal beschränkt.

Pure Storage

Pure Storage bewegt sich in diesem Segment als einer der Marktführer. Das FlashBlade ist im Portfolio die einheitliche Datei- und Objektplattform mit einem verteilten Scale-out-Dateisystem, das für die Verarbeitung von zig Milliarden Dateien und Objekten für massiven Durchsatz und Parallelität ausgelegt sein soll. Pure Storage eignet sich wohl am besten für kommerzielle HPC, Analysen und Backups, bei denen die Leistung des Recovery Time Objective (RTO) entscheidend ist.

In den letzten Monaten hat der Anbieter eine Reihe von Verbesserungen durchgeführt, darunter native Unterstützung für schnelles Scale-out von SMB 2.1, Unterstützung für NFSv4.1 Kerberos und ACLs, verbesserte NFS- und Objektfunktionen sowie Active-Directory-Sicherheit mit Kerberos-Authentifizierung. Zusammen mit den FlashArrays und gemeinsamem Managementsystem können Unternehmen ihre Block-, Datei- und Objekt-Workloads in einer Infrastruktur konsolidieren.

Der Hersteller bietet mit Pure1 auch eine Plattform für AIOps- und Analysefunktionen sowie ein gelobtes Support-Programm namens Evergreen. Die Gartner-Analysten bemängeln jedoch das Fehlen erweiterter Unternehmensfunktionen wie SMB 3.0 und vermissen nahtloses Failover, Deduplizierung, Tiering und die Möglichkeit, die Lösung als reine Software-Version in einer öffentlichen Cloud-Infrastruktur bereitzustellen.

Quantum

ActiveScale des Visionärs Quantum ist eine Objektspeicher-Appliance, die im März 2020 von Western Digital erworben wurde. Die Vision basiert auf einer inzwischen vorgelegten Roadmap für die Integration von Activescale in seine Band- und StorNext-Dateisystem-Produktlinie. Zudem erwarb Quantum CatDV für Metadaten-Tagging von Daten im Activescale-System. Es eignet sich insbesondere für große unstrukturierte Daten-Workloads wie die Archivierung von wissenschaftlichen und medizinischen Forschungsdaten und Repositories von Rich-Media-Inhalten.

Quantum gilt als attraktiv für Unternehmen, die nach effektiven End-to-End-Lösungen mit mehreren mehrerer Technologien in einer einzigen Plattform suchen, urteilen die Analysten. Jedoch ist Activescale ein noch relativ junges Produkt im Quantum-Portfolio. Laut Gartner fehlen (noch) beispielsweise Funktionen wie Datendeduplizierung und -komprimierung, QoS, Mixed-Flash-Unterstützung, NFSv4 und SMB, Hybrid-Cloud-Integration und Dual-Protocol-Zugriff.

Qumulo

Der Leader Qumulo bietet eine portable, Software-definierte Dateispeicherplattform mit Datendiensten, die lokal und in öffentlichen Clouds betrieben werden. Die Lösung ist für umfangreiche Datei-Workloads mit hohem Durchsatz und integrierter Leistungsanalyse sowie Kapazitätsverwaltung konzipiert. Seine primäre Marktakzeptanz liegt in Nordamerika, wo Kunden in der Regel in den Sektoren Medien und Entertainment, Gesundheitswesen und im öffentlichen Sektor tätig sind. Qumulo eignet sich am besten für kommerzielle HPC-, Analyse- und Hybrid-Cloud-Speicher, oftmals in Multi-PByte-Installationen.

Der Anbieter möchte weiter international expandieren, auch auf Basis von OEM-Partnerschaften. Das Produkt wurde zuletzt um einen nativen, verwalteten Azure-Dienst erweitert und unterstützt jetzt AWS Outposts. Ebenso versucht man, eine All-NVMe-Appliance auf Basis von HPE-Servern zu etablieren.

Red Hat

Der Red Hat Ceph Storage unterstützt Block-, Objekt- und Datei-Workloads. Die OpenShift Data Foundation dagegen ist ein reines Container-Speicherprodukt, das auf Ceph Storage basiert. Anwender sind in der Regel große Unternehmen sowie Telekommunikations- und Finanzdienstleistungsorganisationen. Red Hat Ceph Storage eignet sich am besten für die Bereitstellung von Inhalten und Cloud-native Anwendungen.

Im vergangenen Jahr wurde Ceph Storage um eine WORM-Funktion zur Objektsperrung und mit Unterstützung für FIPS 140-2-Kryptografie erweitert. Neuere Ceph Storage-Versionen umfassen ebenso Tiering innerhalb eines Clusters nach Datenträgertyp, verbesserte Leistung für kleine Objekt-Workloads und zusätzliche CephFS-Dateisystemunterstützung mit NFS-Protokoll-basiertem Zugriff.

Die Partnerschaft mit IBM hat den Zugang zum globalen Markt und zu traditionellen Unternehmen erheblich erweitert. Die Software-definierte Open-Source-Technologien ist vielseitige Unified-Storage-Plattform für eine Vielzahl von Cloud-nativen Anwendungsfällen, auch getrieben von einer großen Entwickler-Community, die die Lösung vorantreiben.

Scality

Die Speicherlösung Scality RING wird lokal ausgeführt und reicht bis in die Public Cloud. Scality bietet integrierten Datei- und Objektspeicher für unstrukturierte Daten-Workloads mit hoher Kapazität und läuft als Software auf handelsüblicher Hardware. Scality RING eignet sich für Multi-Petabyte-Bereitstellungen unstrukturierter Daten für die Inhaltsverteilung, Sicherung und Archivierung, die eine SDS-Lösung erfordern

In den letzten Monaten hat Scality seine SOFS-Dateiarchitektur auf Azure portiert, ARTESCA als separate, leichte, containernative Objektspeicherlösung angekündigt und Unterstützung für Flash-Medien erweitert. Ebenso sind neue Funktionen wie Objektsperrung, Smart Tiering und ein neues NFSv4-Stack verfügbar.

Weka

WekaFS ist ein Software-definiertes verteiltes Dateisystem, das lokal über OEM-Partner (beispielsweise über Hitachi Vantara- und Supermicro-Appliances) und in der Public Cloud bereitgestellt werden kann und über einen Client für parallele Dateisysteme verfügt. Das Weka-File-System wurde erstmals im Jahr 2017 veröffentlicht und als NVMe-basiertes, IO-intensives, verteiltes Dateisystem mit geringer Latenz konzipiert, das sich auch auf die Objektspeicherung in einem einzigen Namespace vor Ort oder in der öffentlichen Cloud erstrecken kann.

Die neueste Produktversion umfasst RDMA-Netzwerke, Kontingentmanagement, S3- und Autoscaling-Unterstützung in AWS. Weka konzentriert sich auf Bereitstellungen für KI/maschinelles Lernen (ML), Finanzanalysen, Bio-Wissenschaften und andere HPC vor Ort und in der Public Cloud.

Die Analysten von Gartner heben noch weitere Anbieter hervor, die wegen der erwähnten Voraussetzungen nicht im Magic Quadrant 2021 berücksichtigt sind, es aber in Zukunft sein können. Dazu zählt beispielsweise Cohesity SmartFiles, ein verteiltes Dateisystem-Produkt, das Unveränderlichkeit für Daten bietet. Neben der Bereitstellung von Datei- und Objektdaten können Endbenutzer Virenschutz, Inhaltssuche, Dateiprüfung und Analysen direkt auf der Cohesity-Plattform ausführen.

MinIO ist eine weitere Open-Source-basierte verteilte Objektspeicher-Suite. Es ist ein reines Softwareprodukt und läuft auf branchenüblicher Hardware in der Public Cloud. Mino unterhält viele Partnerschaften mit Speicher-Anbietern und unabhängigen Softwareanbietern (ISV). Der Dienst konzentriert sich auf leistungsorientierte Workloads. Es ist vollständig in Kubernetes integriert, was es bei DevOps-Organisationen sehr beliebt macht.

VAST ist ein verteiltes Dateisystem und eine Objekt-Appliance, die für den Einsatz in großen Rechenzentren entwickelt wurde. Produktdatendienste und Datenspeicherknoten sind über NVMe over Fabric (NVMe-oF)-Protokolle verbunden, um Algorithmen mit höherer Skalierung, geringerer Latenz und globaler Effizienz zu ermöglichen. Neue Speicheralgorithmen nutzen Speicher der Speicherklasse, um Latenz, Ausfallsicherheit und Durchsatz zu verbessern, und Quad-Level-Cell (QLC)-Flash-Medientechnologie, um die Wirtschaftlichkeit von Flash zu verbessern.

Fazit: Speicher-Infrastrukturen werden flexibler

Die Liste der Anbieter für verteilte Dateisysteme und Objektspeicher wächst kontinuierlich. Für moderne Speicher-Infrastrukturen sind sie kaum mehr wegzudenken. Auch schwinden die klassischen Grenzen für Block-, File- und Objekt-Storage. Bleibt für Unternehmen die Frage, ob und in welchem Ausmaß sie ihre lokale Speicher-Infrastruktur um öffentliche und/oder private Clouds erweitern möchten.