Künstliche Intelligenz ist längst in sicherheitskritischen, operativen und strategischen Bereichen von Unternehmen angekommen – sei es beispielsweise in der Prozessautomatisierung, der Medizin, der Kundeninteraktion oder im IT-Betrieb selbst.

Mit dieser wachsenden Relevanz gehen jedoch auch neue Risiken einher: KI-Systeme sind nicht nur anspruchsvoll in ihrer Entwicklung und Nutzung, sie unterscheiden sich auch grundlegend in ihrer Angriffsfläche von klassischen IT-Systemen und sind damit besonders anfällig für neue Arten von Cyberangriffen, wobei klassische Bedrohungen ebenfalls zum Tragen kommen.

Viele Unternehmen betreiben bereits erste KI-Pilotanwendungen oder produktive Systeme, haben jedoch kaum durchgängige Sicherheitsstrategien etabliert, die auf die Besonderheiten von KI abgestimmt sind. Während klassische Systeme z.B. standardmäßig auf Code-Schwachstellen oder Netzwerkangriffe untersucht werden, müssen KI-Systeme unter anderem gegen Datenmanipulation, fehlerhafte Trainingsprozesse oder gezielte Modell-Ausnutzung abgesichert werden.

Was macht KI-Systeme besonders angreifbar?

KI-Modelle, insbesondere solche auf Basis maschinellen Lernens, sind in hohem Maße datengetrieben. Das bedeutet: Qualität, Integrität und Vertraulichkeit der Trainingsdaten bestimmen direkt die Zuverlässigkeit des Modells. Doch gerade diese Abhängigkeit wird häufig zum Schwachpunkt.

Ein weiteres Problem ist die mangelnde Nachvollziehbarkeit vieler Modelle – insbesondere bei tiefen neuronalen Netzen. Entscheidungen sind schwer zu erklären oder zu validieren, was gezielte Manipulationen im Hintergrund vereinfacht. Zudem sind viele Modelle über öffentlich verfügbare APIs erreichbar, ohne dass Zugangskontrollen, Monitoring oder Absicherung gegen Missbrauch ausreichend etabliert sind.

Ein weiterer kritischer Punkt: KI-Modelle lernen aus Daten, aber auch aus Angriffen. Ein einmal kompromittiertes Modell kann sich unter Umständen selbst “weitervergiften”, wenn es mit manipulierten Inputs weiter betrieben oder nachtrainiert wird.

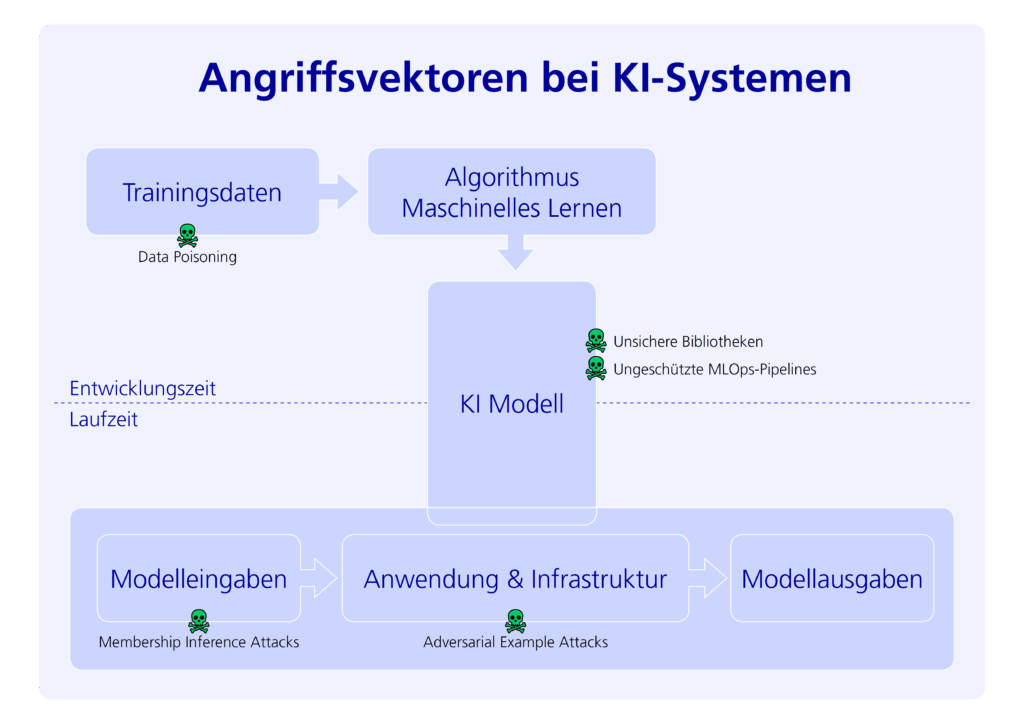

Typische Angriffsvektoren auf KI-Systeme

Die Forschung und Praxis führen mittlerweile eine ganze Reihe spezialisierter Angriffsformen auf KI-Systeme an. Zu den bekanntesten zählen:

- Data Poisoning: Angreifer schleusen manipulierte Daten in das Trainingsset ein, um das Modell gezielt zu schwächen oder zu bestimmten Verhaltensmustern zu etablieren.

- Adversarial Attacks: Eingabedaten werden so manipuliert, dass das Modell falsche Entscheidungen trifft. Der Unterschied ist für Menschen kaum erkennbar, z.B. durch leicht veränderte Bilder.

- Model Inversion Attacks: Durch gezielte API-Abfragen rekonstruieren Angreifer schrittweise Informationen aus dem Trainingsdatensatz.

- Membership Inference Attacks: Hier wird analysiert, ob bestimmte Datenpunkte Teil des Trainings waren – was bei sensiblen Daten (z. B. in Medizin oder Finanzwesen) erhebliche Datenschutzprobleme mit sich bringt.

- Supply Chain Attacks: KI-Modelle verwenden oft Open-Source-Bibliotheken und externe Datenquellen. Werden diese kompromittiert, können Angriffe in die gesamte MLOps-Kette eingeschleust werden.

Absicherung entlang des Lebenszyklus: Development & Runtime

Die effektive Absicherung von KI-Systemen erfordert einen ganzheitlichen Blick über den gesamten Lebenszyklus – von der Entwicklung über das Training bis zum Betrieb und zur Wartung.

In der Entwicklungs- und Trainingsphase:

- Schutz der Trainingsdaten: Daten sollten verifiziert, auf Anomalien geprüft und mit kryptografischen Integritätsmechanismen gesichert werden.

- Adversarial Training: Modelle sollten gezielt mit manipulierten („adversarial“) Beispielen trainiert werden, um ihre Robustheit gegenüber Angriffen zu erhöhen. Dies hilft, die Anfälligkeit für gezielte Eingabemanipulationen zu reduzieren.

- Absicherung des Modells während der Entwicklung: Modelle können durch Versionierung, Prüfprotokolle und Rollenbasierte Zugriffskontrollen abgesichert werden.

- Absicherung der Entwicklungsumgebung: Entwicklungsumgebungen (inkl. Notebook-Servern, Code-Repositories und Datenbanken) müssen gehärtet, kontrolliert und gegen unautorisierte Zugriffe geschützt sein.

- Auditing und Reproduzierbarkeit: Der Trainingsprozess sollte auditierbar sein, um spätere Schwachstellen oder Manipulationen nachvollziehen zu können.

Zur Laufzeit (Inference Phase):

- Schutz der Eingabedaten: Mechanismen wie Adversarial Input Detection oder Input Sanitization helfen dabei, manipulierte Nutzereingaben abzuwehren.

- Modellschutz zur Laufzeit: Modelle sollten in geschützten Umgebungen betrieben, verschlüsselt gespeichert und nur autorisiert zugänglich sein.

- Ausgabekontrolle und Datenschutz: Die Ausgaben von KI-Systemen müssen darauf geprüft werden, ob sie vertrauliche Informationen oder Trainingsdaten unbeabsichtigt preisgeben (z. B. bei generativen Modellen).

- Monitoring und Drift-Erkennung: Systeme zur Erkennung von Modell-Drift, Anomalien im Verhalten oder ungewöhnlichen Zugriffsmustern auf Basis von Monitoring und Analyse sind essenziell.

- Isolation der Laufzeitumgebung: Sicherheitskritische Modelle sollten in abgeschotteten Containern oder gesicherten Cloud-Umgebungen ausgeführt werden.

Rahmenwerke und regulatorische Anforderungen

Die gestiegene Bedeutung von KI in unternehmenskritischen Prozessen hat auch auf regulatorischer Ebene zu Reaktionen geführt. Unternehmen müssen sich zunehmend an verbindlichen oder empfohlenen Standards orientieren.

ISO/IEC 27090 – KI-spezifische Sicherheit

Diese neue Norm – derzeit in Entwicklung – adressiert erstmals spezifisch die Bedrohungsmodelle, Schutzmaßnahmen und Best Practices zur Absicherung von KI-Systemen. Sie ergänzt bestehende Informationssicherheitsstandards wie ISO/IEC 27001 um KI-relevante Aspekte.

EU AI Act – Verpflichtende Risikoklassifizierung

Die EU verfolgt mit dem EU AI Act einen risikobasierten Ansatz: Systeme mit hohem Risiko, etwa im Personalwesen, in der Kreditvergabe oder im Gesundheitswesen, unterliegen strengen Anforderungen hinsichtlich Transparenz, Robustheit, Sicherheit und Auditierbarkeit. Unternehmen müssen bereits ab der Entwicklungsphase dokumentieren, wie sie Risiken identifizieren und mitigieren.

OWASP ML Top 10

Dieses Framework listet die zehn häufigsten und kritischsten Sicherheitsrisiken in Machine-Learning-Systemen auf – von unzureichendem Logging bis hin zu unsicherem Datenmanagement – und bietet konkrete Handlungsempfehlungen für Entwickler und Architekten.

MITRE ATLAS

Das Adversarial Threat Landscape for Artificial-Intelligence Systems (ATLAS) der MITRE Corporation ist eine offene Wissensplattform, die dokumentierte Angriffsszenarien, Taktiken und Techniken gegen KI-Systeme strukturiert. Es dient als Threat-Intelligence-Grundlage zur Entwicklung gezielter Abwehrstrategien.

Darüber hinaus bieten Organisationen wie das NIST (z. B. mit dem AI Risk Management Framework) und das BSI (etwa durch Leitlinien zu Fairness, Bias und Robustheit) technische Empfehlungen und Whitepaper an. Wird KI in vernetzten oder digitalen Produkten eingesetzt, so können zusätzlich die Anforderungen des Cyber Resilience Act (CRA) der EU greifen.

Fazit: KI-Sicherheit braucht Spezialisierung, Disziplin und Voraussicht

KI-Systeme sind kein Sonderfall der IT-Sicherheit – sie sind ein eigenständiger Schutzbereich mit eigenen Risiken. Wer KI in seinem Unternehmen einsetzen oder betreiben will, muss verstehen, dass klassische Security-Mechanismen nicht ausreichen.

Unternehmen sollten frühzeitig in KI-spezifische Sicherheitsmaßnahmen investieren, Teams interdisziplinär aufstellen (KI + Security + Recht), Verantwortlichkeiten klären und sich an bestehenden Best Practices und Normen orientieren. Nur so lässt sich Vertrauen in KI-Anwendungen aufbauen und gleichzeitig die Gefahr von Manipulation, Datenlecks oder regulatorischen Sanktionen minimieren.