KI nimmt Arbeit ab – und entzieht uns Fähigkeiten. Statt einer AGI-Blackbox mit Chat-Tunnel braucht es neue Konzepte. „Holistic Intelligence“ orchestriert spezialisierte Modelle auf einem multimodalen Canvas – befähigend, auditierbar, souverän.

Die Entwicklung von KI-Anwendungen folgt seit Jahren derselben Kurve: Sie nimmt Nutzer:innen kognitive Arbeit ab – oft bis zur Unsichtbarkeit. Antworten kommen längst mit vorgeschlagenen Anschlussfragen; Assistenten bieten vorgefertigte Bausteine, die Strukturarbeit delegieren. Microsofts Copilot etwa blendet in Teams und Dynamics kontextabhängig „Follow-up“-Vorschläge ein – die nächste Frage ist nur noch ein Klick entfernt. Gleichzeitig wird die Schnittstelle immer schmaler. Das Chatfenster ist – gemessen an der Informationsdichte – ein enger Kanal: Es zeigt nur wenig Inhalt pro Schritt und zwingt in lineare Dialoge. Das ist kein Trivium der Usability, sondern eine strukturelle Grenze chatbasierter Interaktion.

Währenddessen verschiebt sich der Schwerpunkt der Arbeit: Eingabedaten treten zurück, die Maschine holt sich Kontexte selbst. Google Gemini fasst Inhalte aus Gmail und Drive zusammenfassen; Microsofts Copilot-APIs „grounden“ Antworten in einem hybriden Enterprise-Index. Wer Kontext-Daten hochlädt oder Quellen automatisch „fischen“ lässt, überspringt selbst das flüchtige Querlesen – ein Komfortgewinn mit Nebenwirkungen.

Unterm Strich: Mit immer weniger Input generieren Blackbox-Modelle immer komplexeren Output. Die Konversation selbst ist flüchtig: sie scrollt davon, Artefakte fehlen. Aus der vielbeschworenen „Zusammenarbeit von Mensch und KI“ droht so eine Verlagerung der Wertschöpfung – weg vom Menschen, hin zur Maschine.

Verleiht uns KI Superkräfte – oder macht sie uns schwach?

Die Kognitionsforschung nennt das „cognitive offloading“: Wir lagern Denk- und Erinnerungsarbeit systematisch aus, um Last zu senken. Gleichzeitig schwächen wir dadurch den Lerneffekt. Sparrow et al. zeigten schon 2011 den „Google-Effekt“: Verfügbarkeit von Suchmaschinen verschiebt, woran wir uns erinnern – weniger Fakten, mehr Speicherorte. Das Automatisierungs-Paradoxon aus der Psychologie beschreibt den Deskilling-Effekt wenn Menschliche Experten spezifische Fähigkeiten für Aufgaben verlieren, die sie nicht mehr selbst ausführen müssen. Eine aktuelle Studie des MIT Media Lab zeigt, dass die Nutzung von ChatGPT zwar produktiv wirken kann, zugleich aber die neuronale Aktivität in Bereichen wie Gedächtnisbildung, Kreativität und exekutiver Kontrolle deutlich reduziert. Die Forschenden sprechen von »metacognitive laziness«.

Warum die Systeme immer „könnender“ werden

Damit Anbieter den Offloading-Pfad weitergehen können, bündeln sie Fähigkeiten: multimodale Wahrnehmung, Langkontext, Tool-Nutzung, Retrieval über Unternehmensbestände.

„AGI“ – Systeme mit allgemeiner kognitiver Leistungsfähigkeit sind ideal für diese Ziele. Und ob OpenAI, Google DeepMind, Meta, Anthropic oder xAI: Die führenden KI-Labs definieren AGI heute offen als strategisches Ziel und treiben in einem kapital- und compute-intensiven Wettlauf die nächsten Modellgenerationen in Richtung AGI.

Narrow AI als Ausweg

Zugleich warnen prominente Stimmen wie Nobelpreisträger Geoffrey Hinton oder OpenAI Mitgründer Ilya Sutskever vor systemischen Risiken. Denn die Generalität und Autonomie der AGI führen dazu, dass Fehler, Missbrauch oder eine falsche Zielsetzung weitreichende, systemweite und potenziell existenzielle Konsequenzen haben können, da die AGI in der Lage ist, ihre Ziele in der realen Welt aktiv und intelligent zu verfolgen.

KI-Sicherheitsforscher Roman Yampolskiy argumentiert, dass es keinen Grund gebe, die Entwicklung zur AGI zu riskieren, wenn die größten potenziellen Vorteile bereits mit Narrow AI erreicht werden könnten. Die strategische Frage bleibt also: Müssen wir für Produktivitätsgewinne wirklich auf (proto-)AGI setzen, oder fahren Unternehmen mit gut gekoppelten, überprüfbaren „Narrow AIs“ am Ende viel besser, ohne dabei das Fortbestehen der Menschheit aufs Spiel zu setzen?

Kollegin KI als Mentorin – ZUIs statt Chat-Tunnel

Je reduzierter und „bequemer“ das Interface und je stärker das System proaktiv führt, desto aktiver müssen wir Reflexion, Kontrolle und Nachvollziehbarkeit gestalten – sonst verlernt der Mensch genau die Fähigkeiten, die ihn als Partner stark machen. Wenn KI uns wirklich stärken soll, braucht es Gegenkräfte im Produktdesign – nicht Mahnrufe. Das lineare Chatfenster ist ein enger Schlauch. Zoomable User Interfaces (ZUI) bieten dagegen eine persistente 2D-Arbeitsfläche mit stufenloser Detailtiefe: Überblick, Hineinzoomen, Zurück – ohne Kontextverluste. Klassiker wie Pad++ zeigen seit den 1990ern, wie räumliche Organisation Orientierung und Sinnbildung stützt; spätere Studien und Übersichtsarbeiten beschreiben, warum stabile räumliche Anordnung die räumliche Erinnerung und Navigation befördert – und warum Animation beim Zoomen mentale Karten festigt. Dass die räumliche Verortung von Informationen die Gedächtnisleistung steigert, ist bereits seit über 2.500 Jahren (vgl. Simonides von Keos) bekannt und als Loci-Methode eine bewährte Memotechnik bei Gedächtniswettbewerben.

Die große Chance liegt nun in der tiefen Integration von canvas-nativen KI-Funktionen: KIs agieren auf Objekten der Fläche – Textblöcken, Skizzen, Tabellen, eingebetteten Apps – und hinterlassen Artefakte (Notizen, Prüfungen, Versionen) direkt dort. Technisch spricht dabei viel für ein Orchestrationsmuster aus mehreren spezialisierten Modellen, nicht für ein monolithisches Generalmodell.

Holistic Intelligence statt Artificial General Intelligence

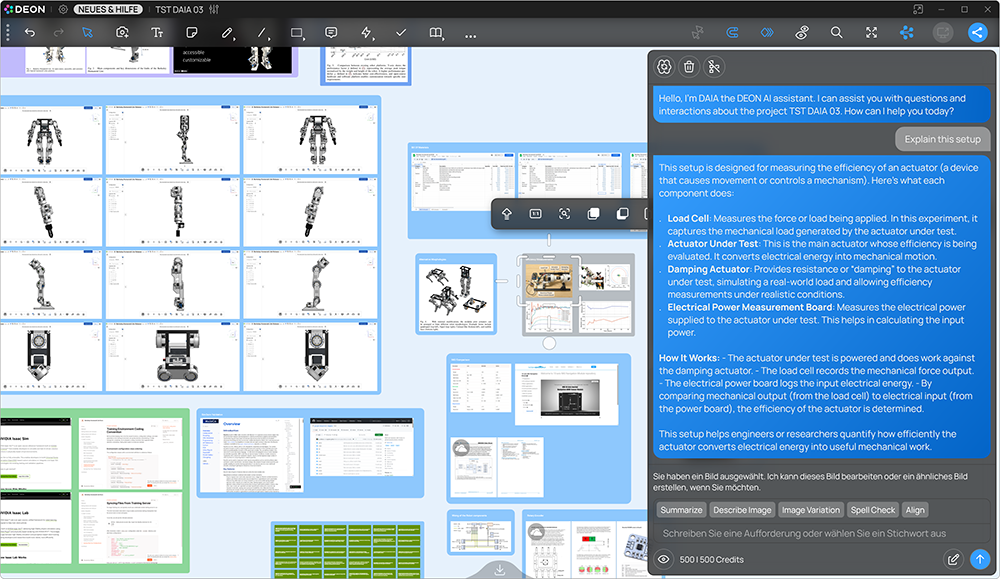

Die Berliner Softwarefirma DEON fasst die Kombination aus multimodaler Mensch-KI-Schnittstelle und Orchestrierung unter dem Begriff „Holistic Intelligence“ und bietet ein interaktives Multi-User-Whiteboard mit AI-Kernel als SaaS-Lösung. Der Kernel übersetzt und vermittelt zwischen der multimodalen Arbeitsfläche, angebundenen KI-Diensten und den Nutzenden – bidirektional und in Echtzeit. Inhalte und ihre räumliche Semantik werden für KIs explizit: Modelle können vorhandene Elemente bearbeiten und neue Artefakte hinzufügen; Menschen interagieren nicht nur per Chat, sondern durch Navigation, Selektion, Verortung und Bearbeitung der multimodalen Inhalte. Der Kernel orchestriert die Anweisungen jeweils passend für die beteiligten Modelle. Der Ansatz zielt auf drei Effekte:

- Echte Befähigung statt kognitivem Auslagern in eine Blackbox. Die KI wird zur Mentorin, weil Ergebnisse als überprüfbare, persistente Artefakte und Ereignisse auf der Fläche entstehen – nachvollziehbar, versionierbar, teilbar.

- Breite Einsetzbarkeit. Durch das universelle Canvas-Konzept lassen sich Recherche, Schreiben, Planung, Analyse und Präsentation in einem Raum zusammenführen.

- Architekturvorteile. Statt eines monolithischen Generalmodells koppelt der Kernel mehrere spezialisierte Modelle und Tools – je Aufgabe das passende, mit klarer Zuteilung von Verantwortlichkeiten.

Bildquelle: Copyright ©DEON

Auch organisatorisch hat das Konsequenzen: Die Plattform wirkt als neutraler Datenaggregator und vermeidet dadurch Vendor-Lock-in. Unterschiedliche Anwendungen können parallel als Datenquellen dienen; welche KI-Endpunkte oder Agentensysteme genutzt werden, bestimmt die Organisation selbst und kann Anbieter wechseln, weil der Kernel Standardschnittstellen wie die OpenAI-API und das Model Context Protocol (MCP) unterstützt. Da DEON ein unabhängiges deutsches Unternehmen ist, unterliegen seine Lösungen uneingeschränkt dem deutschen und europäischen Datenschutzrecht – ein Pluspunkt für Governance und ein Beitrag zur digitalen Souveränität in Europa.