Das Uptime Institute befragt regelmäßig internationale Datacenter-Betreiber nach Umfang, Ursachen und Auswirkungen von Ausfällen in ihren Rechenzentren (RZ). Die gute Nachricht ist, dass Rechenzentren insgesamt immer zuverlässiger werden.

Denn der Umfang der IT-Aktivitäten wächst viel schneller als die Zahl der registrierten Ausfälle. Dennoch ist es sinnvoll, die Ursachen und Auswirkungen von Ausfällen genau zu betrachten und Maßnahmen zur Risikominimierung zu nutzen. Wie sah es also 2021 um die Zuverlässigkeit von Rechenzentren genau aus?

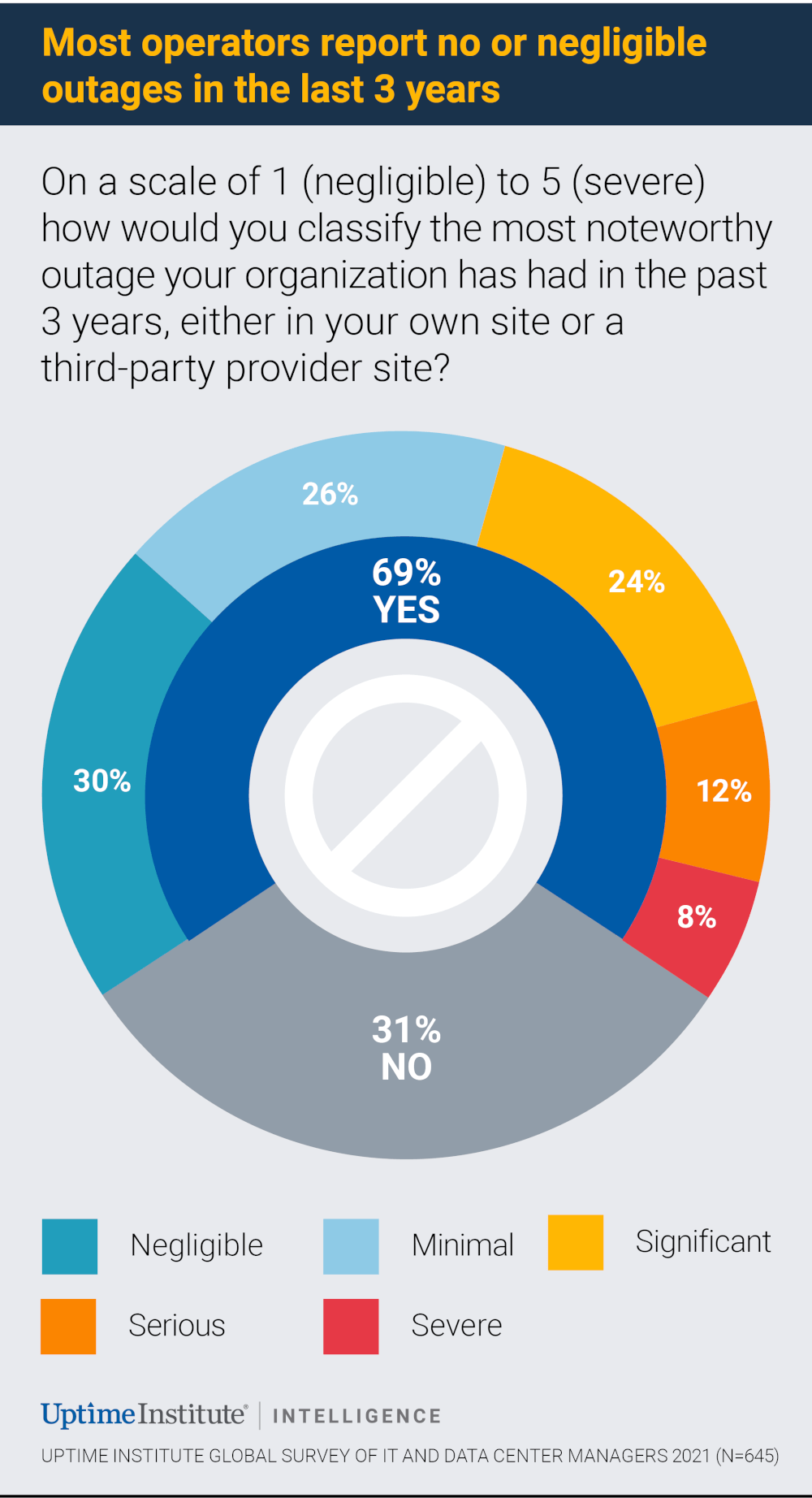

1. Fast ein Drittel ausfallfrei, aber 44 Prozent der Ausfälle erheblich bis kritisch

Nach ihrem bemerkenswertesten Ausfall in den letzten drei Jahren befragt, gaben 31 Prozent der teilnehmenden Datacenter-Betreiber an, in diesem Zeitraum überhaupt keinen Ausfall verzeichnet zu haben (eine Verbesserung gegenüber dem Vorjahreswert um 22 Prozent). Die 69 Prozent der Befragten, die von Ausfällen betroffen waren, klassifizierten deren Schwere folgendermaßen: Geringfügig waren 30 Prozent, minimal 26 Prozent, erheblich 24 Prozent, schwerwiegend 12 Prozent und kritisch 8 Prozent. Insgesamt ließen sich 2021 mehr als die Hälfte (56 Prozent) aller Betriebsunterbrechungen schnell und unauffällig ausräumen. Allerdings zogen die übrigen 44 Prozent der Ausfälle negative Folgen für die Reputation und erhebliche finanzielle Schäden nach sich.

2. Die Ausfallkosten steigen

Die Umfragen zeigen, dass die Kosten für Ausfälle in den letzten Jahren stetig gestiegen sind. 2021 gaben 39 Prozent der Befragten an, dass die wegen ihrer Ausfälle entstandenen Kosten unter 100.000 USD liegen. Bei 47 Prozent bewegten sie sich aber zwischen 100.000 und 1 Million USD, bei 15 Prozent sogar über 1 Million USD. Beachtlich ist hier, dass es jedes Jahr einige wenige große Ausreißer gibt, die so kostspielig sind, dass sie das Gesamtbild verzerren können, weil sich die damit verbundenen Kosten auf mehrere Millionen oder sogar auf zweistellige Millionenbeträge summieren. In unserer Umfrage für 2019 gab es zehn Großvorfälle mit Verlusten von über 25 Millionen Dollar, 2020 waren es drei, 2021 sechs.

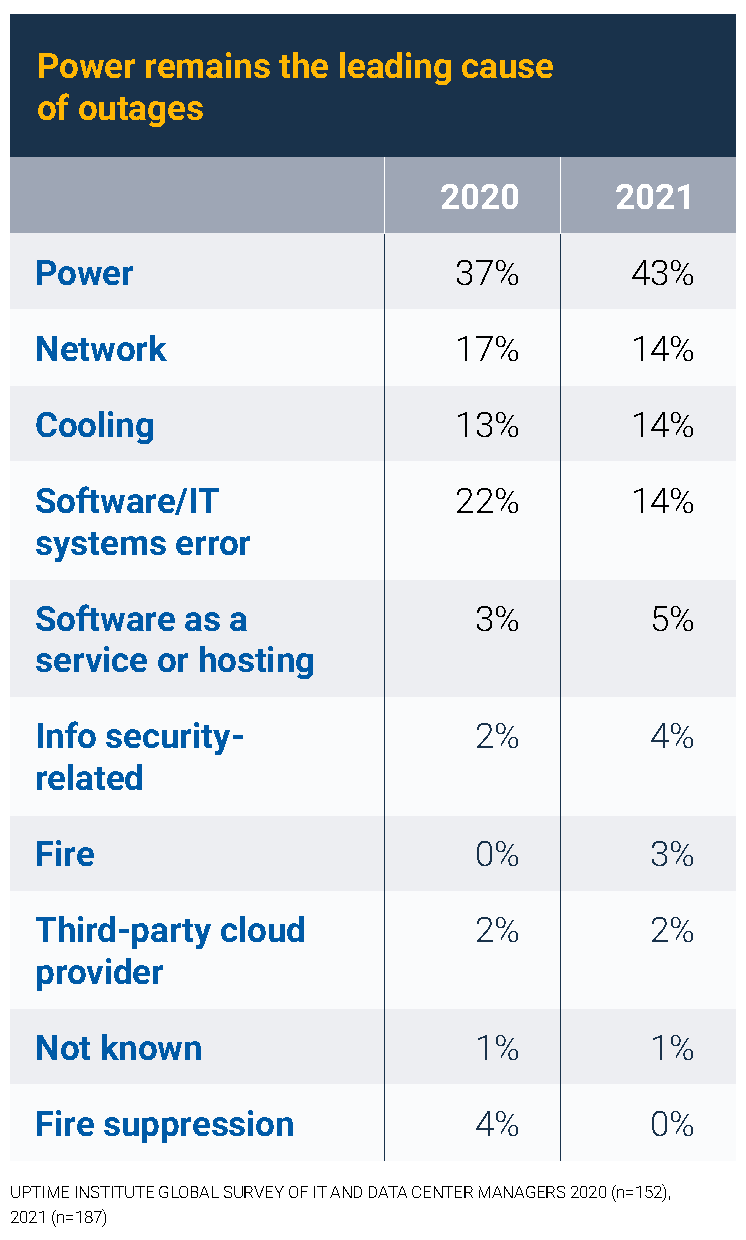

3. Ausfallursache Nr. 1: Probleme mit der Stromversorgung

Nach den Hauptursachen für größere Ausfälle (ohne minimale und geringfügige) befragt, gaben 43 Prozent der Datacenter-Betreiber Probleme mit der Stromversorgung an. Drei weitere Ursachen sind besonders besorgniserregend, sie schlagen mit jeweils 14 Prozent zu Buche: Ausfälle des Kühlsystems, Software-/IT-Systemfehler und Netzwerkprobleme. Alle anderen Ausfallursachen sind selten, obwohl die Häufigkeit von Problemen bei Drittanbietern schleichend zunimmt – beispielsweise bei Software-as-a-Service-, Hosting- oder Public-Cloud-Angeboten.

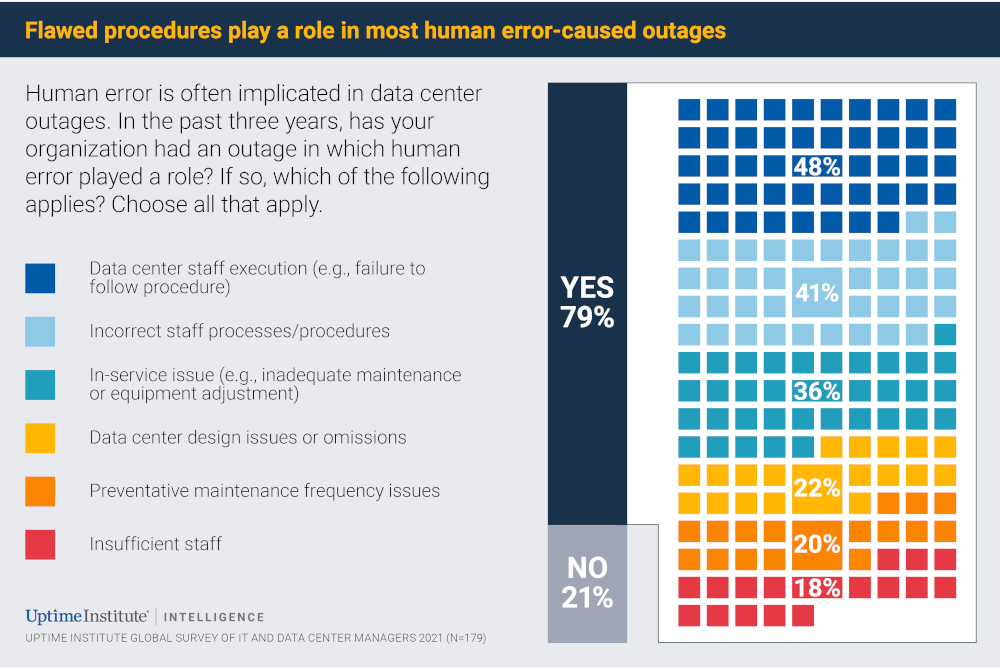

4. Verfahrensmängel begünstigen menschliches Versagen

Das Uptime Institute befragte Datacenter-Betreiber auch, ob sie in den vergangenen Jahren Ausfälle hatten, in denen menschliches Versagen eine Rolle spielte. Dies verneinten 21 Prozent der Befragten. Bei den übrigen 79 Prozent verteilten sich die Ursachen auf: 48 Prozent fehlerhafte Ausführung durch RZ-Mitarbeiter (z.B. Nichteinhaltung von Verfahren), 41 Prozent unpassende Mitarbeiterprozesse, 36 Prozent Probleme bei der Inbetriebnahme, 22 Prozent Versäumnisse bei der RZ-Planung, 20 Prozent Probleme mit der vorbeugenden Wartung sowie 18 Prozent unzureichendes Personal – Mehrfachnennungen waren hier möglich.

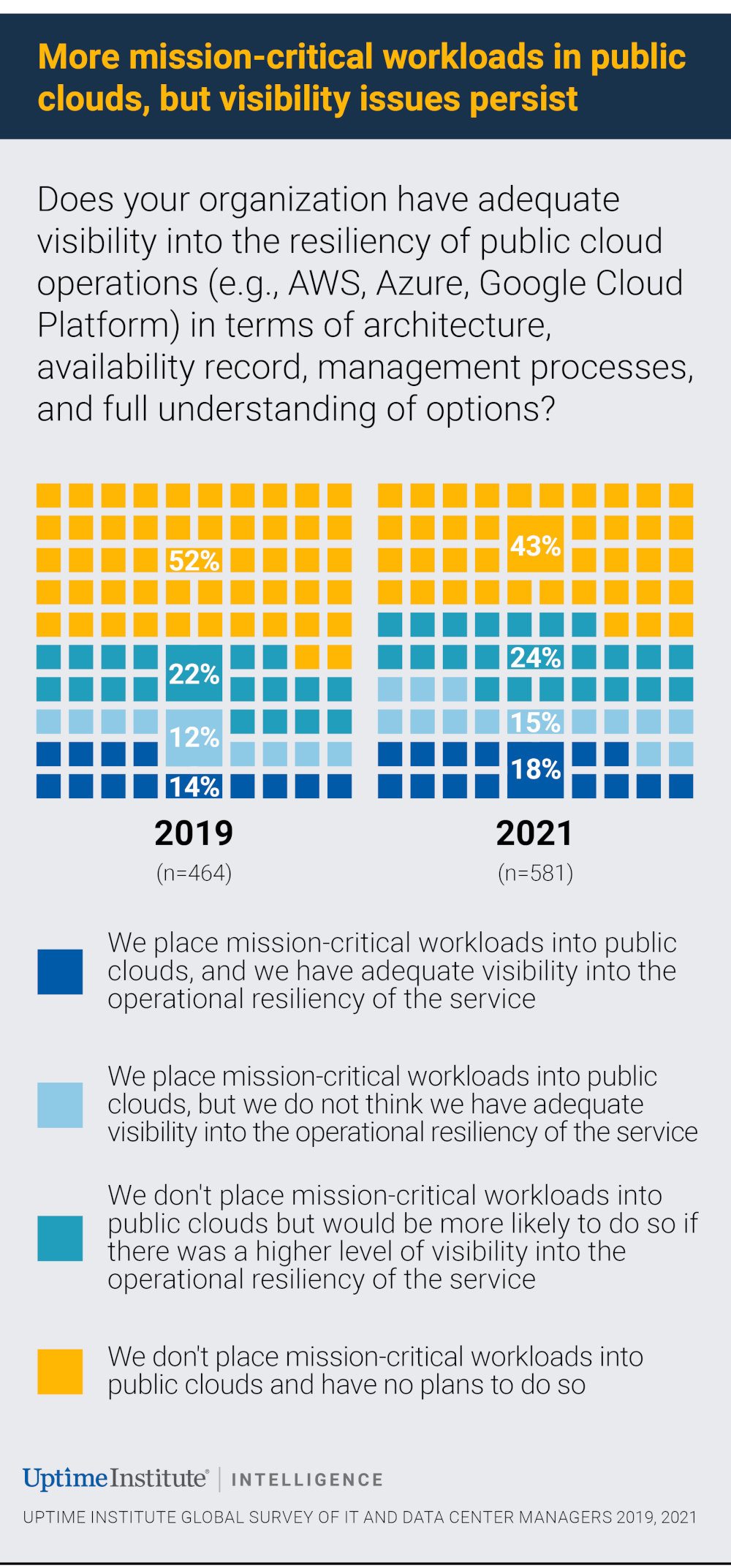

5. Transparenzlücke bei Public-Cloud-Anbietern

Immer mehr Unternehmen verlagern Anteile ihrer IT-Arbeitslasten in die Public Cloud und machen sich damit abhängig von den Maßnahmen, die Cloud-Anbieter für Ausfallsicherheit ergreifen – zum Beispiel im Hinblick auf Architektur, Verfügbarkeit oder Managementprozesse. Das Uptime Institute befragte diese Unternehmen nach der Transparenz ihrer Cloud-Anbieter. Dass unternehmenskritische Arbeitslasten zunehmend in öffentliche Clouds verlagert werden, legt bereits nahe, dass diese Cloud-Kunden das Maß an Transparenz für ausreichend halten. Ein Viertel der Befragten zögert allerdings, kritische Arbeitslasten in öffentliche Clouds zu verlagern – würde dies aber wahrscheinlich tun, wenn die Transparenz rund um die Ausfallsicherheit größer wäre.

Risiken systematisch bewerten – und minimieren

Wenn Unternehmen die Ausfallrisiken für ihre eigenen Rechenzentren oder für die Services ihrer Datacenter-Dienstleister reduzieren wollen, müssen sie sich zunächst einen möglichst objektiven und systematischen Überblick über die konkreten Services und die damit verbundenen Risken verschaffen. Dies ist schon aus der Innenperspektive des RZ-Betreibers oft schwierig. Wichtige Risikofaktoren und Schwachstellen zum Beispiel in der RZ-Anlage, bei der Infrastruktur oder in den Verfahren und Prozessen werden leicht übersehen. Daher lohnt es sich, spezialisierte Dienstleister, zu denen auch das Uptime Institute gehört, hinzuzuziehen. Im Idealfall bewerten diese Dienstleister die Risiken nach standardisierten neutralen Verfahren und gelangen so zu einer klaren Einschätzung und Klassifizierung. Denn Schäden im zweistelligen Millionenbereich wollen Rechenzentrumsbetreiber ebenso dringend vermeiden wie ihre Kunden.

uptimeinstitute.com