NVMe-over-TCP/RoCE ist dabei Fibre-Channel den Rang abzulaufen. So lautet jedenfalls die gängige Meinung, auch bei unserem Doc Storage. Dem sei jedoch mitnichten so, widerspricht Nishant Lodha. Wir sprachen Marvells Director of Technical Marketing über die Zukunft von FC und warum Fibre-Channel die Vorteile nach wie vor auf seiner Seite hat.

◼ NVMe-over-TCP soll in Zukunft FC-SAN ersetzen, unser Doc Storage hat dies in einem ausführlichen Beitrag beschrieben. Natürlich sehen Sie das anders. In welchen Bereichen hat Fibre Channel noch seine Rechtfertigung/Vorteile?

Lodha: In vielen meiner Gespräche über Fibre-Channel-Speichernetzwerke (FC) werde ich nach der Wahrscheinlichkeit gefragt, ob FC für die Server-zu-Speicher Verbindung durch NVMe/TCP ersetzt wird. Dabei basieren die Fragen auf Missverständnissen wie zum Beispiel Ethernet ist einfacher zu bedienen und zu verwalten, ist kostengünstiger und hat heute schon eine höhere Bandbreite als Fibre-Channel. Ich sage bewusst Missverständnisse, denn wenn es um Speicherkonnektivität geht, gibt es mehr als nur ein wichtiger Faktor, der ins Spiel kommt.

Nehmen wir die These Ethernet ist einfacher zu bedienen und zu verwalten: Für die Einrichtung von NVMe/TCP sind heute Dutzende von Konfigurationsschritten erforderlich, da keine automatisierte Erkennungstechnologie in das TCP-Protokoll oder in den Ethernet-Switches integriert ist. Skripts müssen vor der Bereitstellung erstellt, getestet und geprüft werden. Viel Arbeit, nur um das Netzwerk so zu konfigurieren, dass Geräte miteinander kommunizieren können.

Um dieser Komplexität zu begegnen, führen einige Speicheranbieter Software-Lösungen wie CDC (Centralized Discovery Controller) und DDC (Direct Discovery Controllers) ein, um alle angeschlossenen Server und Speichersysteme über Ethernet bekannt zu machen. zu erkennen. Diese Lösungen sind meistens auf virtuellen Maschinen (VM) installiert. Das bedeutet, dass neue Software verwaltet werden muss, neue CPU- und Speicher-Ressourcen erforderlich sind sowie zusätzliche Komplexität und neue Technologien für Netzwerk- und/oder Speicheradministratoren erlernt werden müssen.

Im Vergleich dazu wird beim FC-Speichernetzwerk die Nameserver-Technologie seit Jahrzehnten eingesetzt und ist in jeden Switch in der Fabric eingebettet. Jedes Mal, wenn ein Gerät mit der FC-Fabric verbunden ist, wird es protokolliert und kann für die Zoneneinteilung und den Zugriff durch jedes andere Gerät zur Verfügung gestellt werden. Dies ermöglicht ein vereinfachtes Zoning. Die gesamte Fabric lässt sich mit nur wenigen Klicks von der Switch-Software aus verbinden und einrichten. Es sind keine zusätzlichen Software- oder Server-Ressourcen erforderlich. Dies ist viel einfacher als der Versuch, Ethernet-Netzwerke für die Speicheranbindung zu konfigurieren.

◼ Ethernet besitzt aber eine höheren Bandbreite bei gleichzeitig niedrigeren Kosten?

Lodha: Ethernet ist heute mit 100- und 200GbE-Host-Konnektivität verfügbar, was viel höher ist als FC, welches bei 16-, 32- und 64Gbit-Bandbreiten liegt. Während dies auf dem Papier gut aussieht, sind heute auf dem Markt nur sehr wenige Speicherlösungen verfügbar, die 100GbE oder 200GbE unterstützen. Was nützt eine extrem hohe Bandbreite auf dem Host, wenn das Speichergerät diese in den meisten Fällen nicht unterstützen kann?

Wenn es um die Kosten geht, wissen viele Leute nicht, dass FC-HBAs mit optischen Transceivern ausgeliefert werden, und Ethernet-NICs nicht. Der Vergleich des Preises eines HBA mit dem einer NIC ist ein Vergleich von Äpfel und Birnen, insbesondere bei höheren Bandbreiten, bei denen optische Konnektivität für Ethernet erforderlich ist. Das Gleiche gilt in der Regel für die FC-Switches, bei denen in der Regel die optischen Transceiver im Preis enthalten sind. Das ist bei den Ethernet-Switch-Preise so nicht der Fall.

Darüber hinaus steigen mit zunehmender Ethernet-Bandbreite die Kosten sowohl für die Switching-Infrastruktur als auch für die zu verwendenden optischen Kabel und Steckverbinder deutlich an. Bei 100GbE und höher können aktive optische Kabel (AOC) als »kostengünstige« Option verwendet werden, aber diese haben bereits Listenpreise, die weit über 1.000 US-Dollar pro Kabel liegen. Das Missverständnis hier ist, dass bei der Betrachtung von Ethernet oder FC die meisten Kunden nur die NIC-Kosten mit den HBA-Kosten vergleichen. Das ist nur ein Teil der Gesamtlösung. Verkabelungs- und Switching-Infrastrukturkosten müssen auch einbezogen werden, und dann hat eine Ethernet-Konfiguration nur geringfügig niedrigere Kosten als FC (Bei größeren Bandbreiten sind diese sogar höher als bei FC).

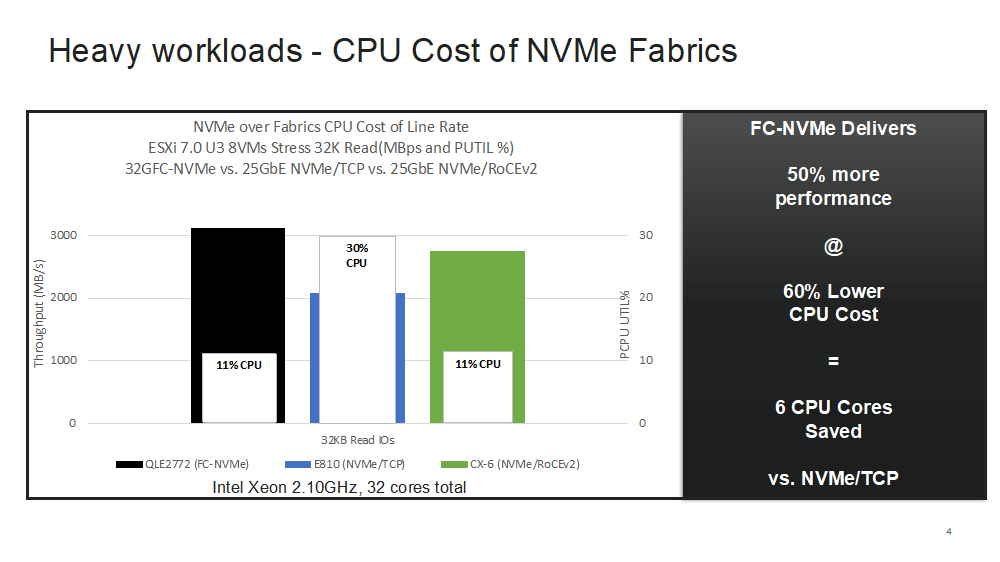

FC basiert auf einer »Offload«-Architektur, was bedeutet, dass das Netzwerkprotokoll auf dedizierten ASICs im HBA ausgeführt wird. Im Vergleich zu TCP werden dadurch die benötigten CPU-Rechenleistungen auf ein Minimum reduziert. Für bestimmte unternehmensweite Anwendungen wird dadurch die Anzahl der benötigten CPU-Cores reduziert. Dies spart in vielen Fällen auch Software-Lizenzen ein, die an die Zahl der Cores gebunden sind. Ethernet ist aus Sicht der CPU-Ressourcen nicht so effizient. Standard-Ethernet-NICs ohne RDMA-Aktivierung haben keine Offload-Architektur, was bedeutet, dass die gesamten I/O Verarbeitung über die Server-CPU laufen. Sehen Sie sich dazu die Ergebnisse eines Leistungstests an, der vom US-amerikanischen Speichermagazin StorageReview veröffentlicht wurde.

◼ Vermutlich sehen Sie auch Leistung und Effizienz auf FC-Seite?

Lodha: Bei unternehmenskritischen Anwendungen muss der Speicherzugriff mit einer vorhersehbaren Leistung erfolgen. Dabei sind die Zugriffsanforderungen dieser Anwendungen an das Netzwerk alles andere als statisch. Um diese dynamischen Workloads optimal zu bedienen, wurde FC von Grund auf für die In-Order-Frame-Bereitstellung entwickelt, der Schlüssel zur vorhersagbaren Netzwerkleistung. Darüber hinaus verfügen FC-Switches und HBAs über eine Technologie, die darauf ausgelegt ist, Netzwerküberlastungen automatisch zu erkennen und zu beheben.

Umgekehrt wurde Ethernet nie entwickelt, um die Zustellung der Datenpakete zeitnah zu garantieren oder Staus zu minimieren. Paketverluste werden akzeptiert und durch erneutes Senden korrigiert. Ja, verlustfreies Ethernet ist eine Option – aber es erhöht die Komplexität der Bereitstellung und Verwaltung erheblich.

Während Leistungsdaten von Ethernet in Bezug auf Bandbreite und IOPS beeindruckend sein können, werden die meisten davon mit sehr kleinen Paketgrößen (512 Bytes oder weniger) erreicht. Während solche Paketgrößen im IP-Netzwerkverkehr üblich sind, sind diese jedoch für den Speicherdatenverkehr nicht relevant. Die meisten Blockgrößen, die für Speicher-Workloads verwendet werden, sind 8 bis 64 KByte und höher, und die IOPS-Leistung ist durch die Blockgröße begrenzt. Sowohl Ethernet-NICs als auch FC-HBAs verfügen über ausreichend Bandbreite, um Speicheranwendungen zu unterstützen, die bei diesen Blockgrößen ausgeführt werden.

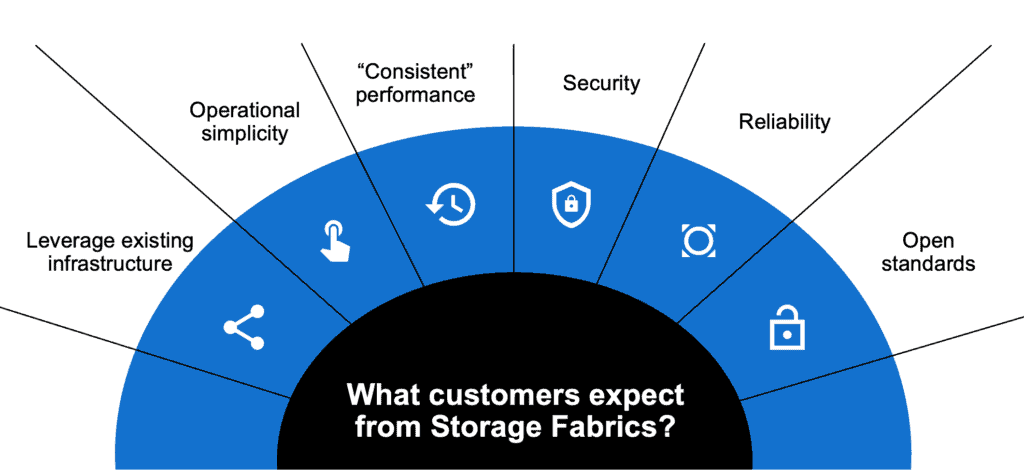

Zusammenfassend kann man sagen, dass die Wahl des Protokolls für die Server-/Speicher-Anbindung immer von den Kundenanforderungen abhängt. Benötigt der Kunde zusätzlich zur herkömmlichen Blockspeicher-Technologie auch Datei- oder Objektbezogene Speicherung, ist Ethernet die einzige Wahl (FC unterstützt nur Blockspeicher). Wenn die Hauptanforderung niedrige Kosten ist, wobei Zuverlässigkeit, Leistung und Skalierbarkeit weiter unten auf der Prioritätenliste stehen, dann ist NVMe/TCP eine gute Wahl. Verwendet der Kunde jedoch Blockspeicher und sucht nach sicherer, zuverlässiger, hoher und vorhersehbarer Zugriffsleistung, die dazu noch relativ einfach zu konfigurieren und zu verwalten ist, dann ist FC mit Abstand die beste Wahl.

◼ Wie ist aus Ihrer Sicht der aktuelle Stand von Fibre-Channel?

Lodha: Der FC-Markt bleibt gesund und stabil, wir sehen weiterhin eine starke Kundennachfrage – sowohl durch existierende FC-Kunden als auch durch neue Kunden. Die meisten Installationen erfolgen dabei auf virtuellen Serverplattformen – beispielswise VMware vSphere. Lassen Sie mich einige öffentlich zugängliche Kennzahlen rund um Fibre-Channel von einem US-amerikanischen Analystenhaus zitieren:

- »Der Umsatz für den gesamten FC-SAN-Markt (FC-Switches + FC-Adapter) stieg im 1Q22 das vierte Quartal in Folge und stieg im Jahresvergleich um 11 % auf 613 Mio. USD bei 6 % mehr FC Ports von 1,82 Millionen«, so der SAN-Bericht 1Q 2022 von Quillin Research.

- »Laut Quillin Research wird die Fibre-Channel-Industrie bis Ende 2021 über 150 Millionen FC Ports ausgeliefert haben. Sie schätzen, dass heute davon fast 50 Millionen Fibre-Channel-Ports in Betrieb sind.«

Aus meiner Sicht wird weiterhin sehr viel in die FC-Infrastruktur investiert, und wenn mir meine Erfahrung eines sagt – dann ist es, dass die Kunden nicht einfach eine Sache komplett aufgeben und mit etwas ganz Neuem wieder anfangen. Fibre Channel erweist sich bezüglich Veränderungen in der Speichernetzwerk Technologie als »sehr träge«.

Im Laufe der Jahre oder eher Jahrzehnte gab es viele alternative Fabrics wie iSCSI, FcoE und IB/RDMA, die Fibre-Channel ersetzen sollten. Die Geschichte hat aber gezeigt, dass es sehr schwierig (nicht unmöglich) ist, die Zuverlässigkeit, Leistung und Installationsbasis von Fibre-Channel zu duplizieren.

◼ Welche Entwicklungsschritte sind in den kommenden Monaten/Jahren zu erwarten? Schlagwort: FCoE

Lodha: FCoE ist in unserer Industrie bereits Vergangenheit. Ja, es gab eine Zeit, in der es als Ersatz oder sollte ich sagen Konvergenz von FC in Ethernet geplant war. Aber das ist so einfach nicht passiert. Heute sind die FCoE-Installationen stark rückläufig und der einzige sinnvolle Einsatz findet noch in Blade-Server-Architekturen statt.

Fibre-Channel auf der anderen Seite hat sich stark weiterentwickelt – mit erheblichen technologischen und funktionellen Weiterentwicklungen, die über die reinen Geschwindigkeitszahlen und Fakten hinausgehen (z. B. 16GFC, 32GFC, 64GFC).

Eine solche neue Funktion ist FC-NVMe, das heißt, NVMe über Fibre-Channel. Dies ist ein neuer Standard. Mit FC-NVMe erhalten Sie die gleichen Vorteile wie mit SCSI-basiertem Fibre-Channel-Protocol (FCP) und noch mehr. FC-NVMe wird vollständig im »Offload«-Betrieb ausgeführt, um hohe Leistung, geringe Latenz und geringe CPU-Auslastung zu ermöglichen sowie die Möglichkeit zu bieten, SCSI- und NVMe-Datenverkehr gleichzeitig in derselben SAN-Fabric (Storage Area Network) zu unterstützen. FC-NVMe nutzt die vorhandene Fibre-Channel-Nameserver-Technologie für eine einfache Erkennung/Installation, es ist von anderen Netzwerken komplett getrennt (Air-Gap-Sicherheit) und basiert auf einer zwei Jahrzehnte bewährten Technologie.

Die Implementierung von FC-NVMe ist ebenfalls einfach. Existierendes muss nicht ersetzt werden, da gleichzeitig SCSI und FC-NVMe im selben SAN unterstützt sind. So lassen sich neue FC-NVMe-Arrays mit den vorhandenen SCSI-Arrays im SAN kombinieren. In den meisten Fällen sind dabei keine Änderungen am Server erforderlich, um den FC-NVMe-Speicher dem SAN hinzuzufügen. Es müssen keine Treiber aktualisiert werden und das Ganze geht unterbrechungsfrei.

Die FC-Branche ist rund um FC-NVMe weiterhin innovativ und hat mit FC-NVMe v2 einen erweiterten Standard definiert, der eine effizientere Fehlerbehebungsmethode ermöglicht. Auch kümmern wir uns darum, dass im Speichernetzwerk nicht nur eine hohe Leistung, sondern auch eine konstant gute Leistung erreicht wird. Dies ist deshalb eine Herausforderung, weil es durch das Hinzufügen von neuen superschnellen NVMe-Speichersystemen in Kombination mit existierenden FC-Arrays zu Datenstau (Congestions) im SAN kommen kann.

Durch die SAN Congestion Mitigation-Funktion können Switches mit HBAs mit Hilfe der Fabric Performance Impact Notifications (FPIN) kommunizieren und damit einen Datenstau im SAN erkennen und beheben. Wir nennen dies das selbstheilende SAN.

Es gibt auch andere Verbesserungen wie die Virtual Machine-ID (VM-ID). Diese ermöglicht es den SAN- und VM-Administratoren jeweils die VMs zu identifizieren, welche den meisten Datenverkehr im SAN verursachen. QLogic-HBAs von Marvell unterstützen heute VM-ID und man kann diese Funktion nutzen, ohne dass das Speicher-Array VM-ID-fähig ist.

Für zusätzliche Sicherheit können bestimmte FC-HBAs die Daten für die Übertragung verschlüsseln. Dies erfordert allerdings eine End-to-End Unterstützung und ist heute mit Speicherlösungen wie IBM Z Fibre Channel Endpoint Security auf einigen IBM-Arrays verfügbar.

Zusammengefasst kann man sagen, dass Fibre-Channel das perfekte Protokoll für ein NVMe-basiertes Rechenzentrums ist. Nur weil es FC schon lange gibt, heißt das nicht, dass die Zeit für das Protokoll abgelaufen ist.

◼ Wie aktuell ist die FC-Roadmap auf fibrechannel.org?

Lodha: Das Fibre-Channel-Gremium ist gerade in den letzten Zügen, um den 128GFC-Standard zu verabschieden. Bis Ende des Jahres erwarte ich, dass sie mit der Arbeit am 256GFC-Standard beginnen und dies bis 2025 erledigt haben.

◼ Wie vergleichbar sind FCoE und NVMe-over-TCP/RoCE?

Lodha: Zwei davon liegen in der Vergangenheit – FCoE (ferne Vergangenheit) und NVMe/RoCE (Vergangenheit). NVMe/TCP ist ein Anwärter auf Speicher-Fabrics der Zukunft. Ich möchte hinzufügen, dass wir weiterhin kleine Implementierungen von NVMe/RoCE speziell bei AI/ML-Kunden sehen sollten, aber wenig darüber hinaus.

Ehrlicherweise müssen wir zugeben, dass NVMe/TCP zumindest aus Sicht der Standards das Potenzial hat, im Kampf, um die Enterprise-Storage-Fabric mit Fibre-Channel zu bestehen. Die NVMe-Gruppe unternimmt lobenswerte Anstrengungen, um einige der wichtigsten Merkmale von Fibre-Channel in NVMe/TCP zu duplizieren. Die Nameserver- und Discovery-Services, die FC seit Jahrzehnten bietet waren die Inspiration für die NVMe/TCP-Spezifikationen rund um Centralized Discovery Services (CDC) und in jüngster Zeit wurde sogar das Konzept des Zoning bei Fibre Channel übernommen.

Die Frage ist: Reicht das aus, um NVMe/TCP erfolgreich zu machen? Ich glaube nicht, dass dies der Fall ist, und die Zeit wird es sicherlich zeigen. Diese Einschätzung basiert auf Jahrzehnte langer eigener Erfahrung, die ich beim Design von Speichernetzwerken gesammelt habe.

◼ Worauf sollten IT-Manager beim Upgrade bestehender (SAN-)Infrastrukturen achten?

Lodha: IT-Manager müssen den Bedarf zukünftiger Workloads abschätzen und immer versuchen die vorhandene Rechenleistung noch effizienter zu nutzen. Dazu gehört auch zwingend eine kontinuierliche Anpassung der Speichernetzwerkinfrastruktur.

32GFC gibt es seit drei Jahren und auf der Server-Seite sehen wir erst jetzt, dass 32GFC die frühere 16GFC-Technologie in Bezug auf Anzahl verkaufter Ports übertrifft. Diese langsame Migration auf die höhere Geschwindigkeit liegt vor allem an der Verfügbarkeit von Enterprise-Storage-Arrays mit 32GFC. In der Regel ersetzen Kunden im ersten Schritt die vorhandenen FC-Switches und -Direktoren mit schnelleren Produkten, bevor dasselbe auf der Server- und Storage-Seite gemacht wird.

Um die Anforderungen beim Datenzugriff für die nächsten zwei bis drei Jahre erfüllen zu können, sollten IT-Manager ihre FC Switches heute mindestens auf 32GFC oder besser auf 64GFC aufrüsten. Es gibt zwar heute noch keine Speicher-Arrays mit 64GFC, jedoch erwarten wir die ersten verfügbaren Produkte Mitte bis Ende 2022 oder Anfang 2023. Gleichzeitig mit dieser Verfügbarkeit kann man dann auch die FC-HBAs im Server auf den 64GFC-Standard aufrüsten. Der größte Hemmschuh dabei sind allerdings die Verfügbarkeit und die hohen Preise für die notwendigen SFPs (Transceiver).

◼ FC wird uns also noch erhalten bleiben.

Lodha: Davon gehe ich aus. Fibre-Channel hat eine sehr große installierte Basis und das Vertrauen von den Kunden gewonnen, die geschäftskritische Anwendungen zusammen mit gemeinsamem Speicher einsetzen. Dieser Erfolg ist beispiellos und mit den Innovationen rund um FC-NVMe, Congestion-Mitigation und VM-Tracking erwarte ich, dass Fibre-Channel weiterhin die erste Wahl für geschäftskritische Anwendungen sein wird.

Weiterführende Links