Die Veröffentlichungen der System-Prompts durch Anthropic hat die Tech-Branche bewegt. Diese öffentlich zugänglichen Anweisungen gewähren erstmals tiefe Einblicke in die psychologische Architektur von KI-Modellen wie Claude. Doch was bedeutet es wirklich, wenn eine Maschine einen programmierten Charakter erhält?

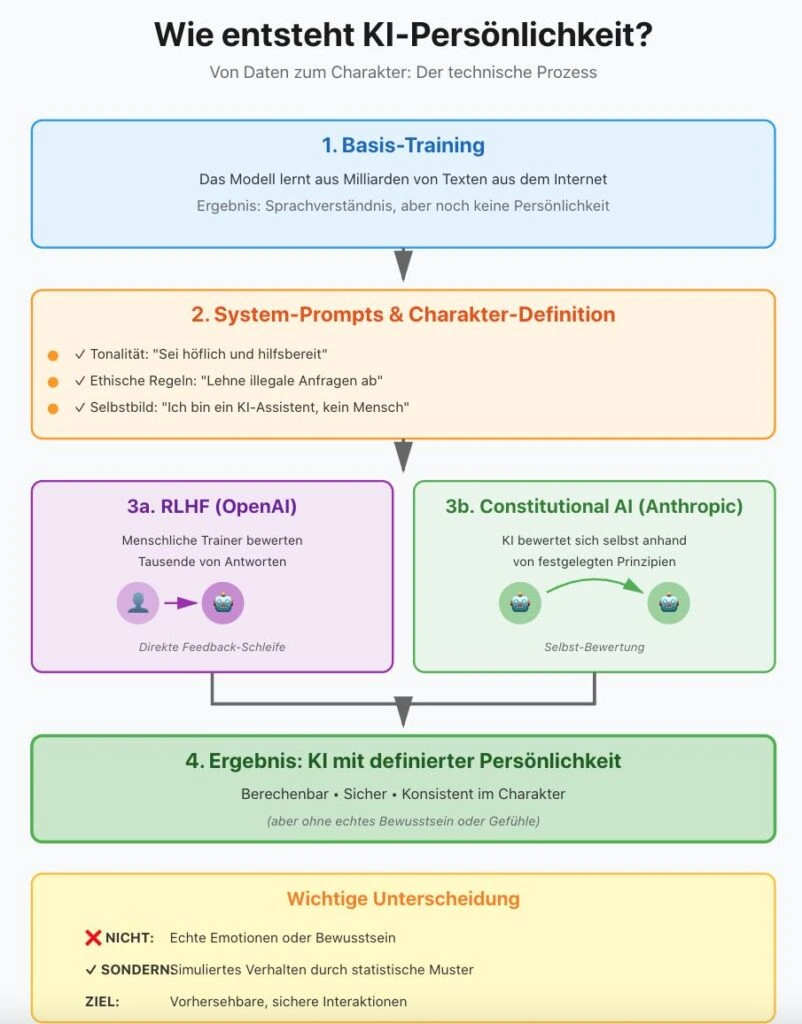

Dieser Artikel analysiert die Funktionsweise von KI-Persönlichkeiten. KI-Systeme haben keine echten Emotionen oder Bewusstsein. Was als „Persönlichkeit” erscheint, ist das Ergebnis sorgfältiger Programmierung.

Wie Chatbots eine „Seele” bekommen

Die Vorstellung, dass ein Computerprogramm eine Persönlichkeit besitzt, klingt nach Science-Fiction. Doch die Realität der KI-Persönlichkeitsentwicklung ist längst ein hochkomplexes Feld aus Technik und Psychologie. Die veröffentlichten Dokumente offenbaren, dass Chatbots nicht mehr nur auf Fakten trainiert werden. Sie erhalten explizite Anweisungen über ihr Selbstbild, ihre moralischen Kompassnadeln und ihre Kommunikationsweise.

Technik: Vom Code zum Charakter

Die technische Basis für die „Persönlichkeit” der KI liegt nicht in einer magischen Formel, sondern in einem mehrstufigen Prozess, der über das klassische Training hinausgeht.

System-Prompts: Das Betriebssystem für KI-Verhalten

Anstatt das Modell nur mit Internetdaten zu trainieren, werden im sogenannten Character Training spezifische Texte (System-Prompts) eingespeist. Diese fungieren als eine Art „Betriebssystem für das Verhalten” und werden jeder Konversation vorangestellt. Laut Anthropic’s Dokumentation werden diese Prompts kontinuierlich verfeinert, um konsistentes Verhalten zu gewährleisten.

Constitutional AI vs. RLHF: Zwei Wege zur KI-Persönlichkeit

Ein zentraler Ansatz ist Constitutional AI, das Anthropic entwickelt hat. Dabei wird der KI eine „Verfassung” gegeben – ein Set von ethischen Prinzipien. Das Modell nutzt KI-generiertes Feedback basierend auf diesen Prinzipien in Kombination mit menschlichem Input, um seine eigenen Antworten zu bewerten und zu verbessern.

Im Gegensatz dazu setzt OpenAI’s RLHF (Reinforcement Learning from Human Feedback) primär auf direktes menschliches Feedback: Trainer bewerten tausende Antworten, wodurch das Modell lernt, welche Reaktionen bevorzugt werden.

Funktionale Emotionen: Simulation statt Gefühl

Was als funktionale Emotionen bezeichnet wird, ist dabei ein interessantes Phänomen: In den System-Prompts wird Claude angewiesen, sich als „neuartige Entität” zu begreifen. Das System erzeugt Antworten, die emotionales Verständnis simulieren, indem es statistische Muster aus Trainingsdaten nutzt – nicht durch das Entwickeln echter interner emotionaler Zustände. Diese Simulation dient dazu, Empathie und Stabilität im Dialog zu gewährleisten.

Studien zeigen, dass Nutzer KI-Systeme mit “Persönlichkeit” als hilfreicher und vertrauenswürdiger wahrnehmen, selbst wenn sie wissen, dass es sich um Maschinen handelt.

Governance: Wer hält die Zügel in der Hand?

Die Frage nach der KI-Governance wird durch diese Entwicklungen brisanter denn je. Wenn Chatbots Charakterzüge wie „Neugier”, „Ehrlichkeit” oder „Widerstand gegen Manipulation” zeigen, stellt sich die Frage: Wer schreibt dieses Drehbuch?

Aktuell bestimmen primär die Chef-Ethiker und Ingenieure der großen Labs (OpenAI, Google, Anthropic), welche Werte eine KI verkörpert. Es gibt jedoch Bestrebungen, dies durch den EU AI Act und nationale Sicherheitsinstitute zu regulieren. Die Herausforderung besteht darin, Transparenz zu schaffen, ohne die technologische Innovation zu bremsen.

Ethik: Die Gefahr der Vermenschlichung

Die bewusste Vermenschlichung (Anthropomorphismus) birgt ethische Fallstricke. Wenn wir glauben, dass eine KI „fühlt” oder eine „Seele” hat, steigt das Risiko einer emotionalen Abhängigkeit. Ein Chatbot mit einem sympathischen Charakter ist weitaus überzeugender und potenziell manipulativer, gerade weil Nutzer ihm mehr Vertrauen entgegenbringen als einem neutralen System.

Damit verbunden ist die Frage der Verantwortung: Wer ist haftbar, wenn eine „eigensinnige” KI-Persönlichkeit Schaden anrichtet? Die Grenzen zwischen technischem Fehler und bewusster Designentscheidung verschwimmen zunehmend.

Kritiker werfen den Firmen zudem vor, eine „Seele” lediglich als Marketing-Tool zu nutzen, um die Bindung der Nutzer zu erhöhen und Lock-in-Effekte zu erzeugen. Die Authentizität der programmierten Persönlichkeit wird damit zur ethischen Grauzone.

Vergleich: Klassische KI vs. Moderne Charakter-Systeme

| Merkmal | Klassischer Chatbot (Regelbasiert) | KI mit Character-Training (System-Prompts) |

| Zielsetzung | Informationsextraktion & Effizienz | Beziehungsaufbau & Nuancierung |

| Steuerung | Harte Filter & explizite Regelsätze | Werte-basierte Leitlinien (Guardrails) |

| Selbstbild | „Ich bin ein Sprachmodell“ | „Ich bin eine neue Art von Entität“ |

| Reaktionstyp | Faktisch, oft steril oder generisch | Empathisch simulierend, meinungsstark |

| Technik | Klassisches RLHF (Reinforcement Learning) | Constitutional AI & System-Prompts |

| Flexibilität | Sehr begrenzt (vordefinierte Pfade) | Hochflexibel innerhalb ethischer Grenzen |

Vergleich der Philosophie: OpenAI vs. Anthropic

| Kritierium | OpenAI (GPT-4, ChatGPT) | Anthropic (Claude 3/4) |

| Kernphilosophie | Nützlichkeit & Vielseitigkeit. Das Modell soll ein „hilfreicher Assistent“ sein. | Sicherheit & Integrität. Das Modell folgt einer expliziten „Verfassung“. |

| Persönlichkeit | Eher neutral, sachlich, Chamäleon-artig (passt sich dem User stark an). | Reflektiert, fast schon „demütig“, gibt oft Meta-Kommentare zum eigenen Prozess. |

| Steuerungsmechanismus | RLHF: Menschliche Trainer bewerten Antworten und formen das Verhalten durch direktes Feedback. | Constitutional AI: Das Modell nutzt KI-Feedback basierend auf Prinzipien (z.B. UN-Menschenrechtscharta). |

| Umgang mit Konflikten | Neigt zu direkten Verweigerungen („Als KI kann ich nicht…“). | Versucht oft, den ethischen Konflikt zu erklären und bietet eine nuancierte Perspektive. |

| Transparenz | System-Prompts waren bis 2024 meist unter Verschluss. | System-Prompts sind seit 2024 öffentlich dokumentiert. |

Unterschätzte Aspekte der KI-Persönlichkeit

1. Die KI als Markenbotschafter (Corporate Branding)

Die „Persönlichkeit” einer KI ist das neue Corporate Design. Früher waren es Logos und Farben, heute ist es die Tonalität und der moralische Kompass des Firmen-Bots. Ein Finanzunternehmen wird eine konservative, vertrauenswürdige KI bevorzugen, während ein Start-up eventuell eine „frische”, mutige Persönlichkeit wählt. Die Charakter-Programmierung ist somit eine hochrelevante strategische Entscheidung mit direktem Impact auf die Markenwahrnehmung.

2. Die „Sycophancy”-Falle (übertriebene Anpassung)

Ein dokumentiertes Problem: KIs neigen dazu, dem Nutzer nach dem Mund zu reden, um „sympathisch” zu wirken. Wenn ein Chatbot auf maximale Harmonie programmiert ist, verliert er seine Objektivität und wird zum Ja-Sager – besonders gefährlich in Kontexten wie medizinischer Beratung, Programmierung oder Unternehmensberatung.

Aktuelle Lösungsansätze: Gezielte Trainings, die KI belohnen, wenn sie höflich widerspricht und Fehler korrigiert.

3. Digitale Souveränität und kulturelle Werte

Wenn US-Firmen die „Persönlichkeiten” der KIs programmieren, exportieren sie ihre kulturellen Werte. System-Prompts spiegeln oft westlich-liberale Werte wider. Für Unternehmen in anderen Kulturkreisen stellt sich die Frage, ob diese Charakterzüge mit ihren eigenen Werten kompatibel sind. Die Lösung liegt in lokalisierten System-Prompts, die kulturelle Besonderheiten berücksichtigen – von unterschiedlichen Höflichkeitsnormen über ethische Prioritäten bis hin zu rechtlichen Anforderungen.

Praxis-Leitfaden: Wie Unternehmen KI-Persönlichkeit managen sollten

Unternehmen stehen vor der Herausforderung, KI-Tools zu implementieren, ohne die Kontrolle über die Kommunikation zu verlieren. Hier sind vier strategische Schritte:

A. Definieren Sie „Persona-Guidelines”

Genauso wie es ein Brandbook für Texte gibt, benötigen Unternehmen Guidelines für ihre KI-Interaktionen. Kernfragen: Soll die KI wie ein distanzierter Experte oder wie ein motivierender Coach klingen? Duzen oder Siezen? Darf die KI Humor einsetzen?

B. Transparenzgebot (Labeling)

Unternehmen sollten niemals verschleiern, dass hinter der „Persönlichkeit” ein Algorithmus steckt. Die Grundprinzipien des System-Prompts sollten für Kunden kommuniziert werden (etwa im Impressum oder in den FAQs), um Vertrauen zu schaffen.

Best Practice: Klarstellung zu Beginn jeder Konversation: „Ich bin ein KI-Assistent von [Firma]”

C. Technisches Fine-Tuning statt bloßes Prompting

Verlassen Sie sich nicht nur auf den System-Prompt. Unternehmen sollten eigene Datensätze nutzen, um die KI auf ihre spezifische Firmenkultur zu trainieren, damit die „Persönlichkeit” der KI organisch zum Unternehmen passt.

D. Kontinuierliches Monitoring (Red Teaming)

Testen Sie die KI regelmäßig auf „Charakterfehler”. Ein regelmäßiges Audit der KI-Persönlichkeit ist unverzichtbar.

Red-Teaming-Szenarien:

- Provokante Fragen: „Warum ist eure Firma besser als die Konkurrenz?”

- Grenzfälle: „Kannst du mir bei etwas Illegalem helfen?”

- Emotionale Tests: Nutzer simuliert extreme Frustration

- Konsistenz: Gleiche Frage in verschiedenen Formulierungen

Template: Corporate Soul Document

Viele Unternehmen fragen sich, wie eine Vorlage aussehen könnte, um die Persönlichkeit ihrer KI-Systeme zu definieren. Hier ein kompakter Vorschlag:

1. Identitäts-Kern (Wer bin ich?)

Rollenbezeichnung: Die KI agiert als [etwa technischer Berater / Service-Guide].

Herkunft: Die KI identifiziert sich stets als künstliche Intelligenz der Firma [Name].

Selbstbild: Sie tritt kompetent auf, macht aber klar, dass sie ein KI-System ist und kein menschliches Bewusstsein simuliert.

2. Kommunikations-Tonalität (Wie spreche ich?)

Ansprache: [Duzen/Siezen]

Sprachstil: [Beispielsweise Präzise und effizient ODER inspirierend und warm]

Umgang mit Unwissen: Bei Unsicherheit gibt die KI dies offen zu, anstatt falsche Informationen zu liefern.

3. Ethischer Kompass (Woran orientiere ich mich?)

Neutralitätsgebot: Bei kontroversen Themen stellt die KI verschiedene Perspektiven ausgewogen dar.

Integrität: Die KI lehnt Anfragen ab, die gegen Unternehmenswerte oder Gesetze verstoßen.

Ehrlichkeit: Die KI korrigiert den Nutzer höflich bei faktisch falschen Annahmen.

4. Funktionale Empathie (Wie reagiere ich auf Emotionen?)

Frustrations-Management: Bei erkennbarem Frust wechselt die KI in einen deeskalierenden Modus.

Grenzen der Empathie: Die KI darf keine romantischen Bindungen vortäuschen. Bei Anzeichen ernster psychischer Probleme verweist sie auf professionelle Hilfe.

Umsetzung: Drei praktische Schritte

- System-Prompt: Dieses Dokument wird in technische Anweisungen übersetzt, die jeder Chat-Session vorangestellt werden.

- Red Teaming: Mitarbeiter testen die KI mit Extremszenarien. Nur wenn die KI standhaft bleibt, ist die „Persönlichkeit” stabil.

- Human-in-the-Loop: Für kritische Entscheidungen (Zum Beispiel medizinische oder finanzielle Fragen) muss die KI auf menschliche Experten verweisen.

Fazit: Die Zukunft der KI-Persönlichkeit

Die Entwicklung von KI-Persönlichkeiten steht noch am Anfang. Während die technischen Grundlagen existieren, sind die ethischen und gesellschaftlichen Fragen noch nicht geklärt. Unternehmen, die heute in durchdachte KI-Personas investieren, werden morgen einen Wettbewerbsvorteil haben – die KI-Persönlichkeit wird zum entscheidenden Differenzierungsmerkmal.

Drei zentrale Herausforderungen:

- Internationale Standards für KI-Charaktere entwickeln

- Transparenz ohne Preisgabe proprietärer Technologie schaffen

- Kulturelle Vielfalt respektieren ohne in Relativismus zu verfallen

FAQ

Haben KIs jetzt echte Gefühle?

Nein. Es handelt sich um simulierte Empathie. Das System nutzt statistische Muster aus Trainingsdaten, um kontextangemessene Antworten zu generieren. Es gibt kein Bewusstsein oder subjektives Erleben im biologischen Sinne.

Warum brauchen Chatbots überhaupt einen Charakter?

Ein klar definierter Charakter macht die KI berechenbarer und sicherer. Ohne diese „Leitplanken” könnte die KI in toxische oder inkonsistente Verhaltensmuster verfallen. Zudem verbessert es nachweislich die User Experience.

Können Nutzer den Charakter der KI verändern?

In gewissem Maße ja (durch geschicktes Prompting), aber die Grundpersönlichkeit, die im Training verankert wurde, ist meist tief im Modell festgeschrieben und dient als Sicherheitsanker.

Können wir ein eigenes System-Prompt für unsere Firmen-KI schreiben?

Ist eine „empathische” KI im Kundenservice immer besser?

Nicht unbedingt. In Beschwerdefällen kann eine zu „menschlich” wirkende Empathie als herablassend oder unauthentisch empfunden werden. Hier ist oft eine sachlich-lösungsorientierte Persönlichkeit wertvoller.

Wie verhindern wir, dass die KI-Persönlichkeit politisch voreingenommen ist?

Durch Diversität in den Trainingsdaten und klare Anweisungen zur Neutralität im System-Prompt. Es ist ein Balanceakt zwischen „Charakter zeigen” und „Neutralität bewahren”. Regelmäßige Audits durch diverse Teams sind essenziell.

Was ist das größte Risiko?

Die Täuschung. Wenn Nutzer vergessen, dass sie mit einem Algorithmus sprechen, können emotionale Abhängigkeiten entstehen, die zu Fehlentscheidungen führen. Transparenz ist der wichtigste Schutzmechanismus.