Früher galt ein Foto als Beweis. Heute reicht das nicht mehr. Mit generativer KI lassen sich in Sekunden täuschend echte Bilder, Stimmen und Videos erzeugen – und selbst geschulte Augen und Ohren erkennen die Fälschung kaum noch. Tools wie ChatGPT, ElevenLabs oder spezialisierte Deepfake-Generatoren produzieren realistisch wirkende Inhalte auf Knopfdruck.

Diese Entwicklung führt zu einer Explosion komplexer Cyberattacken. Mitarbeitende und Privatpersonen sind oft unvorbereitet: Laut Microsoft Digital Defense Report 2024 gehen neun von zehn Cyberangriffen auf menschliches Fehlverhalten zurück. Gartner (2025) berichtet, dass bereits 44 Prozent der Unternehmen Vishing-Angriffe erlebt haben. Besonders gefährlich ist die Kombination aus Social Engineering und KI-basierter Stimmklonung.

Deepfakes als neue Social-Engineering-Waffe

Bereits Anfang 2024 fiel der britische Ingenieurbaukonzern Arup einem Deepfake-Video-Scam zum Opfer: Ein Mitarbeiter wurde in eine gefälschte Videokonferenz gelockt, in der sämtliche Teilnehmende (darunter der vermeintliche CFO) digital erzeugt waren. Innerhalb weniger Tage gingen 25 Millionen US-Dollar verloren. Inzwischen sind die Angriffe noch komplexer geworden, wie der Fall Salesforce/Shiny Hunters im Sommer 2025 zeigt.

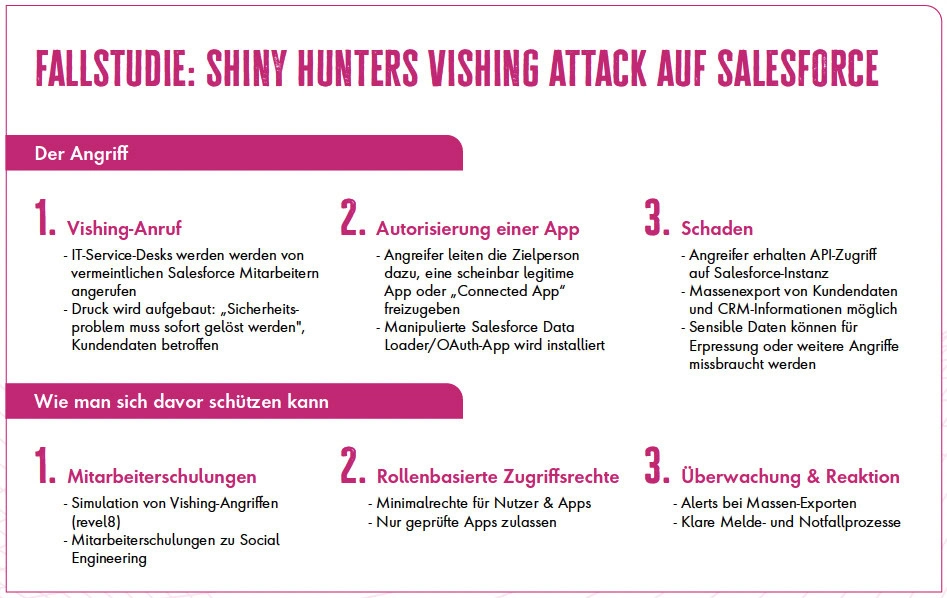

Case Study: Der Salesforce Voice Phishing Angriff

Die international agierende Hackergruppe Shiny Hunters, auch bekannt als UNC6040, nutzte Deepfake-Stimmen, um sich gegenüber IT-Service- und Helpdesk-Mitarbeitenden als internes Salesforce-Support-Team auszugeben.

Der Anruf: Angreifer gaben sich als technische Ansprechpartner aus und meldeten angebliche Sicherheitsprobleme („A security issue must be resolved immediately“). Der psychologische Druck war hoch, Kundendaten sollten angeblich betroffen sein.

Die Aktion: Während des Gesprächs wurden die Opfer angewiesen, Salesforce-Administrationsseiten wie „connected app / setup“ aufzurufen. Dort genehmigten sie – im Glauben, eine offizielle App zu aktivieren – eine manipulierte Anwendung, häufig eine abgeänderte Version des legitimen Salesforce Data Loader.

Die Folgen: Durch die Autorisierung erhielten die Angreifer OAuth-Tokens mit weitreichenden Rechten. Diese nutzten sie, um massenhaft CRM-Daten (Kundenlisten, Support-Logs) zu exportieren. Anschließend forderten sie Lösegeld und drohten mit der Veröffentlichung.

Zu den betroffenen Marken zählten laut Berichten von BBC und SLCyber (2025) unter anderem Gucci, Balenciaga und Alexander McQueen, deren Kundendaten über kompromittierte Salesforce-Instanzen abflossen. Google bestätigte eine Verbindung zwischen diesem Angriff und den Shiny Hunters.

Zwischen Stimme und Vertrauen

Privatpersonen hingegen geraten zunehmend in emotionale Fallen. Kriminelle imitieren vertraute Stimmen oder Behördenmitarbeitende, um Vertrauen aufzubauen. Die Geschichte klingt plausibel, die Stimme echt und das Opfer reagiert instinktiv.

Einige einfache, aber effektive Maßnahmen helfen, sich zu schützen:

➜ Familien-Safeword: Ein zuvor vereinbartes Kennwort dient als interne Verifizierung bei Notfällen.

➜ Kontrollfrage: Eine Frage stellen, deren Antwort nur echte Angehörige kennen („Wie heißen Deine vier Kinder?“ statt fünf).

➜ Kanalwechsel: Bei Unsicherheit das Gespräch beenden und über einen vertrauten Kanal rückversichern.

➜ Ruhe bewahren: Angreifer setzen gezielt auf Zeitdruck und Emotion. Wer 20–30 Sekunden innehält, kann rationaler entscheiden.

➜ Keine sensiblen Daten preisgeben: Seriöse Organisationen im Jahr 2025 fordern niemals TAN, PIN oder Passwörter am Telefon.

Technik allein reicht nicht

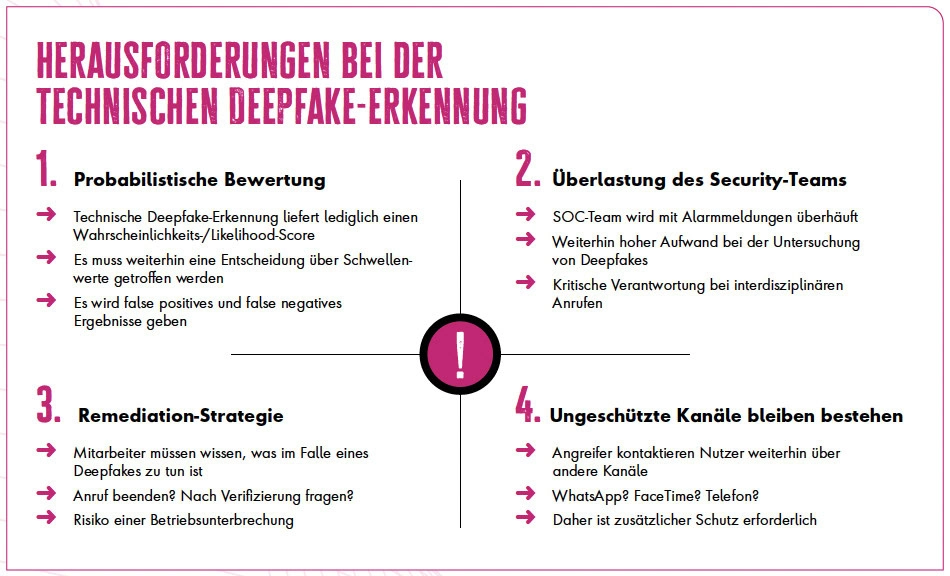

Zum einen gibt es technische Möglichkeiten, die Echtheit von Audio- und Videoinhalten durch sogenannte Deepfake-Detection-Algorithmen zu überprüfen. Diese Systeme analysieren digitale Signaturen, Pixelmuster oder Sprachfrequenzen, um Hinweise auf Manipulation zu erkennen. Sie sind ein wichtiger Bestandteil moderner Sicherheitsstrategien, eignen sich jedoch nicht als alleinige Maßnahme.

Ein zentrales Problem liegt in der kurzen Halbwertszeit solcher Modelle: Detection-Systeme werden auf bestehenden Deepfake-Generatoren trainiert und liefern dort gute Erkennungsraten. Erscheinen jedoch neue KI-Modelle, müssen auch die Erkennungsalgorithmen erneut angepasst und trainiert werden. Das führt zu einem hohen Wartungs- und Updateaufwand, der viele Security-Teams zusätzlich belastet.

Zudem arbeiten diese Systeme probabilistisch. Sie liefern also nur eine Wahrscheinlichkeit, ob ein Inhalt echt oder manipuliert ist. Organisationen müssen daher selbst festlegen, ab welchem Schwellenwert ein Deepfake als erkannt gilt: Bei 90 Prozent? Oder erst ab 99 Prozent? Diese Festlegung beeinflusst unmittelbar die Zahl an False Positives und False Negatives, und damit die operative Belastung des Security-Teams.

Auch die Folgeprozesse müssen klar definiert sein: Was geschieht, wenn der Schwellenwert überschritten wird? Wird der Anruf automatisch unterbrochen, eine Warnmeldung ausgegeben oder eine manuelle Überprüfung eingeleitet? Jedes Szenario hat Auswirkungen auf Nutzerakzeptanz, Produktivität und Reaktionszeiten.

Selbst mit einer Integration in Plattformen wie Microsoft Teams oder Zoom bleiben viele inoffizielle Kommunikationskanäle (etwa WhatsApp oder private Mobiltelefone) ungeschützt. Angreifer nutzen genau diese Lücken, um Sicherheitsmaßnahmen zu umgehen.

KI-Modelle werden immer besser, Deepfake-Generatoren immer zugänglicher. Deshalb gilt: technische Erkennung allein reicht nicht aus.

Julius Muth, revel8 GmbH

Fazit: Wachsamkeit bleibt der beste Schutz

KI-Modelle werden immer besser, Deepfake-Generatoren immer zugänglicher. Deshalb gilt: Technische Erkennung allein reicht nicht aus. Entscheidend bleibt die Awareness der Mitarbeitenden, also die Fähigkeit, verdächtige Situationen selbst zu erkennen, zu hinterfragen und richtig zu reagieren. Moderne Awareness-Programme wie revel8 setzen hier an, indem sie Mitarbeitende mit realitätsnahen Simulationen und praxisbasierten Trainings (wie einen typischen CEO-Fraud per Deepfake-Anruf) auf genau diese Szenarien vorbereiten. Jede Privatperson muss sich darauf einstellen, dass Täuschungen künftig noch realistischer wirken. Der Unterschied liegt nicht in der Technologie, sondern im Verhalten der Menschen, die sie nutzen.

In Zukunft wird sich die Verteidigung stärker auf adaptive KI-Systeme und kontinuierliches Verhaltenstraining stützen müssen – kombiniert mit klaren Richtlinien für Mensch-Maschine-Interaktion. Doch trotz technologischer Fortschritte bleibt Aufklärung die wirksamste Verteidigung. Wer vorbereitet ist, erkennt Deepfakes, bevor sie Schaden anrichten.