Software Defined Storage mittels Speichervirtualisierung ermöglicht dabei die wirtschaftlich sinnvolle Integration von SSD-Technologie in die bestehende Infrastruktur.

Disk im Verbund mit einer SSD-Technologie lässt Unternehmen von unterbrechungsfreier Hochverfügbarkeit und herausragender Performance träumen. Grundsätzlich ist das durch technische Innovationen umsetzbar – allerdings mit entsprechendem Preis. Dieser ist aber der Dreh- und Angelpunkt jedes Projekts zur Bereitstellung oder Optimierung von Datenbanken auf virtuellen Maschinen, denn diese Umgebungen wachsen schnell. Eine Balance zwischen vorhandenen Ressourcen, Investitionssicherheit und Flexibilität für die Zukunft muss gefunden werden. Dabei kann die Hardware-unabhängige Speichervirtualisierung helfen. Der Kostenaufwand für Solid State Technologie ist erheblich, warum also zusätzlich in diese Software-Schicht investieren? Speichervirtualisierung wird hier nicht als plattform- oder gerätespezifische Storage-Technologie verstanden, sondern als übergreifende Basistechnologie für den derzeit viel zitierten „Software-basierenden“ Storage, der eine hybride Speicherinfrastruktur erst ermöglicht.

Hybride Ressourcen integrieren

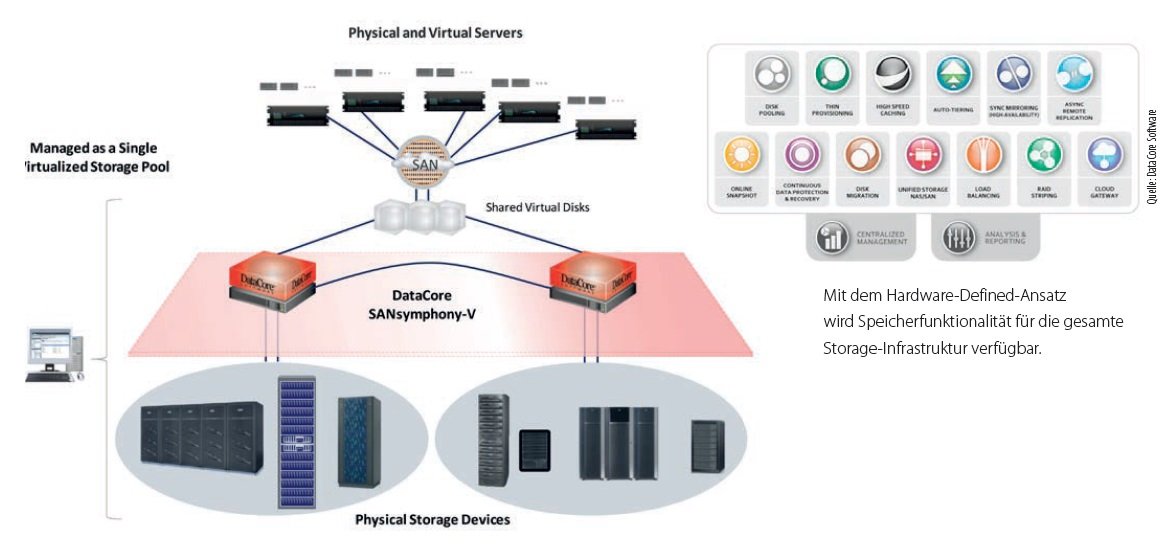

Einerseits wünschen sich Unternehmen bessere IT-Infrastrukturen, andererseits werden die Budgets dafür immer weiter beschränkt und zwingen zu Kompromissen hinsichtlich der Neuanschaffung von Storage-Hardware. Investitionssicherheit und Flexibilität sind in diesem Zusammenhang die häufig genannten Schlagworte. In erster Linie sollen die bereits vorhandenen Ressourcen völlig ausgeschöpft werden, bevor die Umgebung erweitert wird. Das Problem hierbei ist die Umsetzbarkeit: wie kann man eine sinnvolle Kombination von neuer Hardware und den bewährten, bereits implementierten Geräte finden? Ohne Speichervirtualisierung gab es auf Grund der Hersteller-Beschränkungen häufig Probleme bei der Integration von Flash oder SSDs in eine aktive Datenbankumgebung. Diese Hardware- definierten Komplikationen können mit einem Software-definierten Ansatz überwunden werden. Er erlaubt es, SSD-Kapazität unterbrechungsfrei in den virtualisierten Storage-Pool neben herkömmlichen Festplatten zu integrieren. Dabei ist es nicht notwendig, proprietäre und kostenintensive SSD-Lösungen zu verwenden, auch die Integration beispielsweise als SSD-Karte im Server ist geeignet.

Solange man eine einzelne Datenbank auf einer bestimmten Maschine laufen lässt, bleibt der Ablauf vorhersagbar. Dies gilt aber nicht, wenn mehrere virtualisierte Server die gleichen Speicherressourcen nutzen. Unter diesen Umständen braucht man Unterstützung, um herauszufinden, wie etwa Performance-Probleme am besten gelöst werden können. Doch selbst nach stundenlangen Feineinstellungen ist es kaum möglich, die Konfiguration für unterschiedliche Speicherklassen manuell so vorzunehmen, dass I/O intensive Sektionen mit Flash verarbeitet werden, während Hard Disk Drives (HDDs) die weniger anspruchsvollen Segmente bedienen. Speichervirtualisierungssoftware sollte deshalb automatisches Tiering beherrschen. Die Software migriert dann Datenblöcke von den langsameren Laufwerken auf die neue, schnellere Hardware. Dies reduziert die Kosten drastisch, da die kostspieligen SSDs ohnehin nur für maximal 5 Prozent der Datenblöcke benötigt werden. Gleichzeitig profitiert man von einer erhöhten Performance, nicht selten zwischen 200 und 500 Prozent. Sobald festgelegt ist, welche Aktionen Priorität erhalten sollen, trifft die Software die richtigen Entscheidungen in Echtzeit unter Berücksichtigung aller konkurrierenden I/O Anfragen. Die Software dirigiert die zeitsensitivsten Workloads an die Solid State Disks und die weniger wichtigen zu den konventionellen Festplatten. Es ist ebenso möglich, die Algorithmen zu überschreiben, um Volumes mit einer bestimmten Storage-Klasse zu verbinden, beispielsweise Aufträge zum Ende des Quartals, die Vorrang haben müssen. Die ausgereiftesten Lösungen wie beispielsweise DataCores SANsymphony-V gehen noch einen Schritt weiter. Sie ermöglichen zusätzliche Geschwindigkeit bei Festplattenzugriffen, indem sie den Server-DRAM für zusätzliches Caching nutzen. Dabei geht es nicht nur um das Lesen, sondern auch das Schreiben. Neben der schnelleren Reaktionszeit reduziert das Cachen von Schreibzugriffen den Auslastungsgrad von Solid State Speichern und verlängert so ihre Lebenszeit. Dies schafft einen weiteren Anreiz für die Investition. Bei den Speichersystemen wird zusätzlich Thin Provisioning angewendet, um unnötige Verschwendung der teuren Hardware zu vermeiden.

Verfügbarkeit sichern

Nun stellt sich neben der Performance ebenso die Frage nach der Verfügbarkeit. Auch hier hat Hardware-unabhängige Speichervirtualisierungssoftware viel zu bieten. SANsymphony-V stellt beispielsweise redundante Kopien von Datenbanken und den damit verbundenen Dateien auf unterschiedlichen Speichern bereit, unabhängig von Typ oder Marke. Die Software bietet effektiv kontinuierliche Verfügbarkeit, indem sie die sekundäre Kopie nutzt, während auf primärer Seite Wartungsarbeiten oder Erweiterungen durchgeführt werden. Das Gleiche gilt, falls in dem Raum, in dem der Storage untergebracht ist, die Klimaanlage ausfällt, ein Wasserrohrbruch auftritt oder er aufgrund von Baumaßnahmen nicht genutzt werden kann. Die Speichervirtualisierungsprodukte nutzen eine Kombination von synchroner Spiegelung zwischen gleichen oder ungleichen Geräten, zusammen mit Standard-Multi-Path I/O-Treiber auf den Hosts, um die gespiegelten Images transparent zu halten. Sie verwenden automatisches Fail-Over und Fail-Back ohne manuellen Eingriff. Dafür sind keine speziellen Lizenzen für Datenbankreplikation erforderlich. Die gleichen Mechanismen zum Schutz der Datenbanken schützen auch andere virtualisierte und physische Workloads und helfen, Business-Continuity-Praktiken zu konvergieren und zu standardisieren. Für ein besonders hohes Maß an Sicherheit kann man eine weitere Replik für die Disaster Recovery (DR) an einem anderen Ort erstellen. Diese asynchrone Kopie wird über Standard IP WANs erstellt.

Monitoring und Analyse

Natürlich ist auch interessant, was hinter den Kulissen geschieht. Die Ausstattung der umfangreicheren Software-Pakete bietet dafür wertvolle Einblicke. Echtzeit-Diagramme beschreiben akkurate Metriken der I/O-Antwortzeiten und des relativen Kapazitätsverbrauchs. Zusätzlich stellen sie Zeitverläufe zur Verfügung, anhand derer sich nachvollziehen lässt, wie das gesamte System bei zusätzlichen Anfragen reagiert und wann Spitzenzeiten üblicherweise auftreten. Heat Maps zeigen die relative Distribution von Datenblöcken zwischen Flash, SSDs und anderen Speichermedien, inklusive Cloud-basierter Archive. Was kann man daraus schließen? Erstens bieten Solid State Technologien eine attraktive Lösung, die Geschwindigkeit der kritischen Datenbanken-Workloads zu beschleunigen. Dies ist nichts Neues. Verwendet man SSDs im Zusammenspiel mit schnellen Festplatten und hoher Kapazität – gesetzt den Fall, dass Massenspeicher bereits an Ort und Stelle sind – kann ein angemessenes Verhältnis von ausgezeichneten Reaktionszeiten und wirtschaftlichen Investitionen geschaffen werden. Um dieses Gleichgewicht in einem virtualisierten Szenario zu schaffen empfiehlt es sich, die neue Hardware gemeinsam mit hardwareunabhängiger Speichervirtualisierungssoftware einzusetzen. Dies schafft die optimalen Voraussetzungen für die Integration von Flash/SSDs in einer gut abgestimmten, unterbrechungsfreien High Performance-Umgebung, die alle Vorteile von Software-definierten Storage-Infrastrukturen nutzt.

Alexander Best

Diesen Artikel finden Sie auch in der it management Ausgabe 10 – 2013.