.jpg)

DEEP-EST folgt auf die erfolgreich abgeschlossenen Projekte DEEP und DEEP-ER und sieht unter anderem ein zusätzliches neues Modul für die Analyse großer Datenmengen vor. An dem vom Forschungszentrum Jülich koordinierten Projekt sind 16 international führende Forschungseinrichtungen und Unternehmen beteiligt.

Für Smartphones und Notebooks zählt längst nicht mehr nur die reine Rechenleistung. Ebenso wichtig sind Kameras, Netzwerkschnittstellen und GPS. Ein ähnlicher Trend ist auf dem Gebiet des High-Performance Computing (HPC) zu beobachten. Neben rechenintensive Simulationen – das traditionelle Aufgabengebiet wissenschaftlicher Rechenzentren – treten neue Anwendungen wie Big-Data-Analysen und aufwendige Visualisierungen, die sich mit herkömmlichen Superrechner-Architekturen nur ineffizient bewältigen lassen.

„Die Optimierung homogener Systeme ist mehr oder weniger ausgereizt. Wir entwickeln Schritt für Schritt die Voraussetzungen für eine hocheffiziente modulare Superrechner-Architektur, die sich flexibel an unterschiedliche Anforderungen wissenschaftlicher Anwendungen anpasst“, erklärt Prof. Thomas Lippert, Leiter des Jülich Supercomputing Centre (JSC).

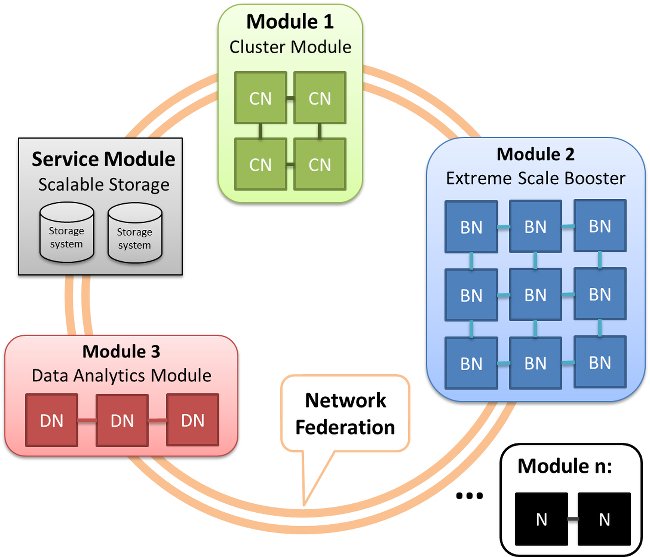

Beschleuniger oder Speichermodule werden nach dem Konzept des modularen Superrechners nicht wie bisher über Erweiterungskarten mit einzelnen CPUs kombiniert, sondern zu eigenständigen Modulen zusammengefasst. Deren Einheiten, genannt Knoten, lassen sich je nach Bedarf kombinieren. Am Ende steht ein flexibel anpassbares System, das mittels zukunftsweisender Technologien die Grundlage schaffen soll für sogenannte Exascale-Rechner: zukünftige Supercomputer, deren Leistungsfähigkeit die der schnellsten heutigen Supercomputer um eine Größenordnung übersteigt.

Neues Modul für Big Data

Bis 2020 wird in DEEP-EST ein Prototyp entwickelt, der die Vorzüge des Konzepts unter Beweis stellen soll. Neu hinzukommen wird unter anderem ein Data-Analytics-Modul für die Analyse großer Datenmengen, das die Cluster-Booster-Architektur der Vorgängerprojekte DEEP und DEEP-ER noch erweitert. Mit einer hohen Speicherkapazität und flexibel programmierbaren Prozessoren, sogenannten FPGAs, soll das Data-Analytics-Modul eine Lücke schließen, die sich aus unterschiedlichen Hardware-Anforderungen für das High-Performance Computing (HPC) und High-Performance Data Analytics (HPDA) entwickelt hat.

„Bei klassischen Supercomputing-Anwendungen wie etwa Simulationen aus der Quantenphysik werden extrem viele Rechenoperationen auf einen relativ kleinen Datensatz angewendet. Das erfordert Systeme mit viel Rechenpower, aber nur relativ wenig Speicher“, erklärt Projektleiterin Dr. Estela Suárez vom Jülich Supercomputing Centre (JSC). „Wir sehen aber schon jetzt, dass die Anwendungen deutlich komplexer und die Datenmengen von heutigen Experimenten, etwa am CERN, immer größer werden. Das bedeutet: Supercomputer brauchen künftig eine drastisch höhere Speicherkapazität – und zwar so nah wie möglich an den Prozessoren. Nur so lassen sich die Daten schnell und möglichst energieeffizient bearbeiten“, erläutert Estela Suárez.

Anwendungen stehen Pate bei Entwicklung

Insgesamt sechs Anwendungen aus relevanten europäischen Forschungsfeldern werden bei der Entwicklung des Prototypen im Co-Design-Verfahren mit einbezogen. Die Anforderungen der Codes fließen in das Design des Prototypen mit ein. Zugleich profitieren die Codes durch Optimierungen im Zuge des Projekts. Die Forscher wollen zum Beispiel mit der KU Leuven einen Code adaptieren, mit dem sich simulieren lässt, wie sich gewaltige Sonnenstürme auf die Erde auswirken. Solche Ereignisse sind zwar selten, drohen aber mit gewaltigen Schäden: etwa dem Ausfall der Satellitenkommunikation und gestörten GPS-, Internet- und Telefonverbindungen.

Tests werden zeigen, inwiefern die hochkomplexe Simulation des Weltraumwetters von der modularen Rechner-Architektur profitiert. Verschiedene Teile des komplexen wissenschaftlichen Codes werden hierzu unterschiedlichen Modulen zugeordnet. Für die bestmögliche Verteilung sorgt die Systemsoftwareumgebung, die es ebenfalls im Projekt zu entwickeln gilt. Über ein ausgeklügeltes Ressourcenmanagement soll zudem sichergestellt werden, dass die verschiedenen Komponenten der Architektur zu jedem Zeitpunkt möglichst effizient genutzt werden und somit Energie gespart wird.

Im Fall der Weltraumwetter-Simulation ist etwa die datenintensive Auswertung von hochauflösenden Satellitenbildern insbesondere für die Auslagerung auf das Data-Analytics-Modul prädestiniert. Andere Teile des Simulationscodes, beispielsweise die Wechselwirkung der von der Sonne ausgestrahlten Teilchen mit dem Erdmagnetfeld, werden dagegen auf das Cluster-Modul mit leistungsfähigen General-Purpose-Prozessoren und den Booster aufgeteilt, der auf vernetzten, hochparallelen Mehrkernprozessoren basiert.