KI-Pilotprojekte scheitern oft am Betrieb – nicht an Algorithmen. AI Engineering ist der Schlüssel zum Sprung in die Produktion, denn Plattformen allein reichen nicht aus.

Zahlreiche Unternehmen investieren aktuell in Künstliche Intelligenz (KI). Strategiepapiere sind geschrieben, Budgets freigegeben, Pilotprojekte gestartet. Doch der erhoffte Durchbruch in den operativen Alltag bleibt häufig aus.

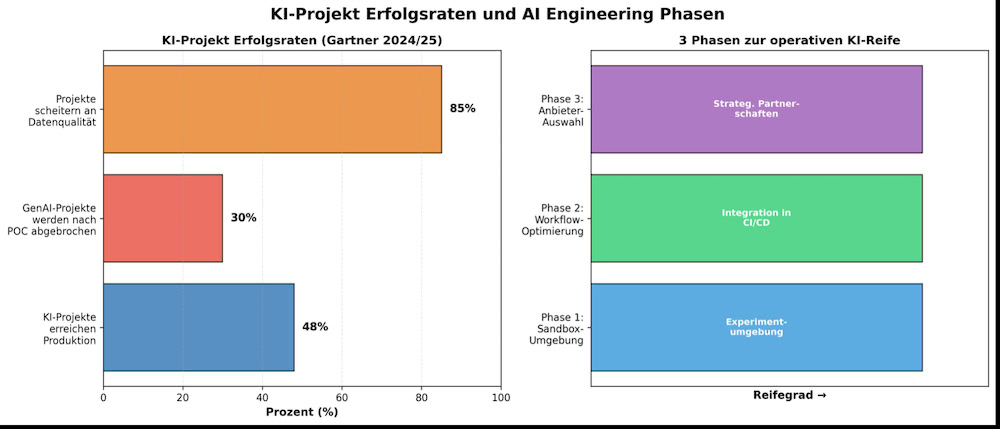

Eine aktuelle Analyse von Gartner zeigt: 48 Prozent aller KI-Pilotprojekte erreichen tatsächlich den produktiven Betrieb. Die Gründe dafür sind selten unzureichende Algorithmen oder fehlende Anwendungsfälle. Viel häufiger scheitern Initiativen an technischen, organisatorischen und regulatorischen Grundlagen für den Betrieb. Genau hier setzt AI Engineering an.

Das strukturelle Problem hinter gescheiterten KI-Piloten

Viele Organisationen entwickeln KI isoliert – als Innovationsprojekt außerhalb etablierter IT- und Betriebsprozesse. Datenwissenschaftler experimentieren mit Modellen, Fachbereiche testen Use Cases, erste Prototypen entstehen. Doch wenn es darum geht, diese Lösungen stabil, sicher, kosteneffizient und skalierbar in produktive Systeme zu überführen, zeigen sich Probleme. Operative, kulturelle und regulatorische Engpässe verhindern die Überführung in die Produktion. Es fehlen klare Prozesse für Deployment, Monitoring, Wartung und Compliance. Verantwortlichkeiten zwischen Daten-, Entwicklungs- und Betriebsteams sind unklar. Zudem existieren keine einheitlichen Frameworks, um Modelle wiederholbar, kontrolliert und rechtskonform auszurollen. Die Folge: KI bleibt ein Experiment – mit unklarem ROI und hohen Opportunitätskosten.

AI Engineering als verbindendes Framework

Genau hier setzt AI Engineering an. Es vereint DataOps, ModelOps, DevOps sowie zunehmend LLMOps und AgentOps in einem ganzheitlichen Ansatz zur Operationalisierung von Künstlicher Intelligenz. Das Ziel: Engpässe identifizieren, beseitigen und Modelle verlässlich in die Produktion bringen. Entscheidend ist dabei die Integration in bestehende DevOps-Strukturen. KI darf nicht als parallele Welt neben der klassischen Softwareentwicklung existieren. Erst durch die clevere Verbindung entstehen stabile, wartbare und vertrauenswürdige KI-basierte Lösungen. AI Engineering schafft die Grundlage für zusammengesetzte KI-Systeme, die unterschiedliche Techniken kombinieren und aufeinander abstimmen. Gerade im Kontext generativer KI, Large Language Models und agentenbasierter Architekturen wächst diese Komplexität weiter – und damit der Bedarf an diszipliniertem Engineering.

Die Suche nach der einen Plattform – eine Illusion

Ein häufiger Irrtum in Unternehmen ist die Suche nach der einen Plattform, die sämtliche KI-Herausforderungen löst. Laut Gartner ist eine solche Lösung eine Illusion. Effektives AI Engineering erfordert vielmehr ein koordiniertes Ökosystem verschiedener Tools, das die spezifischen Nuancen einzelner Modelle – wie LLMs, SLMs oder Multiagentensysteme – berücksichtigt. Es geht nicht um ein einzelnes Produkt, sondern um den Aufbau von Fähigkeiten, Architekturentscheidungen und organisationsübergreifenden Standards. Mit dem Fortschritt der KI-Technologien entwickelt sich auch das Engineering-Framework weiter: von klassischen ModelOps-Ansätzen über domänenspezifische Sprachmodelle bis hin zu adaptiven, agentenbasierten Architekturen. Organisationen müssen ihre Strukturen entsprechend anpassen, denn Technologie allein löst keine strukturellen Defizite in Prozessen, Governance und Kostenkontrolle.

Drei Phasen zur operativen KI-Reife

Die Einführung einer belastbaren AI-Engineering-Strategie erfolgt nicht von heute auf morgen, sondern in klar strukturierten Phasen.

Phase 1: Entwicklungsframeworks etablieren

In der ersten Phase steht der Aufbau einer flexiblen Sandbox-Umgebung im Mittelpunkt. Sie ermöglicht kontrollierte Experimente mit verschiedenen Modellen und Tools, wobei die Integration relevanter Funktionen wie Datenpipelines, RAG-Tools und Open-Source-Komponenten frühzeitig berücksichtigt werden muss. Von zentraler Bedeutung ist dabei die klare Trennung zwischen Entwicklungs- und Produktionsumgebung, denn Experimentierfreiheit darf nicht zu Governance-Verlust führen. Gleichzeitig sollten wiederverwendbare Designmuster dokumentiert werden, um die spätere Skalierung zu erleichtern.

Phase 2: Grundlage für die Operationalisierung schaffen

In der zweiten Phase definieren Unternehmen klare Ziele, optimieren Workflows und wählen geeignete Tools aus. Es geht darum, eine flexible Architektur aufzubauen, die verschiedene KI-Technologien strukturiert zusammenführt. Priorität haben skalierbare Workloads, die nahtlose Integration in bestehende CI/CD-Pipelines sowie die kontinuierliche Modellbereitstellung und -überwachung. Ergänzend empfiehlt Gartner die Integration von menschlichem Feedback und Usability-Tests, um KI/UX-Aspekte angemessen zu berücksichtigen. Strategisch bedeutsam ist zudem der Aufbau einer KI-Plattform-Engineering-Praxis mit klar definierten gemeinsamen Fähigkeiten und ausreichend Rückhalt durch das Top-Management.

Phase 3: Anbieter-Ökosystem kuratieren

In der dritten Phase schließlich erfordert die Auswahl von KI-Anbietern eine strukturierte Marktanalyse, klare Kriterien und eine gründliche Bewertung der jeweiligen Fähigkeiten. Pilotphasen dienen hier als notwendiger Realitätscheck. Darüber hinaus sollten Unternehmen Plattformanforderungen definieren, Roadmaps analysieren und bevorzugte Partnerschaften festlegen. Auf diese Weise werden KI-Ressourcen aktiv gemanagt – nicht nur technologisch, sondern auch strategisch.

Was IT-Entscheider jetzt konkret tun können

Aus der Gartner-Studie lassen sich klare Handlungsfelder ableiten.

Erstens sollten Unternehmen KI nicht als isoliertes Innovationsprojekt betrachten, sondern frühzeitig in bestehende DevOps- und Betriebsprozesse integrieren.

Zweitens ist es entscheidend, Fähigkeiten vor Tools zu priorisieren, denn der Aufbau eines durchgängigen Engineering-Frameworks ist wichtiger als die Auswahl einer einzelnen Plattform.

Drittens müssen Experimentierumgebungen gezielt strukturiert werden, um Wiederholbarkeit, Nachvollziehbarkeit und Governance sicherzustellen.

Viertens gilt es, die verschiedenen Ops-Disziplinen systematisch miteinander zu verbinden, sodass DataOps, ModelOps, DevOps sowie neue Disziplinen wie LLMOps nahtlos zusammenspielen.

Fünftens sollten Organisationen Schritt für Schritt Reife aufbauen, statt sofortige Vollskalierung anzustreben. Und sechstens müssen Governance, Sicherheit und Kosten von Anfang an mitgedacht werden – und nicht als nachgelagertes Problem behandelt werden.

Skalierung ist ein Engineering-Thema

Der entscheidende Perspektivwechsel lautet: KI-Skalierung ist kein Modellthema, sondern ein Engineering-Thema. Dauerhafter Mehrwert entsteht nur dann, wenn Prozesse festgelegt, technische Grundlagen stabil aufgebaut, Zuständigkeiten eindeutig geklärt und rechtliche sowie wirtschaftliche Rahmenbedingungen beherrscht werden. AI Engineering bietet dafür ein strukturiertes Framework, das technologische, organisatorische, regulatorische und operative Aspekte miteinander verbindet.

Für IT- und Technologie-Entscheider ergibt sich daraus eine klare Erkenntnis: Der Weg vom Pilotprojekt zur produktiven KI beginnt nicht mit dem nächsten Modell-Update, sondern mit der konsequenten Professionalisierung des Engineerings. Nur so wird aus Experimenten nachhaltiger Geschäftswert.

Autor: Birgi Tamersoy ist Sr Director Analyst bei Gartner

Zusatztipps von it-daily.net:

Skills und Personalentwicklung als Erfolgsfaktor

Neben Technologie und Prozessen ist ein weiterer Aspekt entscheidend für den Erfolg von KI-Initiativen: die systematische Entwicklung von AI Literacy und Engineering-Kompetenzen im gesamten Unternehmen. Gartner identifiziert dies als eine der vier Grundlagen-Capabilities für KI-reife Organisationen. Ohne ausreichendes Verständnis für die Möglichkeiten und Grenzen von KI scheitern selbst technisch ausgefeilte Lösungen an mangelnder Akzeptanz oder unrealistischen Erwartungen.

Unternehmen sollten daher gezielt in Upskilling-Programme investieren – nicht nur für Data Scientists und ML-Engineers, sondern auch für Product Owner, Business Analysten und IT-Operations-Teams. Die Fähigkeit, KI-Projekte zu verstehen, zu bewerten und in bestehende Geschäftsprozesse zu integrieren, wird zunehmend zu einer Kernkompetenz. Dabei geht es nicht darum, aus jedem Mitarbeitenden einen KI-Experten zu machen, sondern um die Vermittlung eines grundlegenden Verständnisses: Wie funktionieren Modelle? Welche Daten werden benötigt? Wo liegen typische Risiken? Diese AI Literacy schafft die Basis für realistische Erwartungen und konstruktive Zusammenarbeit zwischen Fachabteilungen und technischen Teams.

Governance, Sicherheit und Kosten im Blick behalten

Ergänzend zu den drei Phasen gilt: Technologische Exzellenz allein reicht nicht aus. Unternehmen müssen frühzeitig Governance-Strukturen aufbauen, die regulatorische Anforderungen wie den EU AI Act oder die ISO 42001 adressieren, Sicherheitsrisiken wie Prompt Injections, Adversarial Attacks oder Modell-Diebstahl minimieren und Kostenstrukturen – insbesondere bei generativer KI – transparent steuern. Nur wer KI nicht nur technisch, sondern auch wirtschaftlich, rechtlich und ethisch beherrscht, schafft langfristig Vertrauen, Akzeptanz und Skalierbarkeit.

Besonders bei den Kosten zeigt sich häufig eine problematische Diskrepanz zwischen Investment und Nutzen: Laut Gartner investieren Unternehmen durchschnittlich 1,9 Millionen US-Dollar in GenAI-Projekte (2024), doch weniger als 30 Prozent der CEOs sind mit dem Return on Investment zufrieden. Diese Zahlen unterstreichen die Notwendigkeit einer disziplinierten FinOps-Praxis für KI – mit klaren Budgets, Kostenkontrolle pro Modell-Inference und transparenten Business Cases, die nicht nur technische Machbarkeit, sondern auch wirtschaftliche Tragfähigkeit nachweisen.

Regulatorische Anforderungen: Global denken, lokal handeln

Die regulatorische Landschaft für Künstliche Intelligenz entwickelt sich weltweit rasant – allerdings mit regional unterschiedlichen Ansätzen. Während die Europäische Union mit dem EU AI Act einen risikobasierten, umfassenden Rechtsrahmen geschaffen hat, verfolgen die USA einen sektorspezifischen Ansatz mit freiwilligen Richtlinien und branchenspezifischen Regulierungen. Asiatische Märkte wie China setzen auf staatlich gesteuerte Standards mit Fokus auf Datensouveränität und Kontrolle.

Für global agierende Unternehmen bedeutet dies: Sie müssen ihre AI-Engineering-Strategie so aufbauen, dass sie flexibel auf unterschiedliche regulatorische Anforderungen reagieren kann. Der EU AI Act mit seinen konkreten Fristen – GPAI-Regeln ab 2. August 2025, High-Risk AI ab 2. August 2026, bestehende Modelle ab 2. August 2027 – setzt dabei den strengsten Standard und kann als Orientierung dienen. Unternehmen, die diese Anforderungen erfüllen, sind auch für andere Märkte gut aufgestellt.

Die ISO 42001, der erste zertifizierbare internationale Standard für AI Management Systems (AIMS), bietet dabei einen praxistauglichen Rahmen, der über regionale Grenzen hinweg anwendbar ist und sowohl Governance als auch Risikomanagement systematisch adressiert.

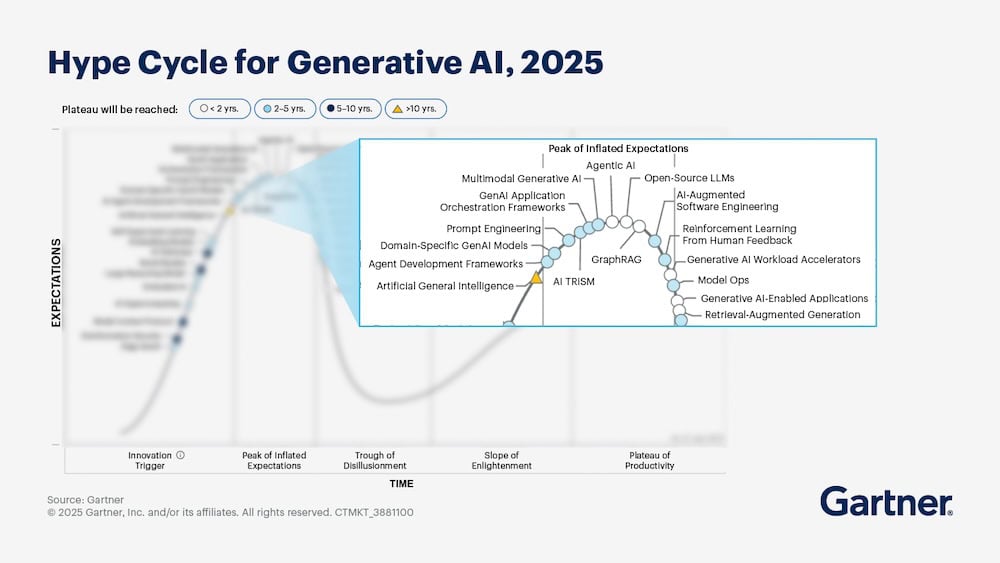

Aktuelle Entwicklungen: Vom Hype zur Reife

Die KI-Landschaft befindet sich aktuell in einer kritischen Übergangsphase. Laut Gartner Hype Cycle 2025 hat Generative AI mittlerweile den „Trough of Disillusionment” erreicht – jene Phase, in der überzogene Erwartungen auf die Realität treffen und Ernüchterung einsetzt. Dies ist jedoch kein Zeichen des Scheiterns, sondern eine natürliche und notwendige Entwicklung auf dem Weg zur produktiven Nutzung. Gerade jetzt wird AI Engineering zur entscheidenden Disziplin: Während der Hype nachlässt, trennt sich die Spreu vom Weizen – erfolgreiche Implementierungen entstehen nicht durch Technologie-Enthusiasmus, sondern durch solide Engineering-Praxis.

Auch bei neueren Entwicklungen wie Agentic AI wiederholen sich bekannte Muster: Gartner prognostiziert (Januar 2025), dass über 40 Prozent der Agentic-AI-Projekte bis Ende 2027 abgebrochen werden. Die Gründe sind dieselben wie bei klassischen KI-Projekten: fehlende Integration in bestehende Systeme, unklare Governance, mangelnde Datenqualität und unrealistische Erwartungen. Dies unterstreicht die zentrale Aussage dieses Artikels: Neue KI-Technologien allein lösen keine strukturellen Probleme – ohne professionelles AI Engineering bleiben auch agentenbasierte Systeme im Pilotmodus stecken.

Besonders kritisch ist die Datenfrage: Laut Gartner werden 60 Prozent der KI-Projekte ohne „AI-ready Data” bis 2026 abgebrochen oder scheitern. Dies zeigt: Der Fokus auf Modellauswahl und Algorithmen greift zu kurz. Erfolgreiche KI beginnt mit sauberen, gut strukturierten und governance-konformen Daten – ein Thema, das viele Organisationen noch immer unterschätzen.