Weil die IT-Manager von heute wissen wie wichtig die Performanceleistung ihrer Umgebung für ihr Business ist. Unternehmen können es sich nicht mehr leisten, immer mehr Hardware zu kaufen, um ein Problem zu lösen. Stattdessen müssen die Manager mit geringeren Budgets auskommen, deshalb suchen sie nach innovativen Lösungen. Daher ist es keine Überraschung, dass eine lebhafte Diskussion darüber stattfindet, wie Spitzenleistungen zu erreichen sind. Oft werden die Vorteile von schnellen Flash-Speichern gelobt. Aber soll das alles sein?

Natürlich sind Flash-Speicher extrem schnell, doch häufig wird die Realität der heterogenen IT-Infrastrukturen von heute übersehen: Wenn man Preis und Ergebnis vergleicht, kommt man zu dem Schluss, dass eine Investition von Tausenden Euro in Flash-Arrays nicht zwingend sinnvoll ist, da das alleine keine optimale Performance garantieren kann. Bei ganzen SAN-Systemen muss die Installation von superschnellen neuen Flash-Arrays nicht unbedingt spürbare Verbesserung mit sich bringen, wenn der Datenverkehr durch Engstellen in anderen Bereichen gebremst wird. Wie kann man ohne ein tiefgreifendes Verständnis der einzelnen komplexen Vorgänge in einem Rechenzentrum wissen, ob die Investition in Flash-Speicher oder andere leistungssteigernde Anwendungen überhaupt eine geeignete Maßnahme ist?

Alle Engpässe kennen

Die Vorteile von Flash-Speichern sind natürlich extrem verlockend. Die Technologie kann ein viel besseres Preis-Leistungs-Verhältnis bieten als herkömmliche Festplattenspeicher. Man könnte daraus schlussfolgern, dass Flash-Speicher reißenden Absatz finden, und vielleicht wird das in der nahen Zukunft auch der Fall sein. Doch im Moment ist noch nicht der magische Wendepunkt erreicht, an dem der Preisunterschied (Euro pro GB) zwischen Flash-Speichern und Festplatten verschwunden ist, und es gibt nach wie vor zahlreiche Hindernisse, die die flächendeckende Nutzung verhindern.

Wenn wir das unantastbare Kostenargument einmal außen vor lassen, stellt man fest, dass es eine riesige Vielfalt an Anordnungs- und Paketoptionen gibt, die durchaus erdrückend und verwirrend sein kann.

Kann ein dedizierter Array eine spürbare höhere Leistungssteigerung als eine serverbasierte Speichererweiterung liefern?

Ist ein hardwarebasiertes Design einer speziell entwickelten, mit Software optimierten Architektur vorzuziehen?

Wird eine SAN-Caching-Appliance benötigt oder reicht ein Hybridmodell (SSDs mit automatischem Tiering in Ihren alten Festplatten-Arrays) aus?

Bei der Auswahl einer geeigneten Flash-Speicher-Lösung spielen unzählige Variablen eine Rolle, wie zum Beispiel Zugriffsmuster, das I/O-Verhältnis, I/O-Parameter und Lastprioritäten, die insbesondere bei mandantenfähigen Systemen sorgfältig erwogen werden müssen. Zudem muss man realisieren, dass die verschiedenen Anbieterlösungen beim Einsatz unvermeidbar unterschiedliche Leistungen liefern.

Es gibt wohl keinen IT-Manager, der nicht genau wissen möchte, was er von einem Anbieter erwarten kann. Leider kann der Unterschied zwischen den Datenblättern der Produkte (Millionen an IOPS/Latenzzeiten, die kürzer als eine Millisekunde sind) und dem, was Sie bei einem tatsächlichen Anwendungstest erwarten können, sehr groß sein. Das ist für alle, die nach einer zuverlässigen IT-Lösung suchen, sehr ärgerlich. Doch ist dieser Umstand auch keine Überraschung, wenn man bedenkt, wie viele Variablen eine Rolle spielen.

Die Variablen erkennen

Natürlich ist der Gedanke einer Anwendungsbeschleunigung sehr attraktiv. Tatsächlich ist dieses Ziel für unzählige Unternehmen sogar so verlockend, dass sie Solid-State-Speicher häufig selbst dann einsetzen, wenn die Entscheidungsträger nicht alle Faktoren verstehen. Nur selten wird ausreichend analysiert und bewertet, wie die umgebende Infrastruktur auf die Einführung von Flash-Speichern reagieren wird.

Bei der Bewertung der Geschwindigkeit eines SANs müssen alle Elemente und Geräte auf dem Datenweg in die Rechnung einbezogen werden, da sie gemeinsam die Gesamtleistung des Systems ausmachen. Wenn die Datenübertragungsrate vom schwächsten Glied in der Transaktionskette gedrosselt wird, ist es sinnvoll, den Storage-Verkehr im gesamten Stack zu analysieren.

Das mag vielleicht offensichtlich sein, aber ohne umfassende Einblicke kann man Hunderttausende Euro in glänzende neue Hardware investieren, die größtenteils auf der Interpretation der I/O-Intensität beruht, was allerdings nur ein abgeleiteter und ungenauer Wert ist. Das tiefer liegende Problem ist, dass sich beinahe alle Standardvergleiche von Flash-Speichern auf die Analyse von Trace-Dateien konzentrieren (Ergebnis der Leistungsnachverfolgung), die sich wiederum ausschließlich auf die I/O-Prozesse von Datenbanken beschränkt, statt den gesamten Workflow im System zu betrachten. Die Anbieter von Flash-Speichern nutzen diese Methode zur Prüfung der CPU-Auslastung, des Datendurchsatzes, der Warteschlangentiefe und der I/O-Latenzzeiten, um mögliche Bereiche zu identifizieren, die verbessert werden können. So kann herausgefunden werden, ob auf dem Datenweg ein Latenzproblem besteht, aber es ist nicht möglich zu bestimmen, wo und warum es auftritt, oder auch geeignete Maßnahmen vorzuschlagen.

Ohne tatsächlich umfassende und korrelierte Informationen kann man nicht feststellen, ob ein System potenzielle Schwachstellen aufweist. Oft manifestieren sich diese Fehler erst dann, wenn es zu spät und eine Investition bereits stattgefunden hat. Erst dann kommen unglückliche Ressourcenkonflikte und „Falscheinstellungen“ an anderen Stellen in der Infrastruktur zum Vorschein – falsch konfigurierte Parallelisierungseinstellungen, nicht für Flash-Speicher optimierte Betriebssystemversionen, zu kleine I/O-Schnittstellen, Netzwerküberlastung und andere Komponenten, die nun überlastet sind.

Unsicherheiten hinter sich lassen

Angesichts der kontinuierlichen Änderungen und der wachsenden Komplexität, wie sie durch neue Abstraktionsebenen und die dynamischen Anforderungen von virtualisierten Umgebungen entstehen, benötigen moderne IT-Manager die richtigen Werkzeuge, die ihnen dabei helfen, fundierte, auf Fakten beruhende Entscheidungen zu treffen. Unternehmen benötigen eine genaue Planung und sorgfältige Überlegungen, um latenzempfindlichere Anwendungen zu virtualisieren.

Vor der Einführung von Flash-Speichern sollte ein System von Grund auf geprüft werden, um die wahrscheinlichen Auswirkungen zu bestimmen, ROI- und TCO-Berechnungen zu prüfen und Anleitungen für die Optimierung und das Forward-Engineering des SAN zu erarbeiten.

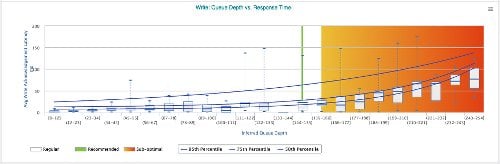

QueueDepthResponseTime: Mit Infrastructure Performance Management-Lösungen wie VirtualWisdom lassen sich Reaktionszeiten analysieren und suboptimale Performance-Messwerte schnell erkennen.

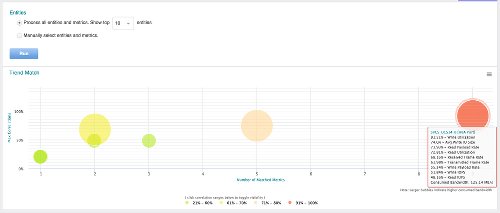

TrendMatch: Mit VirtualWisdom von Virtual Instruments haben Administratoren den aktuellen Bandbreitenverbrauch im Blick und können kritische Stellen und mögliche Probleme einfach erkennen.

Autor: Chris James, Marketing Director EMEA, Virtual Instruments.