Konvergente und hyper-konvergente Systeme mit einem Server-SAN existieren heute neben klassischen Speicherlösungen und geben Unternehmen flexible Möglichkeiten, Dateninfrastrukturen effizient und bedarfsgerecht bereitzustellen.

Software-definierte Infrastrukturen ermöglichen dabei bereits den Einsatz von kostengünstigen Standardkomponenten. Mit der Parallel- I/O-Technologie kommt nun eine Neuentwicklung, die Server so leistungsstark macht, dass sie klassischen Storage bald ablösen könnte. Storage ist im virtualisierten Rechenzentrum zu einem flexiblen Infrastruktur-Service geworden, der auf einem Server oder einer virtuellen Maschine residieren kann. Software-Defined Storage (SDS)-Lösungen auf Basis der Speichervirtualisierung liefern heute ger.te- und herstellerübergreifende Hochverfügbarkeit, ein zentrales, effizientes Datenmanagement sowie Technologien für Disaster Recovery-Szenarien. Dabei regelt die Plattform den effizienten Ressourceneinsatz etwa von Flash durch intelligentes Auto-Tiering zwischen Speicherklassen; sie führt zudem Migrationen im laufenden Betrieb durch und bietet Continuous Data Protection (CDP), Analyse sowie Prognostik und vieles mehr.

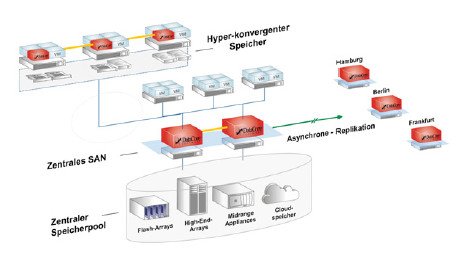

Längst bleiben diese Entwicklungen rund um SDS nicht auf das klassische SAN beschränkt. Konvergente und hyper-konvergente Konzepte mit einem Virtual SAN integrieren Computing, Netzwerk, Storage und Virtualisierung zur Dateninfrastruktur „in a Box“ und machen ein externes SAN in vielen Anwendungsbereichen obsolet. Doch in diesem Box-Modell liegt auch die Gefahr einer Investitionssackgasse. Hyper-konvergenz-Lösungen eignen sich für Remote-Standorte, Niederlassungen oder kleine Computerräume. Beschränkt bleiben sie bis heute oftmals bei der Skalierbarkeit und Systemperformance der Dateninfrastruktur aus Server und Storage. Hier soll künftig die Parallel-I/O-Technologie greifen.

Bild: Hyper-konvergente und herkömmliche SAN-Speicherarchitekturen ergänzen sich zu einer unternehmensweiten Dateninfrastruktur. (Quelle: DataCore)

Flaschenhals in der Dateninfrastruktur

Besonders hyper-konvergente Komplettlösungen verdeutlichen eine gemeinsame Entwicklung: Die Speicherressourcen werden Teil des Serversystems und rücken näher an die Applikation, um Kosten zu senken und entsprechende Performance zu gewährleisten. Sie werden heute in vielen spezifischen Systemumgebungen eingesetzt und ergänzen, zumindest in mittelständischen Unternehmen, die klassische Infrastruktur. Immer höhere Rechenleistung und Elastizität dieser x86-Server ermöglicht ihre Nutzung als Storage-System auch in unternehmenskritischen Bereichen, wodurch Investitions- und Betriebskosten deutlich gesenkt werden. Eine kleine Kehrseite hat aber auch diese Medaille: Die Storage-Performance entwickelt sich zunehmend zum Flaschenhals in diesen verdichteten Systemen einer Cloud-Infrastruktur.

Mit „Tick Tock“ bezeichnet man gerne die Taktraten von Prozessoren, vornehmlich in der x86-Familie, die die heutigen Rechnerlandschaften prägen. Die permanente Vervielfachung der Taktrate und damit rasante Zunahme an Rechengeschwindigkeit war eine Voraussetzung für die Ausbreitung dieser Serverarchitekturen in den produktiven IT-Betrieb der Unternehmen. Als die Dauermultiplizierung des Tick Tock an gewisse physikalische Grenzen stieß, entwickelte man Mehrkernarchitekturen, die weiterhin exponentielle Leistungssteigerungen möglich machten. Hyper-konvergente Systeme verdichten also immer mehr virtuelle Maschinen auf ein Hardware-System. Momentan finden sich bis zu 128 Kernels kombiniert in einem Prozessor, der die Rechenpower zur Verfügung stellen muss, um die konkurrierenden Workloads von immer mehr virtuellen Maschinen parallel zu verarbeiten.

The „Game Changer“

Parallel-I/O-Processing wurde durch die rasante Entwicklung moderner Mikroprozessoren quasi überflüssig und vernachlässigt. Während die Verarbeitung der anwendungsseitigen Arbeitslasten parallel erfolgt, werden die speicherseitigen Input/Output-Operationen (I/O) immer noch seriell abgewickelt – vergleichbar mit einer verkehrsreichen Mautstation, in der nur ein Kassenhäuschen besetzt ist. Dies führt zu einem Dilemma: Entweder nimmt man die Verlangsamung der virtualisierten Applikationen in Kauf, oder man muss die Anzahl der Server erhöhen, was den erhofften wirtschaftlichen Nutzen beschneidet.

Einen echten Quantensprung bringt jetzt eine von DataCore entwickelte und in einigen Benchmarks nachgewiesene Konzept: Die Parallel-I/O-Technologie eröffnet den Weg zu einer parallelen I/O-Verarbeitung, nutzt also deutlich mehr Leistungsstärke von modernen Multicore-Prozessoren, die heute mit für die Speicherverarbeitung in Dateninfrastrukturen zuständig sind, indem sie sie nebeneinander arbeiten lässt. In einem jüngst veröffentlichten Benchmark des etablierten Storage Performance Councils (SPC) erzielte Data-Cores Parallel-I/O-Software eine Latenzzeit von 100 Mikrosekunden – das ist zehn Mal schneller, als sämtliche All Flash-Arrays zu diesem Zeitpunkt nachgewiesen hatten. Den Price-Performance-Weltrekord hält die Software mit 0,08 US-Dollar pro SPC-1 IOPS (Input/Output-Operationen pro Sekunde) – vier Mal günstiger als der Zweitplatzierte und 91 Mal günstiger als die nächstplatzierte hyper-konvergente Lösung.

Durchgeführt wurden die Tests mit einem System zu einem Gesamtpreis von unter 40.000 US-Dollar inklusive Hardware, Software und dreijährigem Support. Damit wurden bei den Latenzzeiten High-End-Storages führender Hersteller, darunter auch All Flash-Systeme mit Kosten bis zu über einer Million US-Dollar, geschlagen.

Klassischer Storage auf dem Rückzug

Diese Ergebnisse auf Basis von Software-Defined Storage und Parallel-I/OTechnologie erschüttern herkömmliche Storage-Paradigmen grundlegend und bieten neue Möglichkeiten für den Einsatz von Standardhardware in der Dateninfrastruktur. Sie bedeuten weniger Server, schnellere Applikationen ohne zusätzlichen Hardwareeinsatz, eine höhere VM-Dichte pro Server und weniger Komplexität. Insgesamt eine optimale Leistung und geringe Latenzen mit weniger Investitionen. Die Parallel-I/O-Technologie könnte also der nächste „Game Changer“ werden, der die Spielregeln in der Speicherindustrie verändert: Anwender haben nicht mehr die Notwendigkeit, dedizierte Storage-Hardware für Hunderttausende an Euro ins Rechenzentrum zu stellen. Unternehmen, die hyperkonvergente Systeme bereits einsetzen, können diese auch nachträglich mit intelligenter Software kombinieren und damit Insellösungen konsolidieren und effektiver verwaltbar machen. Derzeit ist die Parallel-I/O-Technologie in der DataCore Hyper-Converged Virtual SAN-Software sowie der SDS-Plattform SANsymphony verfügbar.

Robert Thurnhofer