Über hyperkonvergente Infrastruktur sollten Unternehmen nachdenken, die auf automatisierte Standardaufgaben und einen stabilen Applikationsbetrieb setzen wollen. Einblicke in technische Details zeigen, warum die neuen Software-gesteuerten Komplettlösungen Kernanwendungen und verschiedene Workloads konsolidieren – und der Unternehmens-IT einen Entwicklungsschub geben können.

Fast die Hälfte der deutschen Mittelstands- und Großunternehmen arbeitet an datenbasierten Geschäftsmodellen und vernetzten Produkten. Das geht aus einer aktuellen Studie von Crisp Research und NetApp hervor. Mehr Gewicht erfährt so die Software-Entwicklung, die sich heute vor allem agiler Methoden wie Scrum oder Kanban bedient. DevOps (Development & Operations) wendet diese Konzepte auch auf den IT-Betrieb an. Entwickler und Administratoren benötigen möglichst viele automatisierte Prozesse, um wie angestrebt, die Release-Zyklen zu verkürzen. So sollen der Build aus dem Repository sowie System- und Performance-Tests automatisiert ablaufen. Entwickler legen ihren Code in einem zentralen Repository ab. Solche Repositorys benötigen skalierbaren Speicher, sodass sich neue Projekte ganz nach Bedarf schnell hinzufügen lassen. Um DevOps bestmöglich zu unterstützen, sollte der Speicher außerdem über einen hohen Automatisierungsgrad verfügen.

Die geforderte flexible Skalierung und Automatisierung beim Management und in der Bereitstellung von IT-Ressourcen liefert die neue Generation hyperkonvergenter Infrastrukturen (HCI), die bereits Marktreife erreicht hat. Mit diesen hochintegrierten Systemen können IT-Administratoren Storage und Server über ein gemeinsames Web-Frontend orchestrieren. Der eigentliche Effekt ist aber, dass sich Repositorys einfacher und schneller anpassen lassen – im Vergleich zu einer Umgebung, in der Server- und Storage-Infrastruktur getrennt ist.

Schlüsselfunktionen eines modernen Rechenzentrums

Die neuen HCIs können nicht nur die Software-Entwicklung auf die nächste Infrastrukturstufe heben, sondern generell die Evolution im IT-Betrieb in Richtung Next Generation Data Center (NGDC) vorantreiben. Zu den charakteristischen Merkmalen eines zukunftsfähigen Rechenzentrums zählen demnach – neben automatisiertem Management und flexibler Skalierbarkeit – garantierte Performance, einfaches Datenmanagement und Ausfallsicherheit. Diese Kriterien erfüllt bereits heute eine neue HCI, die Server, Speicher, Netzwerk und Virtualisierung Software-gesteuert zu einem funktionierenden Mikrorechenzentrum vereint. Ein Administrator dreht quasi nur noch den Schlüssel um – und alle Komponenten spielen perfekt zusammen.

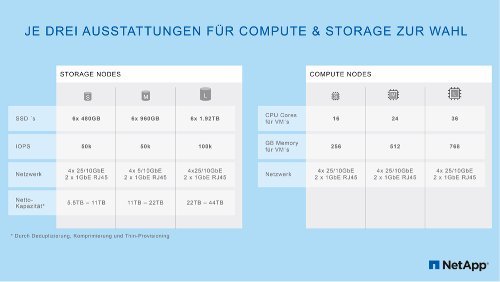

Bild 1: Es stehen je drei Ausstattungen für Compute und Storage zur Wahl. (Quelle: NetApp)

Virtualisierte Flash Storage und Standard Compute Nodes bilden hierbei einen Ressourcen-Pool, der alle Applikationen versorgt. Ebenso stehen integrierte Data Services wie Hochverfügbarkeit, Replikation, Datensicherung, Reduktion sowie Backup und Recovery bereit. Eine eingebaute Deployment Engine automatisiert und beschleunigt die Installation der HCI-Lösung, die nach rund 45 Minuten einsatzbereit ist. Das Management erfolgt über eine zentrale Konsole, beispielsweise die VMware vCenter, und beruht auf vielen automatisierten Standardprozessen. So bedarf es nur wenige Klicks, um eine Virtuelle Maschine (VM) aufzusetzen und zu provisionieren. Der Administrationsaufwand beschränkt sich auf das Nötigste, wobei die Zusatzoption besteht, ein Selbstbedienungsportal zu betreiben. Über das können sich Programmierer in wenigen Schritten eigenständig einen Testserver einrichten. Die Hilfe eines Administrators benötigen sie nicht.

Eingeschränkte Konvergenz

Auch bei einer konvergenten Infrastruktur (CI) hat ein Administrator weniger zu tun. Die in einer Box vorkonfigurierten Server, Speicher, Netzwerk und Virtualisierungstechnik lassen sich perfekt auf ein spezielles Anwendungsszenario wie SAP HANA abstimmen. Doch das Hardware-zentrierte System stößt schnell an Grenzen, wenn beispielsweise als weitere Anwendung eine VDI (Virtual Desktop Infrastructure) auf dem CI-System hinzukommen soll. Die Anforderungen, die sich aus beiden Workloads ergeben, kann die physikalisch aufgebaute Plattform nicht abdecken. Wesentlich flexibler stellen sich Unternehmen mit einer HCI auf. Denn diese Systeme beruhen auf dem Konzept, verschiedene Workloads auf einem System zu konsolidieren. Unter diesen Aspekt werden die HCI-Komponenten auf einander abgestimmt, wobei hardware-seitig zwar Standardprodukte zum Einsatz kommen, die jedoch spezielle Fähigkeiten aufweisen.

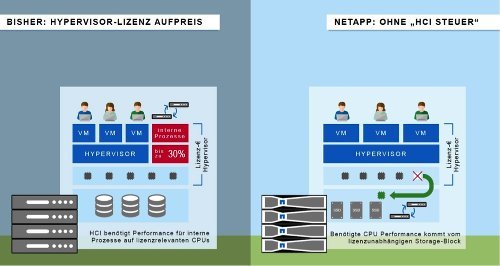

Bild 2: Im Vergleich zu bisherigen Modellen kommt bei NetApp HCI die benötigte CPU Performance vom lizenzunabhängigen Storage-Block. (Quelle: NetApp)

In das verbaute Speichersystem sollte vor allem eine garantierte Quality of Service (QoS) integriert sein. Dadurch vermeiden Unternehmen die Silobildung, die für latenzkritische Anwendungen typisch ist. QoS basiert darauf, dass jeder Applikation ein Minimalwert, ein Maximalwert und einen Burst-Wert an IOPS zugwiesen wird. Der Effekt: Verschiedene Applikationen, die auf denselben Ressourcen-Pool zugreifen, behindern sich nicht. Der IT-Betrieb läuft störungsfrei. Die garantierte Performance verbreitert das Einsatzspektrum, da sich nun beispielsweise eine VDI parallel mit einer Produktionsdatenbank auf derselben HCI betreiben lässt.

Wachstum nicht mehr blockiert

Flexibler wird der IT-Betrieb noch durch eine weitere Verbesserung: Das Wachstum ist nicht mehr an feste Blöcke gebunden. Die neuen hyperkonvergenten Systeme lassen sich horizontal skalieren. Ein Unternehmen erweitert bei Bedarf bloß den Speicher, ohne die Compute Nodes anzufassen und in neue CPU zu investieren. Das komponentenunabhängige Skalieren funktioniert auch anders herum und bewährt sich zusammen mit der QoS-Funktionalität beim Betrieb großer SQL- und NoSQL-Datenbanken.

Technologisch sichert ein intelligentes Speichersystem den Applikationsbetrieb ab. Der Vorgang, Datenblöcke doppelt im System abzulegen, sorgt für einen SSD-Ausfall vor. Tritt der ein, gereift ein intelligenter Prozess, der die zweite Kopie nutzt, um die Daten wiederherzustellen. Zudem verschiebt der Hypervisor betroffene VMs auf intakte Cluster. Das alles läuft automatisiert ab, sodass die Daten innerhalb von Minuten statt in Stunden oder Tagen wieder zur Verfügung stehen.

Daten in die Cloud und zurück verschieben

Ohne ein einfaches wie effizientes Datenmanagement lässt sich die Datenflut nicht beherrschen. Ein einheitliches Datenformat und eine einheitliche Datenübertragung erleichtern es Unternehmen, Informationen schnell am Verarbeitungsort bereitzustellen sowie zwischen Rechenzentrum und Cloud hin- und herzuschieben. Deshalb sollte eine zentrale Datenmanagementplattform zum Einsatz kommen, die diese Kriterien erfüllt. Aus dem Grund hat beispielsweise Datenmanagementspezialist NetApp seine HCI in die eigene Data Fabric eingebunden. In dieser Konstellation und über RESTful APIs zu den Hyperscalern Amazon Web Services, Azure oder Google machen hyperkonvergente Systeme die Unternehmens-IT Cloud-fähig

Die Datenübertragung von einer HCI in einen Cloud-Speicher gehört unter anderem zu den Standardaufgaben bei einer IoT-Anwendung. Unternehmen setzen hierbei das sogenannte Edge Computing um, wofür sie im Maschinenpark eine HCI-Lösung als Micro Data Center installieren. Die Box analysiert Daten bereits am Entstehungsort und leitet nur relevante Informationen an das zentrale Rechenzentrum weiter. Hier ist nur selten IT-Personal vor Ort. Für solche Anwendungsfälle brauchen Unternehmen ein System, das sowohl Rechenleistung als auch Speicher bietet und sich mit wenig Aufwand in Betrieb nehmen und managen lässt.

Wegweisende Konsolidierung

HCIs der zweiten Generation sorgen für einen stabilen wie effizienten IT-Betrieb, zu dessen wesentlichen Eigenschaften dann automatisiertes Management, flexible Skalierbarkeit, garantierte Performance, einfaches Datenmanagement und Ausfallsicherheit zählen. Das entspricht dem Anforderungsprofil, das ansonsten mit einem NGDC in Verbindung gebracht wird. Den Weg dorthin weisen die neuen HCI-Lösungen, die für eine Konsolidierung von verschiedenen Workloads auf einem System konzipiert sind. Die Software-gesteuerten Komplettlösungen sollten daher für alle Branchen interessant sein, um Kernanwendungen wie spezielles Workloads stark automatisiert zu betreiben, ohne Leistungseinbußen fürchten zu müssen. Durch die flexible und unabhängige Skalierung von Compute und Storage haben Unternehmen die Chance, zunächst klein mit der Einstiegsvariante von zwei Compute und Storage Nodes zu starten. Sie können die zwei Chassis sukzessive zu einem großen modernen Rechenzentrum aufrüsten – und zwar in dem Ausmaß und Tempo wie sie tatsächlich wachsen. Diese nächste Evolutionsstufe im IT-Betrieb lohnt sich. Auch weil Silos sowie unnötige Hardware- und Lizenzkosten nicht mehr entstehen, was in anderen Infrastrukturen an der Tagesordnung ist.

Johannes Wagmüller ist Director Systems Engineering, Germany, bei NetApp (Quelle: NetApp)

Johannes Wagmüller ist Director Systems Engineering bei NetApp, als welcher er seit 2010 den technischen Vertrieb des Storage-Herstellers und Datenmanagementspezialisten in Deutschland leitet. Die technische Beratung sowie die Konzeption von Storage- und Datenmanagement Lösungen ist der Schwerpunkt seiner Arbeit. Wagmüller ist bereits seit 2002 bei NetApp, wo er in München als Systems Engineer begann. Vor NetApp war Wagmüller in Professional Service und Pre-Sales Funktionen unter anderem bei Compugraphic und Silicon Graphics tätig.