Die Entscheidung für eine Cloud-Infrastruktur bedeutet heute oft eine Entscheidung zwischen globaler Reichweite und regionaler Souveränität, zwischen etabliertem Ökosystem und Kostentransparenz.

Während Hyperscaler wie AWS, Google Cloud und Microsoft Azure mit umfassenden Service-Portfolios und weltweiter Präsenz punkten, gewinnen europäische Cloud-Anbieter durch transparentere Preismodelle, DSGVO-native Architekturen und die Vermeidung geopolitischer Compliance-Risiken zunehmend an Bedeutung.

Dieser Artikel analysiert die versteckten Kostenaspekte bei Hyperscalern, beleuchtet die regulatorischen Herausforderungen grenzüberschreitender Datenspeicherung und stellt europäische Alternativen vor. Dabei betrachten wir sowohl etablierte Player wie OVHcloud und StackIT als auch jüngere Anbieter wie Impossible Cloud und Scaleway. Transparenzhinweis: Dieser Artikel wurde unabhängig erstellt. Der Autor hat keine finanziellen Beziehungen zu den genannten Cloud-Anbietern. Produktnennungen dienen der redaktionellen Information und stellen keine Kaufempfehlung dar.

Die Anatomie versteckter Cloud-Kosten

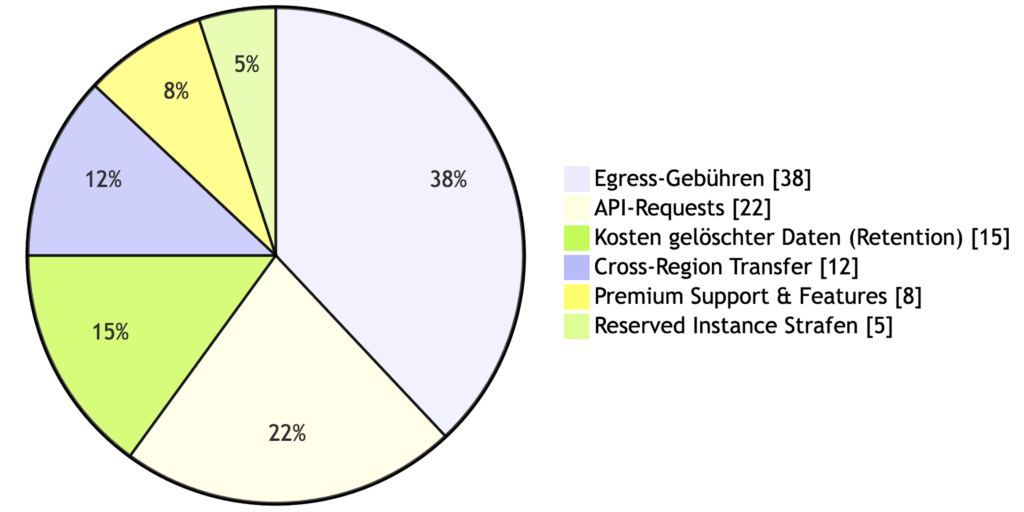

Das größte Missverständnis bei Cloud-Kostenschätzungen liegt in der Annahme, dass der beworbene Storage-Preis pro Gigabyte die tatsächlichen Kosten widerspiegelt. In der Realität entwickelt sich die monatliche Rechnung oft zu einer komplexen Zusammensetzung aus zahlreichen Einzelpositionen.

Egress-Gebühren als Hauptkostentreiber

Der größte Kostentreiber bei Hyperscalern sind Egress-Gebühren, also Kosten für das Abrufen eigener Daten aus der Cloud. Bei AWS beispielsweise können diese je nach Region zwischen 0,05 und 0,15 Dollar pro Gigabyte liegen. Für ein Unternehmen, das täglich 10 Terabyte an Backup-Daten oder Mediendateien abruft, summiert sich dies auf monatliche Egress-Kosten zwischen 15.000 und 45.000 Dollar, unabhängig von den eigentlichen Speicherkosten.

Cross-Region-Transfer und API-Costs

Hinzu kommen Cross-Region-Transfer-Gebühren, wenn Daten zwischen verschiedenen geografischen Rechenzentrumsstandorten bewegt werden, API-Request-Gebühren bei hohen Zugriffszahlen, sowie Kosten für erweiterte Features wie Object Lock, detaillierte Audit-Logs oder automatisierte Lifecycle-Policies. Die Komplexität der Preismodelle macht eine präzise Kostenschätzung zur Herausforderung. Eine Studie von Flexera aus 2024 zeigt, dass Unternehmen durchschnittlich 28 Prozent ihres Cloud-Budgets durch ungenutzte oder falsch dimensionierte Ressourcen verschwenden.

Europäische Anbieter setzen hier oft auf vereinfachte Modelle. Viele verzichten vollständig auf Egress-Gebühren oder bieten Flatrates für Datenverkehr an. Dies schafft nicht nur Kostentransparenz, sondern beseitigt auch einen zentralen Lock-in-Mechanismus, da Unternehmen ihre Daten ohne prohibitive Kosten migrieren können.

Dennoch gilt auch hier: Genau nachfragen. Support-Tiers können kostenpflichtig sein, Minimum-Commitments für attraktive Preise erforderlich werden, und spezielle Features wie WORM-Storage oder erweiterte Compliance-Tools können zusätzliche Gebühren verursachen.

Regulatorische Komplexität: Der geopolitische Faktor

Für europäische Unternehmen wird die Cloud-Entscheidung zunehmend zu einer Frage der Rechtssicherheit und Datensouveränität.

US CLOUD Act und DSGVO im Konflikt

Der US CLOUD Act ermöglicht amerikanischen Behörden den Zugriff auf Daten, die von US-Unternehmen kontrolliert werden, unabhängig vom physischen Speicherort der Server. Ein deutsches Unternehmen, das einen US-Hyperscaler nutzt und Daten in Frankfurt speichert, unterliegt damit potenziell zwei widersprüchlichen Rechtsordnungen: der europäischen Datenschutz-Grundverordnung und dem US CLOUD Act.

Schrems II und seine Folgen für Unternehmen

Das Schrems-II-Urteil des Europäischen Gerichtshofs von 2020 hat die Verwendung von Standardvertragsklauseln für Datenübermittlungen in die USA erschwert, da US-Überwachungsgesetze wie FISA 702 mit europäischen Datenschutzgrundsätzen kollidieren. Unternehmen müssen nun im Einzelfall prüfen, ob die Datenübermittlung rechtssicher ist, und zusätzliche Schutzmaßnahmen implementieren.

NIS2-Richtlinie für kritische Infrastrukturen

Die NIS2-Richtlinie der Europäischen Union verschärft diese Anforderungen für kritische Infrastrukturen zusätzlich. Betreiber wesentlicher und wichtiger Dienste müssen ab Oktober 2024 erhöhte Cybersicherheitsstandards erfüllen und Sicherheitsvorfälle innerhalb von 24 Stunden melden. Die Wahl eines Cloud-Anbieters wird damit auch zu einer Compliance-Entscheidung.

Europäische Anbieter mit ausschließlich europäischer Infrastruktur und Rechtsunterstellung umgehen diese Konfliktzone von vornherein. Sie unterliegen nur europäischem Recht und können Datenherausgabeverlangen nur bei gültigen europäischen Gerichtsbeschlüssen nachkommen. Dies reduziert nicht nur rechtliche Risiken, sondern auch den administrativen Aufwand für Datenschutz-Folgenabschätzungen und die Dokumentation von Schutzmaßnahmen.

Zertifizierungen als Entscheidungskriterium

Allerdings: Auch europäische Anbieter sind nicht per se DSGVO-konform oder sicher. Entscheidend sind Zertifizierungen wie ISO 27001, SOC 2 Type II oder das BSI C5-Testat. Unternehmen sollten diese Nachweise einfordern und prüfen, bevor sie sensible Daten migrieren.

Technische Kompatibilität als Migrationshürde

Eine der größten Ängste bei der Migration zu alternativen Cloud-Anbietern ist die technische Integration. Funktioniert die bestehende Infrastruktur mit einem neuen Anbieter? Müssen Applikationen umgeschrieben werden?

S3-API-Kompatibilität in der Praxis

Für reine Speicher-Workloads bieten viele europäische Anbieter vollständige S3-API-Kompatibilität. Die S3-Schnittstelle von Amazon Web Services hat sich zum de-facto-Standard für Object Storage entwickelt. Anwendungen, Backup-Lösungen wie Veeam oder Commvault, und Analyse-Tools, die mit AWS S3 arbeiten, lassen sich in der Regel nahtlos mit S3-kompatiblen Alternativen verbinden. In den meisten Fällen müssen lediglich Endpoint-URL, Access Key und Secret Key angepasst werden.

Grenzen der Kompatibilität bei erweiterten Features

Die technische Realität ist jedoch nuancierter. Vollständige S3-Kompatibilität bedeutet Unterstützung für Basisfunktionen wie GET, PUT, DELETE, LIST und Multipart-Uploads. Hyperscaler-spezifische Erweiterungen wie AWS Event Notifications, komplexe IAM-Policies, S3 Batch Operations oder bestimmte Security-Features werden möglicherweise nicht identisch abgebildet. Unternehmen sollten vor der Migration eine detaillierte Feature-Analyse durchführen und prüfen, welche AWS-spezifischen Funktionalitäten tatsächlich genutzt werden.

Proprietäre Hyperscaler-Dienste und Re-Engineering

Bei Nutzung proprietärer Hyperscaler-Dienste steigt die Komplexität erheblich. Serverless Functions wie AWS Lambda, managed Databases wie Aurora oder RDS, Streaming-Services wie Kinesis oder Machine-Learning-Plattformen wie SageMaker haben keine direkten Äquivalente bei alternativen Anbietern. Hier ist ein Re-Engineering erforderlich, oft verbunden mit erheblichem Entwicklungsaufwand.

Die pragmatische Antwort auf diese Herausforderung ist ein phasenweiser, use-case-getriebener Migrationsansatz. Beginnen Sie mit kostenintensiven, aber technisch einfachen Workloads: kalte Backups, Archivdaten, statische Webinhalte oder Medienarchive. Diese nutzen typischerweise nur Standard-S3-Funktionalität und bieten schnelle Erfolge bei der Kostensenkung. Hochspezialisierte Anwendungen, die tief in hyperskalare Services integriert sind, können auch langfristig dort verbleiben. Es geht um strategische Diversifizierung, nicht um dogmatische Totalumsiedlung.

Ein paralleler Multi-Cloud-Betrieb während einer Pilotphase minimiert das Risiko und erlaubt realistische Performance- und Kostentests unter Produktionsbedingungen.

Due Diligence: Die vier kritischen Fragen

Ein Wechsel ist also kein Selbstläufer. Er erfordert eine nüchterne Due Diligence, die folgende Fragen beantworten muss:

- Sind unsere kritischen Workloads technisch kompatibel (nicht nur API, auch Features)?

- Wie sieht der konkrete Migrationspfad und -zeitplan aus?

- Welche der versprochenen Einsparungen lassen sich für unsere Nutzungsmuster validieren?

- Welche neuen operativen Prozesse oder Skills sind erforderlich?

Europäische Cloud-Anbieter im Überblick

Der europäische Cloud-Markt ist heterogener als oft angenommen. Neben den großen Hyperscalern, die auch europäische Rechenzentren betreiben, existiert ein Ökosystem spezialisierter Anbieter mit unterschiedlichen Schwerpunkten.

OVHcloud – Europas größter unabhängiger Anbieter

OVHcloud ist Europas größter unabhängiger Cloud-Anbieter mit Hauptsitz in Frankreich. Das Unternehmen betreibt 43 Rechenzentren weltweit, davon 24 in Europa, und bietet ein breites Portfolio von Bare-Metal-Servern über Public Cloud bis zu Storage-Lösungen. OVHcloud positioniert sich als kostengünstige Alternative mit hoher Kapazität, ist aber weniger auf Enterprise-Features fokussiert als die großen Hyperscaler. Die Preisgestaltung ist transparent, Support und Dokumentation erreichen jedoch nicht immer Hyperscaler-Niveau.

StackIT – Deutsche Cloud der Schwarz Gruppe

StackIT, die Cloud-Plattform der Schwarz Gruppe (Lidl, Kaufland), richtet sich gezielt an den deutschen Mittelstand und öffentliche Auftraggeber. Mit Rechenzentren ausschließlich in Deutschland und Österreich und einer klaren DSGVO-Compliance-Strategie adressiert StackIT Unternehmen, die Wert auf Datensouveränität legen. Das Portfolio umfasst IaaS, PaaS und verschiedene Managed Services. Als relativ junger Anbieter baut StackIT sein Angebot kontinuierlich aus, kann aber noch nicht mit der Feature-Breite der Hyperscaler mithalten.

IONOS Cloud – Telekom-Partner für den Mittelstand

IONOS Cloud, Teil von United Internet, profitiert von einer Partnerschaft mit der Deutschen Telekom und fokussiert sich auf den DACH-Markt. Die Plattform bietet solide Grundfunktionalität mit besonderem Fokus auf KMUs und ist bekannt für deutschen Support und einfache Bedienbarkeit. Die Innovationsgeschwindigkeit ist geringer als bei Tech-First-Anbietern, dafür punktet IONOS mit Stabilität und lokalem Service.

Scaleway – Developer-freundliche Innovation

Scaleway, ein französischer Anbieter der Iliad-Gruppe, positioniert sich als Developer-freundliche Alternative mit innovativen Features. Das Unternehmen bietet spezialisierte Services wie ARM-basierte Cloud-Instanzen, Kubernetes-Management und Object Storage mit S3-Kompatibilität. Die Preisstruktur ist etwas komplexer als bei Mitbewerbern, dafür ist die technologische Ausrichtung modern. Scaleway eignet sich besonders für Startups und Tech-Unternehmen, die Wert auf Flexibilität und moderne Architekturen legen.

Impossible Cloud – Radikaler Storage-Fokus

Impossible Cloud verfolgt als jüngster Anbieter einen radikalen Ansatz: vollständiger Verzicht auf Egress-Gebühren, aggressive Preisgestaltung und Fokus auf S3-kompatiblen Object Storage. Das 2022 gegründete Unternehmen richtet sich primär an Unternehmen, die von AWS S3 migrieren möchten, und bietet nach eigenen Angaben Einsparungen von 50 bis 80 Prozent bei datenintensiven Workloads. Als junges Unternehmen fehlt jedoch die Track-Record-Historie etablierter Anbieter, und das Service-Portfolio beschränkt sich auf Storage-Lösungen.

Gaia-X – Standards-Framework statt Cloud-Anbieter

Gaia-X ist kein direkter Cloud-Anbieter, sondern eine europäische Initiative für föderierte Dateninfrastrukturen. Ziel ist die Schaffung eines Standards-Frameworks für Datensouveränität, Interoperabilität und Transparenz. Erste Gaia-X-konforme Dienste werden ab 2025 erwartet. Für Unternehmen ist Gaia-X relevant als zukünftiges Zertifizierungs-Framework, sollte aber aktuelle Migrationsentscheidungen nicht blockieren.

Kostenvergleich in der Praxis

Die Frage nach konkreten Einsparungen lässt sich nicht pauschal beantworten, sondern ist stark use-case-abhängig. Entscheidend sind Faktoren wie Datenvolumen, Zugriffshäufigkeit, geografische Verteilung, benötigte Features und bestehende Enterprise-Rabatte.

Beispielrechnung: 100 TB Storage mit 50 TB Egress

Für datenintensive Workloads mit hohen Egress-Volumina, etwa Medienarchivierung, Backup-Systeme oder Data-Lake-Speicherung, können die Einsparungen signifikant sein. Bei einem Unternehmen, das 100 Terabyte speichert und monatlich 50 Terabyte abruft, entstehen bei AWS S3 Standard in der Region Frankfurt folgende Kosten: circa 2.300 Dollar für Storage und etwa 4.500 Dollar für Egress, insgesamt also rund 6.800 Dollar monatlich. Ein europäischer Anbieter ohne Egress-Gebühren würde bei vergleichbarem Storage-Preis etwa 2.300 Dollar kosten, eine Ersparnis von rund 66 Prozent.

Storage-Klassen und Enterprise-Rabatte berücksichtigen

Diese Rechnung ist jedoch vereinfacht. AWS bietet verschiedene Storage-Klassen wie S3 Intelligent-Tiering, S3 Glacier für Archive oder S3 One Zone-IA für weniger kritische Daten, die deutlich günstiger sind. Enterprise-Kunden erhalten üblicherweise Rahmenverträge mit Rabatten von 20 bis 40 Prozent auf Listenpreise. Cross-Region-Replizierung, erweiterte Monitoring-Features oder Integration in andere AWS-Services können zusätzlichen Wert bieten, der in einer reinen Preisbetrachtung nicht sichtbar wird.

Umgekehrt haben europäische Anbieter oft niedrigere Basispreise auch für selten abgerufene Daten, verzichten aber auf differenzierte Storage-Klassen. Unternehmen zahlen dann auch für kalte Archive den Premium-Preis für “heißen” Storage, was die Ersparnis schmälern kann.

Total Cost of Ownership über drei Jahre

Eine realistische Einschätzung erfordert daher eine individuelle Total-Cost-of-Ownership-Analyse über mindestens drei Jahre, die neben direkten Kosten auch Migrationsaufwände, Schulungen, eventuell notwendige Prozessanpassungen und das Risiko von Vendor-Lock-in berücksichtigt.

Unabhängige Analysten wie Gartner empfehlen einen strukturierten Evaluierungsprozess: Analyse der aktuellen Cloud-Rechnung über drei Monate, Identifizierung von Kostenblöcken, Erstellen eines Workload-Profils, Einholen vergleichbarer Angebote mit identischen Anforderungen und Durchführung eines Proof-of-Concept mit realistischen Lastprofilen.

TCO-Rechner für Backup und Recovery

Helfen können auch TCO-Rechner. Dieser NetApp-Rechner vergleicht zwar primär NetApp-Lösungen mit Hyperscalern, illustriert aber gut die versteckten Kostentreiber bei AWS, Azure und Google Cloud: https://www.netapp.com/de/data-services/backup-and-recovery-tco-calculator/

zusammensetzt und welche Posten bei einem transparenten Modell (Beispiel Impossible

Cloud) wegfallen oder deutlich reduziert werden.

Versteckte Kosten auch bei europäischen Alternativen

Die Transparenz ist ein Wert an sich, doch bei jedem Anbieter, siehe auch die nachfolgende Anbietertabelle) müssen mögliche versteckte oder variable Kosten hinterfragt werden.

Dazu zählen Support-Tiers, Mindestcommitments, Feature-Aufpreise oder Bandbreitenrestriktionen. Speziell Object-Lock-Funktionalitäten (WORM) und erweiterte Audit-Logs können je nach Anbieter kostenpflichtig sein.

- Support-Tiers und Minimum Commitments: Ist ein 24/7 Enterprise-Support mit 15-Minuten-Reaktionszeit im Basistarif enthalten oder kostenpflichtig? Gibt es implizite Mindestnutzungen, um attraktive Preise zu erhalten?

- Feature-Aufpreise für Object Lock und Audit-Logs: Sind Funktionen wie Object Lock, detaillierte Access-Logs oder erweiterte Analytics kostenlos?

- Bandbreitenrestriktionen trotz Egress-Freiheit: Fallen trotz fehlender Egress-Gebühren Kosten für extrem hohe Transfervolumen an?

Performance und Service Level Agreements

Neben Kosten ist Performance ein kritischer Entscheidungsfaktor. Die Frage “Sind Sie schneller als AWS?” lässt sich jedoch nicht pauschal beantworten, da Performance stark vom Anwendungsfall abhängt.

Regionale vs. globale Performance

Für sequentielle Zugriffe auf große Objekte innerhalb Europas können regionale Anbieter Vorteile bieten, da Netzwerklatenz zu lokalen Rechenzentren geringer ist. Für global verteilte Zugriffe oder die Integration in andere Cloud-Services ist die weltweite Infrastruktur der Hyperscaler überlegen.

Verfügbarkeit: 99,9% vs. 99,99%

Entscheidend sind konkrete Service Level Agreements. AWS S3 garantiert beispielsweise 99,99 Prozent Verfügbarkeit und elf Neunen Durability (99,999999999 Prozent). Vergleichbare europäische Anbieter bieten typischerweise 99,9 bis 99,95 Prozent Verfügbarkeit. Der Unterschied klingt minimal, bedeutet aber bei 99,9 Prozent etwa 43 Minuten Ausfallzeit pro Monat gegenüber 4 Minuten bei 99,99 Prozent.

Support-SLAs und Technical Account Manager

Für Unternehmen sind auch Support-SLAs relevant. Enterprise-Support bei AWS beinhaltet 15-Minuten-Reaktionszeiten für kritische Fälle und einen Technical Account Manager. Viele europäische Anbieter bieten vergleichbare Support-Level optional oder als kostenpflichtiges Add-on an.

Proof-of-Concept als Performance-Bewertung

Der optimale Weg zur Performance-Bewertung ist ein strukturierter Proof-of-Concept, der realistische Zugriffsmuster, Objektgrößen, Lastprofile und geografische Verteilung abbildet. Nur so lassen sich theoretische Spezifikationen in praktische Erkenntnisse übersetzen.

Die Migrationsstrategie: Pragmatismus statt Revolution

Die Vorstellung eines “Big Bang”, bei dem alle Workloads simultan migriert werden, ist weder notwendig noch empfehlenswert. Erfolgreiche Cloud-Migrationen folgen einem phasenweisen Ansatz, der Risiken minimiert und schnelle Erfolge ermöglicht.

Phase 1: Kostenintensive, unkomplizierte Workloads

Phase eins fokussiert auf kostenintensive, aber technisch unkomplizierte Workloads. Kalte Backups, die selten abgerufen werden, aber Speicherplatz belegen, sind ideale Kandidaten. Archivdaten ohne Echtzeitanforderungen, statische Webinhalte oder Medienbibliotheken folgen. Diese Workloads nutzen Standard-S3-Funktionalität, haben geringe Performance-Anforderungen und bieten schnelle Kosteneinsparungen.

Phase 2: Aktive Workloads mit Proof-of-Concept

Phase zwei betrachtet aktive Workloads mit höheren Anforderungen an Verfügbarkeit und Performance. Hier ist ein Proof-of-Concept unter Produktionsbedingungen sinnvoll, idealerweise mit parallelem Betrieb zur Risikominimierung. Monitoring von Performance-Metriken, Verfügbarkeit und Anwendungsverhalten über mehrere Wochen gibt Sicherheit für die vollständige Migration.

Phase 3: Komplexe Anwendungen und Neu-Architektur

Phase drei evaluiert komplexe Anwendungen mit tiefer Integration in Hyperscaler-Ökosysteme. Hier ist oft eine Neu-Architektur sinnvoller als eine Migration, etwa durch Containerisierung mit Kubernetes, die Anbieter-Unabhängigkeit schafft.

Datenmigration: Netzwerk vs. Offline-Transfer

Für die Datenmigration selbst existieren verschiedene Ansätze. Bei kleineren Volumina bis 10 Terabyte ist eine Netzwerk-Migration über dedizierte Verbindungen praktikabel. Für größere Datenmengen bieten manche Anbieter Offline-Transfers per Speicher-Appliance an. Die reine Transferzeit bei 10 Gigabit pro Sekunde Bandbreite beträgt für 500 Terabyte etwa 5 Tage, in der Praxis sind jedoch 2 bis 3 Wochen realistisch, da Netzwerk-Overhead, Validierung und Cutover-Koordination hinzukommen.

Change Management und Mitarbeiter-Training

Ein kritischer Erfolgsfaktor ist das Change Management. IT-Teams müssen mit neuen Administrationsoberflächen, anderen IAM-Konzepten, modifizierten Monitoring-Tools und veränderten Billing-Prozessen vertraut gemacht werden. Ein bis zwei Tage intensives Training und begleitende Dokumentation sind typischerweise ausreichend, da AWS-Kenntnisse weitgehend transferierbar sind.

Herausforderungen und ehrliche Nachteile

Bei aller Attraktivität europäischer Alternativen ist eine ehrliche Betrachtung der Nachteile essentiell für fundierte Entscheidungen.

Fehlendes Service-Ökosystem der Hyperscaler

Das umfassendste Defizit ist das fehlende Service-Ökosystem. AWS bietet über 200 Services, von spezialisierten Datenbanken über Machine-Learning-Plattformen bis zu IoT-Infrastrukturen. Diese nahtlose Integration in ein einheitliches Ökosystem, gemeinsame IAM-Strukturen und konsistente Logging- und Monitoring-Tools schaffen erheblichen Mehrwert, der in reinen Kostenvergleichen nicht abgebildet wird. Europäische Anbieter fokussieren sich typischerweise auf Kern-Services wie Compute, Storage und Networking.

Begrenzte globale Präsenz europäischer Anbieter

Die globale Präsenz ist ein weiterer Vorteil der Hyperscaler. AWS betreibt über 30 geografische Regionen weltweit, Azure und Google Cloud ähnlich viele. Für Unternehmen mit globalen Operationen und Anforderungen an lokale Datenresidenz in Asien, Lateinamerika oder Australien sind europäische Anbieter mit primär kontinentaler Infrastruktur keine vollständige Alternative.

Kleinere Developer-Community und Dokumentation

Die Developer-Community und das Ökosystem aus Tools, Frameworks, Bibliotheken und Integrationen ist bei Hyperscalern ungleich größer. Für fast jede technische Herausforderung existieren Lösungsvorschläge, Stack-Overflow-Diskussionen, Open-Source-Tools und Consulting-Partner. Bei neueren europäischen Anbietern ist diese Community kleiner, Dokumentation weniger umfassend, und die Verfügbarkeit spezialisierter Expertise geringer.

Unternehmensrisiko bei jüngeren Anbietern

Das Unternehmensrisiko bei Startups oder jüngeren Anbietern ist ein realer Faktor. Während die Insolvenzwahrscheinlichkeit bei gut finanzierten Unternehmen gering ist, muss sie bei kritischen Workloads bedacht werden. S3-Kompatibilität erleichtert Exit-Szenarien, dennoch bedeutet eine Anbieter-Migration Aufwand und potenzielle Disruption.

Die strategische Gesamtbetrachtung

Die Analyse der versteckten Kosten und Risiken von Hyperscalern führt zu einer differenzierten Erkenntnis.

Hybrid- und Multi-Cloud als optimale Strategie

Die optimale Cloud-Strategie ist für die meisten Unternehmen eine hybride oder Multi-Cloud-Architektur, die spezifische Stärken unterschiedlicher Anbieter für passende Workloads nutzt.

Hyperscaler bieten unschlagbare Vorteile für global skalierte, hochintegrierte Anwendungen, die ihr Service-Ökosystem nutzen. Innovation, Feature-Geschwindigkeit und weltweite Reichweite rechtfertigen oft höhere Kosten. Europäische Anbieter punkten bei datenintensiven, compliance-kritischen Workloads mit transparenter Kostenstruktur, regionalem Support und DSGVO-nativer Architektur.

Fünf zentrale Entscheidungsfragen

Die Entscheidung sollte nicht ideologisch, sondern pragmatisch getroffen werden, basierend auf einer ehrlichen Bestandsaufnahme der eigenen Anforderungen, Risikotoleranz und strategischen Prioritäten. Folgende Fragen strukturieren den Entscheidungsprozess:

Erstens, welche Workloads verursachen die höchsten Cloud-Kosten, und wo liegen die Hauptkostentreiber? Eine detaillierte Analyse der aktuellen Rechnung über drei Monate identifiziert Ansatzpunkte.

Zweitens, welche regulatorischen und Compliance-Anforderungen gelten für unsere Daten? KRITIS-Betreiber, Gesundheitsdienstleister oder Finanzinstitute unterliegen strengeren Vorgaben als E-Commerce-Unternehmen.

Drittens, wie stark sind unsere Anwendungen in Hyperscaler-spezifische Services integriert? Eine ehrliche technische Bestandsaufnahme zeigt Migrationsaufwände.

Viertens, welche Performance- und Verfügbarkeitsanforderungen haben unsere kritischen Workloads wirklich? Nicht jede Anwendung benötigt fünf Neunen Verfügbarkeit.

Fünftens, welche Risikotoleranz haben wir bezüglich Anbieter-Stabilität, und wie wichtig ist uns strategische Unabhängigkeit?

Die Beantwortung dieser Fragen ermöglicht eine fundierte Entscheidung, die technische, wirtschaftliche und strategische Aspekte integriert.

Differenzierte Multi-Cloud-Architektur

Das Ergebnis ist oft eine differenzierte Multi-Cloud-Strategie: Hyperscaler für Innovation und globale Services, europäische Spezialanbieter für souveräne, kosteneffiziente Kern-Workloads.

Praktische Handlungsempfehlungen

Für IT-Entscheider, die eine Evaluierung europäischer Cloud-Alternativen erwägen, bieten sich folgende Schritte an.

Dreimonatige Kostenanalyse durchführen

Beginnen Sie mit einer dreimonatigen Kostenanalyse Ihrer aktuellen Cloud-Nutzung. Isolieren Sie Egress-Kosten, API-Request-Volumina, Cross-Region-Transfers und Feature-Aufpreise. Identifizieren Sie die teuersten Workloads und analysieren Sie deren technische Anforderungen.

Workload-Profil erstellen

Erstellen Sie ein detailliertes Workload-Profil für die drei kostenintensivsten Use Cases: durchschnittliches Datenvolumen, Wachstumsrate, Zugriffsmuster, Performance-Anforderungen, geografische Verteilung, Compliance-Vorgaben und genutzte Cloud-Services.

Vergleichbare Angebote einholen

Holen Sie vergleichbare Angebote von mindestens drei europäischen Anbietern ein, basierend auf identischen Anforderungen. Fordern Sie explizit Auskunft zu versteckten Kosten wie Support-Tiers, Minimum-Commitments und Feature-Aufpreisen.

Proof-of-Concept über 4-8 Wochen

Führen Sie einen strukturierten Proof-of-Concept durch, idealerweise über 4 bis 8 Wochen. Testen Sie realistische Workloads, messen Sie Performance-Metriken, evaluieren Sie Administrations-Interfaces und bewerten Sie Support-Qualität. Ein paralleler Betrieb minimiert Risiken.

TCO-Berechnung über drei Jahre

Erstellen Sie eine Total-Cost-of-Ownership-Berechnung über drei Jahre, die neben direkten Kosten auch Migrationsaufwände, Schulungen, mögliche Anpassungen an Prozessen und Tools sowie Exit-Kosten berücksichtigt. Bewerten Sie quantitative und qualitative Faktoren wie Compliance-Vereinfachung, strategische Unabhängigkeit und Risikoreduktion.

Phasenweisen Migrationsplan entwickeln

Entwickeln Sie einen phasenweisen Migrationsplan, der mit unkritischen, aber kostenintensiven Workloads beginnt, Erfolge dokumentiert und auf dieser Basis weitere Phasen plant. Definieren Sie klare Entscheidungskriterien für Go/No-Go an definierten Meilensteinen.

Ausblick: Die Zukunft der europäischen Cloud

Die europäische Cloud-Landschaft entwickelt sich dynamisch.

Regulatorische Initiativen der EU

Regulatorische Initiativen wie die NIS2-Richtlinie, der Data Act und das Digital Markets Act der EU fördern Interoperabilität, Datensouveränität und offene Standards. Dies schafft strukturelle Vorteile für europäische Anbieter.

Hyperscaler investieren in europäische Souveränität

Gleichzeitig investieren Hyperscaler massiv in europäische Rechenzentren und bieten verstärkt DSGVO-Compliance-Tools an. AWS hat eine “European Sovereign Cloud” angekündigt, Microsoft bietet “EU Data Boundary”, und Google Cloud verstärkt seine europäische Präsenz. Die Grenzen verschwimmen zunehmend.

Intelligente Hybrid-Strategien als Zukunft

Für Unternehmen bedeutet dies: Die Entscheidung zwischen Hyperscalern und europäischen Alternativen wird nicht einfacher, sondern differenzierter. Die besten Ergebnisse werden jene erzielen, die technologische, wirtschaftliche und strategische Faktoren integriert betrachten und ihre Cloud-Architektur kontinuierlich an veränderte Anforderungen anpassen.

Die Zukunft gehört nicht dem einen oder anderen Modell, sondern intelligenten Hybrid-Strategien, die für jeden Workload den optimalen Ort finden – basierend auf Daten, nicht Dogmen.

FAQ

Wie berechne ich die Wirtschaftlichkeit eines Wechsels?

Erstellen Sie eine 3-Monats-Analyse Ihrer aktuellen Hyperscaler-Rechnung:

– Isolieren Sie die Egress-Kosten – oft 20-40% der Gesamtrechnung

– Zählen Sie API-Requests – bei >100 Mio./Monat signifikant

– Identifizieren Sie “kalte” Daten – ideal für Migration zuerst

– Vergleichen Sie die Preise mit denen anderer Anbieter

Gibt es versteckte Gebühren bei europäischen Anbietern?

Viele europäische Cloud-Anbieter haben keine „versteckten“ Gebühren im eigentlichen Sinne, aber differenzierte Kosten für Traffic, API-Calls oder Mindestlaufzeiten, die leicht übersehen werden können. Versteckt bedeutet hier: Kosten, die oft nicht im Marketing-Preis (etwa „x €/TB Speicher“) stehen, sondern in separaten Traffic-/Operations-Tabellen oder AGBs geregelt sind. Für eine konkrete Auswahl lohnt sich der Blick in die jeweilige detaillierte Preisliste (Traffic-Staffelung, API-Gebühren, Mindestvolumen) sowie in SLA/AGB, da sich Konditionen je nach Region, Produktlinie, Laufzeit und Vertragstyp unterscheiden. Achten Sie darauf, ob das Modell ist rein nutzungsbasiert (Pay-as-you-go), ob Enterprise-Support (24/7 mit 15-Minuten-SLA) kostenpflichtig ist, ob dehr hohe API-Volumen (>1 Mrd. Requests/Tag) können spezielle Vereinbarungen benötigen und ob das Data Recovery nach versehentlicher Löschung Service-Kosten verursacht.

Wie handhaben europäische Anbieter Behördenanfragen?

Anders als US-Anbieter unterliegen sie ausschließlich europäischem Recht:

– Datenherausgabe nur bei gültigem europäischem Gerichtsbeschluss

– Transparente Berichterstattung über Behördenanfragen

– Keine Hintertüren durch US-Regularien wie FISA 702

– DSGVO-Compliance durch Design, nicht als Add-on

Was ist das Äquivalent zu S3 Intelligent-Tiering?

Das direkte funktionale Äquivalent zu S3 Intelligent-Tiering gibt es bei den meisten europäischen Anbietern so nicht. Meist musst du zwischen „immer heiß“ (einheitliche Performance) und klassischen Hot/Warm/Cold-Klassen wählen. Impossible Cloud entspricht dabei einem Always-Hot-Modell ohne Tiering, während andere EU-Provider eher fixe Storage-Klassen mit Lifecycle-Regeln anbieten.

Impossible Cloud

„Always-Hot“-Object-Storage: Alle Daten liegen in einem performanten Tier, es gibt keine getrennten Klassen und keine Retrieval-Aufpreise – damit vergleichbar zu S3 Intelligent-Tiering im „Frequent Access“-Modus ohne Übergang in Cold/Archive.

Keine Egress- oder API-Fees, keine Mindest-Speicherdauer; Nachteil aus Kostensicht: selten abgerufene Archive zahlen denselben TB-Preis wie häufig genutzte Daten.

Hetzner Object Storage

Hetzner bietet eine einzige Object-Storage-Klasse ohne internes Tiering; Preis ist pro TB plus evtl. zusätzlichen Traffic, Abrufe kosten nichts extra.

Das kommt einem einfachen „Always-Hot“-Tier nahe; ein automatisches, nutzungsabhängiges Tiering wie S3 Intelligent-Tiering existiert nicht, Lifecycle-Regeln zum Löschen/Verschieben musst du selbst bauen.

Open Telekom Cloud (OBS)

Bietet explizite Storage-Klassen „Standard“, „Warm“ und „Cold“, zwischen denen du per Lifecycle-Regeln automatisch umstufen kannst.

In Summe kannst du so ein manuelles Intelligent-Tiering nachbauen, aber die Klassenzuordnung basiert auf deinen Policies, nicht auf automatischer Zugriffsanalyse wie bei AWS.

Andere europäische Anbieter (OVH, Scaleway, STACKIT etc.)

Viele EU-Provider arbeiten mit klar getrennten Storage-Klassen (Standard/Archive, Hot/Cold) und optionalen Lifecycle-Policies, aber ohne Zugriffszählung wie bei Intelligent-Tiering.

In der Praxis bedeutet das: Du wählst initial eine Klasse und definierst Regeln zum Verschieben, statt eine einzelne „intelligente“ Klasse zu buchen; das reduziert Komplexität, erfordert aber mehr eigenes Kosten- und Datenmanagement.

Wie lange dauert die Migration von 500 TB Daten?

Ein realistischer Zeitplan: In der Praxis bei 10 Gbit/s Dedicated Connection ~15 Tage reine Transferzeit.

Was sind die größten Nachteile europäischer Anbieter?

– Fehlendes Ökosystem: Keine direkte Integration mit 200+ AWS Services

– Globale Präsenz: Nur europäische Rechenzentren (aktuell Deutschland, Schweden)

– Feature-Lücke: Kein S3 Glacier-Äquivalent für Ultra-Cold Storage

– Community & Tools: Weniger Dritt-Tools, kleinere Developer-Community

– Dokumentation: Weniger detailliert als AWS’s 5.000+ Seiten Guide

Sollten wir auf Gaia-X warten?

Gaia-X ist ein Standards-Framework, kein direkter Cloud-Anbieter:

– Erste Gaia-X-konforme Dienste ab 2025

– Impossible Cloud plant Gaia-X-Zertifizierung

– Aktuelle Migration schließt Gaia-X später nicht aus

Empfehlung: Jetzt migrieren, bei Bedarf später zu Gaia-X-konformen Diensten wechseln

Wie überzeuge ich mein Management?

Argumentationsframework:

1. Finanziell: 3-Jahres-TCO-Vergleich mit Risikoabschlag

2. Compliance: Reduktion regulatorischer Risiken (Schrems II)

3. Strategisch: Vermeidung von Vendor Lock-in

4. Operational: Vereinfachung der Kostenkontrolle

5. Präsentieren Sie einen Phasenplan mit klaren Meilensteinen und Exit-Optionen.

Brauchen wir neue Mitarbeiter oder Schulungen?

Technisch geringer Aufwand dank S3-Kompatibilität, aber:

– 1-2 Tage Training für Admin-Team empfohlen

– Unterschiede in IAM, Monitoring, Billing verstehen

– Keine neuen Zertifizierungen nötig

– AWS-Kenntnisse sind größtenteils transferierbar