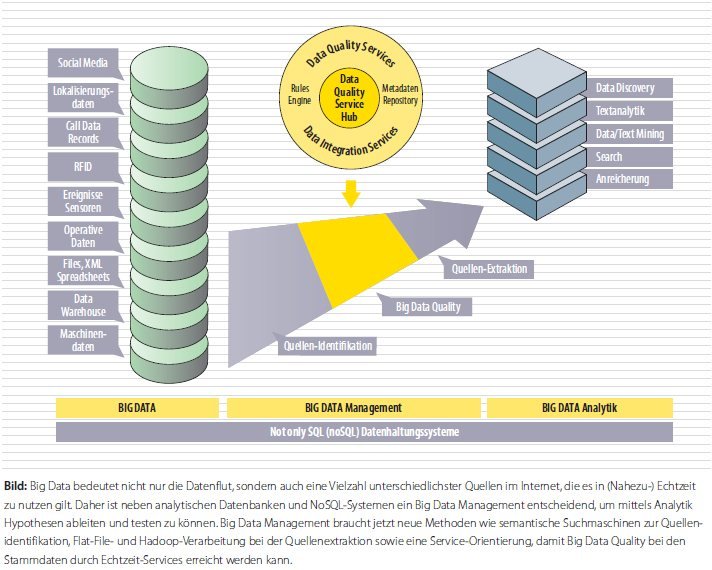

Die "Big Data-Herausforderung": Immer mehr Nutzer wollen in nahezu Echtzeit die Daten aus der immer ausufernden Datenflut und aus immer mehr und unterschiedlichsten Quellen analysieren. Big Data ist damit aber auch das Ende des Monopols der relationalen DBMS. As time goes by, kommen die analytischen Datenbanken. Das ist aber nicht der einzige Paradigmenshift!

Alle reden von Big Data. Bei Google gibt es zu Big Data über 271 Millionen Treffer (1). Aber was ist eigentlich „Big Data“? Big Data ist durch vier Merkmale gekennzeichnet. Diese vier Merkmale stellen wir hier vor und diskutieren dann insbesondere die Herausforderungen von Big Data an traditionelles Information Management: aus Information Management wird Big Data Management.

Volumen

Das betrifft die Menge der Daten, die zu verarbeiten sind. Die Menge der Daten im Unternehmen und außerhalb des Unternehmens wächst kontinuierlich. Dabei handelt es sich sowohl um strukturierte wie um unstrukturierte Daten. Zu den letzteren zählen nicht nur Formulare und Textdokumente, sondern auch Abbildungen, Fotos, Audio und Video-Aufzeichnungen etc. So ist nicht nur im Handel, sondern beispielsweise auch im Gesundheitswesen (20 TB Daten pro Patient ist eine realistische Größe) und in der Wissenschaft (beispielsweise beim CERN in Genf) in den letzten Jahren das Datenvolumen geradezu explodiert. In Folge dieser Datenflut (manche sprechen von einem Daten-Tsunami) ist die traditionelle relationale Datenhaltung an ihre Grenzen gestoßen. Um die Peta-bytes und mehr vonDaten zu lesen und zu durchsuchen, nutzt man heute NoSQL (2) -Datenhaltungssysteme. Hier werden unterschiedliche Software- und Hardware-Technologienmiteinander kombiniert: Spalten-Orientierung, Parallelisierung, Datenkompression, In-Memory-Verarbeitung, massiv parallele Verarbeitung (MPP) über Rechner-Cluster und spezielle sogenannte Data Appliances. Dabei gibt es auch OpenSource-Systeme wie etwa Hadoop, das dabei ist, den Standard der Zukunft zu setzen.

Vielfalt

Die Menge der Datenquellen wächst ebenfalls ständig. Die prominentesten Produzenten sind soziale Medien (allein über 800 Millionen Facebook-Mitglieder) und das mobile Internet mit seinen Verbindungsdatensätzen (call detail records) und Lokalisierungsdaten. Daneben gibt es viele weitere Datenproduzenten wie intelligente Ablesegeräte und Sensoren bei Strom, Wasser, Verkehr und Mautdaten, um nur einige zu nennen, Maschinen-erzeugte Daten über Verhalten und Leistung von Servern, Netzwerken und anderer Rechner-Infrastruktur, RFID-Information in der Supply Chain, Zeiterfassungssysteme und viele andere.Traditionelles Information Management stößt ebenfalls an seine Grenzen. Es hat sich zu „Big Data Management“ weiterentwickelt. Dabei setzen sich die drei Hauptkomponenten von traditionellem Information Management entsprechend fort.

- Big Data Integration

Hier werden zunächst einmal die traditionellen Datenintegrations-Technologien wie ETL- und ELT-Prozesse (3) und Echtzeit-Verarbeitung (change data capture, event triggering, Web Services) weiter genutzt. Neu dazu kommen MapReduce-basierte Flat-File-Verarbeitung zum Sortieren, Filtern, Mischen und Aggregieren von Daten inklusive einiger Basis-arithmetischer Funktionen. Beispiel hierzu ist das FileScale-Verfahren von Talend, das auch von Anbietern wie Uniserv genutzt wird. Alternativ kann man hier aber auch auf alte und sehr bewährte Technologien wie DMExpress von Syncsort zurückgreifen, die im Zuge von Big Data „wiederentdeckt“ werden. Schließlich braucht man jetzt auch – das ist neu – Unterstützung für Hadoop, also Import, Export und interne Verarbeitung.

- Big Data Lineage

Data Lineage basiert auf einem Repository zur Metadatenverwaltung und der Verwaltung aller Transformationsregeln: Alle Objekte der Datenintegrations-Plattform werden im Endeffekt hier abgebildet, damit alle Objekte vom Ursprung bis zum Ziel über den gesamten Informationslebenszyklus verfolgt werden können und bei Änderungen so weit wie möglich auch alle betroffenen Objekte gleich mit geändert werden. Das bleibt grundsätzlich so im Big Data, außer dass jetzt auch alle Metadaten zu Big Data Objekten und Entitäten zu verwalten sind. Das Repository wird also wichtiger und es kommt jetzt besonders auf die Performanz an, die mit der Repository-Technologie erreicht werden kann.

- Big Data Quality

Datenqualität spielt auch im Big Data eine wichtige Rolle, vor allem dann, wenn Unternehmensdaten mit Information aus dem Big Data angereichert werden sollen, also beispielsweise Kundendaten durch Daten aus den sozialen Medien ergänzt werden sollen oder Patientendaten mit therapeutischen Daten im Gesundheitswesen. Die Grundaufgaben von Data Quality Management bleiben die gleichen. Es geht wie immer um das Profiling, das Cleansing und das Anreichern und Abgleichen mit Referenzdaten. Aber auch hier steigen im Big Data die Bedeutung von Datenqualität – das Schaffen des „single point of truth“ ist beim gegebenen Datenvolumen schwieriger geworden – und die Anforderungen an die Performanz der Datenqualitätslösungen. Auf der technologischen Seite muss man jetzt im Big Data Management sicherstellen, dass die Performance stimmt: Alle Werkzeuge, Services und Plattformen müssen entsprechend skalierbar sein. Das wird in der Regel durch Parallelverarbeitung erreicht. Dazu kommen die Anforderungen der neuen Methoden wie Hadoop. Ein weiteres „Muss“ ist die Service-Orientierung der Plattform und der Werkzeuge. Dann lassen sich auch hybride Cloud-Lösungen betreiben, beispielweise ein Datenqualitäts-Management as a Service in ETL-Prozessen, um Social Media-Daten über Referenzdaten auf korrekte Adressen zu prüfen. Einer der ersten Anbieter hierzu ist die deutsche Uniserv. Das ist entscheidend, um auch mit Big Data im Unternehmen den „single point of truth“ zu bewahren.

Das alles erfordert aber neue Skills insbesondere in der IT. In einigen Unternehmen wie Amazon, eBay, Facebook, Google, die sich schon einige Zeit mit Big Data beschäftigen, haben sich neue Rollen wie Data Scientists gebildet. Das sind Mitarbeiter mit folgendem Profil:

- Technische Expertise: Tiefe Kenntnisse in einer Natur- oder Ingenieurs-Wissenschaft sind notwendig.

- Problembewusstsein: die Fähigkeit, ein Problem in testbare Hypothesen aufzubrechen.

- Kommunikation: die Fähigkeit, komplexe Dinge per Anekdoten durch einfach verständliche und gut kommunizierbare Sachverhalte darzustellen.

- Kreativität: die Fähigkeit, Probleme mit anderen Augen zu sehen und anzugehen („thinking out oft he box“).

Im Endeffekt wird so Datenmanagement wieder zur eigentlichen und Hauptaufgabe der IT (4), während das Beherrschen der Prozesse und der Analytik die Hauptaufgabe der Fachbereiche ist.

Neben Datenvolumen und Vielfalt der Datenquellen gibt es noch zwei weitereMerkmale von Big Data, die wir hier der Vollständigkeit halber auch noch aufzählen wollen. Die betreffen aber weniger Datenhaltung-und Datenmanagement, sondern die Analytik.

- Geschwindigkeit. Die Verarbeitung und Analyse vieler dieser unterschiedlichen Daten muss in nahezu Echtzeit erfolgen, denn von diesen Daten hängen beispielsweise Steuerungs- und Abrechnungssysteme ab.

Diese Herausforderung richtet sich an die Analysesysteme: Die Geschwindigkeit der Analyse muss gesteigert werden. Hier helfen jetzt die NoSQL-Datenhaltungssysteme. Damit aber die bekannten analytischen Werkzeuge genutzt werden können, braucht man entweder HLQL-Systeme, die die SQL-Schnittstellen der analytischen Werkzeuge in MapReduce umsetzen oder die Anbieter ergänzen ihre analytischen Werkzeuge um MapReduce-Schnittstellen.

- Verbraucher. Die Menge der Verbraucher von Information aus demBig Data steigt ebenfalls unaufhörlich. Es sind dies entweder immer mehr Mitarbeiter in diversen Fachabteilungen, die Information beispielsweise über Kunden, Mitbewerber und Markt benötigen, oder Systeme, die über Information aus dem Big Data gesteuert werden wie die Überwachung und Steuerung von Netzwerken aller Art (Telefonie, Computer, Luft-, Straßen- und Eisenbahn-Verkehr etc.).

Traditionelle Business Intelligence-Systeme kommen hier auch an ihre Grenzen. Jetzt sind intuitive, visuell-ausgelegte Systeme gefragt: Man spricht von „self-service business intelligence“. Hier helfen heute insbesondere auch die Tablet-Rechner, die für ein genau solches Arbeiten entwickelt wurden. Weiterhin ist eine Analyse von unstrukturierten Daten unabdinglich. Hier ist mit Textanalyse ein Anfang gemacht. Die bekannten statistischen Mining-Verfahren werden jetzt durch linguistische Verfahren und statistisches Lernen ergänzt.

Fazit

Wie im Unternehmen mit traditionellem Information Management geht es beim Big Data Management darum, vertrauenswürdige Daten zu schaffen. Dabei stellt Big Data neue Anforderungen an die Technologien der Datenhaltung, des Datenmanagements und der Analytik. Beim Datenmanagement geht es immer noch um Integration, Lineage und Qualität, aber jetzt sind die bekannten Ansätze umdie NoSQL-Innovationen rund um Hadoop zu ergänzen. Das erfordert insbesondere neue Skills in der IT und einen weiteren Ausbau der Zusammenarbeit von IT und Fachabteilungen: Die IT muss in den Zeiten von Big Data den Hauptfokus auf Datenmanagement legen.

Dr. Wolfgang Martin, www.wolfgang-martin-team.net

Diesen Artikel lesem Sie auch in der it management , Ausgabe 5-2012.

(1) abgefragt am 23.Januar 2012

(2) NoSQL = not only SQL

(3) ETL = extract, transform, load ; ELT = extract, load, transform. Beide Verfahren unterscheiden sich durch die Reihenfolge der drei Schritte. Bei ETL wird der transform-Schritt in der Datenintegrations-Plattform ausgeführt, bei ELT in der Datenbank.

(4) Das unterstreichen einige neuere Marktstudien, siehe den Beitrag bei Information Age www.information-age.com/..