Alle wollen mitmachen, die wenigsten kommen voran: Unternehmen scheitern an der digitalen Transformation, weil noch immer sofort über Software- und Hardwarelösungen gesprochen wird. Dabei beginnt alles mit den Daten. Und die werden selten so verwaltet, dass sie den Visionen neuer Geschäftsmodelle und effizienter Prozesse genügen.

Digitale Transformation bedeutet vor allem eins: Beschleunigung. Die Gewinner der Digitalisierung werden die Unternehmen, die ihre Entscheidungszeiten verkürzen können. Und die dafür ein hohes Maß an Automatisierung durch künstliche Intelligenz erreichen. Im Finanzsektor und bei großen internationalen eCommerce-Unternehmen ist dies bereits seitJahren zu beobachten. Gewinner ist, wer am schnellsten auf die Dynamik des Marktes oder auf den Bestellwunsch eines Kunden reagieren kann. Was machen diese Vorreiter der digitalen Transformation anders als die meisten Serviceund Industrieunternehmen in Deutschland? Sie schaffen es, die historisch gewachsene Barriere zwischen Daten, Datensilos, Expertenwissen, Business Rules und den Lernanforderungen künstlicher Intelligenz (KI) zu überwinden. Das erreichen sie durch drei Fähigkeiten.

Erstens, sie machen implizites Wissen explizit. Daten sind nur nutzbar, wenn wir wissen, was sich hinter diesen Daten verbirgt. Was sind das für Daten? Von wem und unter welchen Bedingungen wurden die Daten erhoben? Welchen Eigenschaften haben Sie? In welchem Zusammenhang stehen die Daten mit anderen Datensätzen? Das Wissen, das sich sonst in den Köpfen der Domänenexperten verbirgt, wird also digital formalisiert. Wenn dieses Kontextwissen explizit zugänglich gemacht wird, können Mensch und Maschine Daten systemübergreifend und flexibel lesen und verstehen.

Zweitens, sie machen die Business Rules hinter den Daten explizit, die für die korrekte Interpretation der Daten notwendig sind. Welche Entscheidungen und Bedingungen lassen sich aus den Daten ableiten? Welche Grenzen setzen sie? Das Wissen wird damit aus dem komplizierten, verklausulierten Softwarecode herausgelöst und explizit gemacht. Erst dadurch wird eine Qualitätssicherung, ein nachvollziehbares Reasoning und dynamisches Lernen der KI möglich.

Drittens die Unternehmen verwalten ihre Daten in einer Form, die eine systemübergreifende Integration und Verarbeitung ermöglicht. Damit können Unternehmen eine Vielzahl verschiedener Datenquellen nutzen und kombinieren, ohne ins Datenchaos abzudriften.

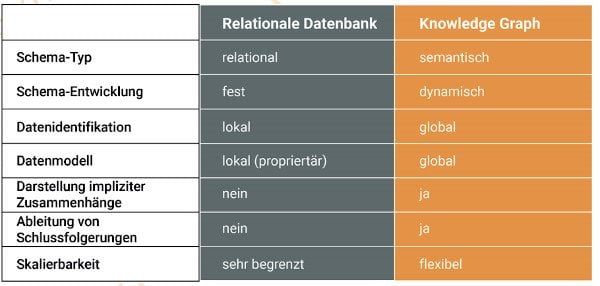

Bild 1: Typische Datenmanagementlösungen wie Master Data Management basieren noch immer auf relationalen Datenbanken. Diese blockieren jedoch das Potential von Big Data und KI. (Quelle: eccenca)

85 Prozent aller Daten sind unbrauchbar

Wie weit die meisten Unternehmen von diesen Grundlagen der Digitalisierung entfernt sind, zeigt eine Auswertung des Berliner IT-Dienstleisters Aikux zum Dateienaufkommen in 400 deutschen Unternehmen. Demnach besitzt jeder PC-Mitarbeiter zwischen 10.000 und 100.000 Dateien allein in den internen Filesystemen. Nur 15 Prozent davon sind nutzbar. Die restlichen 85 Prozent sind entweder Daten von unbekanntem Wert oder redundante, obsolete und triviale Dateien.

Auf der Datenebene sieht es nicht besser aus. Unsere Erfahrungen mit Großunternehmen zeigen, dass selbst strukturierte Daten selten eindeutig, nachvollziehbar und übergreifend nutzbar sind. Gut 50 Prozent aller Daten in Unternehmen beziehen sich beispielsweise auf ein und dieselbe Sache. Den Mitarbeitern ist diese Redundanz in der Regel nicht bewusst, weil die Kontextinformationen dazu fehlen. Der Effekt ist jedem Unternehmen wohlbekannt. Für jeden Datensatz gibt es einen Experten, der als einziger die Daten interpretieren und zuordnen kann. Und eine Integration in ein neues Systemkann nur über aufwendige Transformationsonsprozesse erfolgen, die nicht selten mit Informationsverlusten und Unschärfen einhergehen. Darin liegt auch der Grund, weshalb die bisherigen Ergebnisse von Big Data und KI durchweg ernüchternd sind. Es fehlt die Datengrundlage, um diese Anwendungen effektiv zu trainieren.

FAIR Data

2014 erarbeitete ein Konsortium aus Wissenschaftlern und Organisationen deshalb das FAIR-Data-Konzept. FAIR steht für Findability (Auffindbarkeit), Accessibility (Zugänglichkeit), Interoperability (Integrierbarkeit) und Reusability (Wiederverwendbarkeit). Im Kern adressiert das Konzept damit die Herausforderungen, vor denen jedes Unternehmen steht. Die (richtigen) Daten müssen eindeutig identifizierbar und für die jeweiligen Nutzer verständlich, zugänglich und nachvollziehbar sein. Da verschiedene Nutzer mit verschiedenen Programmen und Anwendungen arbeiten, müssen die Daten softwareübergreifend integrierbar sein. Und schließlich sollen Daten nicht nur einmalig, sondern möglichst mehrfach verwendet werden können.

Um dies zu erreichen definiert das FAIR-Data-Konzept Prinzipien, nach denen Daten verwaltet werden sollten. Unter anderem sollen Daten unabhängig vom Quellsystem, in dem sie gespeichert und verarbeitet werden, einen globalenHTTP- Identifier besitzen. Dreh- und Angelpunkt der Prinzipien sind semantische Metadaten, welche die Rohdaten mit Kontextinformation anreichern. Die Metadaten beschreiben die eigentlichen Daten bezüglich Inhalt, Definition und Terminologie, Herkunft, erfolgte Bearbeitungen, Eigentümer sowie Verlinkungen zu anderen Daten. Sie ermöglichen damit nicht nur ein schnelles Auffinden der Daten.

Mit den Metadaten wird auch die systemund domänenübergreifende Interpretierbarkeit, Nachverfolgbarkeit und das sinnvolle Verlinken untereinander möglich. Damit bilden Metadaten die entscheidende Grundlage, um mit Daten effizient, zielgerichtet und nachvollziehbar die richtigen Entscheidungen in kürzester Zeit zu fällen. Die Frage für Unternehmen bleibt dabei, wie sie FAIR Data in den eigenen Systemen und bestenfalls auch mit den Geschäftspartnern etablieren können.

Viele Systeme, eine Option

Die aktuell bestehenden Datensilos bilden keine Option. Master Data Management und Datenmigrationsprojekte versprechen seit langem die Lösung der Probleme. Diese Optionen führen in einem eng gesteckten Rahmen zwar zu einer gewissen Datenkonsistenz. FAIR Data entsteht dadurch nicht. Vor allem scheitern sie an den drängendsten Herausforderungen: Daten sind dynamisch und ständiger Veränderung unterworfen. Für Daten existiert zudem keine eindeutige Wahrheit, sondern – je nach Anwendungsfall, Domäne und Beschaffenheit – multiple Wahrheiten. Schlussendlich bauen die Ansätze nur ein weiteres Datensilo auf. Für Anwendungen wie künstliche Intelligenz, Big Data, Smart Supply Chain oder IoT-Automation sind sie daher ungeeignet.

Eine sinnvolle Option gibt es dennoch. Diese können sich Unternehmen bei den digitalen Vorreitern abschauen. Die datenintensivsten und erfolgreichsten Unternehmen der Welt – namentlich Amazon, Apple, Microsoft, Facebook, Tencent und Alphabet – nutzen längst semantische Wissensgraphen (engl. KnowledgeGraphs), um der täglichen Datenflut Herr zu werden. Diese Technologie verwaltet die Rohdaten vollständig auf Basis von Metadaten. Die Rohdaten können dabei weiterhin in den etablierten Quellanwendungen (von Excel über SAP bis zu selbstgebauten Systemen) gespeichert und verarbeitet werden. Ein massiver Umbau der Bestandssysteme ist nicht notwendig. Die Daten erhalten einen global eindeutigenIdentifier und werden über Metadaten umdie weiter oben skizzierten, notwendigen Kontextinformationen im Knowledge Graph angereichert. Ein Knowledge Graph kann somit global das Schema, die Semantik und Vernetzung der Datenabbilden. Damit können KI-Anwendungen auch Millionen von Datenpunkten in kürzester Zeit durchsuchen, vergleichen und kombinieren – und damit Zusammenhänge, Trends und klare Entscheidungen ableiten.

Kurz: die Daten werden mit einem Knowledge Graph FAIR. Darüber hinaus kann in den Knowledge Graphs das Regelwissen nachvollziehbar dokumentiert werden. Algorithmen sind damit nicht mehr abhängig vom jeweiligen Programmierer, sondern für die Anwendertransparent, in einfacher Sprache nachvollziehbar und veränderbar. Letzteres istinsbesondere für die Überprüfung der Entscheidungen und die weitere Verbesserung der Algorithmen durch Machine Learning unabdingbar.

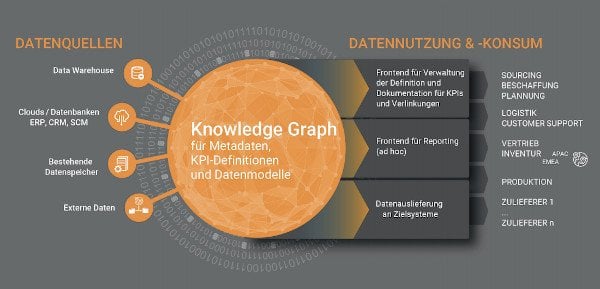

Bild 2: Knowledge Graphen erlauben die Integration verschiedenster Datenquellen. Die Datenverwaltung erfolgt über globale Identifier und ein Vielzahl von Metadaten. (Quelle: eccenca)

Weniger Aufwand für die Datenvorbereitung

Der globale Konzern RFS (Radio Frequency Systems) hat letztes Jahr bewiesen, welches Potential die Knowledge-Graph-Technologien haben. Der führende Hersteller von Großkomponenten für Telekommunikations-Infrastruktur baute 2018 binnen sechs Monaten mit Hilfe der Knowledge-Graph-Plattform Corporate Memory eine globale Datenbank für ihre Produktdaten. Diese wurden in der Vergangenheit an den 8 Produktionsstandorten auf 5 Kontinenten lokal verwaltet. Der Grund waren historisch gewachsen unterschiedliche IT-Systeme, die die Produktdaten in eigenen Formaten verwalteten. Die Knowledge-Graph-Plattform ermöglicht RFS nun, die Produktdaten und Lagerbestände global zu durchsuchen und zu vergleichen. Die lokalen Systeme mussten dafür nicht angepasst werden. Nicht nur reduzierte der Konzern den Aufwand für die Datenvorbereitung um 50 Prozent und damit um jährlich 22 Mannmonate. Das Unternehmen konnte aufgrund der globalen Produkttransparenz auch die Vorlaufzeiten bei seinen Kunden reduzieren und den Lagerbestand um 12 Prozent senken. Das Projekt hatte sich nach nur sechs Monaten doppelt amortisiert. Im nächsten Schritt arbeitet RFS nun daran, die IoT-Daten aus der Produktion zu integrieren, um Best Practices zu identifizieren und die globale Produktionsplanung zu optimieren. Das semantische Datenmanagementkonzept wollen sie in Zukunft auf alle Unternehmensdaten ausweiten. Unter anderem sollen Geschäftspartner flexibler eingebunden und neue Geschäftsmodelle erschlossen werden. Für RFS sind die Daten zukünftig immer FAIR.