Die Systemschwächen äußern sich nicht nur in Performance-Problemen, höheren Betriebskosten oder immer aufwendigeren Entwicklungsprozessen. Auch die Unzufriedenheit der Benutzer bzw. betriebsführenden Organisationen oder ein bereits geplanter Umbau bzw. eine Erweiterung des DWH-BI-Systems sind Symptome hierfür.

Eine nachhaltige Abhilfe für diese Problematik schafft ein Transfer der vorhandenen DWH-Funktionen auf eine moderne Plattform, die über genügend Leistungs- und Kapazitätsreserven für die nächsten drei bis fünf Jahre verfügt. Dabei sollten die Betriebskosten signifikant gesenkt und die getätigten Investitionen in die Datenbeschaffungsprozesse und die Auswertungen geschützt werden.

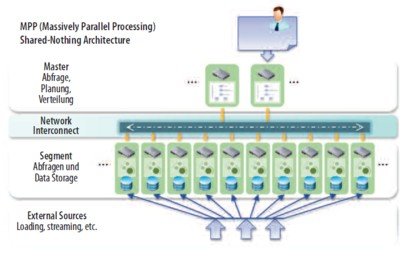

An diesem Punkt kommen Massive-Parallel-Processing-Datenbanken (MPP) ins Spiel, die ohne Zweifel die zukunftsweisende Technologie im Data Warehousing sind und in Zukunft ein unverzichtbarer Bestandteil der Data-Warehouse-Landschaft und Informationslogistik von Großunternehmen aber auch von KMUs sein werden.

Die DATA MART Consulting GmbH hat mit dem Komplettpaket DWH-RetroFIT eine durchdachte Methodik zur Ablösung eines bestehenden DWH-Systems durch eine leistungsfähige und kostengünstigere MPP-Alternative auf der Basis der IBM-Netezza-Technologie einschließlich Consulting-Unterstützung entwickelt. Dabei werden die vorhandenen Strukturen und Daten so weit wie möglich und nötig beibehalten. Ebenso werden alle Schnittstellen wie ETL-Prozesse und die Zugriffe aus den BI-Systemen an die neue Plattform angepasst.

Das Ziel von DWH-RetroFIT sind die Steigerung der System-Performance, die Senkung der Betriebskosten und die Erweiterung der Kapazitäten unter der gleichzeitigen Beibehaltung der vorhandenen ETL-Prozesse und BI-Systeme, inklusive der bestehenden Auswertungen. Das gesamte Paket besteht aus drei Teilen, die auch einzeln geordert werden können.

1. Health-Check: Eine grobe Untersuchung des bestehenden DWH- Systems deckt Systemschwächen auf und prüft die Möglichkeit, ein DWH-RetroFIT umzusetzen.

2. POC: Im Rahmen eines Proof-Of-Concept beim Auftraggeber vor Ort werden auf einem produktionsnahen DWH-System Tests durchgeführt, die aufzeigen, wie Systemschwächen beseitigt und eine grundsätzliche Verbesserung der System-Performance und -Ökonomie erreicht werden können.

3. Migration: Bei der eigentlichen Ablösung des Systems wird eine neue DWH-Plattform in den Räumlichkeiten des Auftraggebers aufgebaut, die bestehenden Daten werden auf diese Plattform transferiert und alle notwendigen Schnittstellen (wie ETL und BI) umgestellt. Die Migration umfasst ebenfalls alle notwendigen Tests sowie die Übergabe an die betriebsführenden Organisationen.

Geeignet ist DWH-RetroFIT für die DWH-Plattformen Oracle, Teradata, DB2, MS SQL Server und SAP/BW (unter bestimmten Voraussetzungen).

Analytische Datenbanken

Technologische Basis von RetroFIT ist die Netezza-Server-Familie von IBM. Die grundlegende Pflicht einer analytischen Datenbank, ihre Leistung jederzeit jedem Nutzer in einem genügenden Maß zur Verfügung zu stellen, erfüllt sie durch die konsequente Anwendung der sogenannten aMPP-Architektur. Bei dieser asymmetrischen Erweiterung der MPP-Architektur wird eine größere Anzahl von unabhängigen Blade-Rechnern mit einem ultraschnellen internen Netzwerk zu einer Maschine zusammengefasst. Die Asymmetrie entsteht durch die Ergänzung dieser blade-gestützten Maschine durch einen übergeordneten SMP-Host, der als voll ausgebauter Computer mit mehreren CPUs als Kontroll-Instanz für alle angeschlossenen Blade-Rechner fungiert.

Zur Abbildung einer DWH-Datenbank auf die Maschine wird diese nach einer Partitionierungsregel physisch auf die einzelnen Blades oder genauer gesagt auf die einzelnen Cores der Blade-Rechner aufgeteilt. Eine mittlere Ausbaustufe des Netezza-Servers umfasst 24 bis 92 einzelne Partitionen, die größte kann bis zu 920 aufweisen.

Jeder dieser Datenbank-Partitionen stehen exklusiv ein CPU-Core, ein FPGA (Field Programmable Gate Array), ein IO-Controller und eine Disk zur Verfügung. Die Daten einer Partition liegen komprimiert auf der Disk und werden vom FPGA gelesen, dekomprimiert – was dem Anschein nach die Leseleistung der Disk mehrfach erhöht – und einer ersten logischen Verarbeitung unterzogen. Die vorverarbeiteten Daten werden zur CPU weitergegeben, wo sie einer weiteren und komplexeren Verarbeitung unterzogen werden. Der übergeordnete SMP-Host konsolidiert zuletzt die Resultate aus allen Partitionen zu einem Gesamt-Resultat.

Die Ressourcen des Netezza-Servers stehen jeder Datenbank-Partition exklusiv und demzufolge uneingeschränkt zur Verfügung. Mit der Kombination dieser speziellen Hardware-Architektur und der entsprechenden Abbildung einer Datenbank kann der IBM-Netezza-Server seine Leistung jederzeit und jedem Nutzer zur Verfügung stellen.

Massive Parallel Processing mit Zusatznutzen

Die Kür einer analytischen Datenbank besteht darin, ihre Leistung jedem Nutzer über die reine Datenverwaltung hinaus auch zur analytischen Auswertung zur Verfügung zu stellen. Der IBM-Netezza-Server erfüllt diese Aufgabe über eine eigene analytische Plattform, über die sich der SQL-Funktionsumfang wesentlich vergrößern lässt. So werden mehrere Funktionspakete angeboten, mit deren Hilfe jeder Datenbank-Nutzer komplexe statistische Funktionen ohne eine entsprechende Oberfläche direkt auf der Datenbank ausführen kann. Dazu zählen zum Beispiel Exploration, Regression, Clustering, Association Rule Mining und viele mehr.

Erwähnenswert sind auch Bibliotheken, die raumbezogene Auswertungen in drei Dimensionen ermöglichen. Damit lassen sich die Informationen aus der Datenbank als räumliche Gebilde darstellen und zum Beispiel Ähnlichkeiten zwischen zwei Datenobjekten als benachbarte Orte abbilden. Darüber hinaus liegt eine ganze Sammlung von Matrix-Funktionen vor. Damit lassen sich auch Berechnungen in der Datenbank durchführen, die dem Standard-SQL vorenthalten sind.

Für alle diese Auswertungen und Berechnungen werden die vorhandenen Ressourcen des Netezza-Servers wiederum im gleichen Parallelisierungsgrad wie bei der Datenverwaltung genutzt. Die Auswertungen und der Zugriff auf die Resultate geschehen mit dem üblichen Funktionsumfang der SQL-Sprache, was seinerseits nur die einfachsten Abfrage-Tools voraussetzt.

Noch interessanter ist die Kombination zwischen Pflicht und Kür in Form der IBM-Netezza-DWH-Appliance, die Datenbank, Server und Speicher in einem einzigen System architektonisch integriert. Damit können Unternehmen große Datenmengen von bis zu 10 Petabyte innerhalb weniger Minuten analysieren – und das zu einem sehr attraktiven Preis, der lediglich von der Größe des Netezza-Servers abhängt.

Wolfgang Dähler, www.datamart.de

Diesen Artikel lesen Sie auch in der it management , Ausgabe 9-2011.