In Zeiten von Big Data gewinnen Data Scientists (Datenwissenschaftler) enorm an Bedeutung. Entsprechend wichtig ist für Unternehmen die Aufgabe, mit diesen Experten und mit Businessanwendern und Entscheidern schlagkräftige Teams zu bilden. Nur so können sie den unterschiedlichen Anforderungen an die Datenanalyse innerhalb eines Geschäftsfeldes gerecht werden.

Wichtige Hinweise für die optimale Umsetzung liefern die langjährigen Erfahrungen von TIBCO Software im Bereich Finanzdienstleistungen. Denn dort sind die unterschiedlichsten Funktionsbereiche auf die Analyse von Big Data angewiesen – sei es im Rahmen des Portfoliohandels und -managements, der Verbesserung des Kundenservice, der Betrugsbekämpfung oder des Risikomanagements innerhalb der Organisation.

Data Scientists und vertikale Märkte

Der Data Scientist wurde von der Harvard Business Review bereits als „Sexiest Job“ des 21. Jahrhunderts bezeichnet. McKinsey hat ausgerechnet, dass die Differenz zwischen Angebot und Nachfrage bei den Datenwissenschaftlern bei 50 bis 60 Prozent liegen wird, und sagt voraus, dass innerhalb der nächsten fünf Jahre mehr als 150.000 Data Scientists und 1,5 Millionen Manager mit fachlicher Qualifikation für die Analyse von Big Data fehlen werden.

Der hohe Stellenwert von Data Science ist mittlerweile unumstritten. Ihre Kernanwendungen treiben die Entwicklung einer ganzen Reihe von Programmen für die Verarbeitung von Unternehmens- und Kundeninformationen voran. Darunter sind Initiativen für

- die Neukundenakquise und Erweiterung der Bestandskunden (Cross-Sell/ Up-Sell)

- ein tieferes Verständnis der Ursachen von Kundenabwanderungen (inklusive prädiktive Modelle mit Interventionsmöglichkeit)

- Trigger-based Marketing (einschließlich mobiler und standortbasierter Angebote)

- die Analyse von Umsatzsteigerungen („Test & Learn“)

- die dynamische Segmentierung (um unterschiedliche Segmente differenziert zu behandeln)

- Preisanalysen (die auch die Kundenbindung und den langfristigen Wert einer Kundenbeziehung berücksichtigen)

- Sentiment- und Attributionsanalysen (Performance der Mitarbeiter und Effektivität von Marketingkampagnen und anderen Werbemaßnahmen)

- Betrugs- und Risikoanalysen (operative Ausführung und Unternehmensanalyse)

Darüber hinaus sind spezialisierte Data-Science-Programme der Motor für die Entwicklung von Branchenlösungen. Diese nutzen branchenspezifische Datenquellen, deren Volumina ständig größer werden und die sich kontinuierlich weiterentwickeln, beispielsweise durch die Einbindung von sozialen Netzwerken und Echtzeitdaten. Im Bereich Finanzdienstleistungen kommen solche Lösungen in allen wichtigen Aufgaben- und Geschäftsbereichen zum Einsatz, so etwa in den Kapitalmärkten für den Handel und das Portfoliomanagement, im Privatkundengeschäft für Markt- und Kundenanalysen, aber auch im Bereich Risikomanagement zur Bewertung und Überwachung des Unternehmensrisikos, der Kredit- und Kontrahentenrisiken, der Marktrisiken sowie für die Eindämmung von Betrugs- und Compliance-Risiken durch Geldwäsche, Kreditkartenbetrug oder im Handel.

In der Öl- und Gasindustrie hingegen dienen die Anwendungen ganz anderen Zielen, unter anderem der Optimierung der Produktion und der Berechnung maximal förderbarer Reserven, der Wartung von wichtigen Sachwerten wie Förderanlagen und Pipelines sowie der Optimierung der Standorte und Prozesse bei Bohrarbeiten einschließlich geographischer, geologischer und geochemischer Daten.

Es zeigt sich, dass der wichtigste Antriebsfaktor für die Differenzierung in nahezu allen Bereichen branchenspezifische Anforderungen sind. Auch wenn einige Ziele des Energiesektors und der Finanzdienstleistungen sich überschneiden, ist in beiden Branchen ein Handling unterschiedlichster Datensätze und statistischer Verfahren erforderlich.

Häufige Fallstricke

Die Begeisterung für Big Data und Data Science ist derzeit so groß, dass auch Lösungen attraktiv erscheinen, die bei genauerer Betrachtung massive Risiken bergen. Dazu gehören isolierte Datenbankanalysen für Endanwender mit den damit einhergehenden Problemen: Es werden bedeutungslose Daten ausgewertet. Es werden Daten aussortiert, die nicht mit den eigenen Hypothesen übereinstimmen. Man verwechselt Früh- und Spätindikatoren und interpretiert Korrelationen als Ursachen.

Die Endanwender können durchaus auf sehr einfache Weise mit Self-Service-Analytics ausgestattet werden, wie unten dargelegt, aber sie brauchen eine integrierte Anleitung, und es sollte ein Framework bereitgestellt werden, das Data-Discovery-Lösungen für Endanwender und Collaboration-Tools beinhaltet und das bereits für den unternehmensweiten Einsatz ausgelegt ist. Nur so sind gründliche und realitätsnahe betriebswirtschaftliche Analysen möglich.

Der richtige Data-Science-Workflow – oder von Data Science 1.0 zu Data Science 2.0

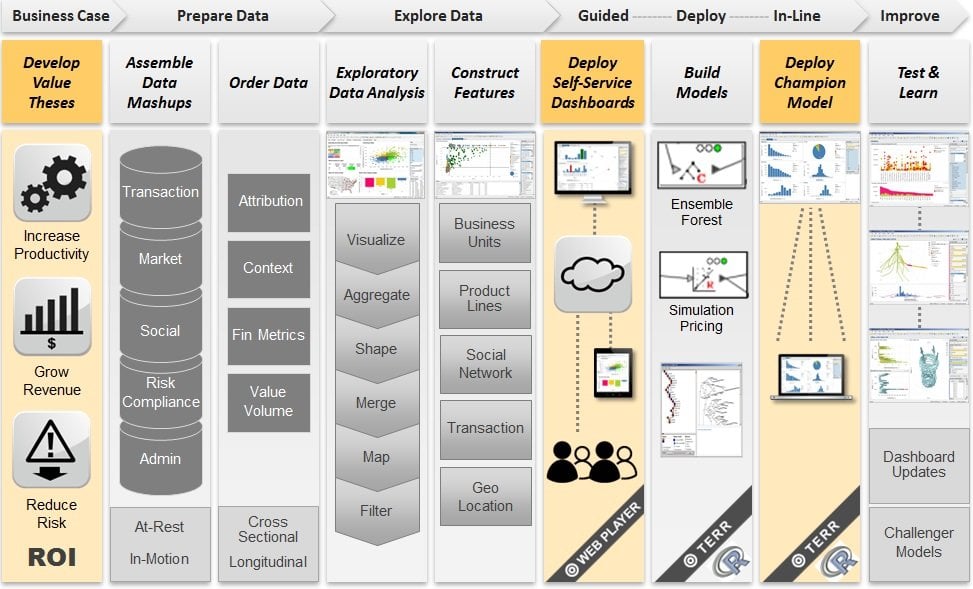

Die Grundlagen des Data Science 1.0-Prozesses habe ich bereits unter anderem in einem 2012 im Forbes Magazin erschienenen Artikel mit dem Titel “What is a Data Scientist” beschrieben. Dank jüngster technologischer Innovationen sind wir meiner Meinung nach mittlerweile in der Data-Science-Ära 2.0 angekommen. Der erweiterte Umfang moderner Data-Science-Prozesse beinhaltet:

- die Identifizierung kritischer Unternehmensprobleme und die Entwicklung von Wertaussagen mit nachweisbarem ROI

- die Zusammenstellung geeigneter Daten-Mashups zur Lösung dieser Probleme

- die Systematisierung von Datenaggregationen und Filtern – in-database und in-memory

- die Explorative Datenanalyse (EDA) – visuell und interaktiv

- die Entwicklung und Validierung von Analyseschritten, die auf ein bestimmtes Problem hinweisen – Früh- und Spätindikatoren

- die Ausführung dieser Analyseschritte und der Einsatz von Explorativer Datenanalyse mittels Self-Service-, Guided- und Collaborative-Analytics in allen wichtigen Funktionsbereichen des Unternehmens – mit flexiblen Architekturen für ein effizientes Handling neuer Anforderungen

- die Erstellung und Bewertung von Modellen zur Beschreibung und/oder Vorhersage des Analyseergebnisses

- die Anwendung des „Champion-Modells“ in Echtzeit-Eventsystemen zur Umsetzung gefundener Lösungsansätze bei Kunden und im Markt

- Die Weiterentwicklung angeleiteter Analysen sowie In-line-Event-Analyse-Systeme durch Entwicklung neuer Funktionalitäten, geänderter Dashboards und mittels „Challenger Modelle“

Folgende Abbildung zeigt diesen Workflow für typische Business Cases aus dem Bereich Finanzdienstleistungen:

Eines steht fest: Die Zukunft gehört dieser Kombination interaktiver, visueller, deskriptiver und prädiktiver Analytics mit Self-Service-, Guided- und Collaborative-Workflows für Endanwender sowie dem Einsatz von In-line-Analytics in Echtzeit-Eventsystemen. Nur so können Businessanwender produktiv eingebunden werden. Denn echten Mehrwert erzielen Unternehmen nur dann, wenn sie die Expertise der Data Scientists mit der fachlichen Erfahrung aus ihren Geschäftsbereichen verknüpfen.